【JavaSE】数据结构-哈希表(HashSet/HashMap底层哈希表详解,源码分析)

哈希表结构

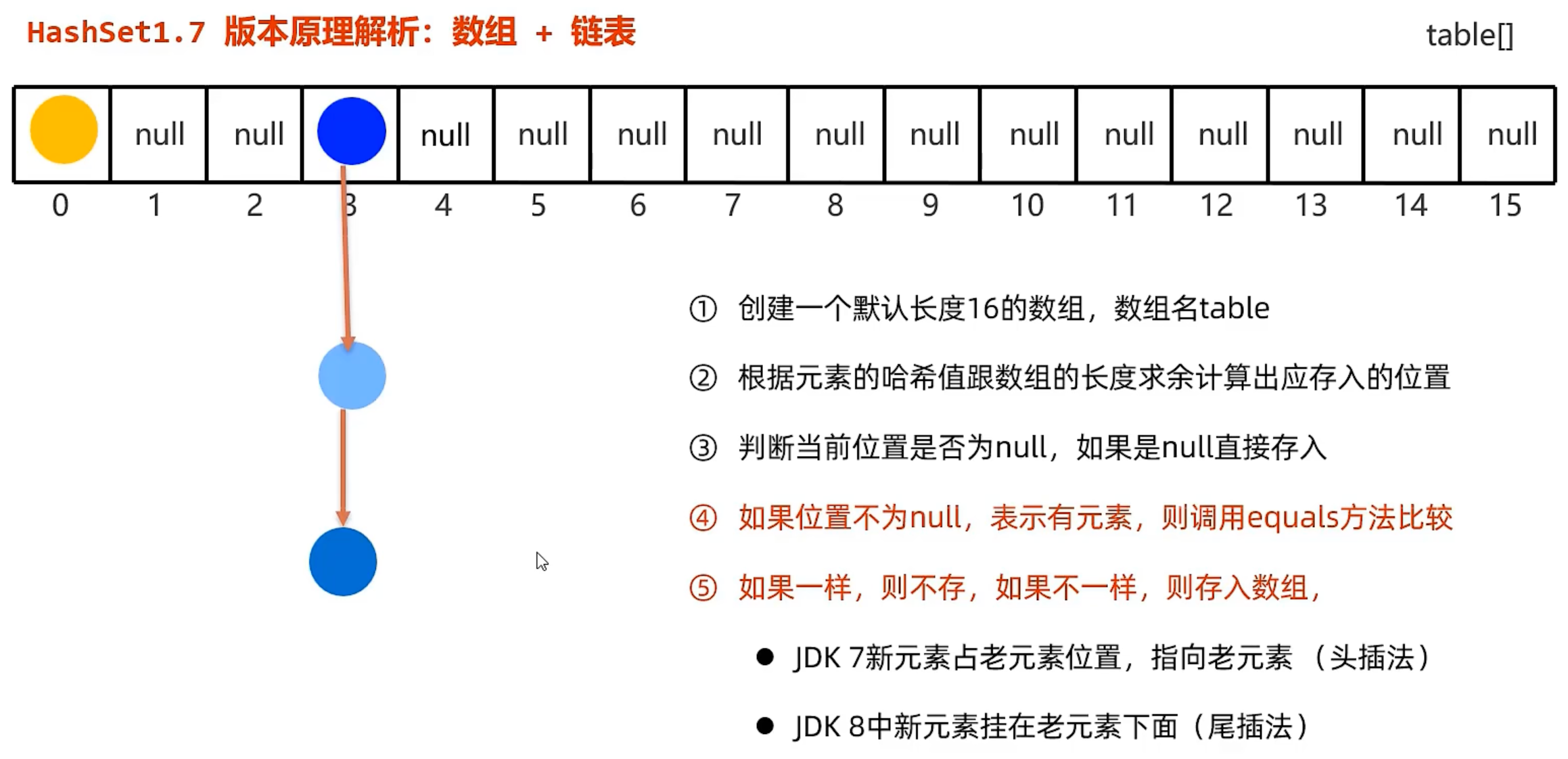

JDK8版本之前:数组+链表

- 为什么头插法改尾插法?

头插法需要将插入元素的next指向原链表头,然后插入元素再作为链表头。单线程没什么问题,但在多线程并发情况下可能会产生环形链表

JDK8版本及之后:数组+链表+红黑树

哈希表HashMap put()方法的添加流程

-

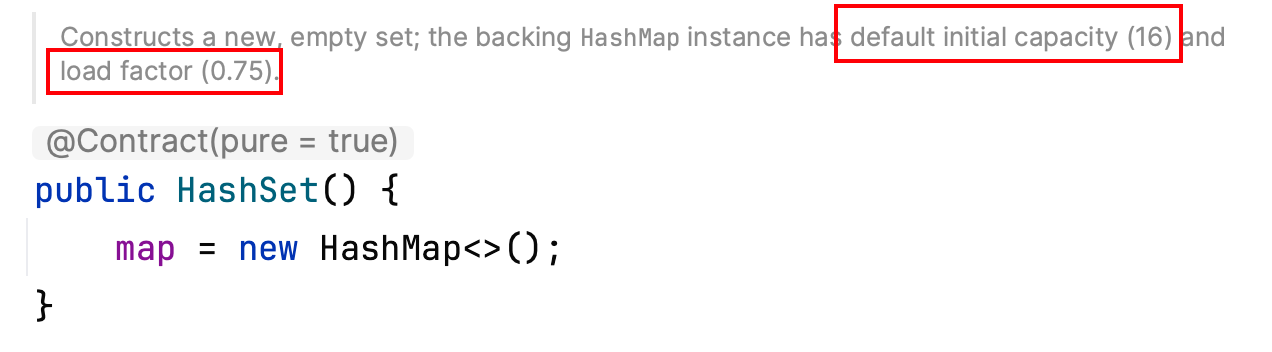

创建HashSet集合时,构造方法中自动创建HashMap集合;

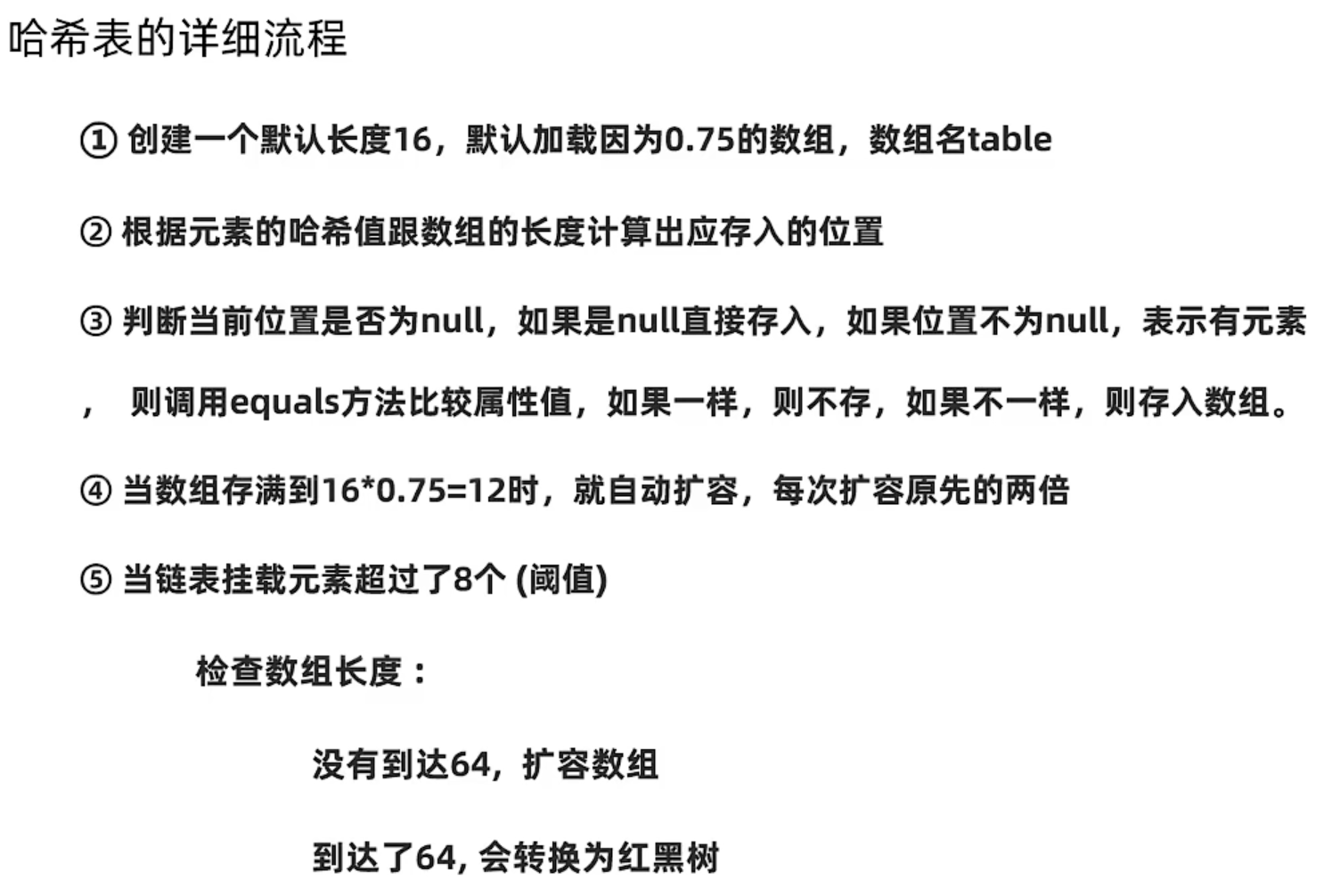

HashMap空参构造方法会创建一个默认长度为16,默认加载因子为0.75的数组,数组名为table

(tips:实际上,HashSet对象创建后,第一次调用add方法时table数组长度才会变为16,初始情况下table数组为空)

-

调用集合的添加方法,会计算元素的索引位置——

哈希值 % 数组长度

-

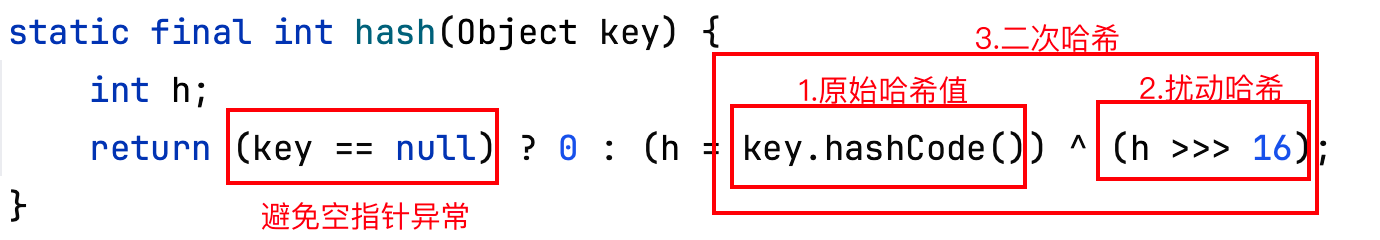

首先,计算哈希值

为了尽可能避免哈希冲突,使集合元素的索引位置尽可能分散,以此减少链表的挂载数量,java底层哈希值运算分为三个步骤:

(1) 原始哈希值:是Object类的hasCode()调用底层C++代码计算出的一个随机数(也就是地址值)

(2) 扰动哈希:整数二进制的后16位变化不大,取模容易产生哈希冲突,因此(无符号)右移原始哈希值,高16位补0,使原高16位的变化较大的数据参与运算

(3) 二次哈希:然后使原始哈希值与扰动哈希值进行异或进行二次哈希 -

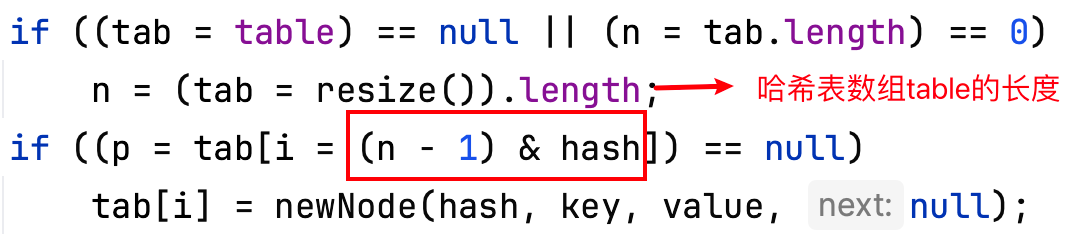

然后,取模数组长度

这里使用[数组长度-1] & 哈希值来替代哈希值 % 数组长度,因为位运算&比取模%计算速度快

-

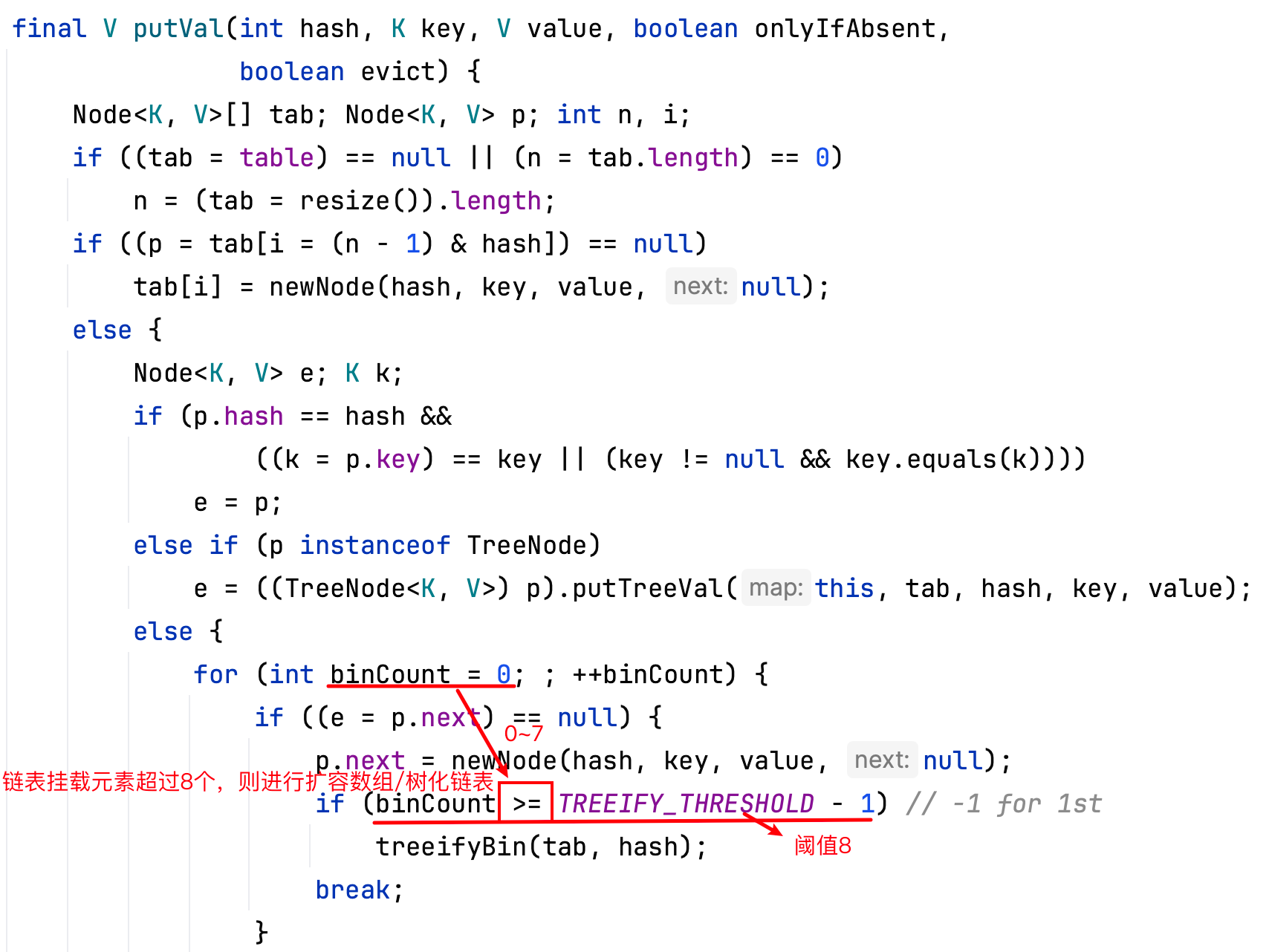

判断索引位置元素是否是null

是->存入;

不是->说明有元素,调用equals方法比较内容,如果元素内容不同,则使用尾插法插入到该位置元素的尾部 -

当某索引位置挂载的元素过多,查询性能会降低,如何提高查询性能?

- 扩容数组

(1)当数组中的元素个数( HashMap.size() )到达了(>=)16*0.75(加载因子)=12时,扩容原数组2倍的大小

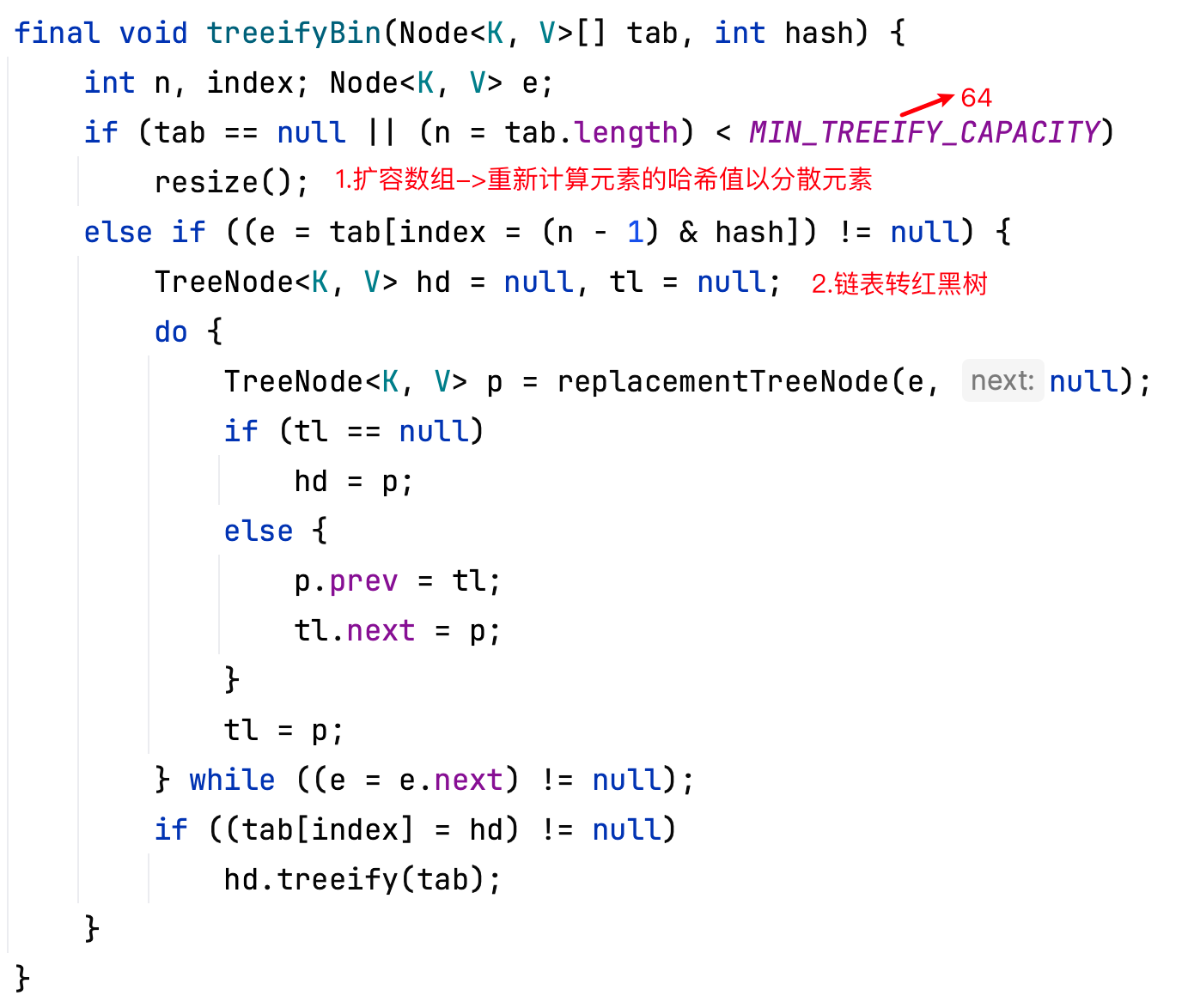

(2)链表挂载的元素超过了(>)8个(阈值),并且数组长度没有超过(<)64,扩容原数组2倍的大小

- 为什么是扩容为两倍?

如果n是2的次幂,那么对于任意的整数 x,x % n等价于 x & (n - 1)。

初始数组长度为16,一直扩容两倍,是因为要一直保证数组长度是2的次幂,从而可以用哈希值&(数组长度-1)来替代%操作。那么一个元素在扩容重新定位索引位置时,新的位置要么在原位置,要么在原长度+原位置的位置。保持哈希表的均匀性,减少碰撞。

数组长度变为原来的2倍,表现在二进制上就是多了一个高位参与数组下标确定。此时,一个元素哈希值是不会变的,索引位置是哈希值&(数组长度-1)。

假设数组长度=16(10000),数组长度-1为1111,现在要扩容为32(100000),数组长度-1为11111

本来是取哈希值的低4位按位与1111,现在是要取哈希值的低5位按位与11111,

那么哈希值低5位中的最高位是0则坐标不变,最高位是1则坐标变为“10000+原坐标”,即“原长度+原坐标”。因此,在扩容时,不需要重新计算元素的hash了,只需要判断最高位是1还是0就好了。

此时同一个链表上的元素也可能会重新分配到原位置或原长度+原位置的位置。比如哈希值1和17,原数组上都在位置1上,但是扩容后,1还是在位置1,17就去位置1+16=17了。

- 链表转红黑树

链表挂载的元素超过了(>)8个(阈值),并且数组长度达到了(>=)64,使链表转红黑树

源代码:

HashSet.java

public boolean add(E e) {

return map.put(e, PRESENT)==null;

}

HashMap.java

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

else {

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

final void treeifyBin(Node<K,V>[] tab, int hash) {

int n, index; Node<K,V> e;

if (tab == null || (n = tab.length) < MIN_TREEIFY_CAPACITY)

resize();

else if ((e = tab[index = (n - 1) & hash]) != null) {

TreeNode<K,V> hd = null, tl = null;

do {

TreeNode<K,V> p = replacementTreeNode(e, null);

if (tl == null)

hd = p;

else {

p.prev = tl;

tl.next = p;

}

tl = p;

} while ((e = e.next) != null);

if ((tab[index] = hd) != null)

hd.treeify(tab);

}

}

Object.java

@IntrinsicCandidate

public native int hashCode(); // 调用底层C++代码计算出的一个随机数(也就是地址值)

哈希表的时间复杂度

增删查的复杂度都是根据元素先计算哈希值得到元素索引然后再进行增删查的操作,因此理想情况下复杂度为O(1),当需要修改哈希表结构时,复杂度降为O(n),需要重新计算所有元素的哈希值得到新的索引。

add()->O(1)

remove()->O(1)

contains()->O(1)

clear()->O(n)

HashSet和HashMap哈希表结构的存储区别

HashSet哈希表结构:就是上述哈希表结构

HashMap哈希表结构:将键值对封装为Entry对象,然后取键做哈希值运算计算索引位置并存储