【目标检测/实例分割】OHEM+Focal Loss

一、OHEM

1. 目的:区分难分样本

2. 方法:多学习难例

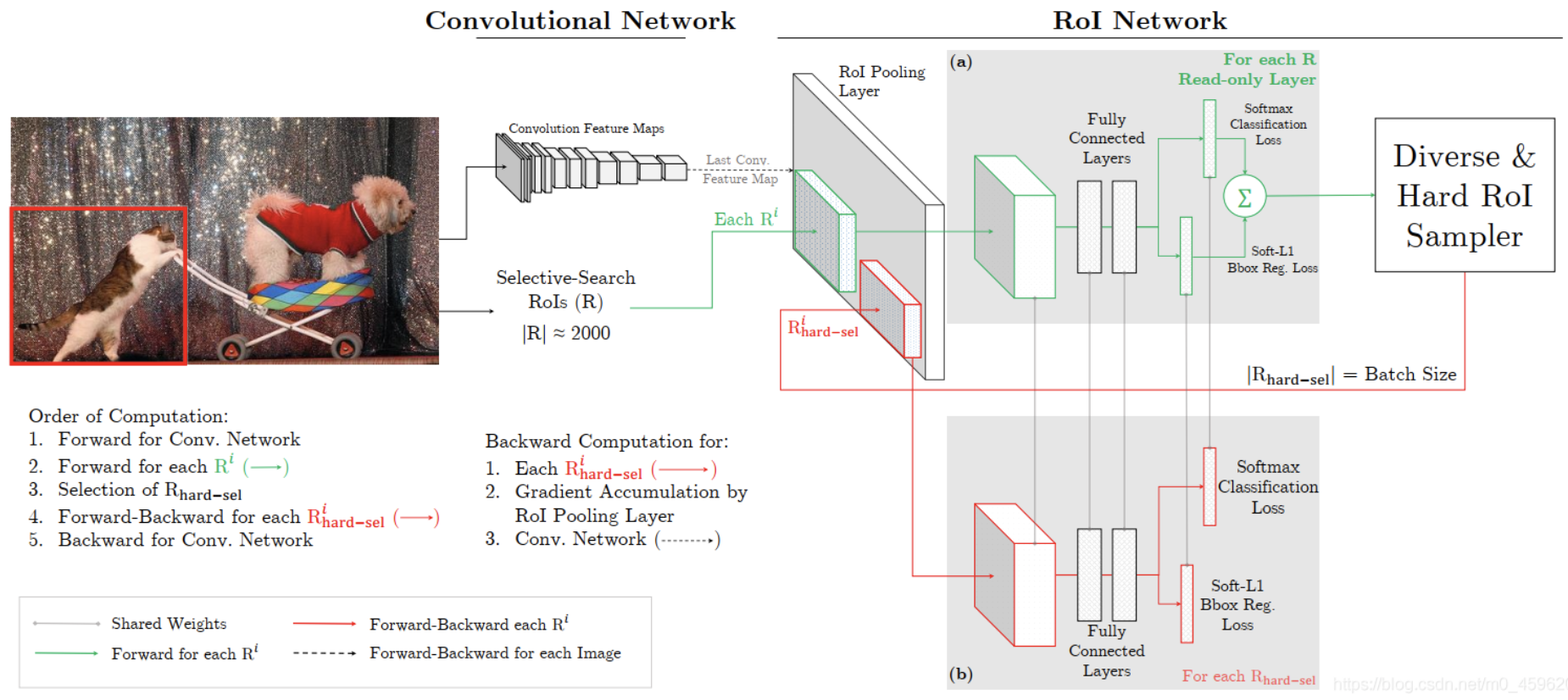

对于一次SGD迭代:先计算出特征图,可读RoI网络对所 有RoI执行前向计算并计算每个RoI的损失,然后选择hard RoIs。把这 些hard RoIs输入到可读可写的RoI网络中执行前向前向计算和反向传播更新网络,并把可读可写的RoI网络的参数赋值给只可读的网络,一次 迭代完成。

3.参考资料

https://blog.csdn.net/m0_45962052/article/details/105068998

二、Focal Loss

1. 目的:解决难易样本不均衡问题

2.方法:降低易分类样本的权重

3. 与OHEM区别:

Ohem按loss大小选负样本,但忽略了那些loss较小的easy的负样本,虽然这些easy负样本loss很小,但数量多,加起来的loss较大,对最终loss有一定贡献。Focol Loss想把这些loss较小的也融入到loss计算中。想融入一些easy example,希望他们能有助于训练,但又不希望他们主导loss。

OHEM一般用在RCNN层,在类别判断上效果明显,准召上提升也较明显,Focol_Loss一般用在RPN层,可以提升目标召回,但会带来噪声。

4.其他

Focal loss可以用于多分类

![]()

https://blog.csdn.net/u014311125/article/details/109470137

博文转载请注明出处。