LSTM简单入门

关于LSTM及RNN的基础知识以及相关的数学推导这篇博客介绍的很好,其中还包括神经网络的其他基础内容。

RNN循环神经网络:https://www.zybuluo.com/hanbingtao/note/541458

LSTM长短时记忆网络:https://zybuluo.com/hanbingtao/note/581764

在这篇博客(Tensorflow实例:利用LSTM预测股票每日最高价):http://blog.csdn.net/mylove0414/article/details/55805974中对如何使用Tensorflow构建LSTM有所介绍。

这类问题解决的步骤:

1、训练,测试数据处理

将数据从csv或者txt文件中读取,利用numpy工具转换成特定的格式,需要特别注意矩阵的维度信息

2、构建神经网络

1)、调整输入数据的维度,设定batch_size,time_step,input_size;

这三个参数,关于batch_size,暂时理解为每次喂多少组数据,比方说,训练时可以将一组数据重复喂给神经网络去训练许多次来更新权重,也可以将多组数据喂给神经网络每组只更新一次权重,batch_size的大小与收敛效果相关

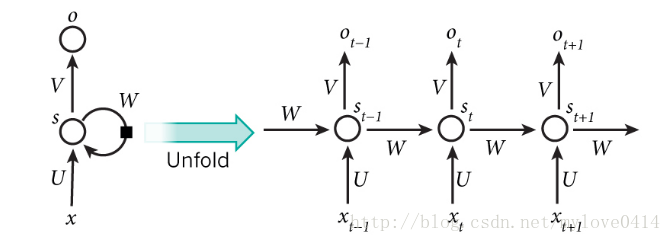

time_step是与RNN相关的一个重要参数,它指神经网络循环的深度,简单理解为RNN展开后宽度,在理解一个神经网络时,可以按左边的结构去想

Input_size指训练数据的维数

2)、设置BasicLSTMCell,DropoutWrapper,MultiRNNCell

DropoutWrapper主要有两个参数需要设定:input_keep_prob及output_keep_prob,它用于解决过拟合的问题。参考文献:https://arxiv.org/pdf/1409.2329.pdf

介绍DropoutWrapper的博客:http://blog.csdn.net/abclhq2005/article/details/78683656

3)、初始化可用zero_state函数实现

3、构建损失函数与优化目标

4、训练和测试

tf.nn.dynamic_rnn用于训练,训练得到的模型可以使用saver=tf.train.Saver()及saver.save()存储,利用modle=tf.train.latest_checkpoint()和saver.restore()恢复并测试

其他有用的博客包括:

多层LSTM构建:https://zhuanlan.zhihu.com/p/29797089

RNN与LSTM相关资源:http://suanfazu.com/t/rnn-lstm/13587/1