hadoop学习笔记(注意事项)

hadoop学习笔记(注意事项)

- 1、集群的启动(`start-all.sh`),任何用户都行(不管是master还是slave1、slave2),只要有一个启动就行,停止也一样(`stop-all.sh`)**

- 2、如果目录为空,那么不会报错,但是没有任何返回值

- 3、drwx是什么意思

- 4、心跳

- 5、hadoop fs、hadoop dfs与hdfs dfs命令的区别

- 6、目录如果有等号前面加'\'**(Linux本地中的目录需要加‘\’,hdfs中的目录不需要)

- 7、`-help`的使用

- 8、`tail -1000f ./hbase-root-regionserver-slave2.log`

- 9、`timedatectl status`

- 9.1、[Linux下使用timedatectl命令时间时区操作详解](https://www.cnblogs.com/zhi-leaf/p/6282301.html)

- 9.2、linux中 timedatectl set-time怎么设置不了时间

- 10、HBase安装时,各节点的系统时间相差不能大于30S

- 11、集群间成员传输文件夹(`-r`)

1、集群的启动(start-all.sh),任何用户都行(不管是master还是slave1、slave2),只要有一个启动就行,停止也一样(stop-all.sh)**

但是:

我发现,master进行start-all.sh我们三个人都可以访问50070和8088,但是master以外其他人启动我们不能访问8088,只能50070

http://172.16.29.121:8088/cluster

http://172.16.29.121:50070/dfshealth.html#tab-datanode

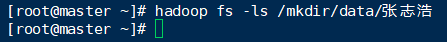

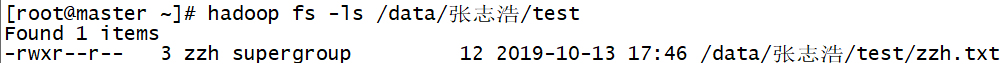

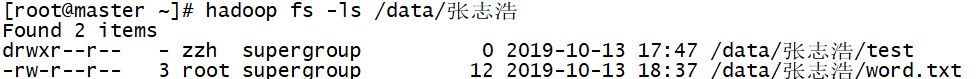

2、如果目录为空,那么不会报错,但是没有任何返回值

hadoop fs -ls <args>:

如果是文件,则按照如下格式返回文件信息:

权限 副本数 用户ID 组ID 文件大小 修改日期 修改时间 文件名

如果是目录,则返回它直接子文件的一个列表,就像在Unix中一样。目录返回列

表的信息如下:

权限 <副本数> 用户ID 组ID 文件大小 修改日期 修改时间 目录名(文件名)

Example:

hadoop fs -ls /user/hadoop/file1 /user/hadoop/file2 hdfs://host:port/user/hadoop/dir1 /nonexistentf

3、drwx是什么意思

首先d表示这个文件是一个文件夹,然后文件的权限一共有9个字符表示,分成三组,分别表示文件所属用户的权限,文件所属用户组的权限,其他人的权限,r 表示读权限, w表示写权限, x表示执行权限,我给的这个例子就是说这是个文件夹,并且此文件所属用户拥有读、写、执行三项权限,其余的用户组,其他用户不拥有任何权限(全部都是-)

4、心跳

主节点和从节点之间的通信是通过心跳机制实现的,如NameNode与DataNode之间,JobTracker和TaskTracker之间。所谓“心跳”是一种形象化描述,指的是持续的按照一定频率在运行,类似于心脏在永无休止的跳动。

1)hdfs是master/slave结构,master包括namenode和resourcemanager,slave包括datanode和nodemanager

2)master启动时会开启一个IPC服务,等待slave连接

3)slave启动后,会主动链接IPC服务,并且每隔3秒链接一次,这个时间是可以调整的,设置heartbeat,这个每隔一段时间连接一次的机制,称为心跳机制。Slave通过心跳给master汇报自己信息,master通过心跳下达命令。

原文链接:[https://blog.csdn.net/album_gyd/article/details/76686206]

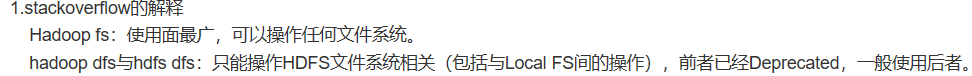

5、hadoop fs、hadoop dfs与hdfs dfs命令的区别

原文链接:https://blog.csdn.net/Luomingkui1109/article/details/80976981

6、目录如果有等号前面加’’**(Linux本地中的目录需要加‘\’,hdfs中的目录不需要)

/root/data/fanTop10/fc=1 是linux本地系统下的目录(我在linux本地下有fc=1目录)

/data/zzh/fanTop10 是hdfs的目录

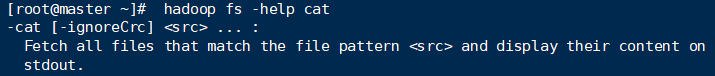

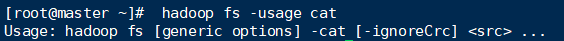

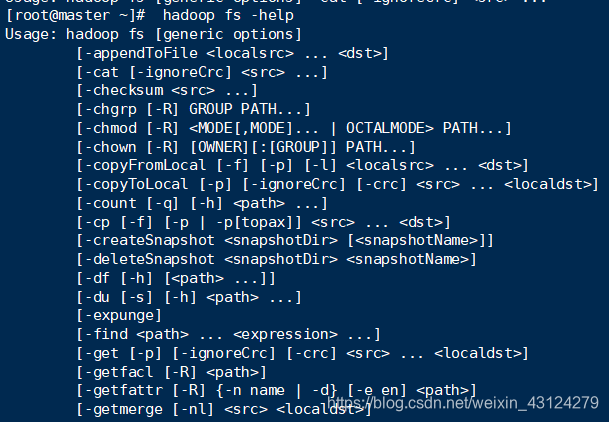

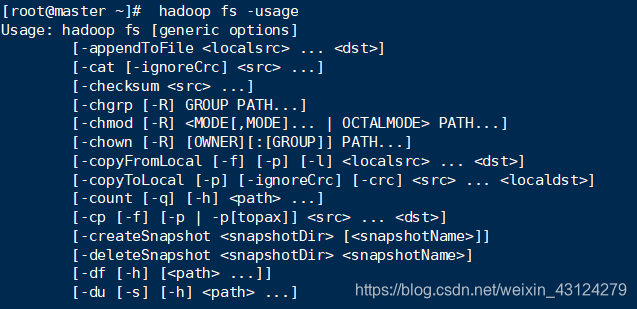

7、-help的使用

8、tail -1000f ./hbase-root-regionserver-slave2.log

9、timedatectl status

9.1、Linux下使用timedatectl命令时间时区操作详解

9.2、linux中 timedatectl set-time怎么设置不了时间

启动了时间同步造成的,关闭就好了。

关闭:timedatectl set-ntp no

开启:timedatectl set-ntp yes

10、HBase安装时,各节点的系统时间相差不能大于30S

11、集群间成员传输文件夹(-r)

scp -r /hadoop/spark-2.3.1-bin-hadoop2.7/ 172.16.29.122:/hadoop/

scp /hadoop/spark-2.3.1-bin-hadoop2.7/ slave1:/hadoop/