Spark中遇到的问题

spark启动slave时提示 JAVA_HOME is not set

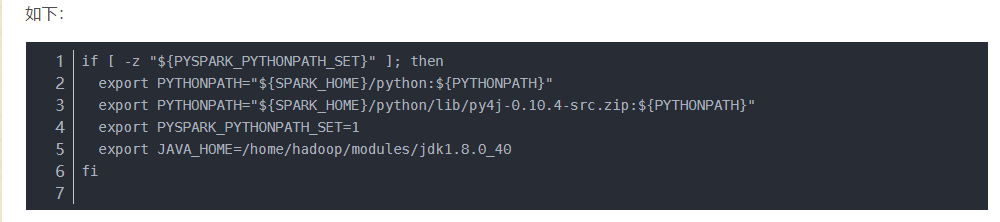

解决方法:

在sbin目录spark-config.sh 中添加自己的jdk 路径

export JAVA_HOME=/home/hadoop/modules/jdk

启动:

sbin/start-all.sh

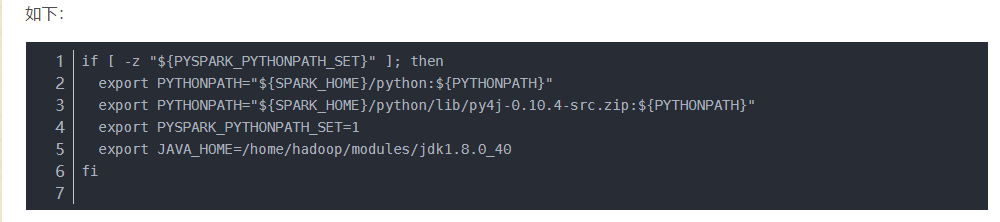

解决方法:

在sbin目录spark-config.sh 中添加自己的jdk 路径

export JAVA_HOME=/home/hadoop/modules/jdk

启动:

sbin/start-all.sh