深度学习_0_相关概念

SVM损失函数

-

L1 = max(0,5.1-3.2+1)+max(0,-1.7-3.2+1) l2 = ...... 损失函数:L=(L1+L2+L3)/3

-

当所有的分数几乎相同时:L=分类数-1 (就是max中的那个1.共有类数-1个)

-

为什么使用平均值? 无论分数如何变化loss不会改变

-

最优化w并不是唯一的,若w1对应loss为0,2*w 对应loss也为0

因此要选择正确的w L=原来的L+λR(w)(正则项) λ为超参数

-

常见的是L2正则化

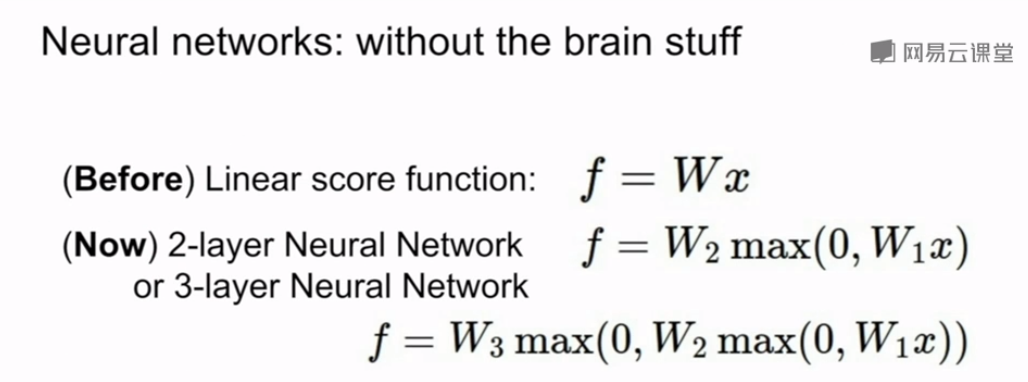

神经网络

卷积神经网络

卷积

- 图片:32*32*3

- 卷积核:3*3*3 前两个 3是卷积核大小,后一个是图片通道数,指定步长后滑动一次生成 一个[x,y,1]

- 假设有n个卷积核,这样就生成[x,y,n] 缩小图片大小,厚度增加

- 参数:n个卷积核 n*3*3 +n(偏执)

池化:

- 对于32*32*3的图片 ----->28*28*64 卷积

- 28*28*64 -------> 14*14*64 池化

- 通常也有滤波器 2*2 每次滑动步长为2 意思就是不重叠

- 池化方法通常是最大池化法:在2*2的4个值中选取最大的作为结果 没有参数,64的深度不变

- 通常使用最大池化,不是均值池化:因为它表示的是神经元在某一区域的感知, (只可意会,不和言传)

- 一般不用0填充

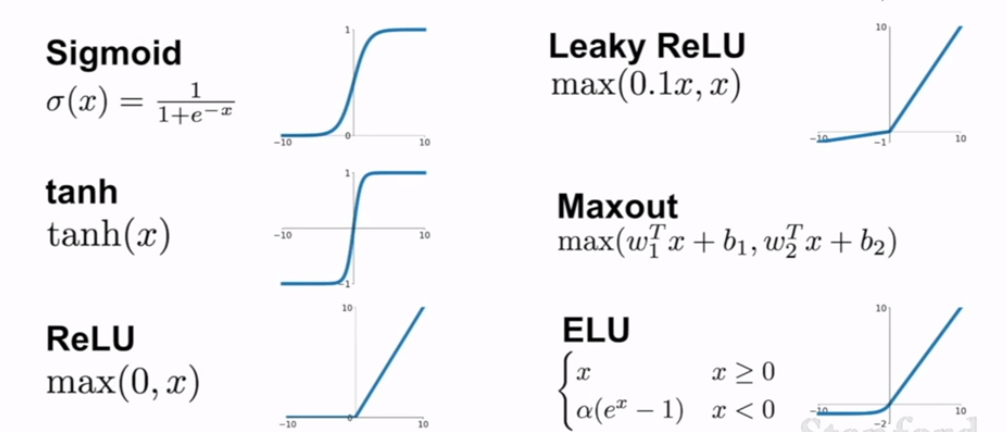

激活函数

批量归一化:Btach Normalization

(x-均值)/标准差 是的均值变为0

正则化

dropout

迁移学习

深度学习框架

caffe2----》caffe2:文件形式,不用写代码,

torch-----》pytorch:动态图,定义,计算一起 科研型

theano----》tensorflow:静态图,先定义图,后运行 产品类

keras:作为Tensorflow的高级应用程序接口 面向对象

CNN框架

神经网络架构:AlexNet,VGGNet,GoogleNet,ResNet

其他的架构:NIN,WIDE ResNeT

leNet:数字识别领域

AlexNet:卷积,池化,归一化,在卷积,池化,全连接 与LeNet类似,只不过层数变多

Vgg 16 19

GoogleNet 22 没有全连接层

ResNet 152层 残差网络

1,CNN,卷积神经网络,是以卷积为核心的一大类网络。

2,LeNet、AlexNet、VGG、GoogLeNet,属于CNN。

3 ,RCNN、Fast RCNN、Faster RCNN、YOLO、YOLOv2、SSD,也属于CNN,但和2是另一条路线。

2和3的区别在于,2属于用于图像分类的CNN,3属于用于目标检测的CNN。

RNN

...

图像语义分割:一张图片上有不同类的物体,用方框画出

1,图像划分为n多小块(可能是每个像素就是一块,但复杂度高 ),分别识别属于那一类,然后合在一起

对于相邻或重复的块,可以共享计算

2,全连接卷积网络

分类定位

知道物体数量

对象识别:目标检测

使用框框框主一类事物

1,框框大小变化位置移动,以此寻找目标位置 计算量大

2,寻找点状n个点状候选区(1000-2000),经过卷积计算RCNN

3,fast-rcnn

4,ssd 图片分为nxn的网格,检测每个格中概率

5,mask rcnn

PCA:主成分分析 降维方法

生成式模型:无监督学习的一种

pixelRNNs

pixelCNNs

自编码器VAE

生成式对抗网络

目标检测

自动驾驶

人脸检测与识别

行为识别

目标计数

实时目标检测

目标分类,定位目标

实时性与性能 需要平衡

浙公网安备 33010602011771号

浙公网安备 33010602011771号