网课-概率论学习笔记

基本概念

特别地,令

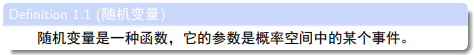

就是概率空间中某个事件在数域上的某种映射。

我们在随机变量上定义一些新运算。令

【注意:这里定义的新运算都是对于随机变量这一“函数”的运算,而非对它们的值的运算,并且运算的结果依旧是一个函数——随机变量。】

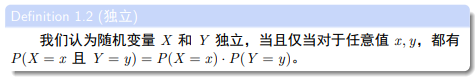

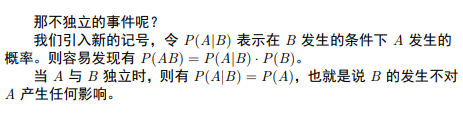

接下来将“独立”的概念从变量推广到事件。则有:

贝叶斯公式

即,在

看课件的意思,应该是说这个公式主要被用于在

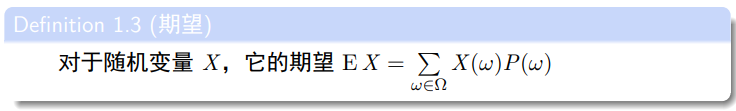

期望

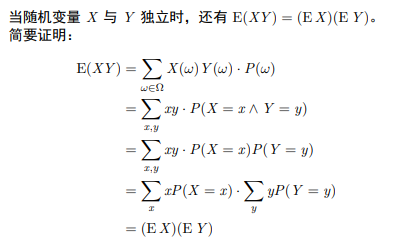

期望是一个作用于随机变量的函数,而且有一些特别的性质。比如,它是一个线性函数:

这个的证明如果搞懂了 (不像我一年多才搞懂它什么意思)

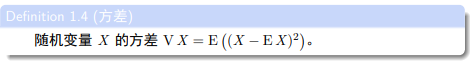

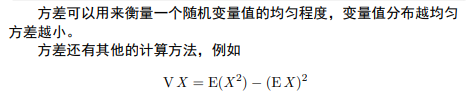

方差

这个定义我属实是说不清它为什么要定义成这样。。。

基本模型

我指的“基本模型”是直接计算期望而用不上 DP 的题型。

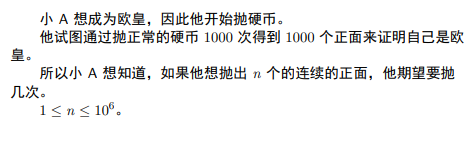

如何计算期望呢?首先容易想到用定义直接计算——枚举每种情况并乘上概率。还有一种办法即是用期望的线性性,将它拆为若干位置的期望之和,如果这些位置有随机变量值为

-

首先需要知道期望可以用线性性拆分,但不止一种拆分方式。比如这道题,你可以把它拆为

经过实践可以发现,本题中选择前者是更为简单的。这道题需要做一点观察和“组合意义”解说,而不是死推式子。发现其实

-

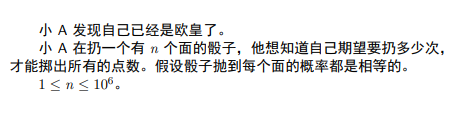

例二

把总期望用线性性拆解为每一次掷出新点数的期望次数之和。

首先,在掷出

最后求和,有总期望为

-

例三:P3802 小魔女帕琪

用线性性将总期望拆解为每个长度为

-

用线性性将总期望拆解为每个点被“选中”而不是被其它点删除的概率之和。令能到达

-

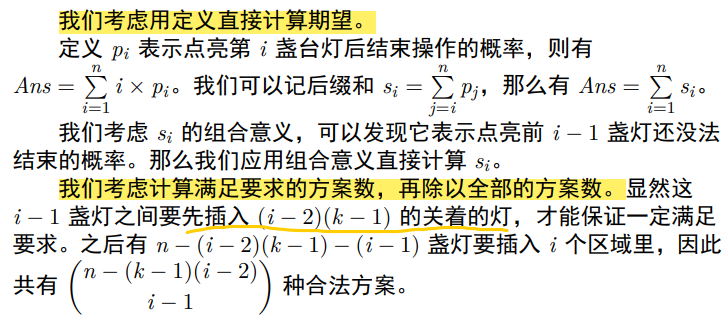

这道题所用到的方法是最原始的:按照期望定义计算期望,按照“满足要求的方案数除以总方案数”的概率定义计算概率。 但是,在我们做期望 dp、概率 dp、线性展开上头之后,这反而是非常容易被我们遗忘的方法。

另外就是一个求方案数时用到的 “类插板法” 的小技巧。

基础期望/概率 DP

这里是我把树上的 DP 单独列出去了。

期望/概率 DP 存在两点非常特殊之处:

-

通常是倒推的形式。

-

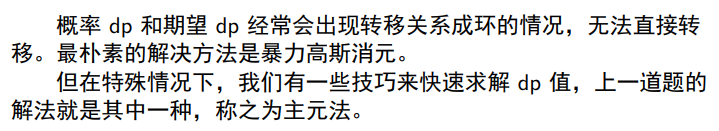

转移方程可能存在后效性,需要用高斯消元/主元法求解。

请结合以下题目理解。

-

例一

对于期望、概率 DP,我们常采用“倒推”的形式,原因可见 知乎-为什么通常期望dp要倒推?。

我们也拿这道题的正推法和倒推法对比一下。如果是正推法,

而若使用倒推法,则

肉眼可见,前者还需要维护一个概率

回到这题采用倒推做法上面。转移式中出现了

-

例二:Fish

由数据范围想到状压 DP,令状态表示当前集合中的鱼活着这种情况的概率。

-

首先,由于是概率 DP,想到倒推。先将 DP 方程加上“剩余人数”一维。

(然后就是我不知道题解是怎么想到的了)设-

对于

-

对于

接下来,对于每一层

-

树上期望/概率 DP

树上期望/概率 DP 和刚刚 DP 不同的地方在于它没有什么要“倒推”的地方了(树上问题怎么会有倒推呢???)。

但是,它依旧会存在后效性问题,因为既可能从父亲处更新也可能从儿子处更新。由于根节点没有父亲,它是主要的突破口。基于此,我们主要有两种解决方案:

-

换根 DP。

-

高斯消元/主元法。

-

这个题使用换根 DP 解决了概率 DP 的后效性问题。

-

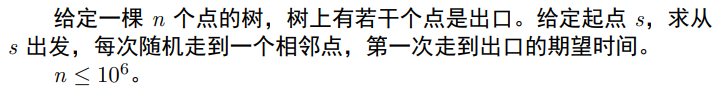

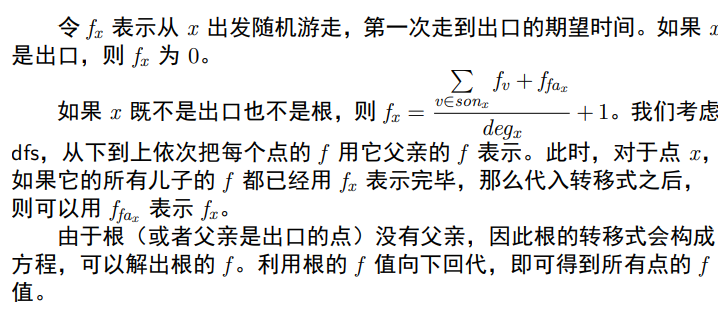

例二:基本树上随机游走

(这个题能不能从每个出口跑 DP,然后换根?——不太行。如果是这样,还需要特判其它出口不能进入,比较难处理。)

树上随机游走是树上期望/概率 DP 中的一个主要类别。

-

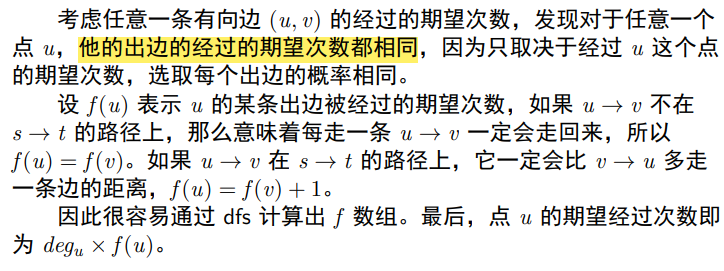

例三:Random Walk

这个题不算比较套路的树上期望/概率 DP。个人认为这个题的关键在将“点的期望经过次数”转化为“有向边的期望经过次数”。结论“出边的经过的期望次数都相同”实际是很反直觉的。这提示我们:

-

在期望、概率问题中,如果换一个角度想问题,经常会推到一些很反直觉但是正确的性质。 这和要依赖直觉再找证明的贪心是不一样的。

-

“转化法”,即将当前期望与更容易求的相关期望进行勾连。

-

-

对于树上情况,就是一个正常的换根 DP。(这里用高斯消元是行不通的。)

对于基环树情况,只需要对环上点进行一次 DP 后再换根即可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术

· .NET周刊【3月第1期 2025-03-02】