3.爬虫 urlib库讲解 总结

urllib库的总结:

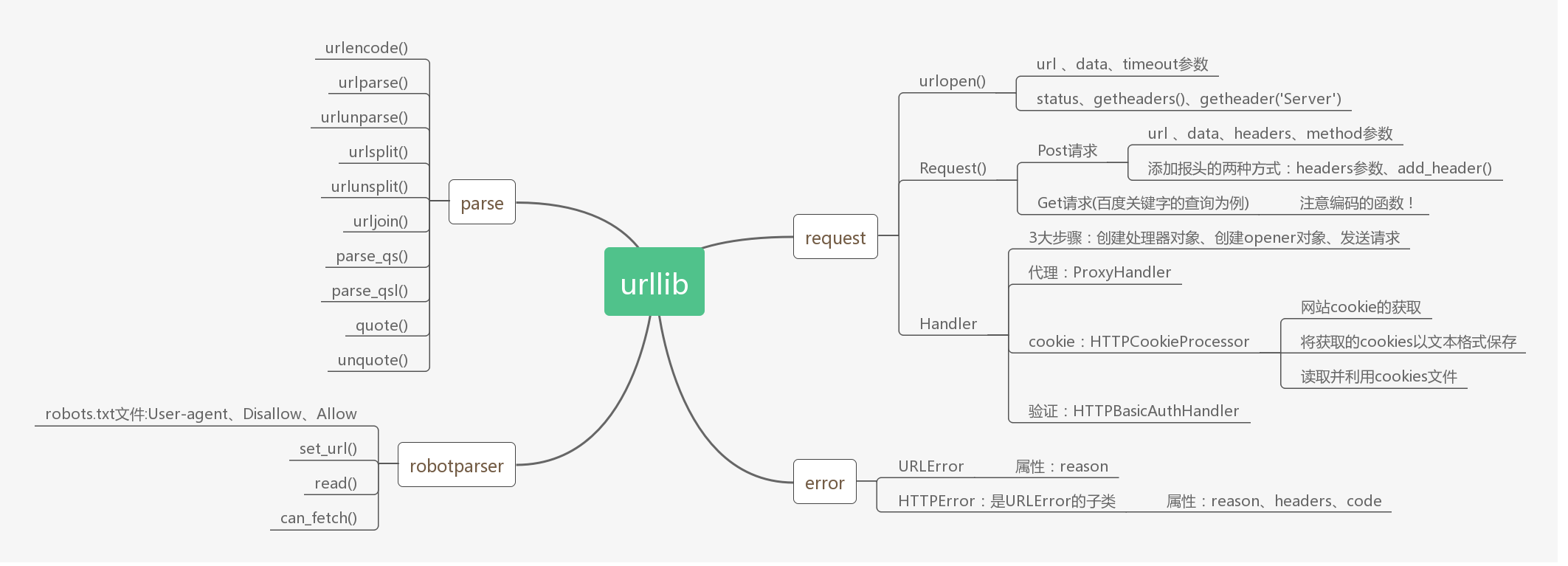

用ProcessOn(安利这个软件,够用了)根据前面的几节内容做了个思维导图。

urllib库一共有四个模块:

request:它是最基本的模块,可以用来模拟发送请求

error:异常处理模块,如果出现请求错误,我们可以捕获这些异常,然后进行重试或其它操作以保证程序不会意外终止

parse:一个工具模块,提供了URL处理方法,比如拆分、解析、合并等

robotparser:主要用来识别网站的robots.txt文件,然后判断哪些网站可以爬、哪些网站不可以爬,用的比较少。

爱笑的男孩运气都不会差

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步