1 2 3 4 5 6 7 8 9 | 版权申明:本文为博主窗户(Colin Cai)原创,欢迎转帖。如要转贴,必须注明原文网址http://www.cnblogs.com/Colin-Cai/p/7899171.html 作者:窗户QQ:6679072E-mail:6679072@qq.com |

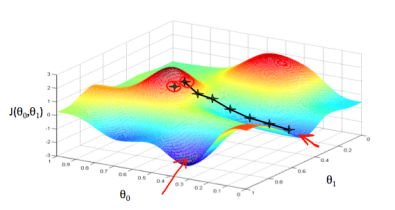

bp神经网络为大家所熟知,推导中使用了基于梯度下降。而对于更为一般的情况,解决问题的出发点是建立一组函数fi(Ci,Xi), i=1..n,n为输出的个数,也就是函数的个数,对于每个fi,Ci是一个参数向量,Xi是一个输入向量,我们的目标就是为这组函数中的每个fi找到最合适的Ci。

基于有导师的梯度下降,则每一步都是计算出误差,然后根据误差的梯度方向,找到最合适的参数。于是在此之前,要给定一个度量误差的函数,用以计算输出的n个值的向量,与实际所希望的n个值的向量之间的误差,本应是一个向量,现在给出一个函数(loss function),将此误差向量映射为一个标量。这个结果一般被称为距离。

一般来说,我们的fi当初选取的时候,都是对于所有的Ci ,Xi中所有分量都是可微的,不会出现奇点。而对于最终误差(用距离来描述)来说,我们要满足度量空间的概念:

1)正定性,任何两点距离都非负,只有两点重合的时候距离为0。

2)对称性,A点到B点的距离和B点到A点的距离相等。

3)三角形不等式,A点到B点距离不会大于A点到C点距离和C点到B点距离之和。

以上三点除了第二点都很重要,当然,为了方便,我们这里顺带上第二点。

再者,我们的结果有n个值,也就是一个n个维度的向量,最终做距离的时候希望距离函数可以对每个维度都是对称的。函数对于自变量的对称,用数学来描述如下:

L(x1...xn)关于x1...xn对称

<=>

对于任意1..n的一个排列k1...kn,都有

L(x1...xn) = L(xk1...xkn)

我们常用的n阶距满足度量空间也满足对每个维度的对称。

一般我们常用的距离有以下这些:

1)曼哈顿距离

2)欧氏距离

3)切比雪夫距离

4)闵氏距离

5)汉明距离

。。。

其中,闵氏距离的意思如下

(|x1-y1|n+...|xn-yn|n)1/n

曼哈顿距离和欧式距离只是闵式距离中的两种而已,切比雪夫距离是闵氏距离的极限。

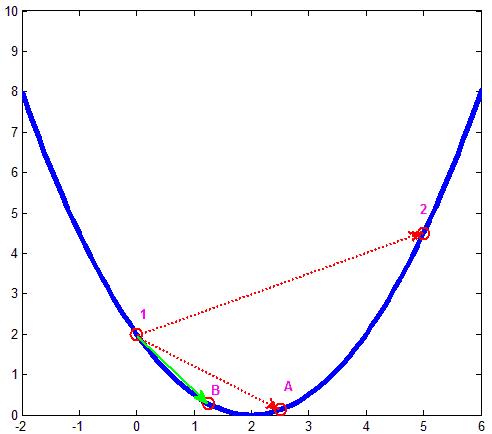

那么我们再来看另外一点,既然要梯度下降,自然要整体可导,而距离函数最终要把各维度的结果函数合成在一起,本身也必须可导,汉明距离、切比雪夫距离都不行,闵氏距离里这些n取奇数的绝对值符号不能消去,使得这个距离函数整体不可导,从而不是很方便使用梯度下降,而n取偶数是可以消去这个绝对值符号,从而整体可导。其中2阶是最低的,并且相对高阶对于各维公平一些,并且微分之后的结果复杂性最低,从而被常用。这和开平方之后的欧氏距离是一致的,如此最为经济。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· AI技术革命,工作效率10个最佳AI工具