redisson 使用全解 ——redisson 官方文档 + 注释

官方文档

Redisson 项目介绍

Redisson 是架设在 Redis 基础上的一个 Java 驻内存数据网格(In-Memory Data Grid)。充分的利用了 Redis 键值数据库提供的一系列优势,基于 Java 实用工具包中常用接口,为使用者提供了一系列具有分布式特性的常用工具类。使得原本作为协调单机多线程并发程序的工具包获得了协调分布式多机多线程并发系统的能力,大大降低了设计和研发大规模分布式系统的难度。同时结合各富特色的分布式服务,更进一步简化了分布式环境中程序相互之间的协作。

Redisson 采用了基于 NIO 的 Netty 框架,不仅能作为 Redis 底层驱动客户端,具备提供对 Redis 各种组态形式的连接功能,对 Redis 命令能以同步发送、异步形式发送、异步流形式发送或管道形式发送的功能,LUA 脚本执行处理,以及处理返回结果的功能,还在此基础上融入了更高级的应用方案,不但将原生的 Redis Hash,List,Set,String,Geo,HyperLogLog 等数据结构封装为 Java 里大家最熟悉的映射(Map),列表(List),集(Set),通用对象桶(Object Bucket),地理空间对象桶(Geospatial Bucket),基数估计算法(HyperLogLog)等结构,在这基础上还提供了分布式的多值映射(Multimap),本地缓存映射(LocalCachedMap),有序集(SortedSet),计分排序集(ScoredSortedSet),字典排序集(LexSortedSet),列队(Queue),阻塞队列(Blocking Queue),有界阻塞列队(Bounded Blocking Queue),双端队列(Deque),阻塞双端列队(Blocking Deque),阻塞公平列队(Blocking Fair Queue),延迟列队(Delayed Queue),布隆过滤器(Bloom Filter),原子整长形(AtomicLong),原子双精度浮点数(AtomicDouble),BitSet 等 Redis 原本没有的分布式数据结构。不仅如此,Redisson 还实现了 Redis 文档中提到像分布式锁 Lock 这样的更高阶应用场景。事实上 Redisson 并没有不止步于此,在分布式锁的基础上还提供了联锁(MultiLock),读写锁(ReadWriteLock),公平锁(Fair Lock),红锁(RedLock),信号量(Semaphore),可过期性信号量(PermitExpirableSemaphore)和闭锁(CountDownLatch)这些实际当中对多线程高并发应用至关重要的基本部件。正是通过实现基于 Redis 的高阶应用方案,使 Redisson 成为构建分布式系统的重要工具。

在提供这些工具的过程当中,Redisson 广泛的使用了承载于 Redis 订阅发布功能之上的分布式话题(Topic)功能。使得即便是在复杂的分布式环境下,Redisson 的各个实例仍然具有能够保持相互沟通的能力。在以这为前提下,结合了自身独有的功能完善的分布式工具,Redisson 进而提供了像分布式远程服务(Remote Service),分布式执行服务(Executor Service)和分布式调度任务服务(Scheduler Service)这样适用于不同场景的分布式服务。使得 Redisson 成为了一个基于 Redis 的 Java 中间件(Middleware)。

Redisson Node 的出现作为驻内存数据网格的重要特性之一,使 Redisson 能够独立作为一个任务处理节点,以系统服务的方式运行并自动加入 Redisson 集群,具备集群节点弹性增减的能力。然而在真正意义上让 Redisson 发展成为一个完整的驻内存数据网格的,还是具有将基本上任何复杂、多维结构的对象都能变为分布式对象的分布式实时对象服务(Live Object Service),以及与之相结合的,在分布式环境中支持跨节点对象引用(Distributed Object Reference)的功能。这些特色功能使 Redisson 具备了在分布式环境中,为 Java 程序提供了堆外空间(Off-Heap Memory)储存对象的能力。

Redisson 提供了使用 Redis 的最简单和最便捷的方法。Redisson 的宗旨是促进使用者对 Redis 的关注分离(Separation of Concern),从而让使用者能够将精力更集中地放在处理业务逻辑上。如果您现在正在使用其他的 Redis 的 Java 客户端,希望 Redis 命令和 Redisson 对象匹配列表 能够帮助您轻松的将现有代码迁徙到 Redisson 里来。如果目前 Redis 的应用场景还仅限于作为缓存使用,您也可以将 Redisson 轻松的整合到像 Spring 和 Hibernate 这样的常用框架里。除此外您也可以间接的通过 Java 缓存标准规范 JCache API (JSR-107) 接口来使用 Redisson。

Redisson 生而具有的高性能,分布式特性和丰富的结构等特点恰巧与 Tomcat 这类服务程序对会话管理器(Session Manager)的要求相吻合。利用这样的特点,Redisson 专门为 Tomcat 提供了会话管理器(Tomcat Session Manager)。

在此不难看出,Redisson 同其他 Redis Java 客户端有着很大的区别,相比之下其他客户端提供的功能还仅仅停留在作为数据库驱动层面上,比如仅针对 Redis 提供连接方式,发送命令和处理返回结果等。像上面这些高层次的应用则只能依靠使用者自行实现。

Redisson 支持 Redis 2.8 以上版本,支持 Java1.6 + 以上版本。

一、概述

Redisson 是一个在 Redis 的基础上实现的 Java 驻内存数据网格(In-Memory Data Grid)。它不仅提供了一系列的分布式的 Java 常用对象,还提供了许多分布式服务。其中包括 (BitSet, Set, Multimap, SortedSet, Map, List, Queue, BlockingQueue, Deque, BlockingDeque, Semaphore, Lock, AtomicLong, CountDownLatch, Publish / Subscribe, Bloom filter, Remote service, Spring cache, Executor service, Live Object service, Scheduler service) Redisson 提供了使用 Redis 的最简单和最便捷的方法。Redisson 的宗旨是促进使用者对 Redis 的关注分离(Separation of Concern),从而让使用者能够将精力更集中地放在处理业务逻辑上。

关于 Redisson 项目的详细介绍可以在官方网站找到。

每个 Redis 服务实例都能管理多达 1TB 的内存。

能够完美的在云计算环境里使用,并且支持 AWS ElastiCache 主备版,AWS ElastiCache 集群版,Azure Redis Cache 和阿里云(Aliyun)的云数据库 Redis 版

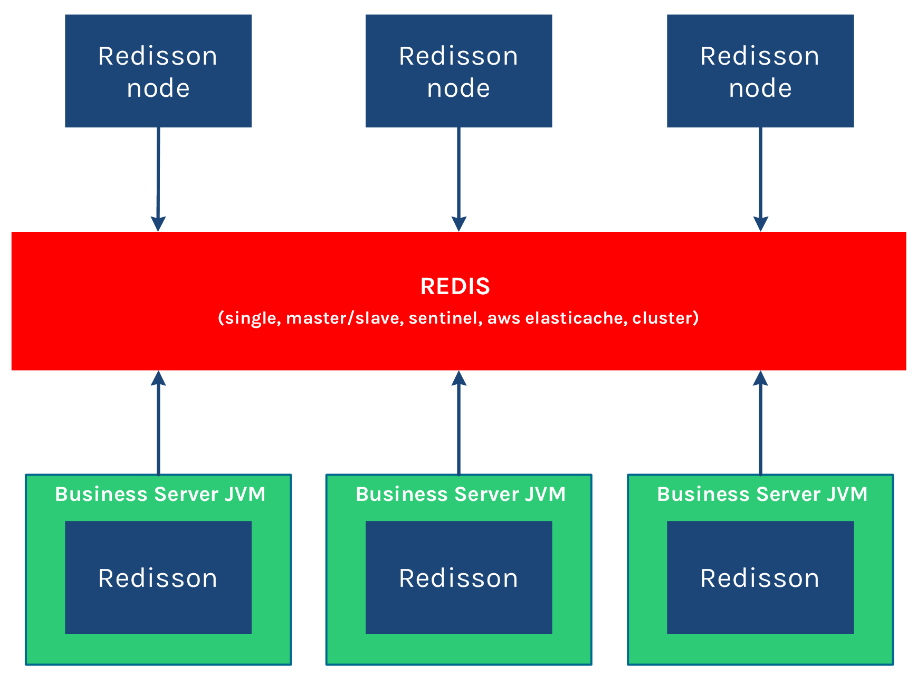

以下是 Redisson 的结构:

Redisson 作为独立节点 可以用于独立执行其他节点发布到分布式执行服务 和 分布式调度任务服务 里的远程任务。

如果你现在正在使用其他的 Redis 的 Java 客户端,那么 Redis 命令和 Redisson 对象匹配列表 能够帮助你轻松的将现有代码迁徙到 Redisson 框架里来。

Redisson 底层采用的是 Netty 框架。支持 Redis 2.8 以上版本,支持 Java1.6 + 以上版本。

欢迎试用高性能 Redisson PRO 版。

二、配置方法

引入 pom:

<dependency>

<groupId>org.redisson</groupId>

<artifactId>redisson</artifactId>

<version>3.12.3</version>

</dependency>2.1. 程序化配置方法

Redisson 程序化的配置方法是通过构建 Config 对象实例来实现的。例如:

Config config = new Config();

config.setTransportMode(TransportMode.EPOLL); // 默认是NIO的方式

config.useClusterServers()

//可以用"rediss://"来启用SSL连接,前缀必须是redis:// or rediss://

.addNodeAddress("redis://127.0.0.1:7181");2.2. 文件方式配置

Redisson 既可以通过用户提供的 YAML 格式的文本文件来配置

2.2.1 通过 YAML 格式配置

Redisson 的配置文件可以是或 YAML 格式。 也通过调用 config.fromYAML 方法并指定一个 File 实例来实现读取 YAML 格式的配置:

Config config = Config.fromYAML(new File("config-file.yaml"));

RedissonClient redisson = Redisson.create(config);调用 config.toYAML 方法可以将一个 Config 配置实例序列化为一个含有 YAML 数据类型的字符串:

Config config = new Config();

// ... 省略许多其他的设置

String jsonFormat = config.toYAML();2.3. 常用设置

以下是关于 org.redisson.Config 类的配置参数,它适用于所有 Redis 组态模式(单机,集群和哨兵)

codec(编码)

默认值: org.redisson.codec.JsonJacksonCodec

Redisson 的对象编码类是用于将对象进行序列化和反序列化,以实现对该对象在 Redis 里的读取和存储。Redisson 提供了以下几种的对象编码应用,以供大家选择:

| 编码类名称 | 说明 |

|---|---|

| org.redisson.codec.JsonJacksonCodec | Jackson JSON 编码 默认编码 |

| org.redisson.codec.AvroJacksonCodec | Avro 一个二进制的 JSON 编码 |

| org.redisson.codec.SmileJacksonCodec | Smile 另一个二进制的 JSON 编码 |

| org.redisson.codec.CborJacksonCodec | CBOR 又一个二进制的 JSON 编码 |

| org.redisson.codec.MsgPackJacksonCodec | MsgPack 再来一个二进制的 JSON 编码 |

| org.redisson.codec.IonJacksonCodec | Amazon Ion 亚马逊的 Ion 编码,格式与 JSON 类似 |

| org.redisson.codec.KryoCodec | Kryo 二进制对象序列化编码 |

| org.redisson.codec.SerializationCodec | JDK 序列化编码 |

| org.redisson.codec.FstCodec | FST 10 倍于 JDK 序列化性能而且 100% 兼容的编码 |

| org.redisson.codec.LZ4Codec | LZ4 压缩型序列化对象编码 |

| org.redisson.codec.SnappyCodec | Snappy 另一个压缩型序列化对象编码 |

| org.redisson.client.codec.JsonJacksonMapCodec | 基于 Jackson 的映射类使用的编码。可用于避免序列化类的信息,以及用于解决使用 byte [] 遇到的问题。 |

| org.redisson.client.codec.StringCodec | 纯字符串编码(无转换) |

| org.redisson.client.codec.LongCodec | 纯整长型数字编码(无转换) |

| org.redisson.client.codec.ByteArrayCodec | 字节数组编码 |

| org.redisson.codec.CompositeCodec | 用来组合多种不同编码在一起 |

threads(线程池数量)

默认值:当前处理核数量 * 2

这个线程池数量被所有 RTopic 对象监听器,RRemoteService 调用者和 RExecutorService 任务共同共享。

nettyThreads (Netty 线程池数量)

默认值:当前处理核数量 * 2

这个线程池数量是在一个 Redisson 实例内,被其创建的所有分布式数据类型和服务,以及底层客户端所一同共享的线程池里保存的线程数量。

executor(线程池)

单独提供一个用来执行所有 RTopic 对象监听器,RRemoteService 调用者和 RExecutorService 任务的线程池(ExecutorService)实例。

eventLoopGroup

用于特别指定一个 EventLoopGroup. EventLoopGroup 是用来处理所有通过 Netty 与 Redis 服务之间的连接发送和接受的消息。每一个 Redisson 都会在默认情况下自己创建管理一个 EventLoopGroup 实例。因此,如果在同一个 JVM 里面可能存在多个 Redisson 实例的情况下,采取这个配置实现多个 Redisson 实例共享一个 EventLoopGroup 的目的。

只有 io.netty.channel.epoll.EpollEventLoopGroup 或 io.netty.channel.nio.NioEventLoopGroup 才是允许的类型。

transportMode(传输模式)

默认值:TransportMode.NIO

可选参数:

TransportMode.NIO,

TransportMode.EPOLL - 需要依赖里有 netty-transport-native-epoll 包(Linux)

TransportMode.KQUEUE - 需要依赖里有 netty-transport-native-kqueue 包(macOS)

lockWatchdogTimeout(监控锁的看门狗超时,单位:毫秒)

默认值:30000

监控锁的看门狗超时时间单位为毫秒。该参数只适用于分布式锁的加锁请求中未明确使用 leaseTimeout 参数的情况。如果该看门口未使用 lockWatchdogTimeout 去重新调整一个分布式锁的 lockWatchdogTimeout 超时,那么这个锁将变为失效状态。这个参数可以用来避免由 Redisson 客户端节点宕机或其他原因造成死锁的情况。

keepPubSubOrder(保持订阅发布顺序)

默认值:true

通过该参数来修改是否按订阅发布消息的接收顺序出来消息,如果选否将对消息实行并行处理,该参数只适用于订阅发布消息的情况。

performanceMode(高性能模式)

默认值:HIGHER_THROUGHPUT

用来指定高性能引擎的行为。由于该变量值的选用与使用场景息息相关(NORMAL 除外)我们建议对每个参数值都进行尝试。

该参数仅限于 Redisson PRO 版本。

可选模式:

HIGHER_THROUGHPUT - 将高性能引擎切换到 高通量 模式。

LOWER_LATENCY_AUTO - 将高性能引擎切换到 低延时 模式并自动探测最佳设定。

LOWER_LATENCY_MODE_1 - 将高性能引擎切换到 低延时 模式并调整到预设模式 1。

LOWER_LATENCY_MODE_2 - 将高性能引擎切换到 低延时 模式并调整到预设模式 2。

NORMAL - 将高性能引擎切换到 普通 模式

2.4. 集群模式

集群模式除了适用于 Redis 集群环境,也适用于任何云计算服务商提供的集群模式,例如 AWS ElastiCache 集群版、Azure Redis Cache 和阿里云(Aliyun)的云数据库 Redis 版。

程序化配置集群的用法:

Config config = new Config();

config.useClusterServers()

.setScanInterval(2000) // 集群状态扫描间隔时间,单位是毫秒

//可以用"rediss://"来启用SSL连接,前缀必须是redis:// or rediss://

// 以下两种写法效果是一样的

.addNodeAddress("redis://127.0.0.1:7000", "redis://127.0.0.1:7001")

.addNodeAddress("redis://127.0.0.1:7002");

RedissonClient redisson = Redisson.create(config);2.4.1. 集群设置

介绍配置 Redis 集群组态的文档在这里。 Redis 集群组态的最低要求是必须有三个主节点。Redisson 的集群模式的使用方法如下:

ClusterServersConfig clusterConfig = config.useClusterServers();

ClusterServersConfig 类的设置参数如下:

nodeAddresses(添加节点地址)

可以通过 host:port 的格式来添加 Redis 集群节点的地址。多个节点可以一次性批量添加。

scanInterval(集群扫描间隔时间)

默认值: 1000

对 Redis 集群节点状态扫描的时间间隔。单位是毫秒。

slots(分片数量)

默认值: 231 用于指定数据分片过程中的分片数量。支持数据分片 / 框架结构有:集(Set)、映射(Map)、BitSet、Bloom filter, Spring Cache 和 Hibernate Cache 等.

readMode(读取操作的负载均衡模式)

默认值: SLAVE(只在从服务节点里读取)

注:在从服务节点里读取的数据说明已经至少有两个节点保存了该数据,确保了数据的高可用性。

设置读取操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里读取。 MASTER - 只在主服务节点里读取。 MASTER_SLAVE - 在主从服务节点里都可以读取。

subscriptionMode(订阅操作的负载均衡模式)

默认值:SLAVE(只在从服务节点里订阅)

设置订阅操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里订阅。 MASTER - 只在主服务节点里订阅。

loadBalancer(负载均衡算法类的选择)

默认值: org.redisson.connection.balancer.RoundRobinLoadBalancer

在多 Redis 服务节点的环境里,可以选用以下几种负载均衡方式选择一个节点: org.redisson.connection.balancer.WeightedRoundRobinBalancer - 权重轮询调度算法 org.redisson.connection.balancer.RoundRobinLoadBalancer - 轮询调度算法

org.redisson.connection.balancer.RandomLoadBalancer - 随机调度算法

subscriptionConnectionMinimumIdleSize(从节点发布和订阅连接的最小空闲连接数)

默认值:1

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的最小保持连接数(长连接)。Redisson 内部经常通过发布和订阅来实现许多功能。长期保持一定数量的发布订阅连接是必须的。

subscriptionConnectionPoolSize(从节点发布和订阅连接池大小)

默认值:50

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

slaveConnectionMinimumIdleSize(从节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时读取反映速度。

slaveConnectionPoolSize(从节点连接池大小)

默认值:64

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

masterConnectionMinimumIdleSize(主节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 主节点的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时写入反应速度。

masterConnectionPoolSize(主节点连接池大小)

默认值:64

主节点的连接池最大容量。连接池的连接数量自动弹性伸缩。

idleConnectionTimeout(连接空闲超时,单位:毫秒)

默认值:10000

如果当前连接池里的连接数量超过了最小空闲连接数,而同时有连接空闲时间超过了该数值,那么这些连接将会自动被关闭,并从连接池里去掉。时间单位是毫秒。

connectTimeout(连接超时,单位:毫秒)

默认值:10000

同任何节点建立连接时的等待超时。时间单位是毫秒。

timeout(命令等待超时,单位:毫秒)

默认值:3000

等待节点回复命令的时间。该时间从命令发送成功时开始计时。

retryAttempts(命令失败重试次数)

默认值:3

如果尝试达到 retryAttempts(命令失败重试次数) 仍然不能将命令发送至某个指定的节点时,将抛出错误。如果尝试在此限制之内发送成功,则开始启用 timeout(命令等待超时) 计时。

retryInterval(命令重试发送时间间隔,单位:毫秒)

默认值:1500

在某个节点执行相同或不同命令时,连续 失败 failedAttempts(执行失败最大次数) 时,该节点将被从可用节点列表里清除,直到 reconnectionTimeout(重新连接时间间隔) 超时以后再次尝试。

password(密码)

默认值:null

用于节点身份验证的密码。

subscriptionsPerConnection(单个连接最大订阅数量)

默认值:5

每个连接的最大订阅数量。

clientName(客户端名称)

默认值:null

在 Redis 节点里显示的客户端名称。

sslEnableEndpointIdentification(启用 SSL 终端识别)

默认值:true

开启 SSL 终端识别能力。

sslProvider(SSL 实现方式)

默认值:JDK

确定采用哪种方式(JDK 或 OPENSSL)来实现 SSL 连接。

sslTruststore(SSL 信任证书库路径)

默认值:null

指定 SSL 信任证书库的路径。

sslTruststorePassword(SSL 信任证书库密码)

默认值:null

指定 SSL 信任证书库的密码。

sslKeystore(SSL 钥匙库路径)

默认值:null

指定 SSL 钥匙库的路径。

sslKeystorePassword(SSL 钥匙库密码)

默认值:null

指定 SSL 钥匙库的密码。

2.4.2. 通过 YAML 文件配置集群模式

配置集群模式可以通过指定一个 YAML 格式的文件来实现。以下是 YAML 格式的配置文件样本。文件中的字段名称必须与 ClusterServersConfig 和 Config 对象里的字段名称相符。

---

clusterServersConfig:

idleConnectionTimeout: 10000

connectTimeout: 10000

timeout: 3000

retryAttempts: 3

retryInterval: 1500

password: null

subscriptionsPerConnection: 5

clientName: null

loadBalancer: !<org.redisson.connection.balancer.RoundRobinLoadBalancer> {}

slaveSubscriptionConnectionMinimumIdleSize: 1

slaveSubscriptionConnectionPoolSize: 50

slaveConnectionMinimumIdleSize: 32

slaveConnectionPoolSize: 64

masterConnectionMinimumIdleSize: 32

masterConnectionPoolSize: 64

readMode: "SLAVE"

nodeAddresses:

- "redis://127.0.0.1:7004"

- "redis://127.0.0.1:7001"

- "redis://127.0.0.1:7000"

scanInterval: 1000

threads: 0

nettyThreads: 0

codec: !<org.redisson.codec.JsonJacksonCodec> {}

"transportMode":"NIO"2.5. 云托管模式

云托管模式适用于任何由云计算运营商提供的 Redis 云服务,包括亚马逊云的 AWS ElastiCache、微软云的 Azure Redis 缓存和阿里云(Aliyun)的云数据库 Redis 版

程序化配置云托管模式的方法如下:

Config config = new Config();

config.useReplicatedServers()

.setScanInterval(2000) // 主节点变化扫描间隔时间

//可以用"rediss://"来启用SSL连接

.addNodeAddress("redis://127.0.0.1:7000", "redis://127.0.0.1:7001")

.addNodeAddress("redis://127.0.0.1:7002");

RedissonClient redisson = Redisson.create(config);2.5.1. 云托管模式设置

Redisson 的云托管模式的使用方法如下: ReplicatedServersConfig replicatedConfig = config.useReplicatedServers ();

ReplicatedServersConfig 类的设置参数如下:

nodeAddresses(节点地址)

可以通过 host:port 的格式来指定云托管模式的多个 Redis 集群节点的地址。多个节点可以一次性批量添加。所有的主从节点必须在配置阶段全部体现出来。

scanInterval(主节点变化扫描间隔时间)

默认值: 1000

对主节点变化节点状态扫描的时间间隔。单位是毫秒。

loadBalancer(负载均衡算法类的选择)

默认值: org.redisson.connection.balancer.RoundRobinLoadBalancer

在使用多个 Elasticache Redis 服务节点的环境里,可以选用以下几种负载均衡方式选择一个节点: org.redisson.connection.balancer.WeightedRoundRobinBalancer - 权重轮询调度算法 org.redisson.connection.balancer.RoundRobinLoadBalancer - 轮询调度算法 org.redisson.connection.balancer.RandomLoadBalancer - 随机调度算法

dnsMonitoringInterval(DNS 监控间隔,单位:毫秒)

默认值:5000

用来指定检查节点 DNS 变化的时间间隔。使用的时候应该确保 JVM 里的 DNS 数据的缓存时间保持在足够低的范围才有意义。用 - 1 来禁用该功能。

subscriptionConnectionMinimumIdleSize(从节点发布和订阅连接的最小空闲连接数)

默认值:1

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的最小保持连接数(长连接)。Redisson 内部经常通过发布和订阅来实现许多功能。长期保持一定数量的发布订阅连接是必须的。

subscriptionConnectionPoolSize(从节点发布和订阅连接池大小)

默认值:50

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

slaveConnectionMinimumIdleSize(从节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时读取反映速度。

slaveConnectionPoolSize(从节点连接池大小)

默认值:64

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

masterConnectionMinimumIdleSize(主节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 主节点的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时写入反应速度。

masterConnectionPoolSize(主节点连接池大小)

默认值:64

主节点的连接池最大容量。连接池的连接数量自动弹性伸缩。

idleConnectionTimeout(连接空闲超时,单位:毫秒)

默认值:10000

如果当前连接池里的连接数量超过了最小空闲连接数,而同时有连接空闲时间超过了该数值,那么这些连接将会自动被关闭,并从连接池里去掉。时间单位是毫秒。

readMode(读取操作的负载均衡模式)

默认值: SLAVE(只在从服务节点里读取)

注:在从服务节点里读取的数据说明已经至少有两个节点保存了该数据,确保了数据的高可用性。

设置读取操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里读取。 MASTER - 只在主服务节点里读取。 MASTER_SLAVE - 在主从服务节点里都可以读取。

subscriptionMode(订阅操作的负载均衡模式)

默认值:SLAVE(只在从服务节点里订阅)

设置订阅操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里订阅。 MASTER - 只在主服务节点里订阅。

connectTimeout(连接超时,单位:毫秒)

默认值:10000

同任何节点建立连接时的等待超时。时间单位是毫秒。

timeout(命令等待超时,单位:毫秒)

默认值:3000

等待节点回复命令的时间。该时间从命令发送成功时开始计时。

retryAttempts(命令失败重试次数)

默认值:3

如果尝试达到 retryAttempts(命令失败重试次数) 仍然不能将命令发送至某个指定的节点时,将抛出错误。如果尝试在此限制之内发送成功,则开始启用 timeout(命令等待超时) 计时。

retryInterval(命令重试发送时间间隔,单位:毫秒)

默认值:1500

在某个节点执行相同或不同命令时,连续 失败 failedAttempts(执行失败最大次数) 时,该节点将被从可用节点列表里清除,直到 reconnectionTimeout(重新连接时间间隔) 超时以后再次尝试。

database(数据库编号)

默认值:0

尝试连接的数据库编号。

password(密码)

默认值:null

用于节点身份验证的密码。

subscriptionsPerConnection(单个连接最大订阅数量)

默认值:5

每个连接的最大订阅数量。

clientName(客户端名称)

默认值:null

在 Redis 节点里显示的客户端名称。

sslEnableEndpointIdentification(启用 SSL 终端识别)

默认值:true

开启 SSL 终端识别能力。

sslProvider(SSL 实现方式)

默认值:JDK

确定采用哪种方式(JDK 或 OPENSSL)来实现 SSL 连接。

sslTruststore(SSL 信任证书库路径)

默认值:null

指定 SSL 信任证书库的路径。

sslTruststorePassword(SSL 信任证书库密码)

默认值:null

指定 SSL 信任证书库的密码。

sslKeystore(SSL 钥匙库路径)

默认值:null

指定 SSL 钥匙库的路径。

sslKeystorePassword(SSL 钥匙库密码)

默认值:null

指定 SSL 钥匙库的密码。

2.5.2. 通过 YAML 文件配置集群模式

配置云托管模式可以通过指定一个 YAML 格式的文件来实现。以下是 YAML 格式的配置文件样本。文件中的字段名称必须与 ReplicatedServersConfig 和 Config 对象里的字段名称相符。

---

replicatedServersConfig:

idleConnectionTimeout: 10000

connectTimeout: 10000

timeout: 3000

retryAttempts: 3

retryInterval: 1500

password: null

subscriptionsPerConnection: 5

clientName: null

loadBalancer: !<org.redisson.connection.balancer.RoundRobinLoadBalancer> {}

slaveSubscriptionConnectionMinimumIdleSize: 1

slaveSubscriptionConnectionPoolSize: 50

slaveConnectionMinimumIdleSize: 32

slaveConnectionPoolSize: 64

masterConnectionMinimumIdleSize: 32

masterConnectionPoolSize: 64

readMode: "SLAVE"

nodeAddresses:

- "redis://127.0.0.1:2812"

- "redis://127.0.0.1:2815"

- "redis://127.0.0.1:2813"

scanInterval: 1000

threads: 0

nettyThreads: 0

codec: !<org.redisson.codec.JsonJacksonCodec> {}

"transportMode":"NIO"2.6. 单 Redis 节点模式

程序化配置方法:

// 默认连接地址 127.0.0.1:6379

RedissonClient redisson = Redisson.create();

Config config = new Config();

config.useSingleServer().setAddress("redis://myredisserver:6379");

RedissonClient redisson = Redisson.create(config);2.6.1. 单节点设置

Redis 程序的配置和架设文档在这里。Redisson 的单 Redis 节点模式的使用方法如下: SingleServerConfig singleConfig = config.useSingleServer ();

SingleServerConfig 类的设置参数如下:

address(节点地址)

可以通过 host:port 的格式来指定节点地址。

subscriptionConnectionMinimumIdleSize(发布和订阅连接的最小空闲连接数)

默认值:1

用于发布和订阅连接的最小保持连接数(长连接)。Redisson 内部经常通过发布和订阅来实现许多功能。长期保持一定数量的发布订阅连接是必须的。

subscriptionConnectionPoolSize(发布和订阅连接池大小)

默认值:50

用于发布和订阅连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

connectionMinimumIdleSize(最小空闲连接数)

默认值:32

最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时写入反应速度。

connectionPoolSize(连接池大小)

默认值:64

在启用该功能以后,Redisson 将会监测 DNS 的变化情况。

dnsMonitoringInterval(DNS 监测时间间隔,单位:毫秒)

默认值:5000

监测 DNS 的变化情况的时间间隔。

idleConnectionTimeout(连接空闲超时,单位:毫秒)

默认值:10000

如果当前连接池里的连接数量超过了最小空闲连接数,而同时有连接空闲时间超过了该数值,那么这些连接将会自动被关闭,并从连接池里去掉。时间单位是毫秒。

connectTimeout(连接超时,单位:毫秒)

默认值:10000

同节点建立连接时的等待超时。时间单位是毫秒。

timeout(命令等待超时,单位:毫秒)

默认值:3000

等待节点回复命令的时间。该时间从命令发送成功时开始计时。

retryAttempts(命令失败重试次数)

默认值:3

如果尝试达到 retryAttempts(命令失败重试次数) 仍然不能将命令发送至某个指定的节点时,将抛出错误。如果尝试在此限制之内发送成功,则开始启用 timeout(命令等待超时) 计时。

retryInterval(命令重试发送时间间隔,单位:毫秒)

默认值:1500

在某个节点执行相同或不同命令时,连续 失败 failedAttempts(执行失败最大次数) 时,该节点将被从可用节点列表里清除,直到 reconnectionTimeout(重新连接时间间隔) 超时以后再次尝试。

database(数据库编号)

默认值:0

尝试连接的数据库编号。

password(密码)

默认值:null

用于节点身份验证的密码。

subscriptionsPerConnection(单个连接最大订阅数量)

默认值:5

每个连接的最大订阅数量。

clientName(客户端名称)

默认值:null

在 Redis 节点里显示的客户端名称。

sslEnableEndpointIdentification(启用 SSL 终端识别)

默认值:true

开启 SSL 终端识别能力。

sslProvider(SSL 实现方式)

默认值:JDK

确定采用哪种方式(JDK 或 OPENSSL)来实现 SSL 连接。

sslTruststore(SSL 信任证书库路径)

默认值:null

指定 SSL 信任证书库的路径。

sslTruststorePassword(SSL 信任证书库密码)

默认值:null

指定 SSL 信任证书库的密码。

sslKeystore(SSL 钥匙库路径)

默认值:null

指定 SSL 钥匙库的路径。

sslKeystorePassword(SSL 钥匙库密码)

默认值:null

指定 SSL 钥匙库的密码。

2.6.2. 通过 YAML 文件配置集群模式

配置单节点模式可以通过指定一个 YAML 格式的文件来实现。以下是 YAML 格式的配置文件样本。文件中的字段名称必须与 SingleServerConfig 和 Config 对象里的字段名称相符。

---

singleServerConfig:

idleConnectionTimeout: 10000

connectTimeout: 10000

timeout: 3000

retryAttempts: 3

retryInterval: 1500

password: null

subscriptionsPerConnection: 5

clientName: null

address: "redis://127.0.0.1:6379"

subscriptionConnectionMinimumIdleSize: 1

subscriptionConnectionPoolSize: 50

connectionMinimumIdleSize: 32

connectionPoolSize: 64

database: 0

dnsMonitoringInterval: 5000

threads: 0

nettyThreads: 0

codec: !<org.redisson.codec.JsonJacksonCodec> {}

"transportMode":"NIO"2.7. 哨兵模式

程序化配置哨兵模式的方法如下:

Config config = new Config();

config.useSentinelServers()

.setMasterName("mymaster")

//可以用"rediss://"来启用SSL连接

.addSentinelAddress("redis://127.0.0.1:26389", "redis://127.0.0.1:26379")

.addSentinelAddress("redis://127.0.0.1:26319");

RedissonClient redisson = Redisson.create(config);2.7.1. 哨兵模式设置

配置 Redis 哨兵服务的官方文档在这里。Redisson 的哨兵模式的使用方法如下: SentinelServersConfig sentinelConfig = config.useSentinelServers ();

SentinelServersConfig 类的设置参数如下:

dnsMonitoringInterval(DNS 监控间隔,单位:毫秒)

默认值:5000

用来指定检查节点 DNS 变化的时间间隔。使用的时候应该确保 JVM 里的 DNS 数据的缓存时间保持在足够低的范围才有意义。用 - 1 来禁用该功能。

masterName(主服务器的名称)

主服务器的名称是哨兵进程中用来监测主从服务切换情况的。

addSentinelAddress(添加哨兵节点地址)

可以通过 host:port 的格式来指定哨兵节点的地址。多个节点可以一次性批量添加。

readMode(读取操作的负载均衡模式)

默认值: SLAVE(只在从服务节点里读取)

注:在从服务节点里读取的数据说明已经至少有两个节点保存了该数据,确保了数据的高可用性。

设置读取操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里读取。 MASTER - 只在主服务节点里读取。 MASTER_SLAVE - 在主从服务节点里都可以读取。

subscriptionMode(订阅操作的负载均衡模式)

默认值:SLAVE(只在从服务节点里订阅)

设置订阅操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里订阅。 MASTER - 只在主服务节点里订阅。

loadBalancer(负载均衡算法类的选择)

默认值: org.redisson.connection.balancer.RoundRobinLoadBalancer

在使用多个 Redis 服务节点的环境里,可以选用以下几种负载均衡方式选择一个节点: org.redisson.connection.balancer.WeightedRoundRobinBalancer - 权重轮询调度算法 org.redisson.connection.balancer.RoundRobinLoadBalancer - 轮询调度算法 org.redisson.connection.balancer.RandomLoadBalancer - 随机调度算法

subscriptionConnectionMinimumIdleSize(从节点发布和订阅连接的最小空闲连接数)

默认值:1

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的最小保持连接数(长连接)。Redisson 内部经常通过发布和订阅来实现许多功能。长期保持一定数量的发布订阅连接是必须的。

subscriptionConnectionPoolSize(从节点发布和订阅连接池大小)

默认值:50

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

slaveConnectionMinimumIdleSize(从节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时读取反映速度。

slaveConnectionPoolSize(从节点连接池大小)

默认值:64

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

masterConnectionMinimumIdleSize(主节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 主节点的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时写入反应速度。

masterConnectionPoolSize(主节点连接池大小)

默认值:64

主节点的连接池最大容量。连接池的连接数量自动弹性伸缩。

idleConnectionTimeout(连接空闲超时,单位:毫秒)

默认值:10000

如果当前连接池里的连接数量超过了最小空闲连接数,而同时有连接空闲时间超过了该数值,那么这些连接将会自动被关闭,并从连接池里去掉。时间单位是毫秒。

connectTimeout(连接超时,单位:毫秒)

默认值:10000

同任何节点建立连接时的等待超时。时间单位是毫秒。

timeout(命令等待超时,单位:毫秒)

默认值:3000

等待节点回复命令的时间。该时间从命令发送成功时开始计时。

retryAttempts(命令失败重试次数)

默认值:3

如果尝试达到 retryAttempts(命令失败重试次数) 仍然不能将命令发送至某个指定的节点时,将抛出错误。如果尝试在此限制之内发送成功,则开始启用 timeout(命令等待超时) 计时。

retryInterval(命令重试发送时间间隔,单位:毫秒)

默认值:1500

在某个节点执行相同或不同命令时,连续 失败 failedAttempts(执行失败最大次数) 时,该节点将被从可用节点列表里清除,直到 reconnectionTimeout(重新连接时间间隔) 超时以后再次尝试。

database(数据库编号)

默认值:0

尝试连接的数据库编号。

password(密码)

默认值:null

用于节点身份验证的密码。

subscriptionsPerConnection(单个连接最大订阅数量)

默认值:5

每个连接的最大订阅数量。

clientName(客户端名称)

默认值:null

在 Redis 节点里显示的客户端名称。

sslEnableEndpointIdentification(启用 SSL 终端识别)

默认值:true

开启 SSL 终端识别能力。

sslProvider(SSL 实现方式)

默认值:JDK

确定采用哪种方式(JDK 或 OPENSSL)来实现 SSL 连接。

sslTruststore(SSL 信任证书库路径)

默认值:null

指定 SSL 信任证书库的路径。

sslTruststorePassword(SSL 信任证书库密码)

默认值:null

指定 SSL 信任证书库的密码。

sslKeystore(SSL 钥匙库路径)

默认值:null

指定 SSL 钥匙库的路径。

sslKeystorePassword(SSL 钥匙库密码)

默认值:null

指定 SSL 钥匙库的密码。

2.7.2. 通过 YAML 文件配置集群模式

配置哨兵模式可以通过指定一个 YAML 格式的文件来实现。以下是 YAML 格式的配置文件样本。文件中的字段名称必须与 SentinelServersConfig 和 Config 对象里的字段名称相符。

---

sentinelServersConfig:

idleConnectionTimeout: 10000

connectTimeout: 10000

timeout: 3000

retryAttempts: 3

retryInterval: 1500

password: null

subscriptionsPerConnection: 5

clientName: null

loadBalancer: !<org.redisson.connection.balancer.RoundRobinLoadBalancer> {}

slaveSubscriptionConnectionMinimumIdleSize: 1

slaveSubscriptionConnectionPoolSize: 50

slaveConnectionMinimumIdleSize: 32

slaveConnectionPoolSize: 64

masterConnectionMinimumIdleSize: 32

masterConnectionPoolSize: 64

readMode: "SLAVE"

sentinelAddresses:

- "redis://127.0.0.1:26379"

- "redis://127.0.0.1:26389"

masterName: "mymaster"

database: 0

threads: 0

nettyThreads: 0

codec: !<org.redisson.codec.JsonJacksonCodec> {}

"transportMode":"NIO"2.8. 主从模式

程序化配置主从模式的用法:

Config config = new Config();

config.useMasterSlaveServers()

//可以用"rediss://"来启用SSL连接

.setMasterAddress("redis://127.0.0.1:6379")

.addSlaveAddress("redis://127.0.0.1:6389", "redis://127.0.0.1:6332", "redis://127.0.0.1:6419")

.addSlaveAddress("redis://127.0.0.1:6399");

RedissonClient redisson = Redisson.create(config);2.8.1. 主从模式设置

介绍配置 Redis 主从服务组态的文档在这里. Redisson 的主从模式的使用方法如下: MasterSlaveServersConfig masterSlaveConfig = config.useMasterSlaveServers ();

MasterSlaveServersConfig 类的设置参数如下:

dnsMonitoringInterval(DNS 监控间隔,单位:毫秒)

默认值:5000

用来指定检查节点 DNS 变化的时间间隔。使用的时候应该确保 JVM 里的 DNS 数据的缓存时间保持在足够低的范围才有意义。用 - 1 来禁用该功能。

masterAddress(主节点地址)

可以通过 host:port 的格式来指定主节点地址。

addSlaveAddress(添加从主节点地址)

可以通过 host:port 的格式来指定从节点的地址。多个节点可以一次性批量添加。

readMode(读取操作的负载均衡模式)

默认值: SLAVE(只在从服务节点里读取)

注:在从服务节点里读取的数据说明已经至少有两个节点保存了该数据,确保了数据的高可用性。

设置读取操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里读取。 MASTER - 只在主服务节点里读取。 MASTER_SLAVE - 在主从服务节点里都可以读取。

subscriptionMode(订阅操作的负载均衡模式)

默认值:SLAVE(只在从服务节点里订阅)

设置订阅操作选择节点的模式。 可用值为: SLAVE - 只在从服务节点里订阅。 MASTER - 只在主服务节点里订阅。

loadBalancer(负载均衡算法类的选择)

默认值: org.redisson.connection.balancer.RoundRobinLoadBalancer

在使用多个 Redis 服务节点的环境里,可以选用以下几种负载均衡方式选择一个节点: org.redisson.connection.balancer.WeightedRoundRobinBalancer - 权重轮询调度算法 org.redisson.connection.balancer.RoundRobinLoadBalancer - 轮询调度算法 org.redisson.connection.balancer.RandomLoadBalancer - 随机调度算法

subscriptionConnectionMinimumIdleSize(从节点发布和订阅连接的最小空闲连接数)

默认值:1

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的最小保持连接数(长连接)。Redisson 内部经常通过发布和订阅来实现许多功能。长期保持一定数量的发布订阅连接是必须的。

subscriptionConnectionPoolSize(从节点发布和订阅连接池大小)

默认值:50

多从节点的环境里,每个 从服务节点里用于发布和订阅连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

slaveConnectionMinimumIdleSize(从节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时读取反映速度。

slaveConnectionPoolSize(从节点连接池大小)

默认值:64

多从节点的环境里,每个 从服务节点里用于普通操作(非 发布和订阅)连接的连接池最大容量。连接池的连接数量自动弹性伸缩。

masterConnectionMinimumIdleSize(主节点最小空闲连接数)

默认值:32

多从节点的环境里,每个 主节点的最小保持连接数(长连接)。长期保持一定数量的连接有利于提高瞬时写入反应速度。

masterConnectionPoolSize(主节点连接池大小)

默认值:64

主节点的连接池最大容量。连接池的连接数量自动弹性伸缩。

idleConnectionTimeout(连接空闲超时,单位:毫秒)

默认值:10000

如果当前连接池里的连接数量超过了最小空闲连接数,而同时有连接空闲时间超过了该数值,那么这些连接将会自动被关闭,并从连接池里去掉。时间单位是毫秒。

connectTimeout(连接超时,单位:毫秒)

默认值:10000

同任何节点建立连接时的等待超时。时间单位是毫秒。

timeout(命令等待超时,单位:毫秒)

默认值:3000

等待节点回复命令的时间。该时间从命令发送成功时开始计时。

retryAttempts(命令失败重试次数)

默认值:3

如果尝试达到 retryAttempts(命令失败重试次数) 仍然不能将命令发送至某个指定的节点时,将抛出错误。如果尝试在此限制之内发送成功,则开始启用 timeout(命令等待超时) 计时。

retryInterval(命令重试发送时间间隔,单位:毫秒)

默认值:1500

在某个节点执行相同或不同命令时,连续 失败 failedAttempts(执行失败最大次数) 时,该节点将被从可用节点列表里清除,直到 reconnectionTimeout(重新连接时间间隔) 超时以后再次尝试。

database(数据库编号)

默认值:0

尝试连接的数据库编号。

password(密码)

默认值:null

用于节点身份验证的密码。

subscriptionsPerConnection(单个连接最大订阅数量)

默认值:5

每个连接的最大订阅数量。

clientName(客户端名称)

默认值:null

在 Redis 节点里显示的客户端名称。

sslEnableEndpointIdentification(启用 SSL 终端识别)

默认值:true

开启 SSL 终端识别能力。

sslProvider(SSL 实现方式)

默认值:JDK

确定采用哪种方式(JDK 或 OPENSSL)来实现 SSL 连接。

sslTruststore(SSL 信任证书库路径)

默认值:null

指定 SSL 信任证书库的路径。

sslTruststorePassword(SSL 信任证书库密码)

默认值:null

指定 SSL 信任证书库的密码。

sslKeystore(SSL 钥匙库路径)

默认值:null

指定 SSL 钥匙库的路径。

sslKeystorePassword(SSL 钥匙库密码)

默认值:null

指定 SSL 钥匙库的密码。

2.8.2. 通过 YAML 文件配置集群模式

配置主从模式可以通过指定一个 YAML 格式的文件来实现。以下是 YAML 格式的配置文件样本。文件中的字段名称必须与 MasterSlaveServersConfig 和 Config 对象里的字段名称相符。

---

masterSlaveServersConfig:

idleConnectionTimeout: 10000

connectTimeout: 10000

timeout: 3000

retryAttempts: 3

retryInterval: 1500

failedAttempts: 3

password: null

subscriptionsPerConnection: 5

clientName: null

loadBalancer: !<org.redisson.connection.balancer.RoundRobinLoadBalancer> {}

slaveSubscriptionConnectionMinimumIdleSize: 1

slaveSubscriptionConnectionPoolSize: 50

slaveConnectionMinimumIdleSize: 32

slaveConnectionPoolSize: 64

masterConnectionMinimumIdleSize: 32

masterConnectionPoolSize: 64

readMode: "SLAVE"

slaveAddresses:

- "redis://127.0.0.1:6381"

- "redis://127.0.0.1:6380"

masterAddress: "redis://127.0.0.1:6379"

database: 0

threads: 0

nettyThreads: 0

codec: !<org.redisson.codec.JsonJacksonCodec> {}

"transportMode":"NIO"三、程序接口调用方式

RedissonClient、RedissonReactiveClient 和 RedissonRxClient 实例本身和 Redisson 提供的所有分布式对象都是线程安全的。

Redisson 为每个操作都提供了自动重试策略,当某个命令执行失败时,Redisson 会自动进行重试。自动重试策略可以通过修改 retryAttempts(默认值:3)参数和 retryInterval(默认值:1000 毫秒)参数来进行优化调整。当等待时间达到 retryInterval 指定的时间间隔以后,将自动重试下一次。全部重试失败以后将抛出错误。

Redisson 框架提供的几乎所有对象都包含了同步和异步相互匹配的方法。这些对象都可以通过 RedissonClient 接口获取。同时还为大部分 Redisson 对象提供了满足异步流处理标准的程序接口 RedissonReactiveClient。除此外还提供了 RxJava2 规范的 RedissonRxClient 程序接口。

以下是关于使用 RAtomicLong 对象的范例:

RedissonClient client = Redisson.create(config);

RAtomicLong longObject = client.getAtomicLong('myLong');

// 同步执行方式

longObject.compareAndSet(3, 401);

// 异步执行方式

RFuture<Boolean> result = longObject.compareAndSetAsync(3, 401);

RedissonReactiveClient client = Redisson.createReactive(config);

RAtomicLongReactive longObject = client.getAtomicLong('myLong');

// 异步流执行方式

Mono<Boolean> result = longObject.compareAndSet(3, 401);

RedissonRxClient client = Redisson.createRx(config);

RAtomicLongRx longObject= client.getAtomicLong("myLong");

// RxJava2方式

Flowable<Boolean result = longObject.compareAndSet(3, 401);3.1. 异步执行方式

几乎所有的 Redisson 对象都实现了一个异步接口,异步接口提供的方法名称与其同步接口的方法名称相互匹配。例如:

// RAtomicLong接口继承了RAtomicLongAsync接口

RAtomicLongAsync longObject = client.getAtomicLong("myLong");

RFuture<Boolean> future = longObject.compareAndSetAsync(1, 401);异步执行的方法都会返回一个实现了 RFuture 接口的对象。该对象同时提供了 java.util.concurrent.CompletionStage 和 java.util.concurrent.Future 两个异步接口。

future.whenComplete((res, exception) -> {

// ...

});

// 或者

future.thenAccept(res -> {

// 处理返回

}).exceptionally(exception -> {

// 处理错误

});3.2. 异步流执行方式

Redisson 为大多数分布式数据结构提供了满足 Reactor 项目的异步流处理标准的程序接口。该接口通过两种方式实现:

1. 基于 Project Reactor 标准的实现方式。使用范例如下:

RedissonReactiveClient client = Redisson.createReactive(config);

RAtomicLongReactive atomicLong = client.getAtomicLong("myLong");

Mono<Boolean> cs = longObject.compareAndSet(10, 91);

Mono<Long> get = longObject.get();

Publisher<Long> getPublisher = longObject.get();2. 基于 RxJava2 标准的实现方式。使用范例如下:

RedissonRxClient client = Redisson.createRx(config);

RAtomicLongRx atomicLong = client.getAtomicLong("myLong");

Single<Boolean> cs = longObject.compareAndSet(10, 91);

Single<Long> get = longObject.get();四、数据序列化

Redisson 的对象编码类是用于将对象进行序列化和反序列化,以实现对该对象在 Redis 里的读取和存储。Redisson 提供了以下几种的对象编码应用,以供大家选择:

| 编码类名称 | 说明 |

|---|---|

| org.redisson.codec.JsonJacksonCodec | Jackson JSON 编码 默认编码 |

| org.redisson.codec.AvroJacksonCodec | Avro 一个二进制的 JSON 编码 |

| org.redisson.codec.SmileJacksonCodec | Smile 另一个二进制的 JSON 编码 |

| org.redisson.codec.CborJacksonCodec | CBOR 又一个二进制的 JSON 编码 |

| org.redisson.codec.MsgPackJacksonCodec | MsgPack 再来一个二进制的 JSON 编码 |

| org.redisson.codec.IonJacksonCodec | Amazon Ion 亚马逊的 Ion 编码,格式与 JSON 类似 |

| org.redisson.codec.KryoCodec | Kryo 二进制对象序列化编码 |

| org.redisson.codec.SerializationCodec | JDK 序列化编码 |

| org.redisson.codec.FstCodec | FST 10 倍于 JDK 序列化性能而且 100% 兼容的编码 |

| org.redisson.codec.LZ4Codec | LZ4 压缩型序列化对象编码 |

| org.redisson.codec.SnappyCodec | Snappy 另一个压缩型序列化对象编码 |

| org.redisson.client.codec.JsonJacksonMapCodec | 基于 Jackson 的映射类使用的编码。可用于避免序列化类的信息,以及用于解决使用 byte [] 遇到的问题。 |

| org.redisson.client.codec.StringCodec | 纯字符串编码(无转换) |

| org.redisson.client.codec.LongCodec | 纯整长型数字编码(无转换) |

| org.redisson.client.codec.ByteArrayCodec | 字节数组编码 |

| org.redisson.codec.CompositeCodec | 用来组合多种不同编码在一起 |

五、单个集合数据分片(Sharding)

在集群模式下,Redisson 为单个 Redis 集合类型提供了自动分片的功能。

Redisson 提供的所有数据结构都支持在集群环境下使用,但每个数据结构只被保存在一个固定的槽内。Redisson PRO 提供的自动分片功能能够将单个数据结构拆分,然后均匀的分布在整个集群里,而不是被挤在单一一个槽里。自动分片功能的优势主要有以下几点:

- 单个数据结构可以充分利用整个集群内存资源,而不是被某一个节点的内存限制。

- 将单个数据结构分片以后分布在集群中不同的节点里,不仅可以大幅提高读写性能,还能够保证读写性能随着集群的扩张而自动提升。

Redisson 通过自身的分片算法,将一个大集合拆分为若干个片段(默认 231 个,分片数量范围是 3 - 16834),然后将拆分后的片段均匀的分布到集群里各个节点里,保证每个节点分配到的片段数量大体相同。比如在默认情况下 231 个片段分到含有 4 个主节点的集群里,每个主节点将会分配到大约 57 个片段,同样的道理如果有 5 个主节点,每个节点会分配到大约 46 个片段。

目前支持的数据结构类型和服务包括集(Set)、映射(Map)、BitSet、布隆过滤器(Bloom Filter)、Spring Cache 和 Hibernate Cache。

该功能仅限于 Redisson PRO 版本。

六、分布式对象

每个 Redisson 对象实例都会有一个与之对应的 Redis 数据实例,可以通过调用 getName 方法来取得 Redis 数据实例的名称(key)。

RMap map = redisson.getMap("mymap");

map.getName(); // = mymap所有与 Redis key 相关的操作都归纳在 RKeys 这个接口里:

RKeys keys = redisson.getKeys();

Iterable<String> allKeys = keys.getKeys();

Iterable<String> foundedKeys = keys.getKeysByPattern('key*');

long numOfDeletedKeys = keys.delete("obj1", "obj2", "obj3");

long deletedKeysAmount = keys.deleteByPattern("test?");

String randomKey = keys.randomKey();

long keysAmount = keys.count();6.1. 通用对象桶(Object Bucket)

Redisson 的分布式 RBucketJava 对象是一种通用对象桶可以用来存放任类型的对象。 除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RBucket<AnyObject> bucket = redisson.getBucket("anyObject");

bucket.set(new AnyObject(1));

AnyObject obj = bucket.get();

bucket.trySet(new AnyObject(3));

bucket.compareAndSet(new AnyObject(4), new AnyObject(5));

bucket.getAndSet(new AnyObject(6));还可以通过 RBuckets 接口实现批量操作多个 RBucket 对象:

RBuckets buckets = redisson.getBuckets();

List<RBucket<V>> foundBuckets = buckets.find("myBucket*");

Map<String, V> loadedBuckets = buckets.get("myBucket1", "myBucket2", "myBucket3");

Map<String, Object> map = new HashMap<>();

map.put("myBucket1", new MyObject());

map.put("myBucket2", new MyObject());

// 利用Redis的事务特性,同时保存所有的通用对象桶,如果任意一个通用对象桶已经存在则放弃保存其他所有数据。

buckets.trySet(map);

// 同时保存全部通用对象桶。

buckets.set(map);6.2. 二进制流(Binary Stream)

Redisson 的分布式 RBinaryStream Java 对象同时提供了 InputStream 接口和 OutputStream 接口的实现。流的最大容量受 Redis 主节点的内存大小限制。

RBinaryStream stream = redisson.getBinaryStream("anyStream");

byte[] content = ...

stream.set(content);

InputStream is = stream.getInputStream();

byte[] readBuffer = new byte[512];

is.read(readBuffer);

OutputStream os = stream.getOuputStream();

byte[] contentToWrite = ...

os.write(contentToWrite);6.3. 地理空间对象桶(Geospatial Bucket)

Redisson 的分布式 RGeo Java 对象是一种专门用来储存与地理位置有关的对象桶。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RGeo<String> geo = redisson.getGeo("test");

geo.add(new GeoEntry(13.361389, 38.115556, "Palermo"),

new GeoEntry(15.087269, 37.502669, "Catania"));

geo.addAsync(37.618423, 55.751244, "Moscow");

Double distance = geo.dist("Palermo", "Catania", GeoUnit.METERS);

geo.hashAsync("Palermo", "Catania");

Map<String, GeoPosition> positions = geo.pos("test2", "Palermo", "test3", "Catania", "test1");

List<String> cities = geo.radius(15, 37, 200, GeoUnit.KILOMETERS);

Map<String, GeoPosition> citiesWithPositions = geo.radiusWithPosition(15, 37, 200, GeoUnit.KILOMETERS);6.4. BitSet

Redisson 的分布式 RBitSetJava 对象采用了与 java.util.BiteSet 类似结构的设计风格。可以理解为它是一个分布式的可伸缩式位向量。需要注意的是 RBitSet 的大小受 Redis 限制,最大长度为 4 294 967 295。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RBitSet set = redisson.getBitSet("simpleBitset");

set.set(0, true);

set.set(1812, false);

set.clear(0);

set.addAsync("e");

set.xor("anotherBitset");6.4.1. BitSet 数据分片(Sharding)(分布式 RoaringBitMap)

基于 Redis 的 Redisson 集群分布式 BitSet 通过 RClusteredBitSet 接口,为集群状态下的 Redis 环境提供了 BitSet 数据分片的功能。通过优化后更加有效的分布式 RoaringBitMap 算法,突破了原有的 BitSet 大小限制,达到了集群物理内存容量大小。在这里可以获取更多的内部信息。

RClusteredBitSet set = redisson.getClusteredBitSet("simpleBitset");

set.set(0, true);

set.set(1812, false);

set.clear(0);

set.addAsync("e");

set.xor("anotherBitset");该功能仅限于 Redisson PRO 版本。

6.5. 原子整长形(AtomicLong)

Redisson 的分布式整长形 RAtomicLong 对象和 Java 中的 java.util.concurrent.atomic.AtomicLong 对象类似。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RAtomicLong atomicLong = redisson.getAtomicLong("myAtomicLong");

atomicLong.set(3);

atomicLong.incrementAndGet();

atomicLong.get();6.6. 原子双精度浮点(AtomicDouble)

Redisson 还提供了分布式原子双精度浮点 RAtomicDouble,弥补了 Java 自身的不足。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RAtomicDouble atomicDouble = redisson.getAtomicDouble("myAtomicDouble");

atomicDouble.set(2.81);

atomicDouble.addAndGet(4.11);

atomicDouble.get();6.7. 话题(订阅分发)

Redisson 的分布式话题 RTopic (http://static.javadoc.io/org.redisson/redisson/3.10.0/org/redisson/api/RTopic.html 对象实现了发布、订阅的机制。除了同步接口外,还提供了异步(Async (http://static.javadoc.io/org.redisson/redisson/3.10.0/org/redisson/api/RTopicAsync.html))、反射式(Reactive (http://static.javadoc.io/org.redisson/redisson/3.10.0/org/redisson/api/RTopicReactive.html))和 RxJava2 (http://static.javadoc.io/org.redisson/redisson/3.10.0/org/redisson/api/RTopicRx.html) 标准的接口。

RTopic topic = redisson.getTopic("anyTopic");

topic.addListener(SomeObject.class, new MessageListener<SomeObject>() {

@Override

public void onMessage(String channel, SomeObject message) {

//...

}

});

// 在其他线程或JVM节点

RTopic topic = redisson.getTopic("anyTopic");

long clientsReceivedMessage = topic.publish(new SomeObject());在 Redis 节点故障转移(主从切换)或断线重连以后,所有的话题监听器将自动完成话题的重新订阅。

6.7.1. 模糊话题

Redisson 的模糊话题 RPatternTopic 对象可以通过正式表达式来订阅多个话题。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

// 订阅所有满足`topic1.*`表达式的话题

RPatternTopic topic1 = redisson.getPatternTopic("topic1.*");

int listenerId = topic1.addListener(Message.class, new PatternMessageListener<Message>() {

@Override

public void onMessage(String pattern, String channel, Message msg) {

Assert.fail();

}

});在 Redis 节点故障转移(主从切换)或断线重连以后,所有的模糊话题监听器将自动完成话题的重新订阅。

6.8. 布隆过滤器(Bloom Filter)

Redisson 利用 Redis 实现了 Java 分布式布隆过滤器(Bloom Filter)。所含最大比特数量为 232。

RBloomFilter<SomeObject> bloomFilter = redisson.getBloomFilter("sample");

// 初始化布隆过滤器,预计统计元素数量为55000000,期望误差率为0.03

bloomFilter.tryInit(55000000L, 0.03);

bloomFilter.add(new SomeObject("field1Value", "field2Value"));

bloomFilter.add(new SomeObject("field5Value", "field8Value"));

bloomFilter.contains(new SomeObject("field1Value", "field8Value"));6.8.1. 布隆过滤器数据分片(Sharding)

基于 Redis 的 Redisson 集群分布式布隆过滤器通过 RClusteredBloomFilter 接口,为集群状态下的 Redis 环境提供了布隆过滤器数据分片的功能。 通过优化后更加有效的算法,通过压缩未使用的比特位来释放集群内存空间。每个对象的状态都将被分布在整个集群中。所含最大比特数量为 2^64。在这里可以获取更多的内部信息。

RClusteredBloomFilter<SomeObject> bloomFilter = redisson.getClusteredBloomFilter("sample");

// 采用以下参数创建布隆过滤器

// expectedInsertions = 255000000

// falseProbability = 0.03

bloomFilter.tryInit(255000000L, 0.03);

bloomFilter.add(new SomeObject("field1Value", "field2Value"));

bloomFilter.add(new SomeObject("field5Value", "field8Value"));

bloomFilter.contains(new SomeObject("field1Value", "field8Value"));该功能仅限于 Redisson PRO 版本。

6.9. 基数估计算法(HyperLogLog)

Redisson 利用 Redis 实现了 Java 分布式基数估计算法(HyperLogLog)对象。该对象可以在有限的空间内通过概率算法统计大量的数据。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RHyperLogLog<Integer> log = redisson.getHyperLogLog("log");

log.add(1);

log.add(2);

log.add(3);

log.count();6.10. 整长型累加器(LongAdder)

基于 Redis 的 Redisson 分布式整长型累加器(LongAdder)采用了与 java.util.concurrent.atomic.LongAdder 类似的接口。通过利用客户端内置的 LongAdder 对象,为分布式环境下递增和递减操作提供了很高得性能。据统计其性能最高比分布式 AtomicLong 对象快 12000 倍。完美适用于分布式统计计量场景。

RLongAdder atomicLong = redisson.getLongAdder("myLongAdder");

atomicLong.add(12);

atomicLong.increment();

atomicLong.decrement();

atomicLong.sum();当不再使用整长型累加器对象的时候应该自行手动销毁,如果 Redisson 对象被关闭(shutdown)了,则不用手动销毁。

RLongAdder atomicLong = ...

atomicLong.destroy();6.11. 双精度浮点累加器(DoubleAdder)

基于 Redis 的 Redisson 分布式双精度浮点累加器(DoubleAdder)采用了与 java.util.concurrent.atomic.DoubleAdder 类似的接口。通过利用客户端内置的 DoubleAdder 对象,为分布式环境下递增和递减操作提供了很高得性能。据统计其性能最高比分布式 AtomicDouble 对象快 12000 倍。完美适用于分布式统计计量场景。

RLongDouble atomicDouble = redisson.getLongDouble("myLongDouble");

atomicDouble.add(12);

atomicDouble.increment();

atomicDouble.decrement();

atomicDouble.sum();当不再使用双精度浮点累加器对象的时候应该自行手动销毁,如果 Redisson 对象被关闭(shutdown)了,则不用手动销毁。

RLongDouble atomicDouble = ...

_b6d2063_

atomicDouble.destroy();6.12. 限流器(RateLimiter)

基于 Redis 的分布式限流器(RateLimiter)可以用来在分布式环境下现在请求方的调用频率。既适用于不同 Redisson 实例下的多线程限流,也适用于相同 Redisson 实例下的多线程限流。该算法不保证公平性。除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RRateLimiter rateLimiter = redisson.getRateLimiter("myRateLimiter");

// 初始化

// 最大流速 = 每1秒钟产生10个令牌

rateLimiter.trySetRate(RateType.OVERALL, 10, 1, RateIntervalUnit.SECONDS);

CountDownLatch latch = new CountDownLatch(2);

limiter.acquire(3);

// ...

Thread t = new Thread(() -> {

limiter.acquire(2);

// ...

});七、分布式集合

7.1. 映射(Map)

基于 Redis 的 Redisson 的分布式映射结构的 RMap Java 对象实现了 java.util.concurrent.ConcurrentMap 接口和 java.util.Map 接口。与 HashMap 不同的是,RMap 保持了元素的插入顺序。该对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

除了同步接口外,还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。如果你想用 Redis Map 来保存你的 POJO 的话,可以考虑使用分布式实时对象(Live Object)服务。

在特定的场景下,映射缓存(Map)上的高度频繁的读取操作,使网络通信都被视为瓶颈时,可以使用 Redisson 提供的带有本地缓存功能的映射。

RMap<String, SomeObject> map = redisson.getMap("anyMap");

SomeObject prevObject = map.put("123", new SomeObject());

SomeObject currentObject = map.putIfAbsent("323", new SomeObject());

SomeObject obj = map.remove("123");

map.fastPut("321", new SomeObject());

map.fastRemove("321");

RFuture<SomeObject> putAsyncFuture = map.putAsync("321");

RFuture<Void> fastPutAsyncFuture = map.fastPutAsync("321");

map.fastPutAsync("321", new SomeObject());

map.fastRemoveAsync("321");映射的字段锁的用法:

RMap<MyKey, MyValue> map = redisson.getMap("anyMap");

MyKey k = new MyKey();

RLock keyLock = map.getLock(k);

keyLock.lock();

try {

MyValue v = map.get(k);

// 其他业务逻辑

} finally {

keyLock.unlock();

}

RReadWriteLock rwLock = map.getReadWriteLock(k);

rwLock.readLock().lock();

try {

MyValue v = map.get(k);

// 其他业务逻辑

} finally {

keyLock.readLock().unlock();

}7.1.1. 映射(Map)的元素淘汰(Eviction),本地缓存(LocalCache)和数据分片(Sharding)

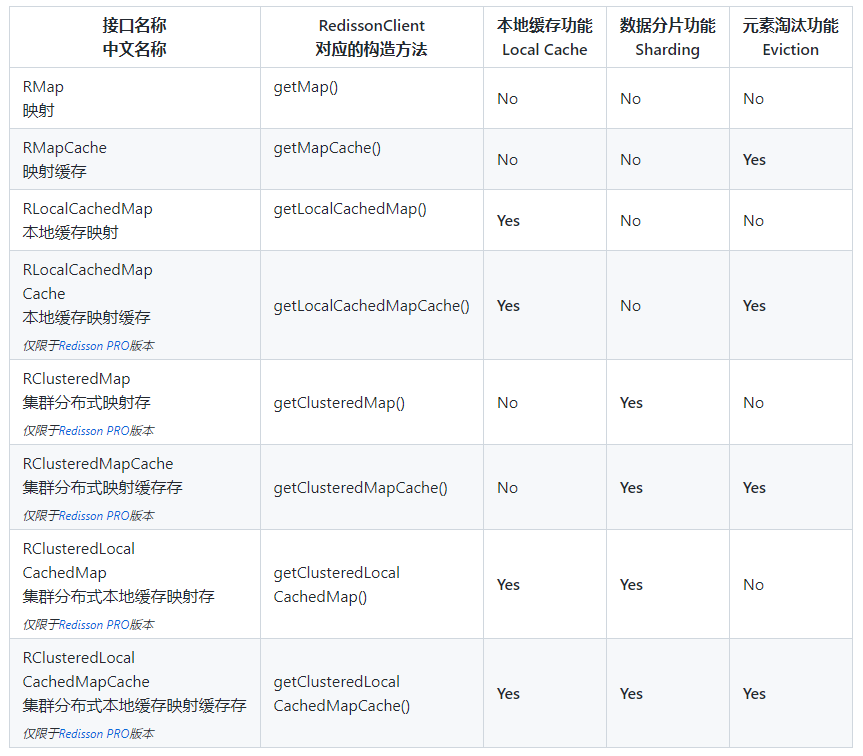

Redisson 提供了一系列的映射类型的数据结构,这些结构按特性主要分为三大类:

-

元素淘汰(Eviction) 类 – 带有元素淘汰(Eviction)机制的映射类允许针对一个映射中每个元素单独设定 有效时间 和 最长闲置时间 。

-

本地缓存(LocalCache) 类 – 本地缓存(Local Cache)也叫就近缓存(Near Cache)。这类映射的使用主要用于在特定的场景下,映射缓存(MapCache)上的高度频繁的读取操作,使网络通信都被视为瓶颈的情况。Redisson 与 Redis 通信的同时,还将部分数据保存在本地内存里。这样的设计的好处是它能将读取速度提高最多 45 倍 。 所有同名的本地缓存共用一个订阅发布话题,所有更新和过期消息都将通过该话题共享。

-

数据分片(Sharding) 类 – 数据分片(Sharding)类仅适用于 Redis 集群环境下,因此带有数据分片(Sharding)功能的映射也叫集群分布式映射。它利用分库的原理,将单一一个映射结构切分为若干个小的映射,并均匀的分布在集群中的各个槽里。这样的设计能使一个单一映射结构突破 Redis 自身的容量限制,让其容量随集群的扩大而增长。在扩容的同时,还能够使读写性能和元素淘汰处理能力随之成线性增长。

以下列表是 Redisson 提供的所有映射的名称及其特性:

除此以外,Redisson 还提供了 Spring Cache 和 JCache 的实现。

元素淘汰功能(Eviction)

Redisson 的分布式的 RMapCache Java 对象在基于 RMap 的前提下实现了针对单个元素的淘汰机制。同时仍然保留了元素的插入顺序。由于 RMapCache 是基于 RMap 实现的,使它同时继承了 java.util.concurrent.ConcurrentMap 接口和 java.util.Map 接口。Redisson 提供的 Spring Cache 整合以及 JCache 正是基于这样的功能来实现的。

目前的 Redis 自身并不支持散列(Hash)当中的元素淘汰,因此所有过期元素都是通过 org.redisson.EvictionScheduler 实例来实现定期清理的。为了保证资源的有效利用,每次运行最多清理 300 个过期元素。任务的启动时间将根据上次实际清理数量自动调整,间隔时间趋于 1 秒到 1 小时之间。比如该次清理时删除了 300 条元素,那么下次执行清理的时间将在 1 秒以后(最小间隔时间)。一旦该次清理数量少于上次清理数量,时间间隔将增加 1.5 倍。

RMapCache<String, SomeObject> map = redisson.getMapCache("anyMap");

// 有效时间 ttl = 10分钟

map.put("key1", new SomeObject(), 10, TimeUnit.MINUTES);

// 有效时间 ttl = 10分钟, 最长闲置时间 maxIdleTime = 10秒钟

map.put("key1", new SomeObject(), 10, TimeUnit.MINUTES, 10, TimeUnit.SECONDS);

// 有效时间 = 3 秒钟

map.putIfAbsent("key2", new SomeObject(), 3, TimeUnit.SECONDS);

// 有效时间 ttl = 40秒钟, 最长闲置时间 maxIdleTime = 10秒钟

map.putIfAbsent("key2", new SomeObject(), 40, TimeUnit.SECONDS, 10, TimeUnit.SECONDS);本地缓存功能(Local Cache)

在特定的场景下,映射(Map)上的高度频繁的读取操作,使网络通信都被视为瓶颈时,使用 Redisson 提供的带有本地缓存功能的分布式本地缓存映射 RLocalCachedMapJava 对象会是一个很好的选择。它同时实现了 java.util.concurrent.ConcurrentMap 和 java.util.Map 两个接口。本地缓存功能充分的利用了 JVM 的自身内存空间,对部分常用的元素实行就地缓存,这样的设计让读取操作的性能较分布式映射相比提高最多 45 倍 。以下配置参数可以用来创建这个实例:

LocalCachedMapOptions options = LocalCachedMapOptions.defaults()

// 用于淘汰清除本地缓存内的元素

// 共有以下几种选择:

// LFU - 统计元素的使用频率,淘汰用得最少(最不常用)的。

// LRU - 按元素使用时间排序比较,淘汰最早(最久远)的。

// SOFT - 元素用Java的WeakReference来保存,缓存元素通过GC过程清除。

// WEAK - 元素用Java的SoftReference来保存, 缓存元素通过GC过程清除。

// NONE - 永不淘汰清除缓存元素。

.evictionPolicy(EvictionPolicy.NONE)

// 如果缓存容量值为0表示不限制本地缓存容量大小

.cacheSize(1000)

// 以下选项适用于断线原因造成了未收到本地缓存更新消息的情况。

// 断线重连的策略有以下几种:

// CLEAR - 如果断线一段时间以后则在重新建立连接以后清空本地缓存

// LOAD - 在服务端保存一份10分钟的作废日志

// 如果10分钟内重新建立连接,则按照作废日志内的记录清空本地缓存的元素

// 如果断线时间超过了这个时间,则将清空本地缓存中所有的内容

// NONE - 默认值。断线重连时不做处理。

.reconnectionStrategy(ReconnectionStrategy.NONE)

// 以下选项适用于不同本地缓存之间相互保持同步的情况

// 缓存同步策略有以下几种:

// INVALIDATE - 默认值。当本地缓存映射的某条元素发生变动时,同时驱逐所有相同本地缓存映射内的该元素

// UPDATE - 当本地缓存映射的某条元素发生变动时,同时更新所有相同本地缓存映射内的该元素

// NONE - 不做任何同步处理

.syncStrategy(SyncStrategy.INVALIDATE)

// 每个Map本地缓存里元素的有效时间,默认毫秒为单位

.timeToLive(10000)

// 或者

.timeToLive(10, TimeUnit.SECONDS)

// 每个Map本地缓存里元素的最长闲置时间,默认毫秒为单位

.maxIdle(10000)

// 或者

.maxIdle(10, TimeUnit.SECONDS);RLocalCachedMap<String, Integer> map = redisson.getLocalCachedMap("test", options);

String prevObject = map.put("123", 1);

String currentObject = map.putIfAbsent("323", 2);

String obj = map.remove("123");

// 在不需要旧值的情况下可以使用fast为前缀的类似方法

map.fastPut("a", 1);

map.fastPutIfAbsent("d", 32);

map.fastRemove("b");

RFuture<String> putAsyncFuture = map.putAsync("321");

RFuture<Void> fastPutAsyncFuture = map.fastPutAsync("321");

map.fastPutAsync("321", new SomeObject());

map.fastRemoveAsync("321");当不再使用 Map 本地缓存对象的时候应该手动销毁,如果 Redisson 对象被关闭(shutdown)了,则不用手动销毁。

RLocalCachedMap<String, Integer> map = ...

map.destroy();如何通过加载数据的方式来降低过期淘汰事件发布信息对网络的影响

代码范例:

public void loadData(String cacheName, Map<String, String> data) {

RLocalCachedMap<String, String> clearMap = redisson.getLocalCachedMap(cacheName,

LocalCachedMapOptions.defaults().cacheSize(1).syncStrategy(SyncStrategy.INVALIDATE));

RLocalCachedMap<String, String> loadMap = redisson.getLocalCachedMap(cacheName,

LocalCachedMapOptions.defaults().cacheSize(1).syncStrategy(SyncStrategy.NONE));

loadMap.putAll(data);

clearMap.clearLocalCache();

}数据分片功能(Sharding)

Map 数据分片是 Redis 集群模式下的一个功能。Redisson 提供的分布式集群映射 RClusteredMap Java 对象也是基于 RMap 实现的。它同时实现了 java.util.concurrent.ConcurrentMap 和 java.util.Map 两个接口。

RClusteredMap<String, SomeObject> map = redisson.getClusteredMap("anyMap");

SomeObject prevObject = map.put("123", new SomeObject());

SomeObject currentObject = map.putIfAbsent("323", new SomeObject());

SomeObject obj = map.remove("123");

map.fastPut("321", new SomeObject());

map.fastRemove("321");7.1.2. 映射持久化方式(缓存策略)

Redisson 供了将映射中的数据持久化到外部储存服务的功能。主要场景有一下几种:

- 将 Redisson 的分布式映射类型作为业务和外部储存媒介之间的缓存。

- 或是用来增加 Redisson 映射类型中数据的持久性,或是用来增加已被驱逐的数据的寿命。

- 或是用来缓存数据库,Web 服务或其他数据源的数据。

Read-through 策略

通俗的讲,如果一个被请求的数据不存在于 Redisson 的映射中的时候,Redisson 将通过预先配置好的 MapLoader 对象加载数据。

Write-through(数据同步写入)策略

在遇到映射中某条数据被更改时,Redisson 会首先通过预先配置好的 MapWriter 对象写入到外部储存系统,然后再更新 Redis 内的数据。

Write-behind(数据异步写入)策略

对映射的数据的更改会首先写入到 Redis,然后再使用异步的方式,通过 MapWriter 对象写入到外部储存系统。在并发环境下可以通过 writeBehindThreads 参数来控制写入线程的数量,已达到对外部储存系统写入并发量的控制。

以上策略适用于所有实现了 RMap、RMapCache、RLocalCachedMap 和 RLocalCachedMapCache 接口的对象。

配置范例:

MapOptions<K, V> options = MapOptions.<K, V>defaults()

.writer(myWriter)

.loader(myLoader);

RMap<K, V> map = redisson.getMap("test", options);

// 或

RMapCache<K, V> map = redisson.getMapCache("test", options);

// 或

RLocalCachedMap<K, V> map = redisson.getLocalCachedMap("test", options);

// 或

RLocalCachedMapCache<K, V> map = redisson.getLocalCachedMapCache("test", options);7.1.3. 映射监听器(Map Listener)

Redisson 为所有实现了 RMapCache 或 RLocalCachedMapCache 接口的对象提供了监听以下事件的监听器:

事件 | 监听器 元素 添加 事件 | org.redisson.api.map.event.EntryCreatedListener

元素 过期 事件 | org.redisson.api.map.event.EntryExpiredListener

元素 删除 事件 | org.redisson.api.map.event.EntryRemovedListener

元素 更新 事件 | org.redisson.api.map.event.EntryUpdatedListener

使用范例:

RMapCache<String, Integer> map = redisson.getMapCache("myMap");

// 或

RLocalCachedMapCache<String, Integer> map = redisson.getLocalCachedMapCache("myMap", options);

int updateListener = map.addListener(new EntryUpdatedListener<Integer, Integer>() {

@Override

public void onUpdated(EntryEvent<Integer, Integer> event) {

event.getKey(); // 字段名

event.getValue() // 新值

event.getOldValue() // 旧值

// ...

}

});

int createListener = map.addListener(new EntryCreatedListener<Integer, Integer>() {

@Override

public void onCreated(EntryEvent<Integer, Integer> event) {

event.getKey(); // 字段名

event.getValue() // 值

// ...

}

});

int expireListener = map.addListener(new EntryExpiredListener<Integer, Integer>() {

@Override

public void onExpired(EntryEvent<Integer, Integer> event) {

event.getKey(); // 字段名

event.getValue() // 值

// ...

}

});

int removeListener = map.addListener(new EntryRemovedListener<Integer, Integer>() {

@Override

public void onRemoved(EntryEvent<Integer, Integer> event) {

event.getKey(); // 字段名

event.getValue() // 值

// ...

}

});

map.removeListener(updateListener);

map.removeListener(createListener);

map.removeListener(expireListener);

map.removeListener(removeListener);7.1.4. LRU 有界映射

Redisson 提供了基于 Redis 的以 LRU 为驱逐策略的分布式 LRU 有界映射对象。顾名思义,分布式 LRU 有界映射允许通过对其中元素按使用时间排序处理的方式,主动移除超过规定容量限制的元素。

RMapCache<String, String> map = redisson.getMapCache("map");

// 尝试将该映射的最大容量限制设定为10

map.trySetMaxSize(10);

// 将该映射的最大容量限制设定或更改为10

map.setMaxSize(10);

map.put("1", "2");

map.put("3", "3", 1, TimeUnit.SECONDS);7.2. 多值映射(Multimap)

基于 Redis 的 Redisson 的分布式 RMultimap Java 对象允许 Map 中的一个字段值包含多个元素。 字段总数受 Redis 限制,每个 Multimap 最多允许有 4 294 967 295 个不同字段。

7.2.1. 基于集(Set)的多值映射(Multimap)

基于 Set 的 Multimap 不允许一个字段值包含有重复的元素。

RSetMultimap<SimpleKey, SimpleValue> map = redisson.getSetMultimap("myMultimap");

map.put(new SimpleKey("0"), new SimpleValue("1"));

map.put(new SimpleKey("0"), new SimpleValue("2"));

map.put(new SimpleKey("3"), new SimpleValue("4"));

Set<SimpleValue> allValues = map.get(new SimpleKey("0"));

List<SimpleValue> newValues = Arrays.asList(new SimpleValue("7"), new SimpleValue("6"), new SimpleValue("5"));

Set<SimpleValue> oldValues = map.replaceValues(new SimpleKey("0"), newValues);

Set<SimpleValue> removedValues = map.removeAll(new SimpleKey("0"));7.2.2. 基于列表(List)的多值映射(Multimap)

基于 List 的 Multimap 在保持插入顺序的同时允许一个字段下包含重复的元素。

RListMultimap<SimpleKey, SimpleValue> map = redisson.getListMultimap("test1");

map.put(new SimpleKey("0"), new SimpleValue("1"));

map.put(new SimpleKey("0"), new SimpleValue("2"));

map.put(new SimpleKey("0"), new SimpleValue("1"));

map.put(new SimpleKey("3"), new SimpleValue("4"));

List<SimpleValue> allValues = map.get(new SimpleKey("0"));

Collection<SimpleValue> newValues = Arrays.asList(new SimpleValue("7"), new SimpleValue("6"), new SimpleValue("5"));

List<SimpleValue> oldValues = map.replaceValues(new SimpleKey("0"), newValues);

List<SimpleValue> removedValues = map.removeAll(new SimpleKey("0"));7.2.3. 多值映射(Multimap)淘汰机制(Eviction)

Multimap 对象的淘汰机制是通过不同的接口来实现的。它们是 RSetMultimapCache 接口和 RListMultimapCache 接口,分别对应的是 Set 和 List 的 Multimaps。

所有过期元素都是通过 org.redisson.EvictionScheduler 实例来实现定期清理的。为了保证资源的有效利用,每次运行最多清理 100 个过期元素。任务的启动时间将根据上次实际清理数量自动调整,间隔时间趋于 1 秒到 2 小时之间。比如该次清理时删除了 100 条元素,那么下次执行清理的时间将在 1 秒以后(最小间隔时间)。一旦该次清理数量少于上次清理数量,时间间隔将增加 1.5 倍。

RSetMultimapCache 的使用范例:

RSetMultimapCache<String, String> multimap = redisson.getSetMultimapCache("myMultimap");

multimap.put("1", "a");

multimap.put("1", "b");

multimap.put("1", "c");

multimap.put("2", "e");

multimap.put("2", "f");

multimap.expireKey("2", 10, TimeUnit.MINUTES);7.3. 集(Set)

基于 Redis 的 Redisson 的分布式 Set 结构的 RSet Java 对象实现了 java.util.Set 接口。通过元素的相互状态比较保证了每个元素的唯一性。该对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

RSet<SomeObject> set = redisson.getSet("anySet");

set.add(new SomeObject());

set.remove(new SomeObject());Redisson PRO 版本中的 Set 对象还可以在 Redis 集群环境下支持单集合数据分片。

7.3.1. 集(Set)淘汰机制(Eviction)

基于 Redis 的 Redisson 的分布式 RSetCache Java 对象在基于 RSet 的前提下实现了针对单个元素的淘汰机制。由于 RSetCache 是基于 RSet 实现的,使它还集成了 java.util.Set 接口。

目前的 Redis 自身并不支持 Set 当中的元素淘汰,因此所有过期元素都是通过 org.redisson.EvictionScheduler 实例来实现定期清理的。为了保证资源的有效利用,每次运行最多清理 100 个过期元素。任务的启动时间将根据上次实际清理数量自动调整,间隔时间趋于 1 秒到 2 小时之间。比如该次清理时删除了 100 条元素,那么下次执行清理的时间将在 1 秒以后(最小间隔时间)。一旦该次清理数量少于上次清理数量,时间间隔将增加 1.5 倍。

RSetCache<SomeObject> set = redisson.getSetCache("anySet");

// ttl = 10 seconds

set.add(new SomeObject(), 10, TimeUnit.SECONDS);7.3.2. 集(Set)数据分片(Sharding)

Set 数据分片是 Redis 集群模式下的一个功能。Redisson 提供的分布式 RClusteredSet Java 对象也是基于 RSet 实现的。在这里可以获取更多的信息。

RClusteredSet<SomeObject> set = redisson.getClusteredSet("anySet");

set.add(new SomeObject());

set.remove(new SomeObject());除了 RClusteredSet 以外,Redisson 还提供了另一种集群模式下的分布式集(Set),它不仅提供了透明的数据分片功能,还为每个元素提供了淘汰机制。RClusteredSetCache 类分别同时提供了 RClusteredSet 和 RSetCache 这两个接口的实现。当然这些都是基于 java.util.Set 的接口实现上的。

该功能仅限于 Redisson PRO 版本。

7.4. 有序集(SortedSet)

基于 Redis 的 Redisson 的分布式 RSortedSet Java 对象实现了 java.util.SortedSet 接口。在保证元素唯一性的前提下,通过比较器(Comparator)接口实现了对元素的排序。

RSortedSet<Integer> set = redisson.getSortedSet("anySet");

set.trySetComparator(new MyComparator()); // 配置元素比较器

set.add(3);

set.add(1);

set.add(2);

set.removeAsync(0);

set.addAsync(5);7.5. 计分排序集(ScoredSortedSet)

基于 Redis 的 Redisson 的分布式 RScoredSortedSet Java 对象是一个可以按插入时指定的元素评分排序的集合。它同时还保证了元素的唯一性。

RScoredSortedSet<SomeObject> set = redisson.getScoredSortedSet("simple");

set.add(0.13, new SomeObject(a, b));

set.addAsync(0.251, new SomeObject(c, d));

set.add(0.302, new SomeObject(g, d));

set.pollFirst();

set.pollLast();

int index = set.rank(new SomeObject(g, d)); // 获取元素在集合中的位置

Double score = set.getScore(new SomeObject(g, d)); // 获取元素的评分7.6. 字典排序集(LexSortedSet)

基于 Redis 的 Redisson 的分布式 RLexSortedSet Java 对象在实现了 java.util.Set 接口的同时,将其中的所有字符串元素按照字典顺序排列。它公式还保证了字符串元素的唯一性。

RLexSortedSet set = redisson.getLexSortedSet("simple");

set.add("d");

set.addAsync("e");

set.add("f");

set.lexRangeTail("d", false);

set.lexCountHead("e");

set.lexRange("d", true, "z", false);7.7. 列表(List)

基于 Redis 的 Redisson 分布式列表(List)结构的 RList Java 对象在实现了 java.util.List 接口的同时,确保了元素插入时的顺序。该对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

RList<SomeObject> list = redisson.getList("anyList");

list.add(new SomeObject());

list.get(0);

list.remove(new SomeObject());7.8. 队列(Queue)

基于 Redis 的 Redisson 分布式无界队列(Queue)结构的 RQueue Java 对象实现了 java.util.Queue 接口。尽管 RQueue 对象无初始大小(边界)限制,但对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

RQueue<SomeObject> queue = redisson.getQueue("anyQueue");

queue.add(new SomeObject());

SomeObject obj = queue.peek();

SomeObject someObj = queue.poll();7.9. 双端队列(Deque)

基于 Redis 的 Redisson 分布式无界双端队列(Deque)结构的 RDeque Java 对象实现了 java.util.Deque 接口。尽管 RDeque 对象无初始大小(边界)限制,但对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

RDeque<SomeObject> queue = redisson.getDeque("anyDeque");

queue.addFirst(new SomeObject());

queue.addLast(new SomeObject());

SomeObject obj = queue.removeFirst();

SomeObject someObj = queue.removeLast();7.10. 阻塞队列(Blocking Queue)

基于 Redis 的 Redisson 分布式无界阻塞队列(Blocking Queue)结构的 RBlockingQueue Java 对象实现了 java.util.concurrent.BlockingQueue 接口。尽管 RBlockingQueue 对象无初始大小(边界)限制,但对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

RBlockingQueue<SomeObject> queue = redisson.getBlockingQueue("anyQueue");

queue.offer(new SomeObject());

SomeObject obj = queue.peek();

SomeObject someObj = queue.poll();

SomeObject ob = queue.poll(10, TimeUnit.MINUTES);poll, pollFromAny, pollLastAndOfferFirstTo 和 take 方法内部采用话题订阅发布实现,在 Redis 节点故障转移(主从切换)或断线重连以后,内置的相关话题监听器将自动完成话题的重新订阅。

7.11. 有界阻塞队列(Bounded Blocking Queue)

基于 Redis 的 Redisson 分布式有界阻塞队列(Bounded Blocking Queue)结构的 RBoundedBlockingQueue Java 对象实现了 java.util.concurrent.BlockingQueue 接口。该对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。队列的初始容量(边界)必须在使用前设定好。

RBoundedBlockingQueue<SomeObject> queue = redisson.getBoundedBlockingQueue("anyQueue");

// 如果初始容量(边界)设定成功则返回`真(true)`,

// 如果初始容量(边界)已近存在则返回`假(false)`。

queue.trySetCapacity(2);

queue.offer(new SomeObject(1));

queue.offer(new SomeObject(2));

// 此时容量已满,下面代码将会被阻塞,直到有空闲为止。

queue.put(new SomeObject());

SomeObject obj = queue.peek();

SomeObject someObj = queue.poll();

SomeObject ob = queue.poll(10, TimeUnit.MINUTES);poll, pollFromAny, pollLastAndOfferFirstTo 和 take 方法内部采用话题订阅发布实现,在 Redis 节点故障转移(主从切换)或断线重连以后,内置的相关话题监听器将自动完成话题的重新订阅。

7.12. 阻塞双端队列(Blocking Deque)

基于 Redis 的 Redisson 分布式无界阻塞双端队列(Blocking Deque)结构的 RBlockingDeque Java 对象实现了 java.util.concurrent.BlockingDeque 接口。尽管 RBlockingDeque 对象无初始大小(边界)限制,但对象的最大容量受 Redis 限制,最大元素数量是 4 294 967 295 个。

RBlockingDeque<Integer> deque = redisson.getBlockingDeque("anyDeque");

deque.putFirst(1);

deque.putLast(2);

Integer firstValue = queue.takeFirst();

Integer lastValue = queue.takeLast();

Integer firstValue = queue.pollFirst(10, TimeUnit.MINUTES);

Integer lastValue = queue.pollLast(3, TimeUnit.MINUTES);poll, pollFromAny, pollLastAndOfferFirstTo 和 take 方法内部采用话题订阅发布实现,在 Redis 节点故障转移(主从切换)或断线重连以后,内置的相关话题监听器将自动完成话题的重新订阅。

7.13. 阻塞公平队列(Blocking Fair Queue)

基于 Redis 的 Redisson 分布式无界阻塞公平队列(Blocking Fair Queue)结构的 RBlockingFairQueue Java 对象在实现 Redisson 分布式无界阻塞队列(Blocking Queue)结构 RBlockingQueue 接口的基础上,解决了多个队列消息的处理者在复杂的网络环境下,网络延时的影响使 “较远” 的客户端最终收到消息数量低于 “较近” 的客户端的问题。从而解决了这种现象引发的个别处理节点过载的情况。

以分布式无界阻塞队列为基础,采用公平获取消息的机制,不仅保证了 poll、pollFromAny、pollLastAndOfferFirstTo 和 take 方法获取消息的先入顺序,还能让队列里的消息被均匀的发布到处在复杂分布式环境中的各个处理节点里。

RBlockingFairQueue queue = redisson.getBlockingFairQueue("myQueue");

queue.offer(new SomeObject());

SomeObject obj = queue.peek();

SomeObject someObj = queue.poll();

SomeObject ob = queue.poll(10, TimeUnit.MINUTES);该功能仅限于 Redisson PRO 版本。

7.14. 阻塞公平双端队列(Blocking Fair Deque)

基于 Redis 的 Redisson 分布式无界阻塞公平双端队列(Blocking Fair Deque)结构的 RBlockingFairDeque Java 对象在实现 Redisson 分布式无界阻塞双端队列(Blocking Deque)结构 RBlockingDeque 接口的基础上,解决了多个队列消息的处理者在复杂的网络环境下,网络延时的影响使 “较远” 的客户端最终收到消息数量低于 “较近” 的客户端的问题。从而解决了这种现象引发的个别处理节点过载的情况。

以分布式无界阻塞双端队列为基础,采用公平获取消息的机制,不仅保证了 poll、take、pollFirst、takeFirst、pollLast 和 takeLast 方法获取消息的先入顺序,还能让队列里的消息被均匀的发布到处在复杂分布式环境中的各个处理节点里。

RBlockingFairDeque deque = redisson.getBlockingFairDeque("myDeque");

deque.offer(new SomeObject());

SomeObject firstElement = queue.peekFirst();

SomeObject firstElement = queue.pollFirst();

SomeObject firstElement = queue.pollFirst(10, TimeUnit.MINUTES);

SomeObject firstElement = queue.takeFirst();

SomeObject lastElement = queue.peekLast();

SomeObject lastElement = queue.pollLast();

SomeObject lastElement = queue.pollLast(10, TimeUnit.MINUTES);

SomeObject lastElement = queue.takeLast();该功能仅限于 Redisson PRO 版本。

7.15. 延迟队列(Delayed Queue)

基于 Redis 的 Redisson 分布式延迟队列(Delayed Queue)结构的 RDelayedQueue Java 对象在实现了 RQueue 接口的基础上提供了向队列按要求延迟添加项目的功能。该功能可以用来实现消息传送延迟按几何增长或几何衰减的发送策略。

RQueue<String> distinationQueue = ...

RDelayedQueue<String> delayedQueue = getDelayedQueue(distinationQueue);

// 10秒钟以后将消息发送到指定队列

delayedQueue.offer("msg1", 10, TimeUnit.SECONDS);

// 一分钟以后将消息发送到指定队列

delayedQueue.offer("msg2", 1, TimeUnit.MINUTES);在该对象不再需要的情况下,应该主动销毁。仅在相关的 Redisson 对象也需要关闭的时候可以不用主动销毁。

RDelayedQueue<String> delayedQueue = ...

delayedQueue.destroy();7.16. 优先队列(Priority Queue)

基于 Redis 的 Redisson 分布式优先队列(Priority Queue)Java 对象实现了 java.util.Queue 的接口。可以通过比较器(Comparator)接口来对元素排序。

RPriorityQueue<Integer> queue = redisson.getPriorityQueue("anyQueue");

queue.trySetComparator(new MyComparator()); // 指定对象比较器

queue.add(3);

queue.add(1);

queue.add(2);

queue.removeAsync(0);

queue.addAsync(5);

queue.poll();7.17. 优先双端队列(Priority Deque)

基于 Redis 的 Redisson 分布式优先双端队列(Priority Deque)Java 对象实现了 java.util.Deque 的接口。可以通过比较器(Comparator)接口来对元素排序。

RPriorityDeque<Integer> queue = redisson.getPriorityDeque("anyQueue");

queue.trySetComparator(new MyComparator()); // 指定对象比较器

queue.addLast(3);

queue.addFirst(1);

queue.add(2);

queue.removeAsync(0);

queue.addAsync(5);

queue.pollFirst();

queue.pollLast();7.18. 优先阻塞队列(Priority Blocking Queue)

基于 Redis 的分布式无界优先阻塞队列(Priority Blocking Queue)Java 对象的结构与 java.util.concurrent.PriorityBlockingQueue 类似。可以通过比较器(Comparator)接口来对元素排序。PriorityBlockingQueue 的最大容量是 4 294 967 295 个元素。

RPriorityBlockingQueue<Integer> queue = redisson.getPriorityBlockingQueue("anyQueue");

queue.trySetComparator(new MyComparator()); // 指定对象比较器

queue.add(3);

queue.add(1);

queue.add(2);

queue.removeAsync(0);

queue.addAsync(5);

queue.take();当 Redis 服务端断线重连以后,或 Redis 服务端发生主从切换,并重新建立连接后,断线时正在使用 poll,pollLastAndOfferFirstTo 或 take 方法的对象 Redisson 将自动再次为其订阅相关的话题。

7.19. 优先阻塞双端队列(Priority Blocking Deque)

基于 Redis 的分布式无界优先阻塞双端队列(Priority Blocking Deque)Java 对象实现了 java.util.Deque 的接口。addLast、 addFirst、push 方法不能再这个对里使用。PriorityBlockingDeque 的最大容量是 4 294 967 295 个元素。

RPriorityBlockingDeque<Integer> queue = redisson.getPriorityBlockingDeque("anyQueue");

queue.trySetComparator(new MyComparator()); // 指定对象比较器

queue.add(2);

queue.removeAsync(0);

queue.addAsync(5);

queue.pollFirst();

queue.pollLast();

queue.takeFirst();

queue.takeLast();当 Redis 服务端断线重连以后,或 Redis 服务端发生主从切换,并重新建立连接后,断线时正在使用 poll,pollLastAndOfferFirstTo 或 take 方法的对象 Redisson 将自动再次为其订阅相关的话题。

八、分布式锁和同步器(重要!)

8.1. 可重入锁(Reentrant Lock)

基于 Redis 的 Redisson 分布式可重入锁 RLock Java 对象实现了 java.util.concurrent.locks.Lock 接口。同时还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RLock lock = redisson.getLock("anyLock");

// 最常见的使用方法

lock.lock();大家都知道,如果负责储存这个分布式锁的 Redisson 节点宕机以后,而且这个锁正好处于锁住的状态时,这个锁会出现锁死的状态。为了避免这种情况的发生,Redisson 内部提供了一个监控锁的看门狗,它的作用是在 Redisson 实例被关闭前,不断的延长锁的有效期。默认情况下,看门狗的检查锁的超时时间是 30 秒钟,也可以通过修改 Config.lockWatchdogTimeout 来另行指定。

另外 Redisson 还通过加锁的方法提供了 leaseTime 的参数来指定加锁的时间。超过这个时间后锁便自动解开了。

// 加锁以后10秒钟自动解锁

// 无需调用unlock方法手动解锁

lock.lock(10, TimeUnit.SECONDS);

// 尝试加锁,最多等待100秒,上锁以后10秒自动解锁

boolean res = lock.tryLock(100, 10, TimeUnit.SECONDS);

if (res) {

try {

...

} finally {

lock.unlock();

}

}Redisson 同时还为分布式锁提供了异步执行的相关方法:

RLock lock = redisson.getLock("anyLock");

lock.lockAsync();

lock.lockAsync(10, TimeUnit.SECONDS);

Future<Boolean> res = lock.tryLockAsync(100, 10, TimeUnit.SECONDS);RLock 对象完全符合 Java 的 Lock 规范。也就是说只有拥有锁的进程才能解锁,其他进程解锁则会抛出 IllegalMonitorStateException 错误。但是如果遇到需要其他进程也能解锁的情况,请使用分布式信号量 Semaphore 对象.

使用范例

@ResponseBody

@GetMapping(value = "/hello")

public String hello() {

//1、获取一把锁,只要锁的名字一样,就是同一把锁

RLock myLock = redisson.getLock("my-lock");

//2、加锁

myLock.lock(); //阻塞式等待。默认加的锁都是30s

//1)、锁的自动续期,如果业务超长,运行期间自动锁上新的30s。不用担心业务时间长,锁自动过期被删掉

//2)、加锁的业务只要运行完成,就不会给当前锁续期,即使不手动解锁,锁默认会在30s内自动过期,不会产生死锁问题

// myLock.lock(10,TimeUnit.SECONDS); //10秒钟自动解锁,自动解锁时间一定要大于业务执行时间

//问题:在锁时间到了以后,不会自动续期(不会启动看门狗机制)

//1、如果我们传递了锁的超时时间,就发送给redis执行脚本,进行占锁,默认超时就是 我们指定的时间

//2、如果我们未指定锁的超时时间,就使用 lockWatchdogTimeout = 30 * 1000 【看门狗默认时间】

//只要占锁成功,就会启动一个定时任务【重新给锁设置过期时间,新的过期时间就是看门狗的默认时间】,每隔10秒都会自动的再次续期,续成30秒

// internalLockLeaseTime 【看门狗时间】 / 3, 10s

try {

System.out.println("加锁成功,执行业务..." + Thread.currentThread().getId());

try { TimeUnit.SECONDS.sleep(20); } catch (InterruptedException e) { e.printStackTrace(); }

} catch (Exception ex) {

ex.printStackTrace();

} finally {

//3、解锁 假设解锁代码没有运行,Redisson会不会出现死锁

System.out.println("释放锁..." + Thread.currentThread().getId());

myLock.unlock();

}

return "hello";

}8.2. 公平锁(Fair Lock)

基于 Redis 的 Redisson 分布式可重入公平锁也是实现了 java.util.concurrent.locks.Lock 接口的一种 RLock 对象。同时还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。它保证了当多个 Redisson 客户端线程同时请求加锁时,优先分配给先发出请求的线程。所有请求线程会在一个队列中排队,当某个线程出现宕机时,Redisson 会等待 5 秒后继续下一个线程,也就是说如果前面有 5 个线程都处于等待状态,那么后面的线程会等待至少 25 秒。

RLock fairLock = redisson.getFairLock("anyLock");

// 最常见的使用方法

fairLock.lock();大家都知道,如果负责储存这个分布式锁的 Redis 节点宕机以后,而且这个锁正好处于锁住的状态时,这个锁会出现锁死的状态。为了避免这种情况的发生,Redisson 内部提供了一个监控锁的看门狗,它的作用是在 Redisson 实例被关闭前,不断的延长锁的有效期。默认情况下,看门狗的检查锁的超时时间是 30 秒钟,也可以通过修改 Config.lockWatchdogTimeout 来另行指定。

另外 Redisson 还通过加锁的方法提供了 leaseTime 的参数来指定加锁的时间。超过这个时间后锁便自动解开了。

// 10秒钟以后自动解锁

// 无需调用unlock方法手动解锁

fairLock.lock(10, TimeUnit.SECONDS);

// 尝试加锁,最多等待100秒,上锁以后10秒自动解锁

boolean res = fairLock.tryLock(100, 10, TimeUnit.SECONDS);

...

fairLock.unlock();Redisson 同时还为分布式可重入公平锁提供了异步执行的相关方法:

RLock fairLock = redisson.getFairLock("anyLock");

fairLock.lockAsync();

fairLock.lockAsync(10, TimeUnit.SECONDS);

Future<Boolean> res = fairLock.tryLockAsync(100, 10, TimeUnit.SECONDS);8.3. 联锁(MultiLock)

基于 Redis 的 Redisson 分布式联锁 RedissonMultiLock 对象可以将多个 RLock 对象关联为一个联锁,每个 RLock 对象实例可以来自于不同的 Redisson 实例。

RLock lock1 = redissonInstance1.getLock("lock1");

RLock lock2 = redissonInstance2.getLock("lock2");

RLock lock3 = redissonInstance3.getLock("lock3");

RedissonMultiLock lock = new RedissonMultiLock(lock1, lock2, lock3);

// 同时加锁:lock1 lock2 lock3

// 所有的锁都上锁成功才算成功。

lock.lock();

...

lock.unlock();大家都知道,如果负责储存某些分布式锁的某些 Redis 节点宕机以后,而且这些锁正好处于锁住的状态时,这些锁会出现锁死的状态。为了避免这种情况的发生,Redisson 内部提供了一个监控锁的看门狗,它的作用是在 Redisson 实例被关闭前,不断的延长锁的有效期。默认情况下,看门狗的检查锁的超时时间是 30 秒钟,也可以通过修改 Config.lockWatchdogTimeout 来另行指定。

另外 Redisson 还通过加锁的方法提供了 leaseTime 的参数来指定加锁的时间。超过这个时间后锁便自动解开了。

RedissonMultiLock lock = new RedissonMultiLock(lock1, lock2, lock3);

// 给lock1,lock2,lock3加锁,如果没有手动解开的话,10秒钟后将会自动解开

lock.lock(10, TimeUnit.SECONDS);

// 为加锁等待100秒时间,并在加锁成功10秒钟后自动解开

boolean res = lock.tryLock(100, 10, TimeUnit.SECONDS);

...

lock.unlock();8.4. 红锁(RedLock)

基于 Redis 的 Redisson 红锁 RedissonRedLock 对象实现了 Redlock 介绍的加锁算法。该对象也可以用来将多个 RLock 对象关联为一个红锁,每个 RLock 对象实例可以来自于不同的 Redisson 实例。

RLock lock1 = redissonInstance1.getLock("lock1");

RLock lock2 = redissonInstance2.getLock("lock2");

RLock lock3 = redissonInstance3.getLock("lock3");

RedissonRedLock lock = new RedissonRedLock(lock1, lock2, lock3);

// 同时加锁:lock1 lock2 lock3

// 红锁在大部分节点上加锁成功就算成功。

lock.lock();

...

lock.unlock();大家都知道,如果负责储存某些分布式锁的某些 Redis 节点宕机以后,而且这些锁正好处于锁住的状态时,这些锁会出现锁死的状态。为了避免这种情况的发生,Redisson 内部提供了一个监控锁的看门狗,它的作用是在 Redisson 实例被关闭前,不断的延长锁的有效期。默认情况下,看门狗的检查锁的超时时间是 30 秒钟,也可以通过修改 Config.lockWatchdogTimeout 来另行指定。

另外 Redisson 还通过加锁的方法提供了 leaseTime 的参数来指定加锁的时间。超过这个时间后锁便自动解开了。

RedissonRedLock lock = new RedissonRedLock(lock1, lock2, lock3);

// 给lock1,lock2,lock3加锁,如果没有手动解开的话,10秒钟后将会自动解开

lock.lock(10, TimeUnit.SECONDS);

// 为加锁等待100秒时间,并在加锁成功10秒钟后自动解开

boolean res = lock.tryLock(100, 10, TimeUnit.SECONDS);

...

lock.unlock();8.5. 读写锁(ReadWriteLock)

基于 Redis 的 Redisson 分布式可重入读写锁 RReadWriteLock Java 对象实现了 java.util.concurrent.locks.ReadWriteLock 接口。其中读锁和写锁都继承了 RLock 接口。

分布式可重入读写锁允许同时有多个读锁和一个写锁处于加锁状态。

RReadWriteLock rwlock = redisson.getReadWriteLock("anyRWLock");

// 最常见的使用方法

rwlock.readLock().lock();

// 或

rwlock.writeLock().lock();大家都知道,如果负责储存这个分布式锁的 Redis 节点宕机以后,而且这个锁正好处于锁住的状态时,这个锁会出现锁死的状态。为了避免这种情况的发生,Redisson 内部提供了一个监控锁的看门狗,它的作用是在 Redisson 实例被关闭前,不断的延长锁的有效期。默认情况下,看门狗的检查锁的超时时间是 30 秒钟,也可以通过修改 Config.lockWatchdogTimeout 来另行指定。

另外 Redisson 还通过加锁的方法提供了 leaseTime 的参数来指定加锁的时间。超过这个时间后锁便自动解开了。

// 10秒钟以后自动解锁

// 无需调用unlock方法手动解锁

rwlock.readLock().lock(10, TimeUnit.SECONDS);

// 或

rwlock.writeLock().lock(10, TimeUnit.SECONDS);

// 尝试加锁,最多等待100秒,上锁以后10秒自动解锁

boolean res = rwlock.readLock().tryLock(100, 10, TimeUnit.SECONDS);

// 或

boolean res = rwlock.writeLock().tryLock(100, 10, TimeUnit.SECONDS);

...

lock.unlock();使用范例

/**

* 保证一定能读到最新数据,修改期间,写锁是一个排它锁(互斥锁、独享锁),读锁是一个共享锁

* 写锁没释放读锁必须等待

* 读 + 读 :相当于无锁,并发读,只会在Redis中记录好,所有当前的读锁。他们都会同时加锁成功

* 写 + 读 :必须等待写锁释放

* 写 + 写 :阻塞方式

* 读 + 写 :有读锁。写也需要等待

* 只要有读或者写的存都必须等待

* @return

*/

@GetMapping(value = "/write")

@ResponseBody

public String writeValue() {

String s = "";

RReadWriteLock readWriteLock = redisson.getReadWriteLock("rw-lock");

RLock rLock = readWriteLock.writeLock();

try {

//1、改数据加写锁,读数据加读锁

rLock.lock();

s = UUID.randomUUID().toString();

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

ops.set("writeValue",s);

TimeUnit.SECONDS.sleep(10);

} catch (InterruptedException e) {

e.printStackTrace();

} finally {

rLock.unlock();

}

return s;

}

@GetMapping(value = "/read")

@ResponseBody

public String readValue() {

String s = "";

RReadWriteLock readWriteLock = redisson.getReadWriteLock("rw-lock");

//加读锁

RLock rLock = readWriteLock.readLock();

try {

rLock.lock();

ValueOperations<String, String> ops = stringRedisTemplate.opsForValue();

s = ops.get("writeValue");

try { TimeUnit.SECONDS.sleep(10); } catch (InterruptedException e) { e.printStackTrace(); }

} catch (Exception e) {

e.printStackTrace();

} finally {

rLock.unlock();

}

return s;

}8.6. 信号量(Semaphore)

基于 Redis 的 Redisson 的分布式信号量(Semaphore)Java 对象 RSemaphore 采用了与 java.util.concurrent.Semaphore 相似的接口和用法。同时还提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RSemaphore semaphore = redisson.getSemaphore("semaphore");

semaphore.acquire();

//或

semaphore.acquireAsync();

semaphore.acquire(23);

semaphore.tryAcquire();

//或

semaphore.tryAcquireAsync();

semaphore.tryAcquire(23, TimeUnit.SECONDS);

//或

semaphore.tryAcquireAsync(23, TimeUnit.SECONDS);

semaphore.release(10);

semaphore.release();

//或

semaphore.releaseAsync();使用范例

/**

* 车库停车

* 3车位

* 信号量也可以做分布式限流

*/

@GetMapping(value = "/park")

@ResponseBody

public String park() throws InterruptedException {

RSemaphore park = redisson.getSemaphore("park");

park.acquire(); //获取一个信号、获取一个值,占一个车位

boolean flag = park.tryAcquire();

if (flag) {

//执行业务

} else {

return "error";

}

return "ok=>" + flag;

}

@GetMapping(value = "/go")

@ResponseBody

public String go() {

RSemaphore park = redisson.getSemaphore("park");

park.release(); //释放一个车位

return "ok";

}8.7. 可过期性信号量(PermitExpirableSemaphore)

基于 Redis 的 Redisson 可过期性信号量(PermitExpirableSemaphore)是在 RSemaphore 对象的基础上,为每个信号增加了一个过期时间。每个信号可以通过独立的 ID 来辨识,释放时只能通过提交这个 ID 才能释放。它提供了异步(Async)、反射式(Reactive)和 RxJava2 标准的接口。

RPermitExpirableSemaphore semaphore = redisson.getPermitExpirableSemaphore("mySemaphore");

String permitId = semaphore.acquire();

// 获取一个信号,有效期只有2秒钟。

String permitId = semaphore.acquire(2, TimeUnit.SECONDS);

// ...

semaphore.release(permitId);8.8. 闭锁(CountDownLatch)

基于 Redisson 的 Redisson 分布式闭锁(CountDownLatch)Java 对象 RCountDownLatch 采用了与 java.util.concurrent.CountDownLatch 相似的接口和用法。

RCountDownLatch latch = redisson.getCountDownLatch("anyCountDownLatch");

latch.trySetCount(1);

latch.await();

// 在其他线程或其他JVM里

RCountDownLatch latch = redisson.getCountDownLatch("anyCountDownLatch");

latch.countDown();使用范例

/**

* 放假、锁门

* 1班没人了

* 5个班,全部走完,我们才可以锁大门

* 分布式闭锁

*/

@GetMapping(value = "/lockDoor")

@ResponseBody

public String lockDoor() throws InterruptedException {

RCountDownLatch door = redisson.getCountDownLatch("door");

door.trySetCount(5);

door.await(); //等待闭锁完成

return "放假了...";

}

@GetMapping(value = "/gogogo/{id}")

@ResponseBody

public String gogogo(@PathVariable("id") Long id) {

RCountDownLatch door = redisson.getCountDownLatch("door");

door.countDown(); //计数-1

return id + "班的人都走了...";

}九、分布式服务

9.1. 分布式远程服务(Remote Service)

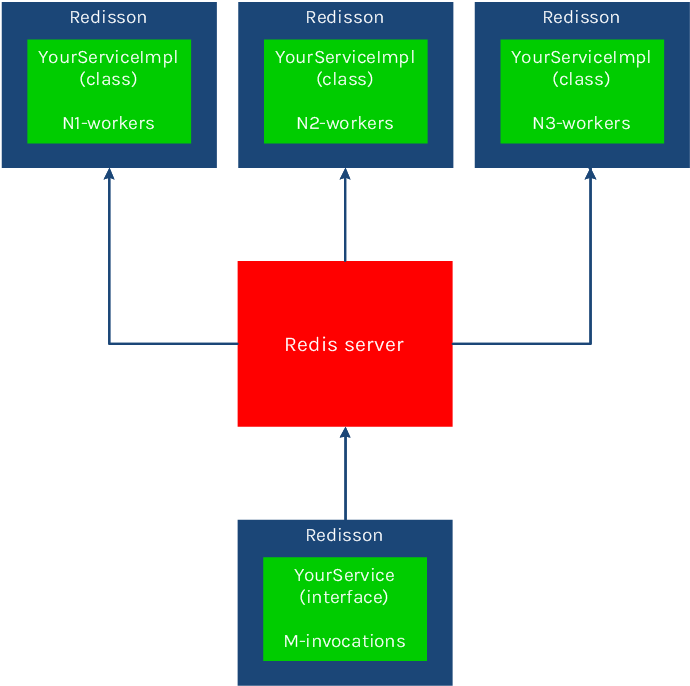

基于 Redis 的 Java 分布式远程服务,可以用来通过共享接口执行存在于另一个 Redisson 实例里的对象方法。换句话说就是通过 Redis 实现了 Java 的远程过程调用(RPC)。分布式远程服务基于可以用 POJO 对象,方法的参数和返回类不受限制,可以是任何类型。

分布式远程服务(Remote Service)提供了两种类型的 RRemoteService 实例:

(1)服务端(远端)实例 - 用来执行远程方法(工作者实例即 worker instance). 例如:

RRemoteService remoteService = redisson.getRemoteService();

SomeServiceImpl someServiceImpl = new SomeServiceImpl();

// 在调用远程方法以前,应该首先注册远程服务

// 只注册了一个服务端工作者实例,只能同时执行一个并发调用

remoteService.register(SomeServiceInterface.class, someServiceImpl);

// 注册了12个服务端工作者实例,可以同时执行12个并发调用

remoteService.register(SomeServiceInterface.class, someServiceImpl, 12);(2)客户端(本地)实例 - 用来请求远程方法。例如:

RRemoteService remoteService = redisson.getRemoteService();

SomeServiceInterface service = remoteService.get(SomeServiceInterface.class);

String result = service.doSomeStuff(1L, "secondParam", new AnyParam());客户端和服务端必须使用一样的共享接口,生成两者的 Redisson 实例必须采用相同的连接配置。客户端和服务端实例可以运行在同一个 JVM 里,也可以是不同的。客户端和服务端的数量不收限制。(注意:尽管 Redisson 不做任何限制,但是 Redis 的限制仍然有效。)

在服务端工作者可用实例数量 大于 1 的时候,将并行执行并发调用的远程方法。

并行执行工作者数量计算方法如下: T = R * N

T - 并行执行工作者总数

R - Redisson 服务端数量

N - 注册服务端时指定的执行工作者数量

超过该数量的并发请求将在列队中等候执行。

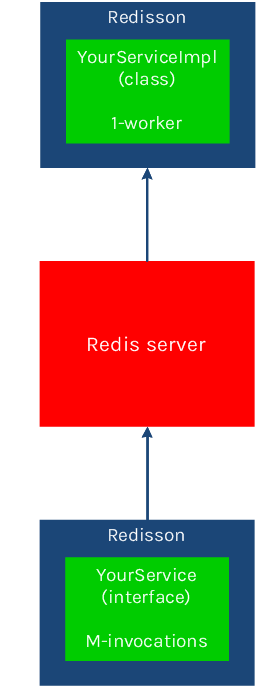

在服务端工作者实例可用数量为 1 时,远程过程调用将会按 顺序执行。这种情况下,每次只有一个请求将会被执行,其他请求将在列队中等候执行。

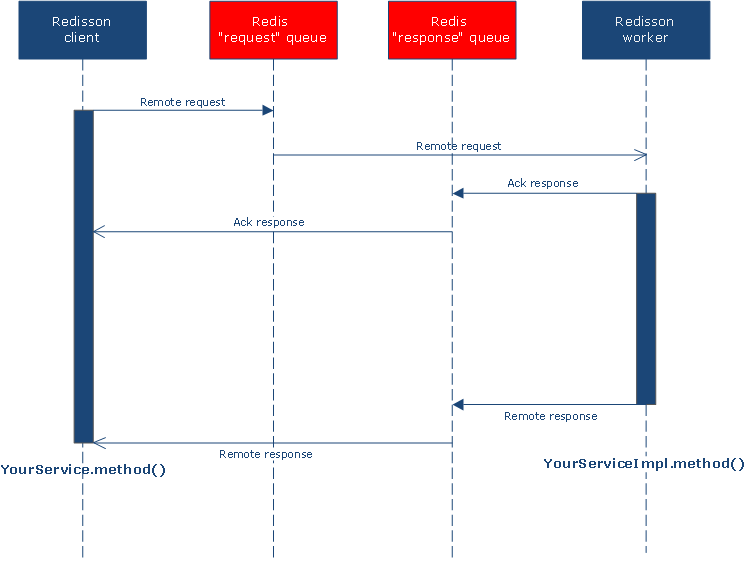

9.1.1. 分布式远程服务工作流程

分布式远程服务为每个注册接口建立了两个列队。一个列队用于请求,由服务端监听,另一个列队用于应答回执和结果回复,由客户端监听。应答回执用于判定该请求是否已经被接受。如果在指定的超时时间内没有被执行工作者执行将会抛出 RemoteServiceAckTimeoutException 错误。

下图描述了每次发起远程过程调用请求的工作流程。

9.1.2. 发送即不管(Fire-and-Forget)模式和应答回执(Ack-Response)模式

分布式远程服务通过 org.redisson.core.RemoteInvocationOptions 类,为每个远程过程调用提供了一些可配置选项。这些选项可以用来指定和修改请求超时和选择跳过应答回执或结果的发送模式。例如:

// 应答回执超时1秒钟,远程执行超时30秒钟

RemoteInvocationOptions options = RemoteInvocationOptions.defaults();

// 无需应答回执,远程执行超时30秒钟

RemoteInvocationOptions options = RemoteInvocationOptions.defaults().noAck();

// 应答回执超时1秒钟,不等待执行结果

RemoteInvocationOptions options = RemoteInvocationOptions.defaults().noResult();

// 应答回执超时1分钟,不等待执行结果

RemoteInvocationOptions options = RemoteInvocationOptions.defaults().expectAckWithin(1, TimeUnit.MINUTES).noResult();

// 发送即不管(Fire-and-Forget)模式,无需应答回执,不等待结果

RemoteInvocationOptions options = RemoteInvocationOptions.defaults().noAck().noResult();

RRemoteService remoteService = redisson.getRemoteService();

YourService service = remoteService.get(YourService.class, options);9.1.3. 异步调用

远程过程调用也可以采用异步的方式执行。异步调用需要单独提交一个带有 @RRemoteAsync 注解(annotation)的异步接口类。异步接口方法签名必须与远程接口的方法签名相符。异步接口的返回类必须是 org.redisson.api.RFuture 对象或其子对象。在调用 RRemoteService.get 方法时将对异步接口的方法进行验证。异步接口无须包含所有的远程接口里的方法,只需要包含要求异步执行的方法即可。

// 远程接口

public interface RemoteInterface {

Long someMethod1(Long param1, String param2);

void someMethod2(MyObject param);

MyObject someMethod3();

}

// 匹配远程接口的异步接口

@RRemoteAsync(RemoteInterface.class)

public interface RemoteInterfaceAsync {

RFuture<Long> someMethod1(Long param1, String param2);

RFuture<Void> someMethod2(MyObject param);

}

RRemoteService remoteService = redisson.getRemoteService();

RemoteInterfaceAsync asyncService = remoteService.get(RemoteInterfaceAsync.class);9.1.4. 取消异步调用

通过调用 Future.cancel () 方法可以非常方便的取消一个异步调用。分布式远程服务允许在三个阶段中任何一个阶段取消异步调用:

- 远程调用请求在列队中排队阶段

- 远程调用请求已经被分布式远程服务接受,还未发送应答回执,执行尚未开始。

- 远程调用请求已经在执行阶段

想要正确的处理第三个阶段,在服务端代码里应该检查 Thread.currentThread ().isInterrupted () 的返回状态。范例如下:

// 远程接口

public interface MyRemoteInterface {

Long myBusyMethod(Long param1, String param2);

}

// 匹配远程接口的异步接口

@RRemoteAsync(MyRemoteInterface.class)

public interface MyRemoteInterfaceAsync {

RFuture<Long> myBusyMethod(Long param1, String param2);

}

// 远程接口的实现

public class MyRemoteServiceImpl implements MyRemoteInterface {

public Long myBusyMethod(Long param1, String param2) {

for (long i = 0; i < Long.MAX_VALUE; i++) {

iterations.incrementAndGet();

if (Thread.currentThread().isInterrupted()) {