约克大学提出混合深度增强全景视觉SLAM,使用全景相机和倾斜多线LiDAR

2023-03-01 10:04 计算机视觉life 阅读(54) 评论(0) 编辑 收藏 举报以下内容来自小六的机器人SLAM学习圈知识星球每日更新内容

点击领取学习资料 → 机器人SLAM学习资料大礼包

论文# HDPV-SLAM: Hybrid Depth-augmented Panoramic Visual SLAM for Mobile Mapping System with Tilted LiDAR and Panoramic Visual Camera

论文地址:https://arxiv.org/abs/2301.11823

作者单位:约克大学

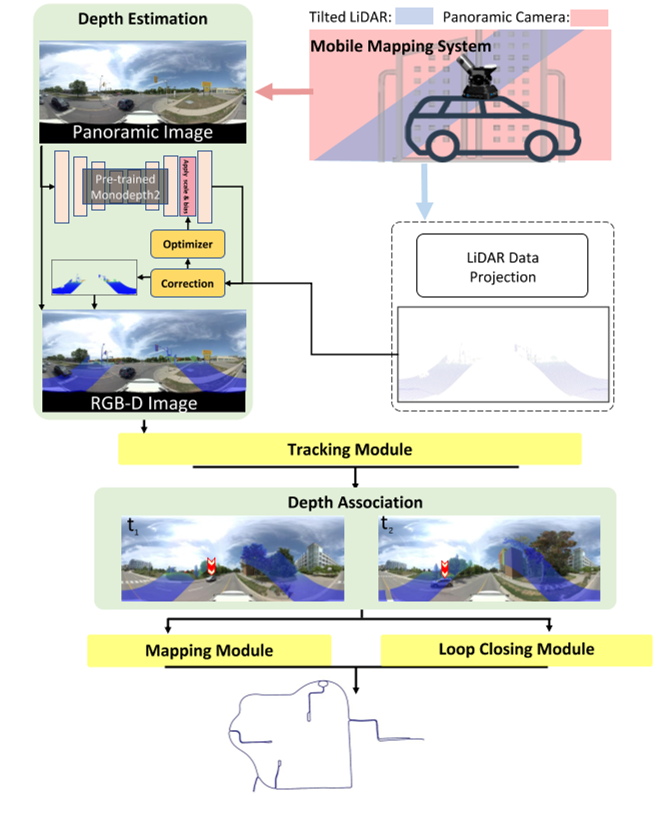

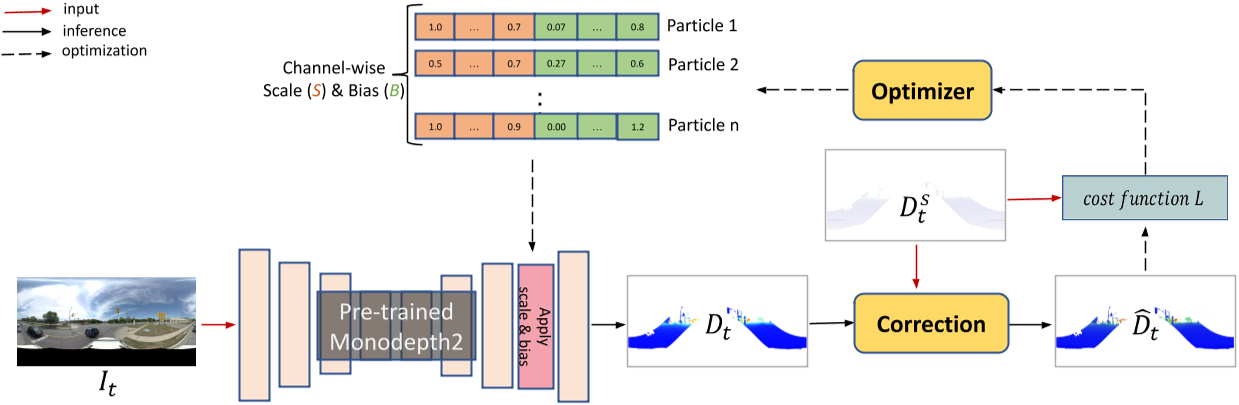

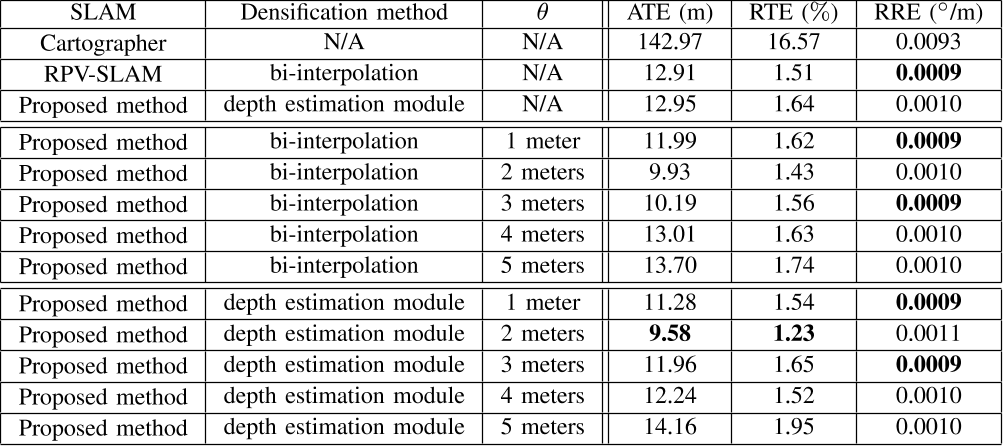

本文提出了一种新的视觉SLAM,称为混合深度增强全景视觉SLAM(HDPV-SLAM),它使用全景相机和倾斜的多线LiDAR生成精确的、度量尺度的车辆轨迹。RGB-D SLAM作为HDPVSLAM的设计基础,为视觉特征添加了深度信息。它克服了限制RGB-D SLAM系统性能的两个问题。第一个是LiDAR深度的稀疏性,这使得将其与从RGB图像中提取的视觉特征联系起来具有挑战性。针对这一问题,我们提出了一种基于深度学习的稀疏激光雷达深度迭代增密的深度估计模型。第二个问题涉及全景相机和倾斜的激光雷达传感器之间的水平重叠覆盖严重不足在深度关联方面造成的挑战。

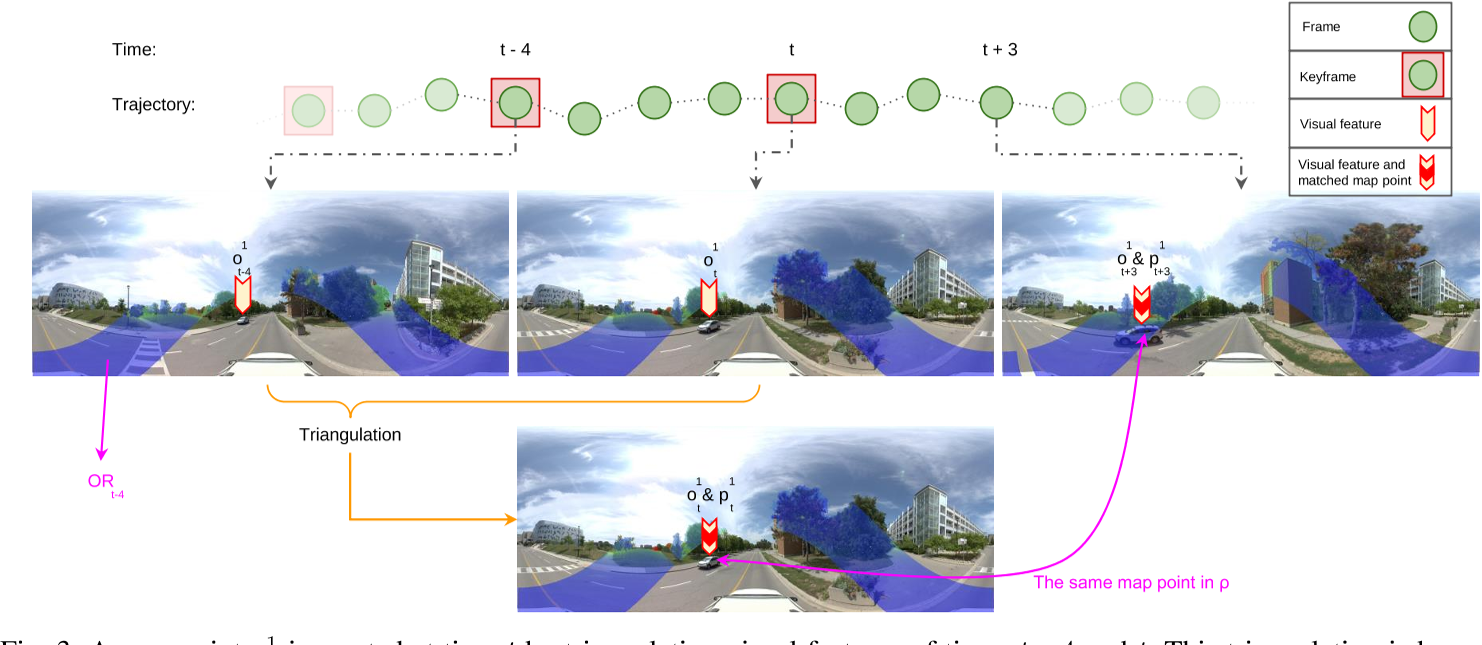

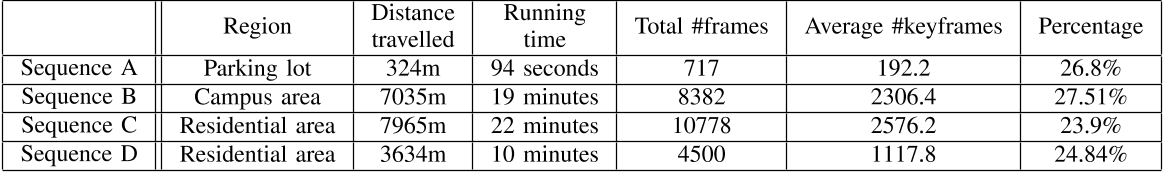

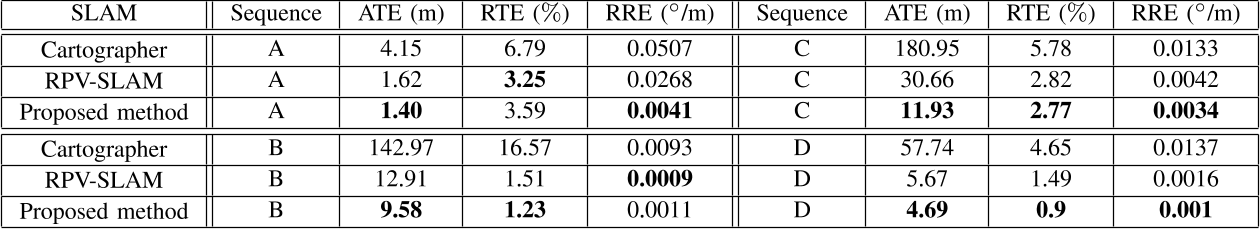

为了克服这一困难,我们提出了一种混合深度关联模块,该模块优化地结合了特征三角剖分和深度估计这两个独立过程估计的深度信息。该混合深度关联模块旨在最大限度地利用在特征跟踪阶段中跟踪视觉特征的三角化深度和基于DL的校正深度之间的更准确的深度信息。我们使用18.95公里长的约克大学和Teledyne Optech(YUTO)MMS数据集评估了HDPV-SLAM的性能。实验结果表明,提出的两个模块显著提高了HDPV-SLAM的性能,其性能优于最先进的SOTA SLAM系统。

本文贡献如下:

1、为了提高视觉特征的深度增强质量,我们提出了一种新的基于深度学习的稀疏LiDAR深度估计模块。

2、我们提出了一种新的混合深度关联模块,它将由三角化视觉特征驱动的深度信息和LiDAR深度关联完美地结合在一起,以解决全景相机和倾斜LIDAR传感器之间明显缺乏空间重叠所带来的挑战。

3、通过在18.95公里长的具有挑战性的室外条件下的广泛实验,我们证明了HDPV-SLAM可以提供比最先进的SOTA(SOTA)性能更好的度量结果。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 周边上新:园子的第一款马克杯温暖上架

· 分享 3 个 .NET 开源的文件压缩处理库,助力快速实现文件压缩解压功能!

· Ollama——大语言模型本地部署的极速利器

· DeepSeek如何颠覆传统软件测试?测试工程师会被淘汰吗?

· 使用C#创建一个MCP客户端