图森提出激光雷达辅助视觉惯性定位方法,结合语义地图,遮挡和退化环境也稳!

2023-02-06 14:38 计算机视觉life 阅读(219) 评论(0) 编辑 收藏 举报以下内容来自小六的机器人SLAM学习圈知识星球每日更新内容

点击领取学习资料 → 机器人SLAM学习资料大礼包

论文# LiDAR-Aided Visual-Inertial Localization with Semantic Maps

论文地址:IROS2022

作者单位:图森未来

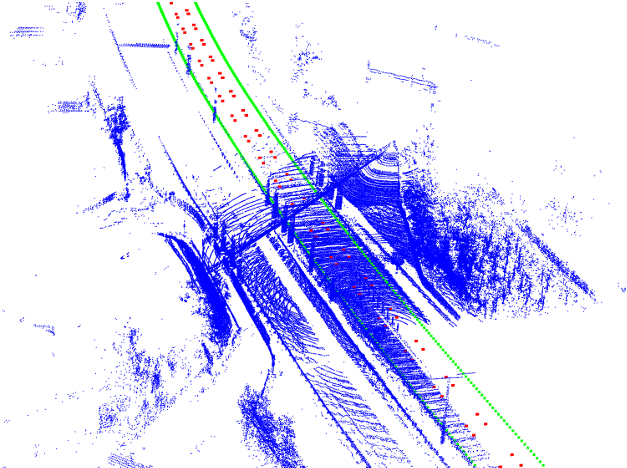

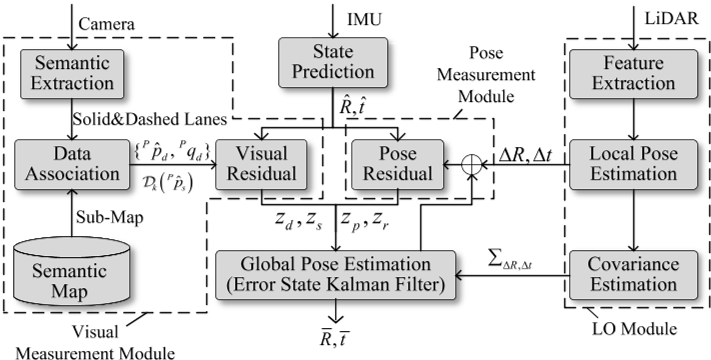

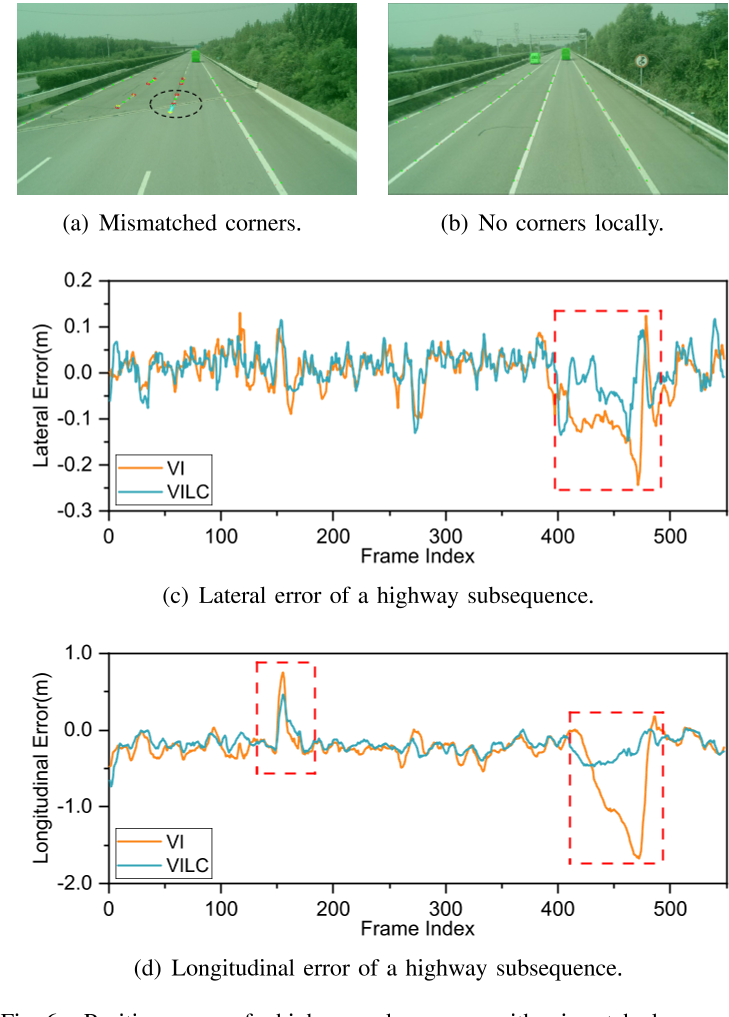

准确而鲁棒的定位是自动驾驶系统的一项基本任务。本文提出了一种新的三维激光雷达辅助的视觉惯性定位方法。我们的方法充分探索了视觉观测和激光雷达观测的互补性。一方面,图像中的语义特征与给定的语义地图之间的关联为绝对位姿提供了约束。另一方面,激光雷达里程计(LO)可以提供准确且稳健的六自由度相对位姿。利用误差状态卡尔曼滤波(ESKF)框架来估计相对于语义地图的车辆姿态,融合了图像和语义地图之间的全局约束、来自LO的相对姿态和原始IMU数据。

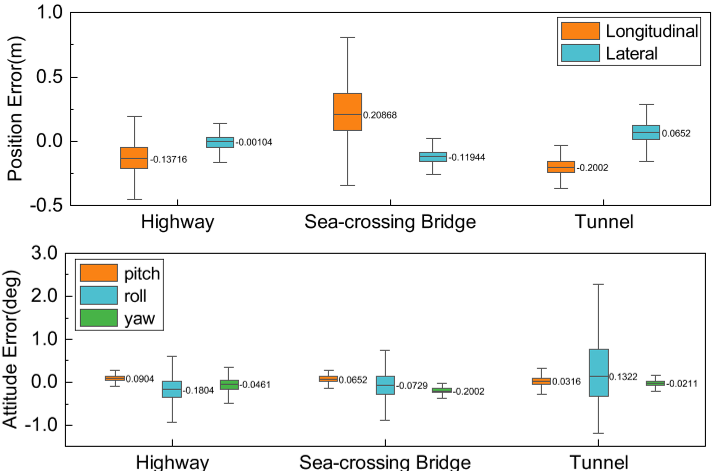

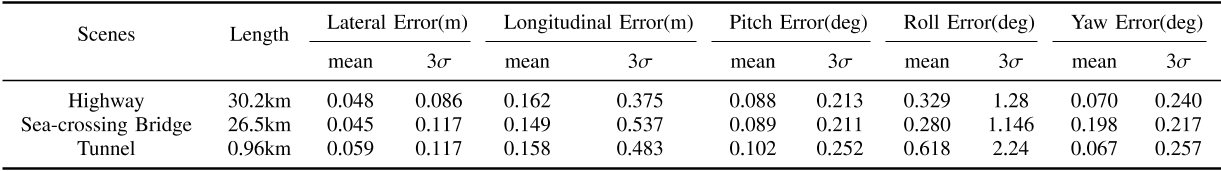

该方法在各种具有挑战性的场景中实现厘米级的定位精度。我们在50公里以上的真实场景中验证了该方法的鲁棒性和准确性。实验结果表明,该方法的平均横向精度为0.059 m,纵向精度为0.158 m,证明了该系统在自动驾驶应用中的实用性。

本工作的主要贡献如下:

(1)针对遮挡和场景退化环境,我们使用了一个紧密耦合的ESKF来融合全局语义约束和局部里程计测量。

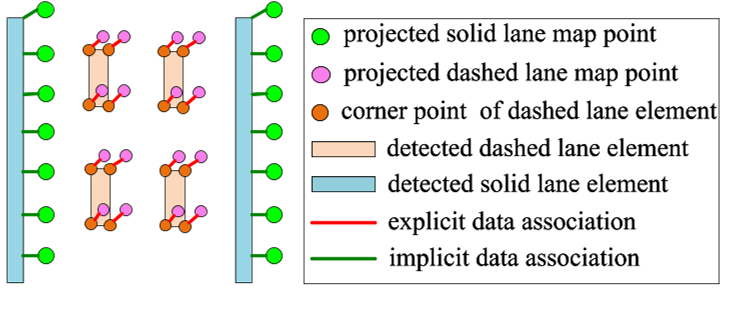

(2)我们开发了一种融合隐式里程计损失和显式重投影损失的混合视觉测量模型,以提高精度和鲁棒性。

(3)提出了一种具有封闭姿态协方差的漂移感知LO算法,应用于在线融合定位,提高了系统的鲁棒性。

(4)我们进行了各种大规模道路试验,以验证所开发方法的有效性。

以上内容来自小六的机器人SLAM学习圈 每日更新内容

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 周边上新:园子的第一款马克杯温暖上架

· 分享 3 个 .NET 开源的文件压缩处理库,助力快速实现文件压缩解压功能!

· Ollama——大语言模型本地部署的极速利器

· DeepSeek如何颠覆传统软件测试?测试工程师会被淘汰吗?

· 使用C#创建一个MCP客户端