Efficient Learned Lossless JPEG Recompression

简介

本文是GuoLina以及HeDailan商汤团队关于重压缩的第二篇论文,这次该团队将注意力放到了加速解码上。

创新点

提出Multi-Level Parallel Conditional Modeling (ML-PCM)在不同颗粒度上并行解码。

模型设置

首先还是将DCT系数进行重排

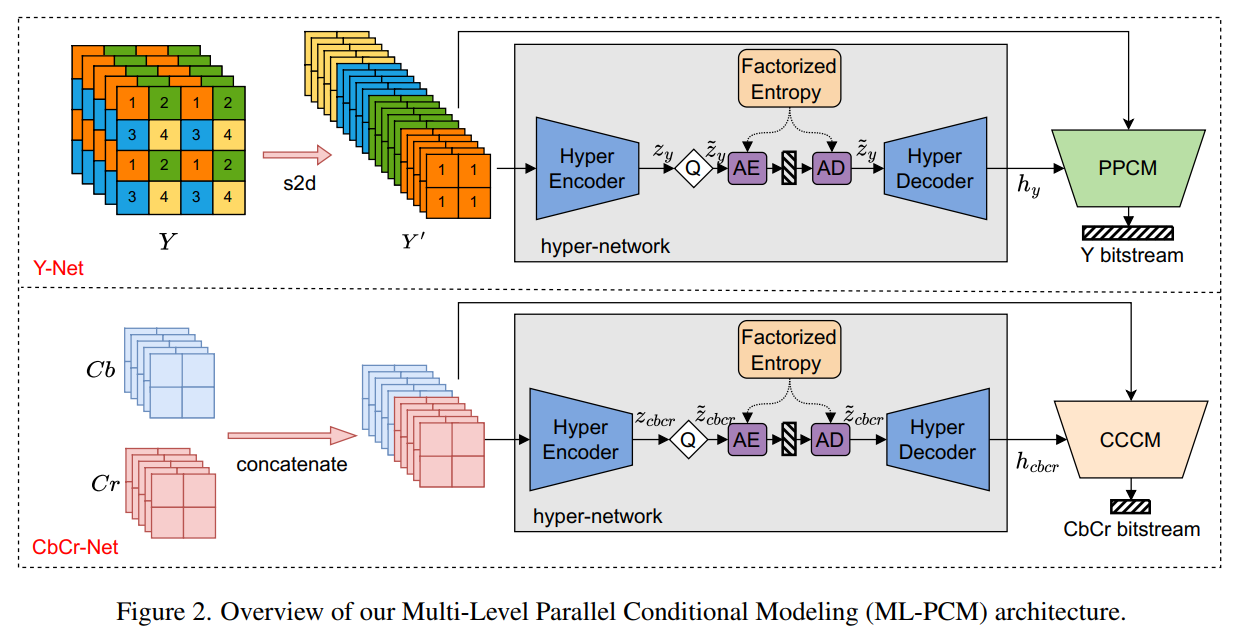

为了支持多种子采样格式,分别为色度分量和亮度分量设计了两个独立的网络,如图2所示

从图中可以看到两条网络都是由一个hyper-network和parallel context model。(超网络提供边信息来学习全局相关性;上下文模型则从已解码的相邻符号中学习局部信息)

Y分量是先进行space-to-depth,然后被压缩。

CbCr分量是先串联,然后再压缩。

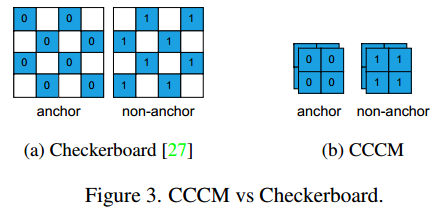

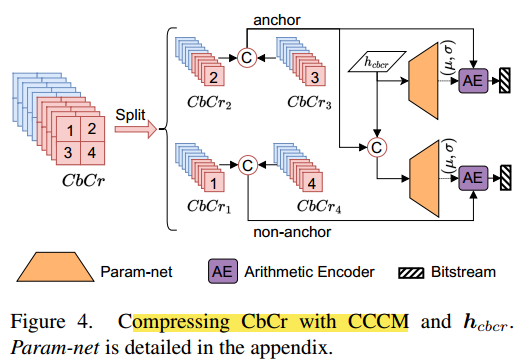

CCCM compressed checkerboard context model

CbCr的上下文模型其实还是用的棋盘上下文模型

具体的网络实现为,把CbCr2和CbCr3作为anchor

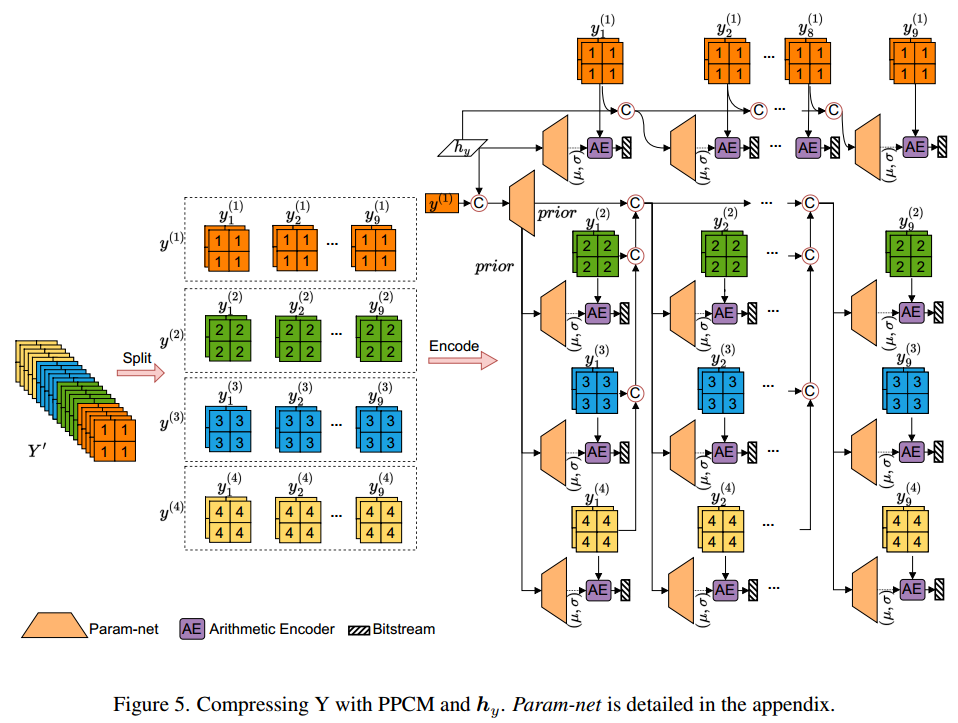

PPCM pipeline parallel context model

Y分量的上下文模型有点类似于上篇文章的MLCC模型,将输入数据分为4行9列,每一列的深度分别为28, 8, 7, 6, 5, 4, 3, 2 and 1。

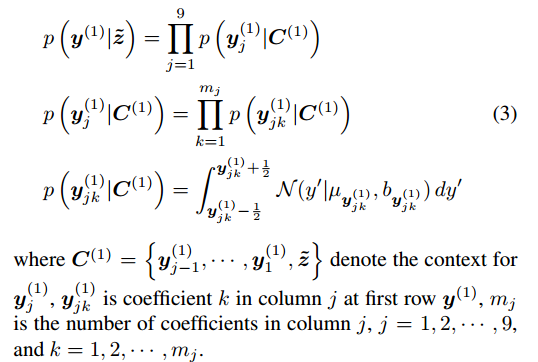

第一行的概率计算公式为

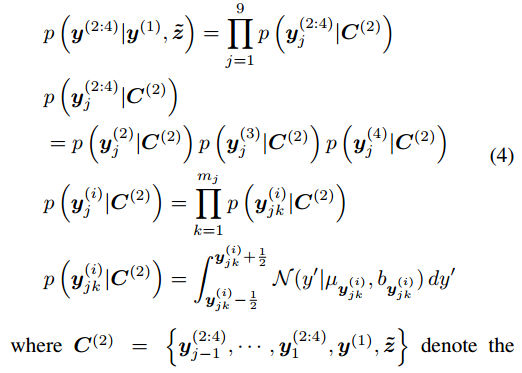

第二行到第四行都是以第一行为先验的,它们并行运行:

Shift Context

实验设置

训练数据集:the largest 8000 images chosen from the ImageNet.

测试数据集:Kodak, DIV2K, CLIC professional and CLIC mobile.

具体细节: 训练图像被随机裁剪为256*256的块,然后提取量化后的DCT系数。

然后分别优化Y-Net和CbCr-Net。其中,Y-Net的训练分为三个阶段:1:训练超网络 2:训练PPCM捕捉上下文信息 3:进行微调。

最后使用TensorRT库部署了模型,利用 8 位量化《Learned Step Size Quantization》来进一步加速推理,从而实现了与全精度模型相当的压缩性能(Y-Net 仅降低约 1%,CbCrNet 仅降低 0.7%)。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 如何调用 DeepSeek 的自然语言处理 API 接口并集成到在线客服系统

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App

2017-03-15 坏掉的项链