QARV: Quantization-Aware ResNet VAE for Lossy Image Compression

什么是Quantization-Aware量化感知?

简介

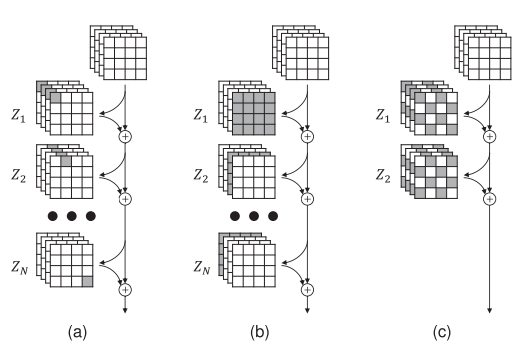

该文章基于VAE提出一种多层次的图像压缩方法

专门设计了用于快速解码(CPU)的QARV网络结构,并为可变速率压缩提出自适应归一化操作。

创新之处

- 提出了一个算法模型,实现了更快的解码速度和更好的R-D性能。

- 将计算从解码器转移到编码器,加快解码速度

- 为实现可变速率图像压缩,提出自适应归一化层AdaLN

- 总的来说,提出一种新的神经网络模型(QARV)。他的设计更简单,没有上下文模型;更灵活,速率可变,具有层次结构。 与现有模型相比,具有快速地CPU解码。

模型结构

- 熵编码是如何进行的

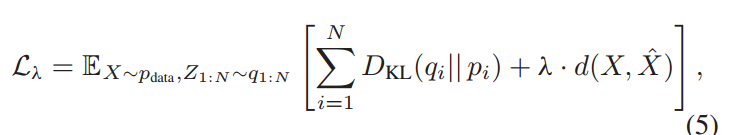

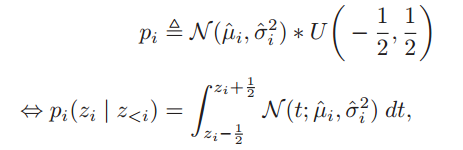

使用N个潜变量的层次结构,记为

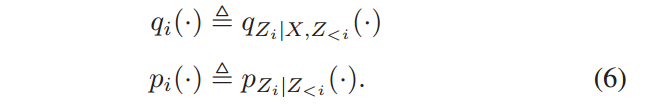

在编码时,给定X,使用一系列的后验 来推理

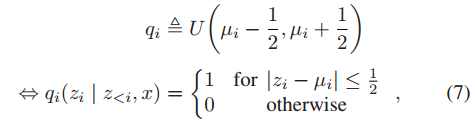

对于每个潜在变量,使用一个(条件)均匀后验来建模在测试过程中将遇到的均匀量化误差。

除了后验,模型还对每个潜在变量生成先验

最后得到N个比特流

VAE目标是找到一组参数,使得Px(px,z的边际概率)更接近数据真实分布pdata,

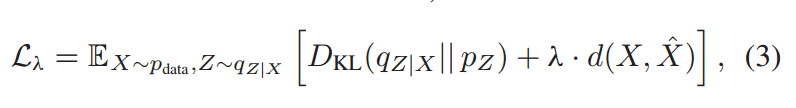

传统VAE的损失函数

本文的损失函数为

训练过程中,自上而下根据X和Zi,得到, 先验则是使用与均匀分布做卷积的条件高斯模型

然后生成均匀的后验概率分布

获得qi后,对zi进行采样(训练时加均匀噪声),接着继续向下传播

同时计算先验概率

另外,作者提出,该模型可以广泛推广到现有的图像压缩方法中,包括z型自回归,通道自回归,以及棋盘模型...

- 如何实现可变速率压缩的还没看懂

将视为模型的输入? - QARV 网络模型

实验结果

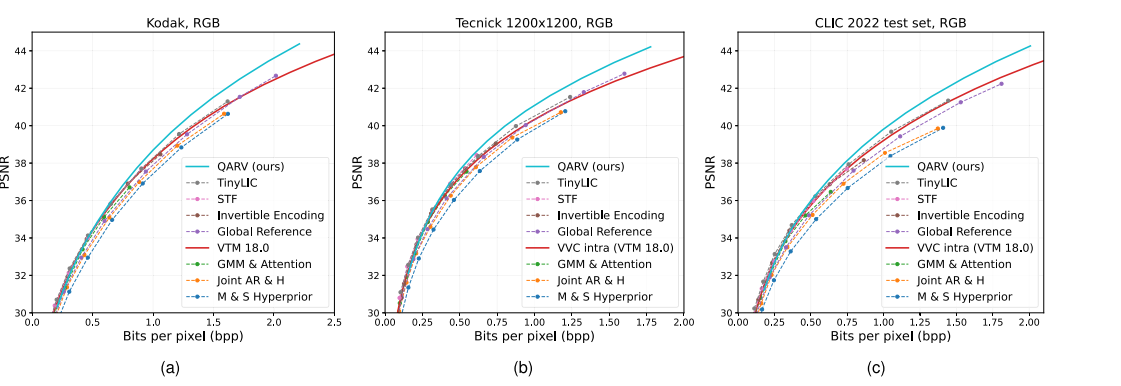

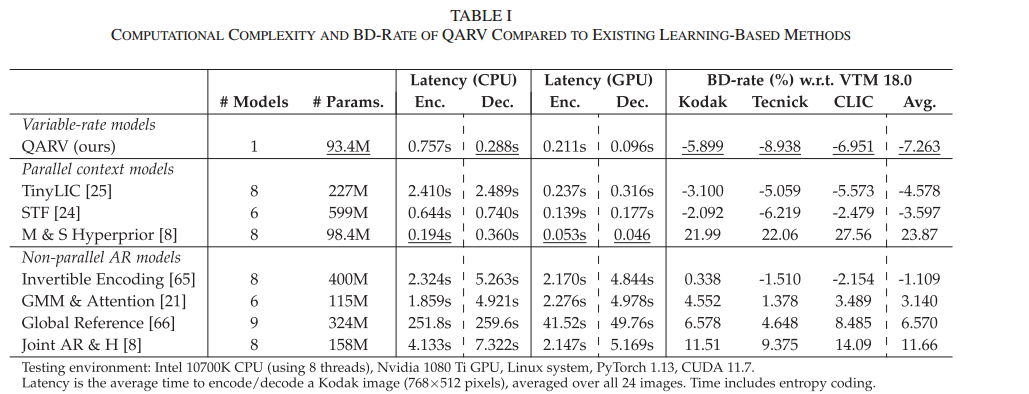

使用COCO数据集训练,Kodak、Tecnick TESTIMAGES、CLIC 2022 test set三个数据集做测试。

指标 计算每个图像的PSNR和bpp,取平均值

另外,使用 BD-rate metric来衡量rate的平均变化。

主要实验2million,消融实验500k.

三个数据集上的PSNR结果如图,

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 如何调用 DeepSeek 的自然语言处理 API 接口并集成到在线客服系统

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App