Swin Transformer 马尔奖论文(ICCV 2021最佳论文)

简介

作者之一的微软亚研院的首席研究员胡瀚老师在bibili讲过该论文

使用Transformer完全取代CNN

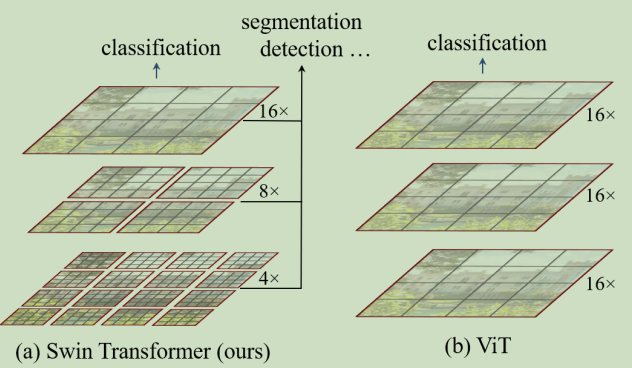

该文章提出的Swin Transformer可以被当做通用的骨干网络用于多种下游视觉任务。

文章内容:

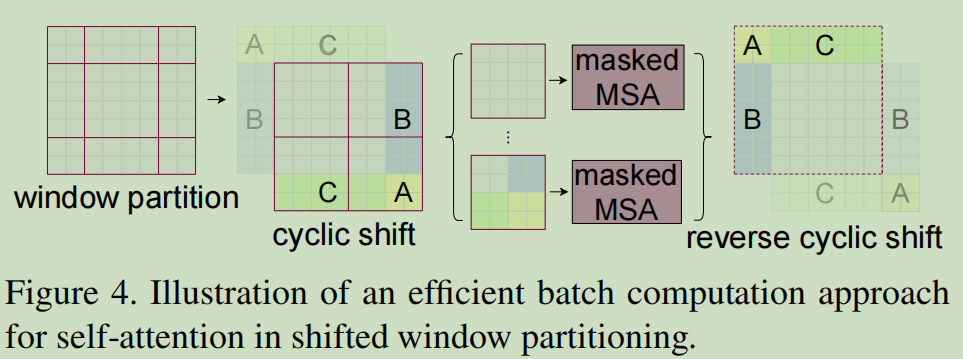

Swin 即 Shifted window:它在本地窗口进行自注意力计算并允许在两个layers之间进行跨窗口的连接

这就使得将自注意力限制在不重叠的块中。

这种分层结构可以灵活运行不同的图像尺度。并且计算复杂度与图像大小成线性关系(而非二次增长)。

先使用 个小patch为一组, 然后在前向传播过程中不断patch merging(相当于CNN的池化)

方法

局部窗口的自注意力计算:图像被非重叠的均匀分割,每次将个patch为一组,进行自注意力的计算,而非对全局图像同时计算。

但是这种局部的注意力计算,缺乏跨窗口的沟通,限制了其建模能力。为此,提出移动窗口的方法。

移动窗口操作:

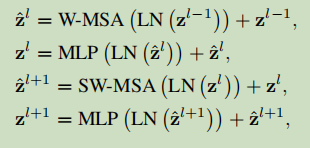

每次计算完自注意力后,将窗口循环移位,做一次注意力然后再放回。

计算过程如下

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 如何调用 DeepSeek 的自然语言处理 API 接口并集成到在线客服系统

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App