Conditional Probability Models for Deep Image Compression

简介

训练这种基于网络的压缩方法有一个关键的挑战:优化编码器中潜在表示的比特率R,为了使用数量有限的比特对图像进行编码,需要将潜在的表示离散化映射到有限值的集合。而离散化是不可微的,这就给基于梯度的优化方法带来挑战,人们提出很多方法来解决这个问题。

本文重点就是如何对熵进行建模以便在优化过程中权衡

该文章提出的模型基于上下文模型,上下文模型之前被用来证明已训练模型的编码率,直接作为优化项中的熵。同时训练自动编码器和上下文模型,其中上下文模型学习图像表征的卷积概率模型,而自动编码器则利用它进行熵估计,以实现速率-失真权衡。

模型

Quantization

量化过程是把连续的数 离散到有限数集中,减少储存压力,但是要处理好反向传播的问题。

思考:这个有限的数集如何确定?

在反向传播时,使用如下软量化

Entropy estimation

这篇文章在PixelRNN的基础上,将离散后的概率分布分解为条件概率的累乘。

然后使用神经网络作为上下文模型,来估计条件概率。过程为:

使用

作为向量中第i个位置量化为有限集C中元素l的概率。将这种近似的概率分布称为

由于这种条件分布只依赖之前的值,这就对网络P施加了因果约束。因为如果想在网络P中并行的计算,就必须保证它只依赖之前的。

为了学习P,训练P的最大似然,或者使用交叉熵损失来训练来对在C中的序号进行分类。(交叉熵损失如下)

我们学习使得可以使用交叉熵作为熵的估计。所以,在训练自编码器的时候,可以通过最小化CE间接最小化H。因此编码成本为:

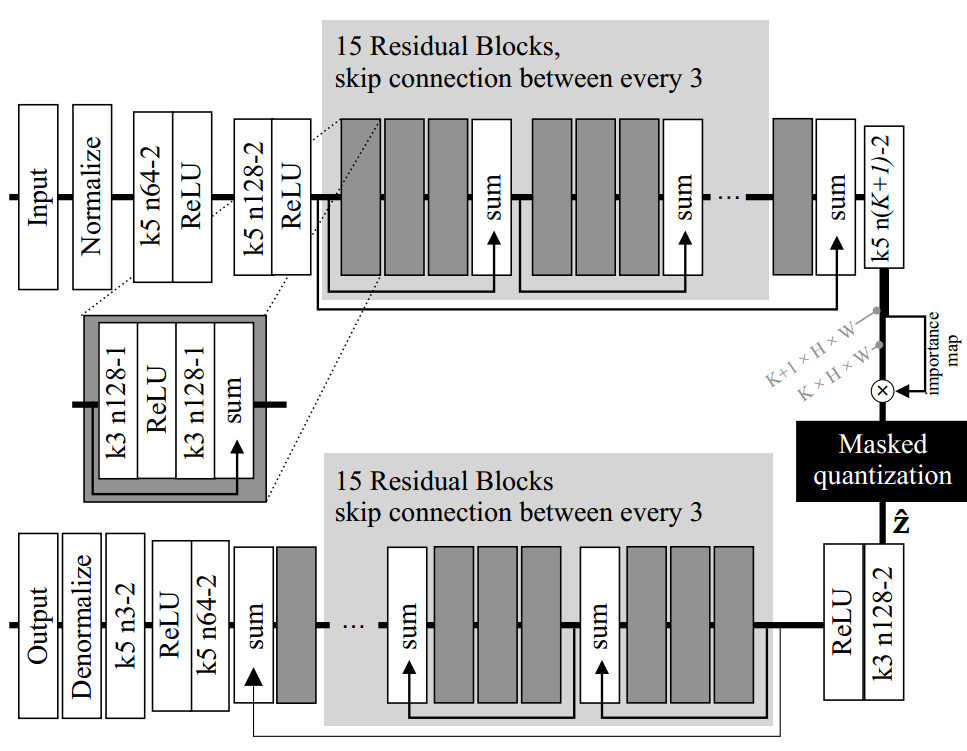

整个模型结构如图所示:

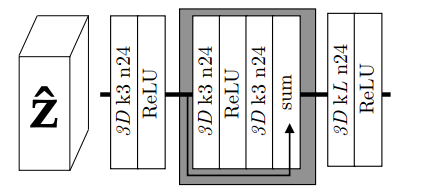

上下文概率模型结构如图所示:

对量化后的结果进行概率统计。

分类:

深度学习

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 如何调用 DeepSeek 的自然语言处理 API 接口并集成到在线客服系统

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App