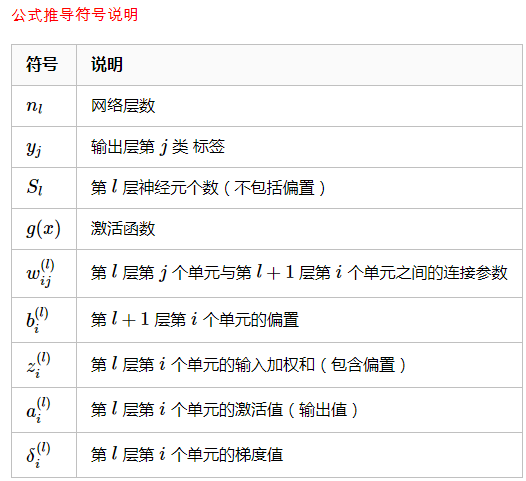

反向传播算法推导

一、MSE 损失函数推导

前向传播过程:

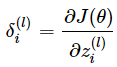

梯度反向传播公式推导:

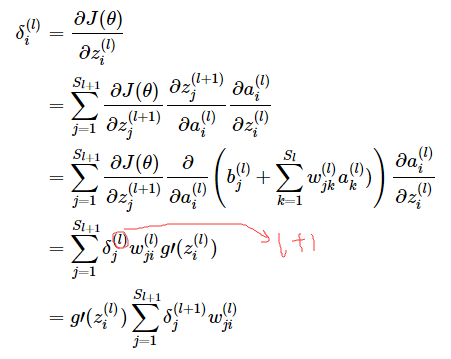

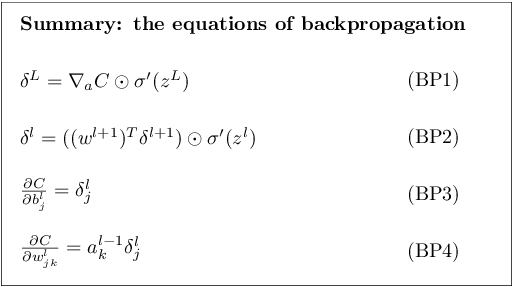

定义残差:

则

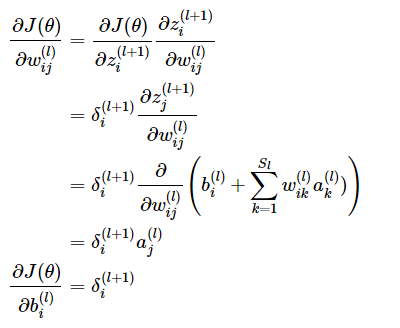

残差推导如下:

对于最后一层:

广义上,左边项(-(···))是定义的损失函数对其输入(即最后一层神经元值)的导数,右项是sigmoind求导,这两项都是根据实际使用可以替换的。

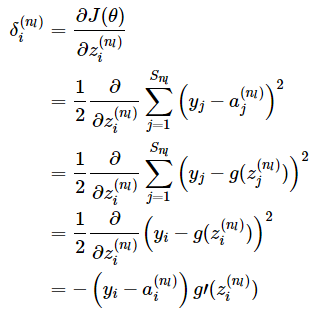

对于隐藏层:

若去掉下标i,则有

其中的操作是把两个向量对应元素相乘组成新的元素。

参考:

https://www.cnblogs.com/nowgood/p/backprop2.html

https://zhuanlan.zhihu.com/p/25416673

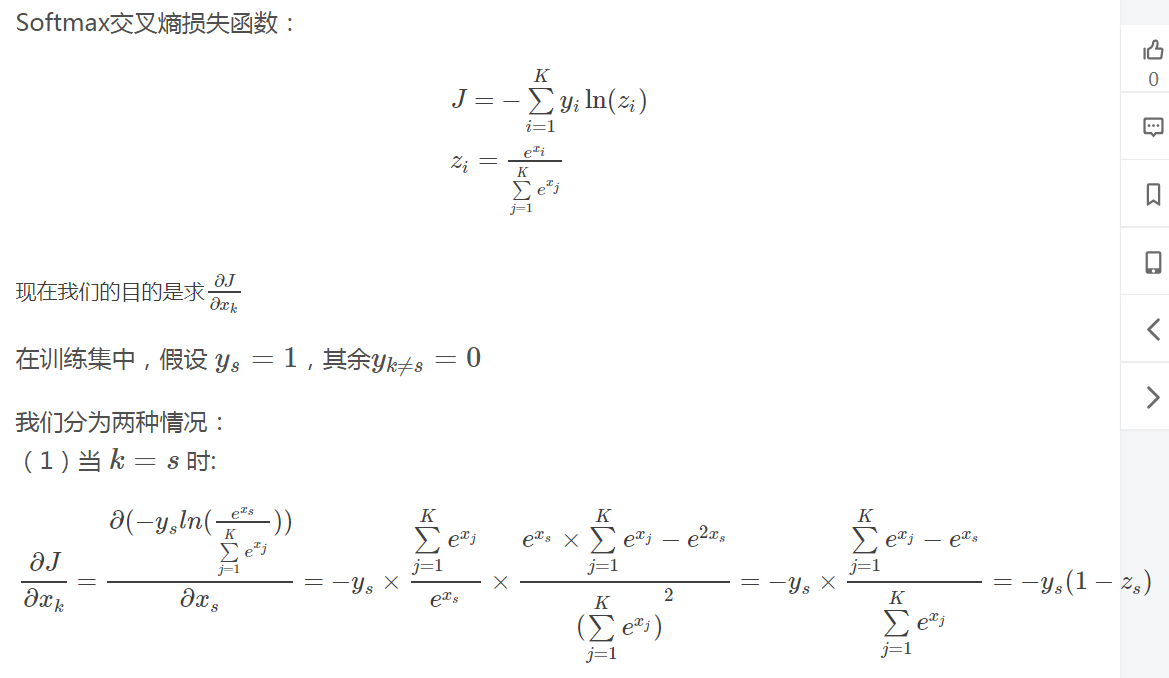

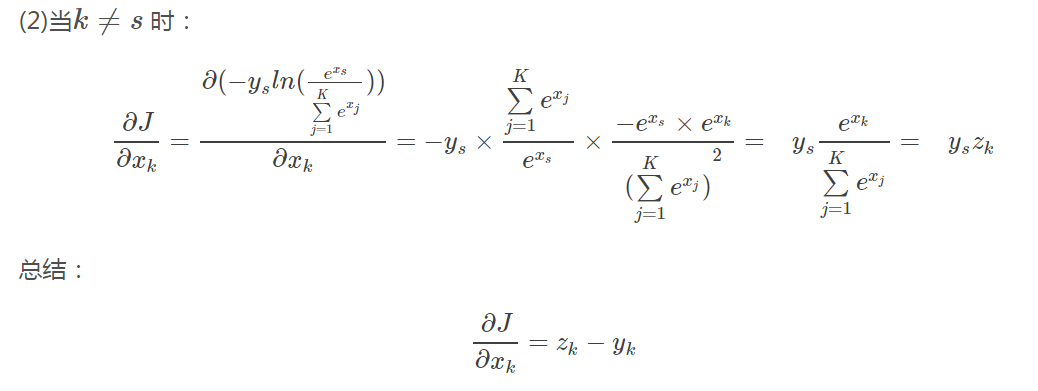

二、交叉熵损失函数推导

只放出最后一层残差:

参考:https://blog.csdn.net/Charel_CHEN/article/details/81266838

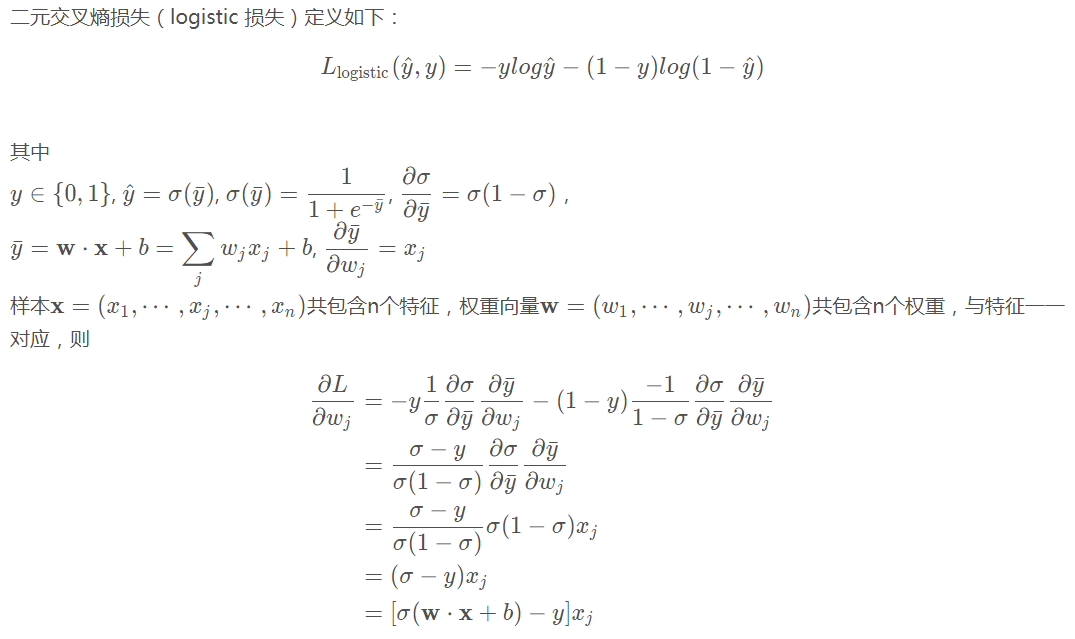

三、二元交叉熵损失梯度推导

参考:https://blog.csdn.net/chansonzhang/article/details/84674144

四、L2正则化以及反向传播

参考:https://blog.csdn.net/obrightlamp/article/details/85290929

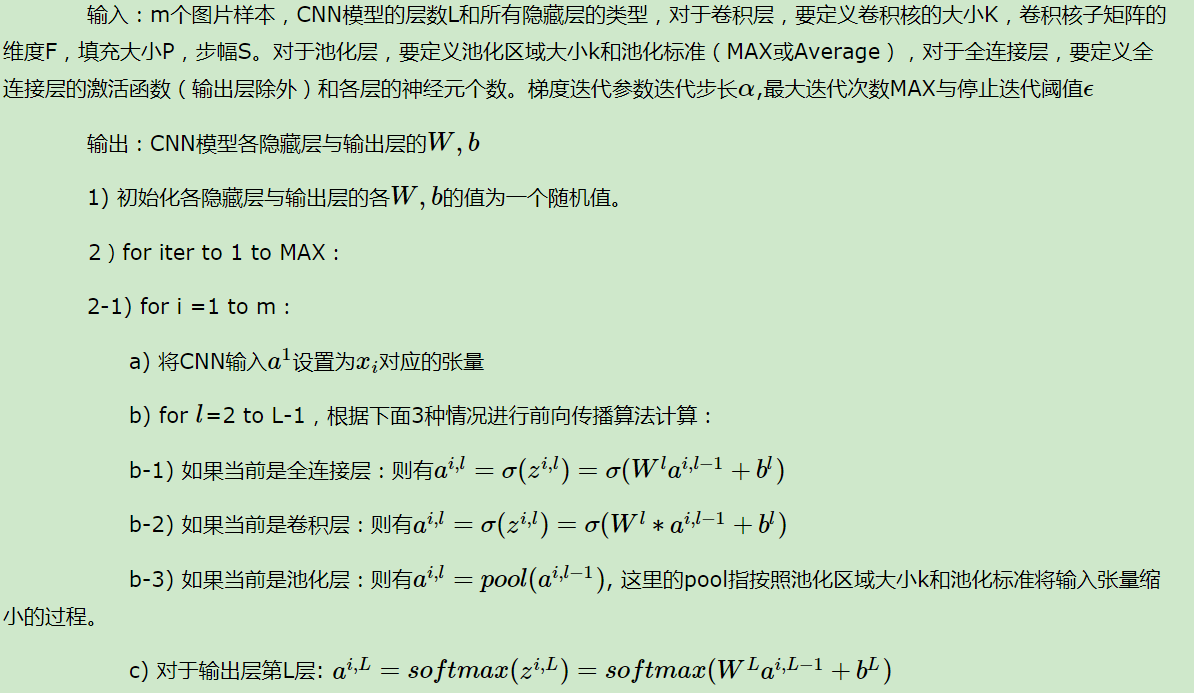

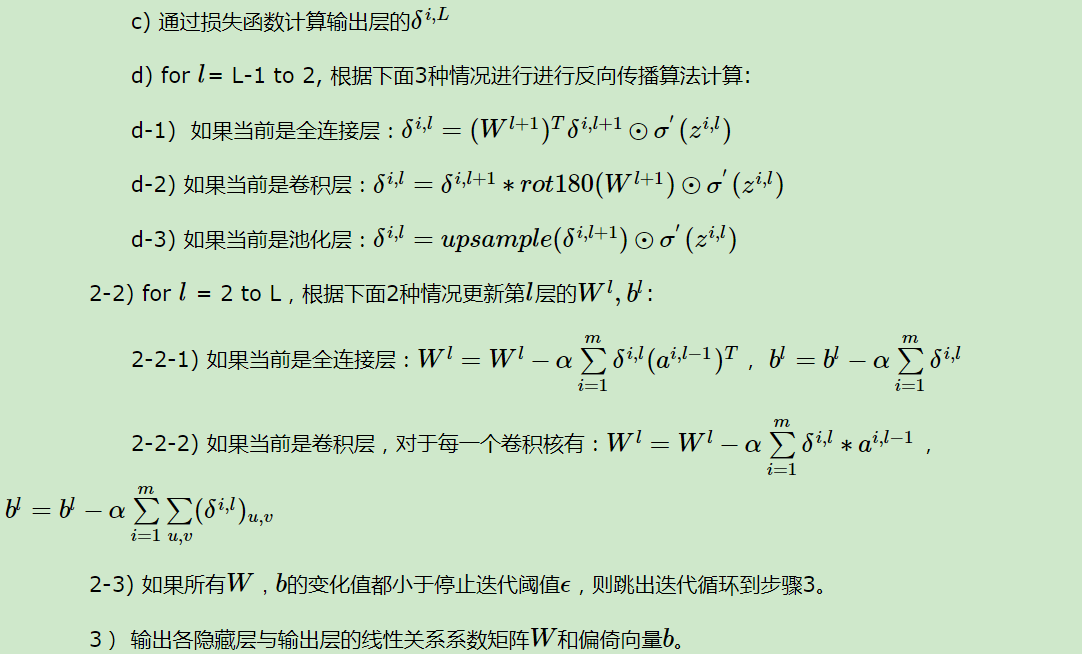

五、CNN反向传播算法总结

注释:CNN反向传播主要解决四个问题

一二问对应步骤d-3,三问对应步骤d-2,四问对应步骤2-2-2.

具体推导细节请移步:https://www.cnblogs.com/pinard/p/6494810.html