《机器学习》第一次作业——第一至三章学习记录和心得

| 作业标题 | 软件工程课程 |

|---|---|

| 课程连接 | 中国大学MOOC·模式识别与机器学习 |

| 作业说明 | 根据慕课和补充课件进行学习,并在自己理解的基础上,在博客园记录前三章的学习笔记。 |

| 作业要求 | 表述学习心得。以及可以依据自己的理解,描述知识点串接的思路 |

第一章

1.1 什么是模式识别?

定义:

根据已有的知识表达,针对待识别模式,判别决策其所述的类别或者预测其对应的回归值。

划分:

分为分类与回归两种。分类:输出量是离散的类别表达,即输出待识别模式所属的类别;回归:输出量为连续的信号表达。

回归是分类的基础:离散的类别值是由回归值做判别决策得到的。

应用:

- 计算机视觉领域(字体识别,交通标识识别,动作识别...)

- 人机交互(语音识别)

- 医学领域

- 网络领域

- 金融领域

1.2 模式识别数学表达

-

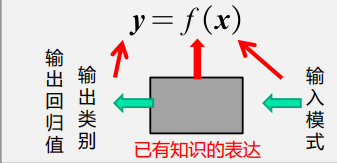

数学解释:模式识别可以看做一种函数映射f(x),将待识别模式x从输入空间映射到输出空间。函数f(x)是关于已有知识的表达。

- 函数f (x)的形式:可解析表达的、难以解析表达的

- 函数f (x)的输出:确定值、概率值。

-

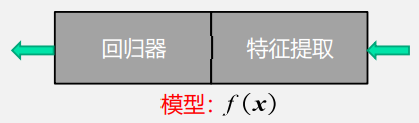

模型:

-

关于已有知识的一种表达 y = f(x);

-

(回归模型)组成:

- 特征提取(feature extraction):从原始输入数据提取更有效的信息。

- 回归器(regressor):将特征映射到回归值。传统意义上的模型)

-

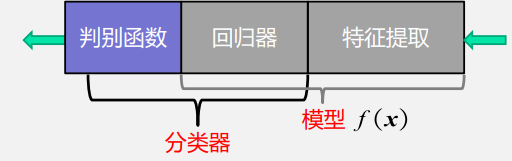

(分类模型)组成:

-

模型(广义):特征提取+回归器+判别函数。

-

模型(狭义):特征提取+回归器

-

分类器(classifier):回归器+判别函数。

-

-

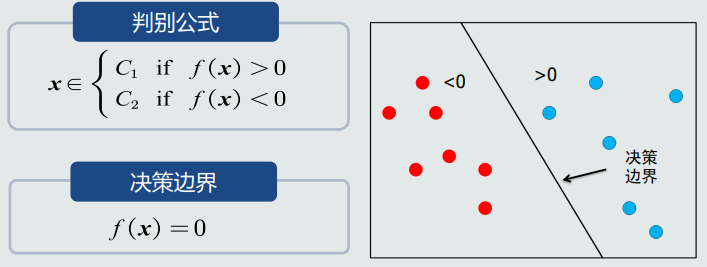

判别函数(决策边界)

- 二类分类: 使用sign函数:判断回归值大于0还是小于0。

- 多类分类:使用max函数:取最大的回归值所在维度对应的类别。

- 由于判别函数通常固定已知,所以不把它当做模型的一部分。

- 决策边界:

-

特征:

- 可以用于区分不同类别模式的、可测量的量。

- 特征向量: 多个特征构成的向量。

- 长度、方向等

- 特征空间:

- 每个坐标轴代表一维特征

- 空间中的每个点代表一个模式(样本)

- 从坐标原点到任意一点(模式)之间的向量即为该模式的特征 向量。

1.3 特征向量相关性

- 线性代数相关知识:

- 点积

- 投影(向量x分解到向量y方向上的程度。能够分解的越多,说明两个向量方向上越相似。)

- 残差向量

- 向量间的欧氏距离

1.4 机器学习基本概念

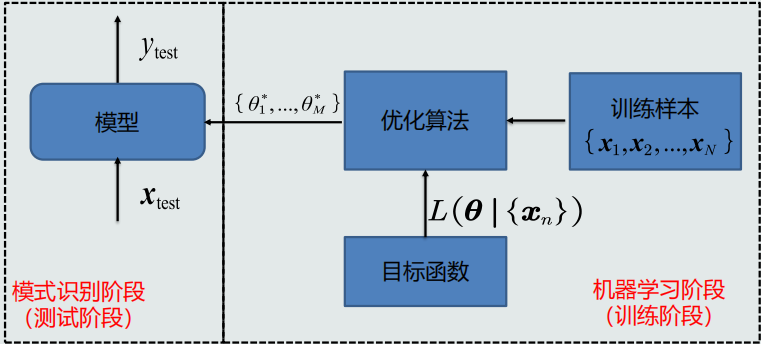

- 可理解为“用一组训练样本(数据)学习模型的参数和结构”

- 分为线性模型和非线性模型

- 样本量N与模型参数M的关系(参考线性代数-解方程组):

- N=M唯一的解

- N>>M没有准确的解

- N<<M无数个解/无解

- 机器学习流程

- 机器学习方式

- 监督式学习

- 无监督式学习

- 半监督式学习

- 强化学习

1.5 模型的泛化能力

- 训练集/ 测试集

- 测试集和训练集是互斥的,但假设是同分布的。

- 训练误差/测试误差

- 测试误差(test error):模型在测试集上的误差。它反映了模型 的泛化能力,也称作泛化误差。

- 训练误差(training error):模型在训练集上的误差。

- 泛化能力:

- 问题: 噪声、不均匀、样本稀疏

- 训练得到的模型不仅要对训练样本具有决策能力, 也要对新的(训练过程中未看见)的模式具有决策能力。

- 过拟合: 模型训练阶段表现很好,但是在测试阶段表现很差。 模型过于拟合训练数据。

- 提高泛化能力:

- 不要过度训练。(正则化、模型选择、调节超参数)

1.6.评估方法与性能指标

- 评估方法:留出法、K折交叉法、留一验证法

- 性能指标:准确度、精度、召唤率、F-Score、F1-Score、PR曲线、ROC曲线、AUC曲线

第二章 基于距离的分类器

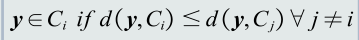

2.1 MED分类器

-

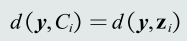

基于距离分类:把测试样本到每个类之间 的距离作为决策模型,将测试样 本判定为与其距离最近的类。

-

类的原型: 用来代表这个类的一个模式或者 一组量,便于计算该类和测试样 本之间的距离。

- 均值

- 最近邻

-

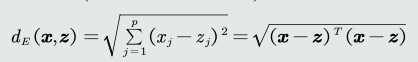

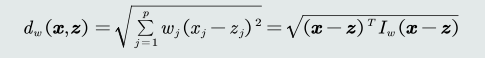

常见的几种距离度量

-

欧氏距离

-

曼哈顿距离

-

加权欧式距离

-

-

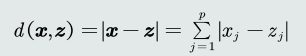

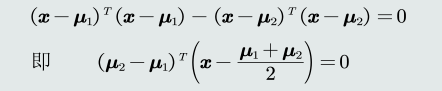

MED分类器

-

最小欧式距离分类器(Minimum Euclidean Distance Classifier)

-

距离衡量:欧式距离

-

类的原型:均值

-

决策边界:

-

问题: MED分类器采用欧氏距离作为距离度量,没有考虑 特征变化的不同及特征之间的相关性。

-

解决方法:去除特征变化的不同及特征之间的相关性。

-

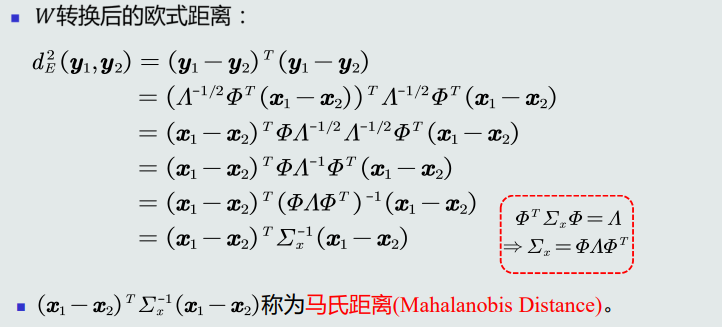

2.2 特征白化

-

目的:将原始特征映射到一个新的特征空间,使得在新空间 中特征的协方差矩阵为单位矩阵,从而去除特征变化 的不同及特征之间的相关性。

-

目标:

-

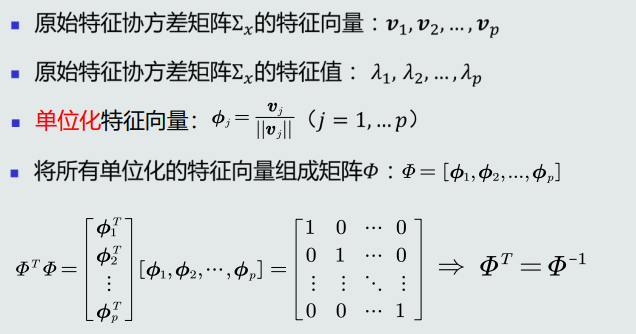

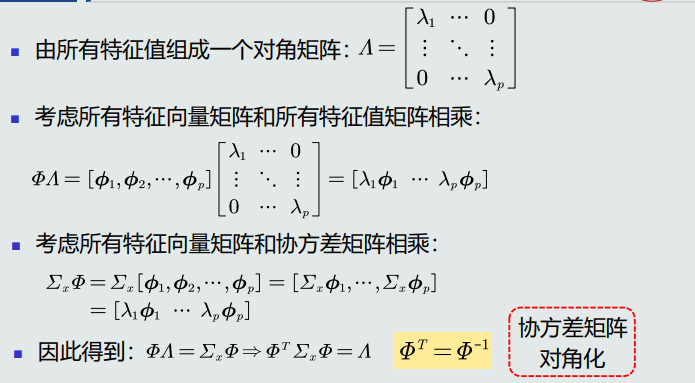

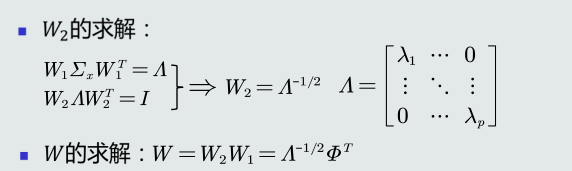

将特征转换分为两步:

-

解耦: 通过W1实现协方差矩阵对角化,去除特征之间的相关性。

-

白化: 通过W2对上一步变换后的特征再进行尺度变换,实现所有特征具有相同方差。

-

4.补充

- 马氏距离使非奇异线性变换不变的

- 马氏距离具有平移不变性、旋转不变性、尺度缩放不变性、不受量纲影响的特性

- 欧式距离具有平移不变性、旋转不变性

- 基于距离的决策仅考虑了每个类各自观测到的训练样本的分布情况,没有考虑类的分布等先验知

第三章贝叶斯决策与学习

3.1贝叶斯决策与MAP分类器

-

先验概率和后验概率

- 先验概率:根据以往的经验和分析得到的概率,不依靠观测数据。

- 表示方式有:

- 常数表达:例如,𝑝 𝐶𝑖 = 0.2

- 参数化解析表达:高斯分布……

- 非参数化表达:直方图、核密度、蒙特卡洛…

- 表示方式有:

- 后验概率:

- 先验概率:根据以往的经验和分析得到的概率,不依靠观测数据。

-

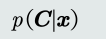

MAP分类器(最大后验概率分类器)

- 即将测试样本决策分类给后验概率最大的那个类

- 判别公式、决策边界(二类分类; 单维空间:通常有两条决策边界,高维空间:复杂的非线性边界)

- 决策误差(概率误差=未选择的类对应所对应的后验概率)

MAP分类器决策目标即为最小化概率误差,即分类误差最小化

(给定所有测试样本,MAP分类器选择后验概率最大的类,等于最小化平均概率误差,即最小化决策误差)

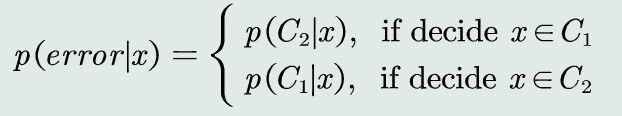

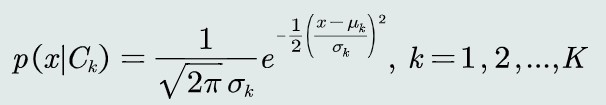

3.2 MAP分类器:高斯观测概率

-

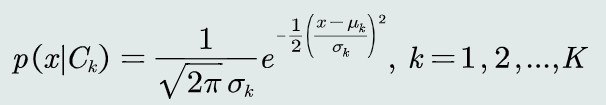

观测概率:单维高斯分布

决策边界:

- 当𝜎𝑖 = 𝜎𝑗 = σ 时,决策边界是线性的,只有一条;

如果𝜇𝑖 < 𝜇𝑗,且𝑃 𝐶𝑖 < 𝑃 𝐶𝑗 ,则𝛿 < 0;

说明:在方差相同的情况下,MAP决策边界偏向先验可能性较小的类,即分类器决策偏向先验概率高的类 - 当𝜎𝑖 ≠ 𝜎𝑗时,决策边界有两条(非线性边界),该决策方程是关于𝒙的二次型函数

且若𝜎𝑖 > 𝜎𝑗及先验概率相等时,可知𝛿 > 0,分类器倾向选择𝐶𝑗类,即方差较小(紧致)的类 - MAP分类器偏向于先验较大可能性、分布较为紧致的类

- 当𝜎𝑖 = 𝜎𝑗 = σ 时,决策边界是线性的,只有一条;

-

观测概率:高维高斯分布

决策边界为一个超二次型

3.3 决策风险与贝叶斯分类器

- 贝叶斯决策不能排除出现错误判断的情况,由此会带来决策风险。更重要的是,不同的错误决策会产生程度完全不一样的风险;

损失( λ(αi|Cj)(决策动作αi|Cj、测试样本的真值Cj) )

决策风险 R(αi|x)

R(αi|x) = ∑λij*P(Cj|x) - 贝叶斯分类器

给定一个测试样本𝒙,贝叶斯分类器选择决策风险最小的类;

贝叶斯分类器=MAP分类器+决策风险因素

判别公式

决策损失: 给定单个测试样本,贝叶斯决策的损失就是决策风险R

对于所有测试样本,期望损失为所有样本决策损失之和

决策目标:最小化期望损失 - 朴素贝叶斯分类器

特征维度太高,通过即假设特征之间符合独立同分布以达到简化计算的目的 - 拒绝选项

3.4最大似然估计

-

监督式学习

- 参数化方法:最大似然估计、贝叶斯估计

- 非参数化方法

-

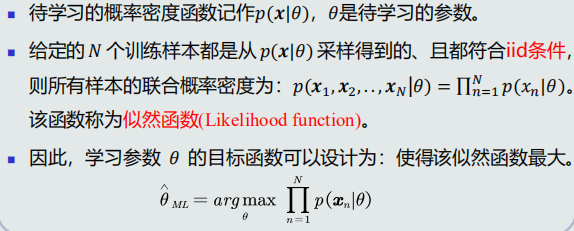

最大似然估计

- 先验概率估计: 给定所有类的𝑁个训练样本,假设随机抽取其中一个样本属于𝐶1类的概率为𝑃,则选取到𝑁1个属于𝐶1类样本的概率为先验概率的似然函数(即目标函数)

为最大化似然函数,采用对参数P求偏导

先验概率的最大似然估计就是该类训练样本出现的频率 - 观测概率估计: 如果观测似然概率服从高斯分布,待学习的参数包含该高斯分布的均值𝝁和协方差𝚺(观测似然概率是关于单个类的条件概率)

为最大化似然函数,采用对两个参数𝝁和𝚺分别求导

高斯分布均值的最答似然估计等于样本的均值,高斯分布协方差估计等于所有训练模式的协方差

- 先验概率估计: 给定所有类的𝑁个训练样本,假设随机抽取其中一个样本属于𝐶1类的概率为𝑃,则选取到𝑁1个属于𝐶1类样本的概率为先验概率的似然函数(即目标函数)

3.5最大似然估计的估计偏差

- 无偏估计

- 如果一个参数的估计量的数学期望是该参数的真值,则该估计量称作无偏估计

- 无偏估计意味着只要训练样本个数足够多,该估计值就是参数的真实值

- 均值的最大似然估计是无偏估计

- 高斯分布协方差的最大似然估计式有偏估计

- 需对协方差估计进行修正

可以通过将训练样本的协方差乘以𝑁/(𝑁 − 1)来修正协方差的估计值

3.6贝叶斯估计(1)

-

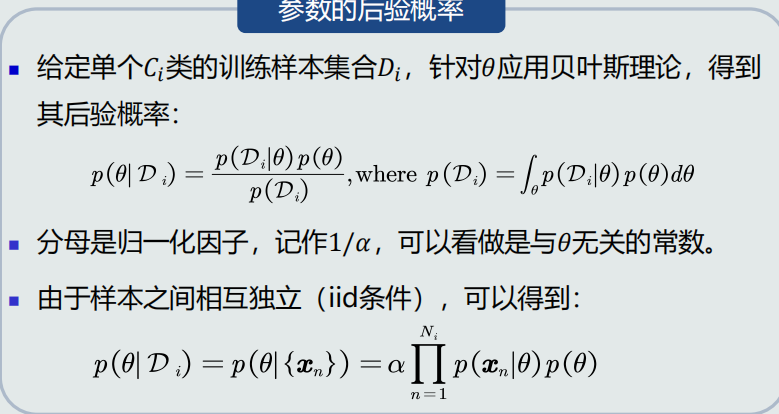

估计θ的后验概率

-

贝叶斯估计:给定参数𝜃分布的先验概率以及训练样本,估计参数θ分布的后验概率

假设𝜃服从一个概率分布:

- 该概率分布的先验概率已知:𝑝(𝜃)

- 先验概率反映了关于参数𝜃的最初猜测及其不确定信息

-

参数的后验概率

-

总结:

- 给定𝐶𝑖类的𝑁𝑖个训练样本,参数θ概率分布的均值等于训练样本均值和该参数先验概率均值的加权和

- 给定𝐶𝑖类的𝑁𝑖个训练样本,参数θ概率分布的方差是由𝐶𝑖类观测似然分布的方差、该参数的先验概率方差、𝐶𝑖类的样本个数共同决定

- 当𝑁𝑖足够大时,样本均值m就是参数θ的无偏估计

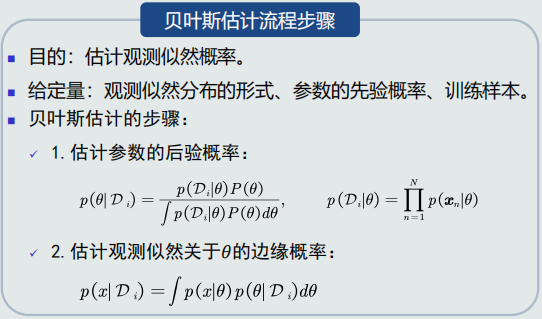

3.7贝叶斯估计(2)

- 估计观测似然关于θ的边缘概率

- 贝叶斯估计的步骤

3.8KNN估计

- 贝叶斯估计等是假设概率分布为高斯分布,但如果分布未知,就需要使用无参数估计技术来实现概率密度估计

- 常用的无参数估计技术:KNN估计、直方图估计、核密度估计,基于p(x)=k/(NV)估计概率密度

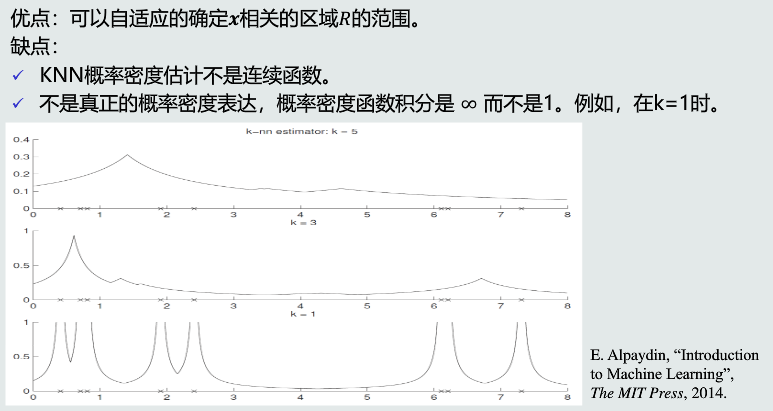

- KNN估计(K近邻估计)

- 给定x,找到其对应的区域R时期包含k个训练样本,以此计算P(x)

- 概率密度估计表达(dk(x)为 k个样本与x距离):

P(x)≈k/(2Ndk(x)) - 当训练样本个数N越大,k取值越大,概率估计越准确

- 优缺点

- KNN估计(K近邻估计)

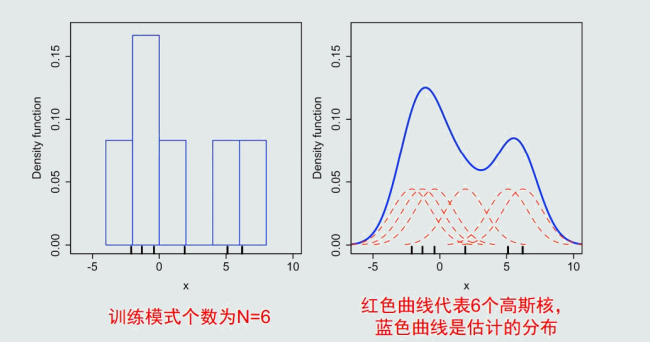

3.9 直方图与核密度估计

- KNN估计的问题:

- 在推理测试阶段,仍然需要存储所有训练样本

- 由于区域R是由第k个近邻点确定的,易受噪声影响。

- 直方图估计

-

原理:

- 区域𝑅的确定:

- 直接将特征空间分为m个格子(bins),每个 格子即为一个区域𝑅,即区域的位置固定。

- 平均分格子大小,所以每个格子的体积 (带宽)设为𝑉 = ℎ,即区域的大小固定。

- 相邻格子不重叠。

- 落到每个格子里的训练样本个数不固定, 即𝑘值不需要给定。

- 统计学习

- 概率密度估计:给定任意模式𝒙,先判断它属于哪 个格子,其概率密度即为该格子的统计值/带宽:

-

优缺点

- 优点

- 固定区域𝑅:减少由于噪声污染造成的估计误差。

- 不需要存储训练样本。

- 缺点

- 固定区域𝑅的位置:如果模式𝒙落在相邻格子的交界区域,意味 着当前格子不是以模式𝒙为中心,导致统计和概率估计不准确。

- 固定区域𝑅的大小:缺乏概率估计的自适应能力,导致过于尖锐 或平滑。

- 优点

-

带宽选择

- 带宽ℎ过小,概率密度函数过于尖锐。

- 带宽ℎ过大,概率密度函数过于平滑。

-

- 核密度估计

-

-

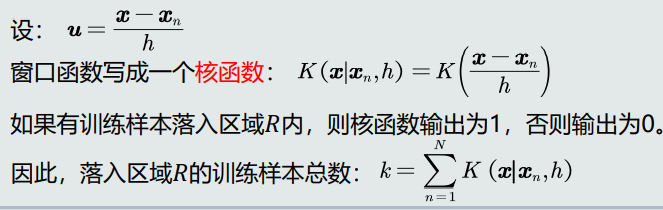

区域𝑅的确定:以任意待估计模式𝒙为中心、固定带宽ℎ,以此确定一个区域𝑅。

-

原理

-

统计学习

-

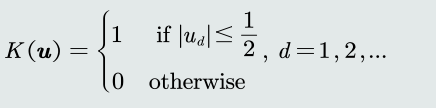

定义一个窗口函数:以𝒖为中心的单位超立方体(unit hypercube)

-

统计落入区域𝑅(带宽为h )内的训练样本个数

-

-

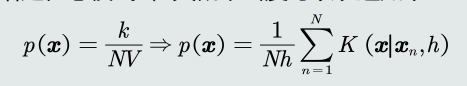

概率密度估计:

-

给定任意模式𝒙,其概率密度可以表达如下:

-

核函数要满足如下两个条件,使得估计的概率密度符合概率的定义。

-

所以,通常会放宽核函数输出的0/1约束,使其满足概率的定义,输 出变为0~1之间的值。

-

-

-

- 核函数:核函数可以是高斯分布、均匀分布、三角分布等。

- 优缺点

- 优点:

- 以待估计模式𝒙为中心、自适应确定区域𝑅的位置(类似KNN)。

- 使用所有训练样本,而不是基于第 𝑘 个近邻点来估计概率密度, 从而克服KNN估计存在的噪声影响。

- 如果核函数是连续,则估计的概率密度函数也是连续的。

- 缺点

- 与直方图估计相比,核密度估计不提前根据训练样本估计每个 格子的统计值,所以它必须要存储所有训练样本。

- 优点:

- 带宽选取原则:泛化能力

- 带宽ℎ决定了估计概率的平滑程度。

- 因为给定的训练样本数量是有限的,所以要求根据这些训练样本估计出 来的概率分布既能够符合这些训练样本,同时也要有一定预测能力,即 也能估计未看见的模式。

- 核密度估计比直方图估计更加平滑。