强化学习算法解析:PPO(Proximal Policy Optimization)

PPO(近端策略优化)是OpenAI于2017年提出的一种策略梯度类算法,以其高效性、稳定性和易实现性成为强化学习领域的主流算法。以下从核心原理、数学推导、代码实现到应用场景进行系统解析。

一、PPO 的核心设计思想

-

问题背景

传统策略梯度方法(如TRPO)存在两大痛点:-

更新步长敏感:步长过大易导致策略崩溃,步长过小则收敛缓慢;

-

样本利用率低:需大量环境交互数据。

-

-

PPO 的解决方案

-

Clipped Surrogate Objective:通过限制策略更新的幅度,确保新策略与旧策略的差异在可控范围内;

-

重要性采样(Importance Sampling):复用旧策略采集的数据,提升样本效率;

-

自适应惩罚项:替代TRPO的复杂约束优化,降低计算成本。

-

二、数学原理与目标函数

-

策略梯度基础

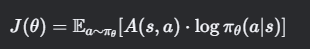

策略梯度目标函数为:

其中 𝐴(𝑠,𝑎)A(s,a) 为优势函数,衡量动作的相对价值。

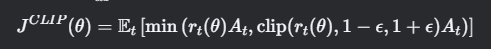

PPO 的目标函数引入重要性采样比![]() ,构建 clipped 目标函数:

,构建 clipped 目标函数:

-

Clip 机制:限制 𝑟𝑡(𝜃)rt(θ) 在 [1−𝜖,1+𝜖][1−ϵ,1+ϵ] 区间(通常 𝜖=0.2ϵ=0.2),防止策略突变;

-

双重目标:取最小值确保优化方向保守,避免过度偏离旧策略。

-

优势估计技术

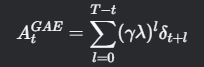

常用 GAE(Generalized Advantage Estimation) 计算优势值:

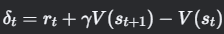

其中

,λ 控制偏差-方差权衡。

,λ 控制偏差-方差权衡。

三、算法流程与伪代码

四、关键超参数与调优策略

五、应用场景与性能对比

-

典型应用

-

游戏AI:OpenAI Five(Dota 2)、AlphaStar(星际争霸Ⅱ)

-

机器人控制:波士顿动力 Atlas 机器人步态优化

-

自然语言处理:ChatGPT 的策略优化阶段

-

-

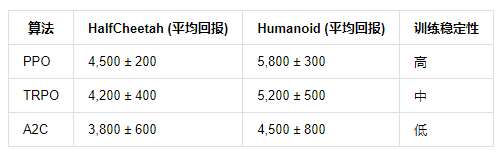

基准测试对比

在 MuJoCo 连续控制任务中,PPO 的性能显著优于传统算法:

六、PyTorch 实现核心代码

七、局限性与改进方向

-

固有缺陷

-

局部最优陷阱:Clip机制可能限制探索能力;

-

高维动作空间:对连续控制任务需精细调整熵系数。

-

-

前沿改进

-

PPO-Adaptive:动态调整Clip范围 ε;

-

POP(Phasic Policy Gradient):解耦策略与价值函数更新频率;

-

结合元学习:实现跨任务快速适应(如 Meta-PPO)。

-

总结

PPO 通过创新的目标函数设计和工程优化,在保持策略梯度方法理论优势的同时大幅提升实用价值。其核心在于平衡样本效率、训练稳定性与实现复杂度,成为工业级强化学习应用的首选算法。未来,与离线强化学习、多智能体系统的结合将拓展其应用边界。

浙公网安备 33010602011771号

浙公网安备 33010602011771号