Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ]

论文信息

论文标题:CoCo: A Coupled Contrastive Framework for Unsupervised Domain Adaptive Graph Classification

论文作者:Xiao Shen、Quanyu Dai、Fu-lai Chung、Wei Lu、Kup-Sze Choi

论文来源:2023 aRxiv

论文地址:download

论文代码:download

视屏讲解:click

1-摘要

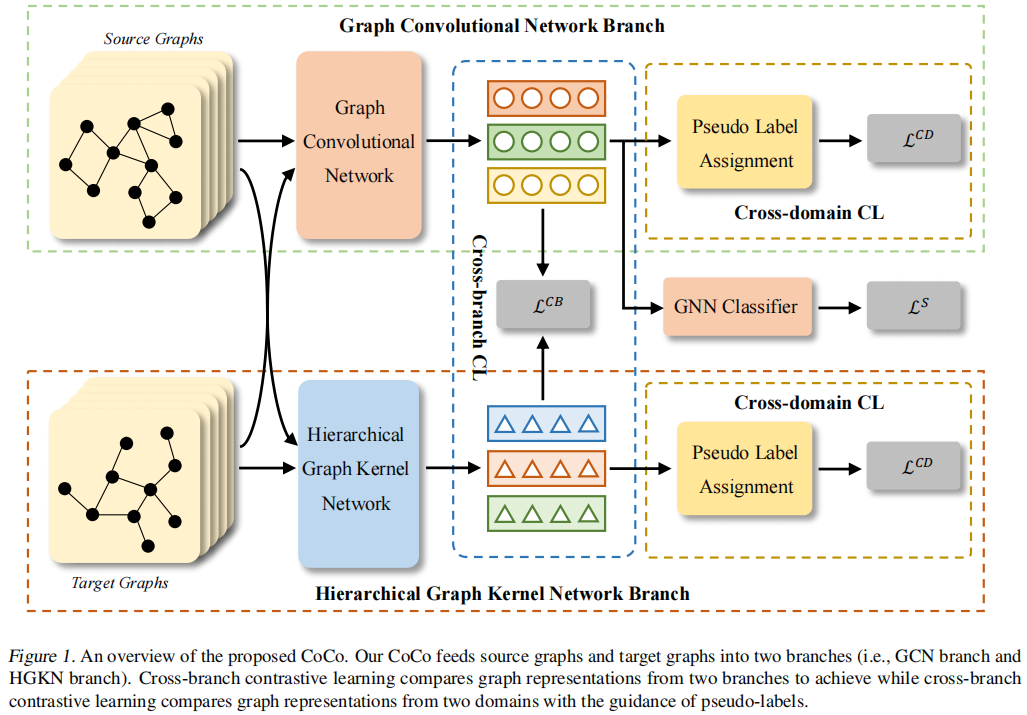

虽然图神经网络(GNNs)在图分类方面取得了令人印象深刻的成就,但它们往往需要丰富的任务特定标签,而获取这些标签的代价可能会很高。一个可信的解决方案是探索额外的标记图来增强目标域上的无监督学习。然而,由于对图拓扑的探索不足和领域差异显著,如何将gnn应用于领域自适应仍未得到解决。在本文中,我们提出了耦合对比图表示学习(CoCo),它从耦合学习分支中提取拓扑信息,并通过耦合对比学习减少域差异。CoCo包含一个图卷积网络分支和一个层次图核网络分支,它们以隐式和显式的方式探索图的拓扑。此外,我们将耦合分支合并到一个整体的多视图对比学习框架中,该框架不仅整合了从互补视图中学习到的图表示,以增强理解,而且还鼓励了具有相同语义的跨域实例对之间的相似性。在流行数据集上的大量实验表明,我们的CoCo在不同的设置下通常优于这些竞争基线。

2-介绍

贡献

- 介绍了一种新的无监督域自适应图分类方法CoCo,该方法包含一个图卷积网络分支和一个层次图核网络分支,从不同的角度挖掘拓扑信息;

- 一方面,跨分支对比学习鼓励耦合模块的一致性来生成全面的图表示。另一方面,跨域对比学习减少了具有相同语义的跨域对之间的距离,从而实现了有效的域对齐。

- 在各种广泛使用的图分类基准数据集上进行的综合实验证明了所提出的CoCo的有效性。

3-方法

模型框架

3.1 图卷积分支

GCN 通过消息传递隐式捕获结构信息 和 属性信息;

h(l)v=COM(l)θ(h(l−1)v,AGG(l)θ({h(l−1)u}u∈N(v)))h(l)v=COM(l)θ(h(l−1)v,AGG(l)θ({h(l−1)u}u∈N(v)))

图表示:

gθ(G)=READOUT({h(L)v}v∈V)(1)gθ(G)=READOUT({h(L)v}v∈V)(1)

3.2 层次结构图内核网络分支

hierarchical graph kernel network (HGKN) 显式 捕获图结构信息(高阶)

e(k)v(m)=Φ(Q(S(k−1)v),˜G(k)m)(2)e(k)v(m)=Φ(Q(S(k−1)v),~G(k)m)(2)

其中,S(k−1)vS(k−1)v 表示在前一层以 vv 为中心的子图,Φ(⋅,⋅)Φ(⋅,⋅) 表示给定的图核。

然后,我们可以通过连接所有过滤器的输出来更新节点表示 e(k)v∈RM,如下所示:

e(k)v=[e(k)v(1),⋯,e(v)M(M)](3)

最后,我们利用多层感知器(MLP)ψk(⋅) 将连接的核值投影到第 k 层的节点表示中,即 x(k)v=ψk(e(k)v)。

3.3 多视角的对比性学习框架

3.3.1 跨分支对比学习

考虑到该模型从互补视图学习图语义,我们对两个分支的图表示进行对比,以相互交换知识,提高了标签稀缺条件下目标数据的识别能力

具体来说,对于源批 Bs 和目标批 Bt 中的每一个图 Gi,我们从耦合分支产生嵌入,即 zi=gθ(Gi) 和 ˜zi=fϕ(Gi) 。然后,我们引入InfoNCE损失来增强交叉耦合分支的一致性。在配方中,

LCB=1|Bs|+|Bt|∑Gi∈Bs∪Bt−logexp(zi∗˜zi/τ)∑Gi′∈Btexp(zi∗˜zi′/τ)(6)

其中,τ 表示温度参数,被设置为 0.5。

3.3.2 跨领域对比学习

然而,由于图空间中严重的域移,图表示对于下游分类仍然存在偏差和不可靠。直观地说,源(目标)样本的表示应该接近于具有相同语义的目标(源)样本。为了实现这一点,我们需要生成目标数据的伪标签作为初步的。鉴于由于标签的缺乏,学习分类器是次优的和有偏的,我们通过比较目标图和源图之间的相似性,以非参数的方式生成伪标签。在此基础上,我们进行了跨域对比学习,使具有相同语义的跨域实例对与具有不同语义的实例对之间的距离最小化。

目标域伪标签生成:

ˆptj=∑(Gsi,ysi)∈Bs(ζ(zj,gθ(Gsi))∑(Gsi,ysi)∈Bsζ(zj,gθ(Gsi)))ysi

ˆytj=argmax(ˆptj)

其中,ζ(zj,gθ(Gsi))=exp(zj∗gθ(Gsi)/τ)。

跨域对比目标:

LCD=∑Gtj∈Bt−1|Π(j)|∑i∈Π(j)logexp(ztj∗zsi/τ)∑Gsi′∈Bsexp(ztj∗zsi′/τ)(8)

我们的跨领域对比性学习目标有两个好处。一方面,考虑到每一项的分子惩罚了具有相同语义的源样本和目标样本之间的距离,我们的损失有助于生成域不变图表示。另一方面,由于对比学习取得了很好的结果,比较正对和负对的比较有助于开发鉴别图表示,在标签稀缺条件下进行有效的图分类。我们还在另一个分支中构造了对比学习目标,并将它们相加得到最终的损失。

3.3.3 训练目标

总体目标:

L=LCB+LCD+LS

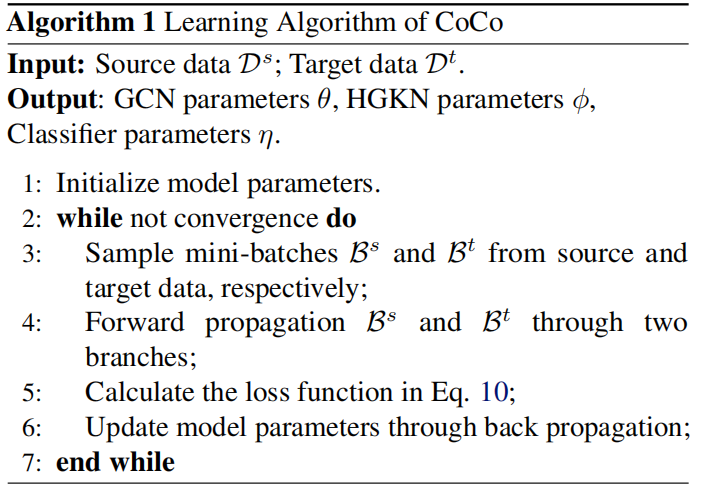

3.4 算法

4 实验

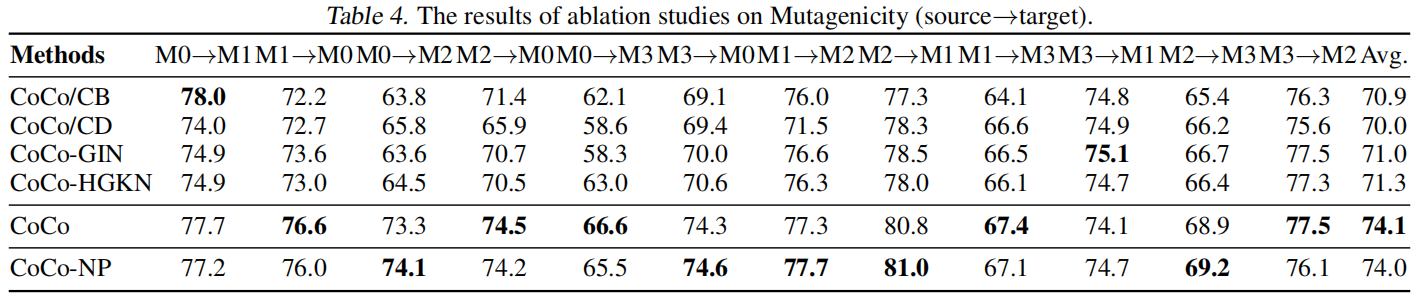

4.1 消融实验

4.1.1 组件消融实验

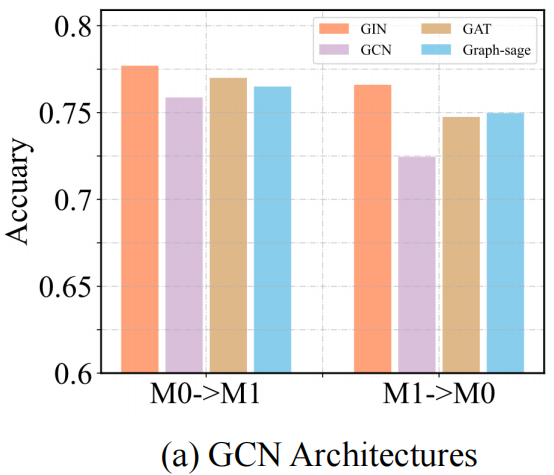

4.1.2 卷积消融实验

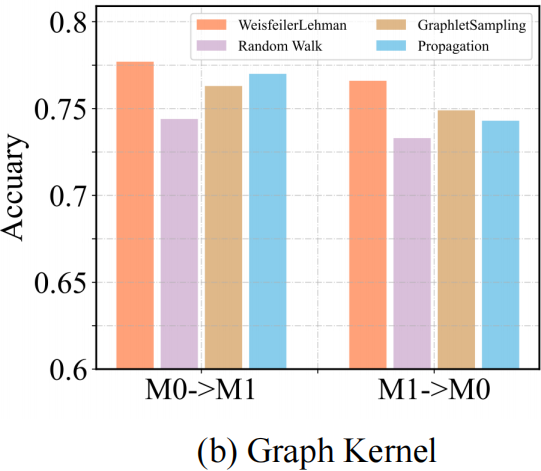

4.1.3 图核消融实验

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/18100161

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 地球OL攻略 —— 某应届生求职总结

· 提示词工程——AI应用必不可少的技术

· Open-Sora 2.0 重磅开源!

· 周边上新:园子的第一款马克杯温暖上架

2022-04-09 论文解读(S^3-CL)《Structural and Semantic Contrastive Learning for Self-supervised Node Representation Learning》

2020-04-09 红与黑