Note:[ wechat:Y466551 | 可加勿骚扰,付费咨询 ]

论文信息

论文标题:WIND: Weighting Instances Differentially for Model-Agnostic Domain Adaptation

论文作者:

论文来源:2021 ACL

论文地址:download

论文代码:download

视屏讲解:click

1 介绍

出发点:传统的实例加权方法由于不能学习权重,从而不能使模型在目标领域能够很好地泛化;

方法:为了解决这个问题,在元学习的启发下,将领域自适应问题表述为一个双层优化问题,并提出了一种新的可微模型无关的实例加权算法。提出的方法可以自动学习实例的权重,而不是使用手动设计的权重度量。为了降低计算复杂度,在训练过程中采用了二阶逼近技术;

贡献:

-

- 提出了一种新的可微实例加权算法,该算法学习梯度下降实例的权重,不需要手动设计加权度量;

- 采用了一种二阶近似技术来加速模型的训练;

- 对三个典型的NLP任务进行了实验:情绪分类、机器翻译和关系提取。实验结果证明了该方法的有效性;

2 相关

事实:把域外、域内数据联合训练做领域适应,但并不是所有来自域外数据集的样本在训练过程中都具有相同的效果。一些关于神经机器翻译(NMT)任务的研究表明,与域内数据相关的域外实例是有益的,而与域内数据无关的实例甚至可能对翻译质量有害 。

目前的实列加权方法:

-

- 核心思想:根据实例的重要性以及与目标域的相似性来加权实例;

- 问题:当前领域适应场景中,域外语料库的规模大于域内语料库,容易导致学习到的权值偏向于域外数据,导致域内数据的性能较差;

3 方法

为避免域内数据的性能较差,如何有效地利用 是域转移的关键。为解决这个问题,首先从 中抽取子集 ,并为每个实例 分配一个标量权值 。本文希望在训练过程中,模型能够找到最优的权重 ,因此,权重 是可微的,并可通过梯度下降优化。此外,将 DNN 表示为由 参数化的函数 ,并将 从输入空间映射到标签空间。

最终训练损失遵循一个加权和公式:

其中 表示损失函数,可以是任何类型的损失,如分类任务的交叉熵损失,或标签平滑交叉熵损失。

由于域内和域外数据集的数据分布存在差异,简单联合优化 和 可能会对 引入偏差。本文期望在 上训练的模型可以推广到域内数据。受 MAML 的启发,本文建议从 中采样另一个子集 命名为查询集,使用这个查询集来优化 。具体来说,目标是得到一个权重向量 减少 上的损失:

总结:随机初始化 ,用 训练一个模型,得到优化后的参数 ,接着固定 ,最小化在查询集上的损失,得到新的 。

该过程表述为以下双层优化问题:

上述双层优化问题由于求解复杂性高,难以直接解决。受 MAML 中的优化技术启发,将每次迭代的训练过程分为以下三个步骤:

- 伪更新

- 实例权重更新

- 最终更新

对 使用链式法则:

问题:使用 , 分别表示 , 的维数,二阶推导 是一个 矩阵,无法计算和存储。幸运的是,可采用 DARTS 中使用的近似技术来解决这个问题,这种技术使用了有限差分近似:

算法

4 实验

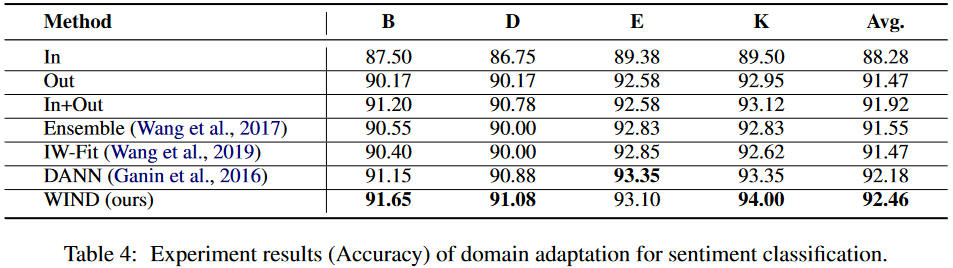

情感分析

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/17584262.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· winform 绘制太阳,地球,月球 运作规律

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

2020-08-23 1356. 根据数字二进制下 1 的数目排序

2020-08-23 数组中出现次数超过一半的数字

2020-08-23 762. 二进制表示中质数个计算置位

2020-08-23 476. 数字的补数

2020-08-23 面试题 05.07. 配对交换