论文信息

论文标题:A Survey on Graph Structure Learning: Progress and Opportunities

论文作者:Yanqiao Zhu, Weizhi Xu, Jinghao Zhang, Yuanqi Du, Jieyu Zhang, Qiang Liu, Carl Yang, Shu Wu

论文来源:2022,arXiv

论文地址:download

论文代码:download

1 Introduction

图结构学习的出发点:GNN 的成功可以归因于它们能够同时利用图结构和属性中固有的丰富信息,但所提供的图不可避免地不完整和噪声较大,这给将 GNN 应用于现实问题带来了巨大的挑战。从表示学习的角度来看,GNN 通过递归聚合来自相邻节点的信息来计算节点嵌入,这种迭代机制具有级联效应——小的噪声将传播到社区,恶化许多其他表示的质量。

上述问题激发了围绕图结构学习(GSL)的中心主题的大量研究,该主题的目标是联合学习 一个优化的图结构 及 其相应的表示。

2 Preliminaries

2.1 Problem Formulation

Given a (partially available) graph at the begining, the goal of GSL is to simultaneously learn an adjacency matrix and its corresponding graph representations that are optimized for certain downstream tasks.

与图结构相关的概念:

-

- graph generation:target at generating novel, diversified graphs;

-

- graph learning:Aim to recover the Laplacian matrix of a homophilous graph corresponding to given node features;

-

- a GNN encoder :接收一个图作为输入,并为下游任务生成嵌入;

- a structure learner :对图的边连通性进行建模;

对模型参数 进行训练,学习目标如下:

其中第一项是相对于特定目标的真实标签 的任务,第二项对学习图及其表示施加先验约束, 是一个超参数。

2.2 Graph Structure Learning Pipeline

如 Figure 2 所示,大多数现有的GSL模型都遵循一个三阶段的管道:(1) graph construction,(2) graph structure modeling,和 (3) message propagation 。

最初,当给定的图结构不完整甚至根本不可用时,我们构造一个初步的图作为起点。有多种方法来构建这样的初始图,其中两个最常见的选项是

-

- (1) Nearest Neighbors (kNN graphs)

- (2) proximity thresholding ( -graphs)

这两种方法都首先使用核函数来计算节点特征的成对距离。

对于kNN图,如果 是 的 近邻居之一,则我们连接两个节点 、。对于后一个 -graphs,,如果两个节点的相似性小于预设的阈值,我们将在两个节点之间创建一条边。

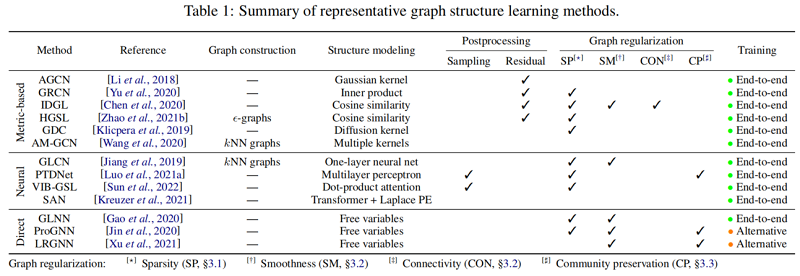

GSL的核心是结构学习器 ,它对边连通性进行建模,以细化初步图。在这项工作中,我们将现有的研究分为以下三组:

-

- Metric-based approaches employ a metric function on pairwise node embeddings to derive edge weights.

- Neural approaches leverage more expressive neural networks to infer edge weights given node representations.

- Direct approaches treat the adjacency matrix as free learnable parameters and directly optimize them along with GNN parameters .

与直接方法不同,基于 direct approaches 的和 neural approaches 通过参数化网络学习边缘连接,该网络接收节点表示并生成一个表示优化图结构的矩阵 。在获得由结构学习者表示的原始图结构后,可能需要进行额外的后处理步骤,如离散抽样,来产生最终的图 。

在得到一个优化的邻接矩阵 后,我们使用一个GNN编码器 来将节点特征传播到细化的邻域,从而得到嵌入 。

值得注意的是,由于优化图结构的困难,通常会重复最后两个步骤,直到满足指定的标准。换句话说,在第二步中,将利用消息传播产生的表示来建模边缘权值,迭代地细化图的拓扑和表示。

3 Graph Regularization

在实践中,我们经常希望学习到的图满足某些性质。在使用图结构建模技术之前,我们将在本节中回顾三种通用的图正则化技术:稀疏性(sparsity)、平滑性(smoothness)和社区保存(community preservation)。

3.1 Sparsity

然而,最小化等式(2)通常是 NP-hard 的。因此,我们通常采用 ,即它的凸松弛,它可以用 coordinate descent 或 proximal gradient descent 来求解。另一种包含稀疏性约束的方法是通过其连续松弛。

除了直接泛化非零项外,一些方法还采用了隐式稀疏化,例如,对邻接矩阵进行硬阈值化,类似于构造 -graph。

3.2 Smoothness

图信号处理的一个广泛使用的假设是,信号在相邻节点之间平滑变化。为了增强图信号的平滑性,我们最小化以下一项:

理论上,最小化 惩罚连接 的远边,表明光滑信号对应的图具有稀疏边集。因此,我们可以施加一个辅助的连接约束

其中对数势垒强制度为正,但不使单个边稀疏。虽然最小化 导致稀疏图,改变其系数并不控制稀疏度,而只对解进行扩展。为了直接控制稀疏性,建议将稀疏性正则化器与 一起使用。

3.3 Community Preservation

4 Graph Structure Modeling

4.1 Model Taxonomy

4.1.1 Metric-based Approaches

基于度量的方法使用核函数来计算节点特征/嵌入对之间的相似性作为边缘权值。根据网络同质性假设,边缘倾向于连接相似的节点,这些方法通过促进类内连接来细化图结构,从而得到更紧凑的表示。由于核函数的可微性,大多数基于度量的方法都具有端到端训练的能力。Gaussian kernels

AGCN 提出了一种基于距离度量学习的结构学习模型。具体来说,AGCN计算每对节点特征之间的广义马氏距离。然后,利用给定距离的大小为 的高斯核来细化拓扑结构:

其中, 和 是一个可训练矩阵。

GRCN 、GAUG-M 和 CAGNN 提出通过取两个端节点嵌入的内积来建模边权值:

其中,。

GNN-Guard 和 IDGL 使用余弦相似度来测量边权值:

其中, 是可训练参数。

GDC 使用扩散核来量化边连接:

其中, 为所满足要求的加权系数 , 是广义的转移矩阵, 常采用的是 PageRank kernel 和 heat kernel。在 GDC 之后,AdaCAD 在设计过渡矩阵时同时考虑了节点特征和图结构;GADC 研究了每个节点的最优扩散步骤。

为了增强表达性,AM-GCN 利用 cosine kernel 和 heat kernels 来学习拓扑空间中的信息嵌入。类似地,Yuan等人 [2022] 在节点表示上使用 cosine kernel 和一个额外的 heat kernels 来对图结构的局部和全局方面进行编码。

4.1.2 Neural Approaches

除了简单的神经网络,许多人利用注意机制来建模边连接,因为它能够捕捉节点之间复杂的交互。GAT 率先提出了在一跳社区中使用 masked self-attention 的方法:

其中, 和 是可学习参数。注意分数 指定了对不同相邻节点的系数。在消息传播中,每个节点计算其邻域特征的加权组合:

与在静态图结构上操作的普通 GNN 相比,归一化注意分数 动态地放大或减弱现有的连接,形成一个表示学习到的图结构的邻接矩阵。

GAT的一种改进方法设计了不同的注意机制。下面我们将讨论一些广泛使用的工作;我们基于度量的神经直接推荐感兴趣的读者到 Lee等人[2019] 进行全面的调查。GaAN [Zhangetal.,2018] 利用了一种门控注意机制,动态调整每个注意头部的贡献。Gao 和 Ji[2019] 建议使用 hard and channel-wise attention 来提高计算效率。PGN [2018]和 VIB-GSL [2022] 提出使用点积自注意力机制来推断动态连接。Magna [ 2021] 提出了包含多跳上下文信息的注意力扩散。Brody [2022] 提出了一种GAT变体来增加注意功能的表达性。

由于消息的传播不管图的连通性如何,如何恢复图的位置和结构信息(例如,局部连通性)成为基于 Transformer 的模型的中心问题。最早的工作提出了事先将拉普拉斯式的位置嵌入连接到节点特征上 [Dwivedi和Bresson,2020],类似于序列的位置编码。后续工作 Graphomer [Yingetal.等人,2021]考虑了额外的结构信息,如中心性和最短路径距离。GraphiT [Mialonetal.,2021] 提出了相对位置编码,通过正确定核重加权注意分数,并利用局部子图结构丰富节点特征。Kreuzer [2021] 提出了可学习的位置编码,它使用另一个变换编码器变换图的拉普拉斯谱。最近,Dwivedi [2022] 提出了解耦结构嵌入和位置嵌入,并使它们能够与其他参数一起进行更新。

4.1.3 Direct Approaches

与上述方法不同,direct approache 将目标图的邻接矩阵视为自由变量来学习。由于 direct approache 不依赖于节点表示来建模边连接,因此它们具有更大的灵活性,但在学习矩阵参数方面存在困难。

其中 为指示函数, 和 表示标签 的计算图及其相关特征, 为子图进行解释。最近,GSM L [Wan,2021] 提出了一种元学习方法,即将 GSL 表述为一个双层优化问题,其中内环表示下游任务,外环学习最优结构:

其中, 指定不导致单例节点的可允许拓扑空间,, 是测试集和训练集的节点标签。由于缺少自监督知道,GSML提出了通过元梯度进行二层优化的解决方案。

类似地,vGCN [Elinas,2020] 也从贝叶斯的角度制定了GSL,它考虑了先验伯努利分布(由观察图参数化)和基于 GNN 的可能性。由于后验分布的计算在分析上是棘手的,vGCN 利用变分推理来近似推断后验。后验参数的估计通过基于梯度优化的 Evidence Lower BOund (ELBO),由

其中第一项是基于 GNN 的似然,第二项测量近似后验和先验之间的 KL 散度。

4.2 Postprocessing Graph Structures

4.2.1 Discrete Sampling

请注意,从离散分布中进行抽样是不可微的。除了上述使用特殊优化方法的直接方法(4.1.3)外,我们还讨论了通过重新参数化技巧与传统的梯度下降方法进行优化,该技巧允许梯度通过采样操作反向传播。一种常见的方法是利用 Gumbel-softmax 技巧 [Jang等人,2017],通过从 Gumbel 分布中抽取样本(即边)来生成可微分图。以神经稀疏为例[Zheng,2020]为例;它近似于分类分布如下:

除了Gumbel-Softmax技巧,其他端到端离散抽样的实现包括 AD-GCL 使用的 Gumbel-Max ,以及 hard concrete [Louizos,2018],由 PGExplainer 推广 [Luo et al., 2020] 和PTDNet [Luo et al., 2021a]。GIB [Wu,2020] 提出了两个模型变量,将注意力权重视为分类分布和伯努利分布的参数,从中对细化的图结构进行抽样。

4.2.2 Residual Connections

初始图结构,如果可用,通常携带关于拓扑的重要先验知识。因此,可以合理地假设优化后的图结构与原始图结构略有变化。基于这一假设,一些工作添加了残差连接 [Heetal.,2016] 来纳入图结构的初始状态,这也被发现可以加速和稳定训练 [Lietal.,2018]。

在数学上,使用更新函数将学习到的边权值与原始邻接矩阵相结合:

在其他文献中,我们可以将学习到的邻接矩阵 与原始结构 结合起来作为残差。一个超参数 用于调节每个部分的影响,其中 被实例化为:

其他流行的 的选择包括多层感知器和通道式注意网络,它们能够自适应地融合这两种结构。

请注意,原始的图结构可以用邻接矩阵以外的不同形式来表示。例如,AGCN [Li,2018]将图拉普拉斯矩阵作为先验知识;AM-GCN [Wang,2020] 将原始特征图独立传播到学习特征图上,并将两种表示结合起来获得最终的节点嵌入。

5 Challenges and Future Directions

- Beyond homogeneity

- Beyond homophily

- Learning structures in absence of rich attributes

- Increasing scalability

- Towards task-agnostic structure learning

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/16531147.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· DeepSeek在M芯片Mac上本地化部署