论文信息

论文标题:MGAE: Masked Autoencoders for Self-Supervised Learning on Graphs

论文作者:Qiaoyu Tan, Ninghao Liu, Xiao Huang, Rui Chen, Soo-Hyun Choi, Xia Hu

论文来源:2022, ArXiv

论文地址:download

论文代码:download

1 Introduction

MAE 在图上的应用。

2 Method

整体框架:

2.1 Encoder

本文的掩藏目标是随机掩藏一部分(30%)边,然后考虑 GCN、GraphSage 作为主干网络提取特征信息,对于被掩藏的边将通过 Decoder 训练得到。

掩藏策略:

-

- Undirected masking:将图看成无向图,删除 之间的边,对应于 中的两条边;

- Directed masking:将图看成有向图,删除 之间的边,对应于 中的一条有向边;

注意:上述两种策略边掩藏率是设置一样的。

2.2 Cross-correlation decoder

由于Encoder 采用的是基于消息传递机制的 Encoder,所以最终只得到被保留部分的节点潜在嵌入。

Encoder 层传播结构共生成的保留节点嵌入矩阵 ,对于存在的保留节点进行 cross-correlations 操作,即

其中:

-

- 表示连接;

- 表示元素乘法;

- 表示节点 和节点 之间的交叉表示,分别考虑它们的 阶邻域和 阶邻域;

为避免过于复杂,通常 。

假设剩余的节点有 个,那么输入到对应的 MLP Decoder 的将有 (无向图)个特征向量,最终预测 直接边存在的概率通过下式生成:

2.3 Reconstruction target

MGAE解码器,只重建掩码的边,目标函数如下:

为加速训练,本文采用负采样策略。

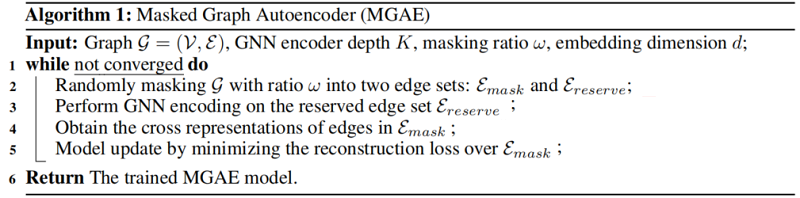

2.4 Algorithm

整体算法如下:

3 Experiments

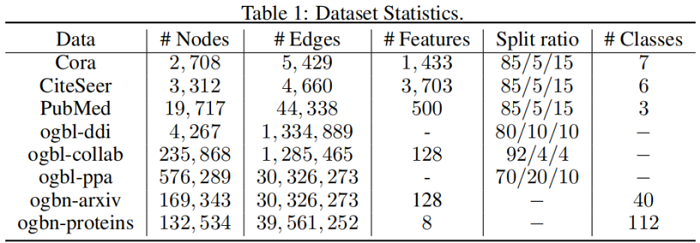

数据集

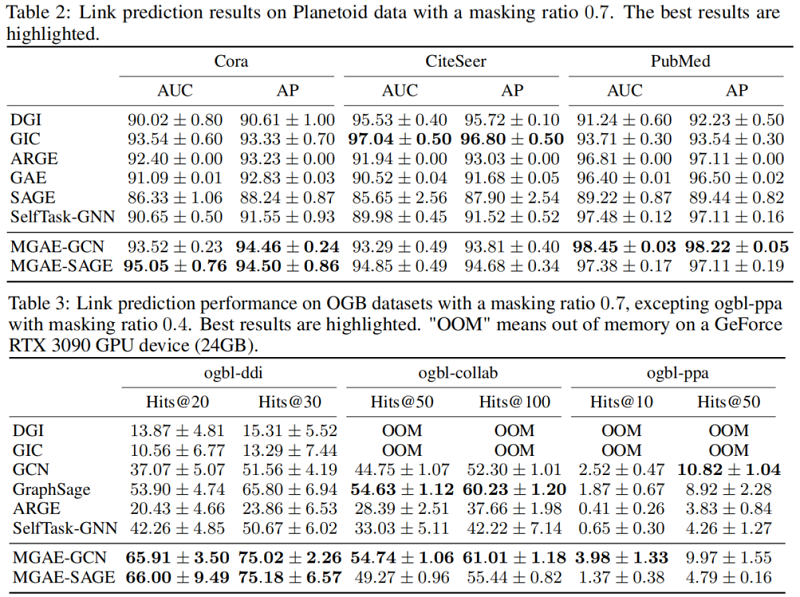

Link prediction

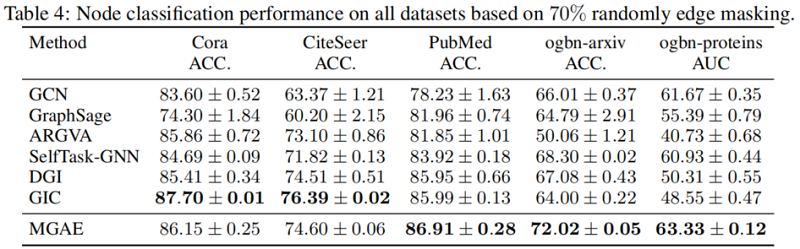

Node classifification

4 Conclusion

图上边掩码AE。

修改历史

2022-06-17 创建文章

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/16386259.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律

2021-06-18 机器学习——逻辑回归(Logistic Regression)