论文信息

论文标题:Bilinear Graph Neural Network with Neighbor Interactions

论文作者:Hongmin Zhu, Fuli Feng, Xiangnan He, Xiang Wang, Yan Li, Kai Zheng, Yongdong Zhang

论文来源:2019, NeurIPS

论文地址:download

论文代码:download

1 Introduction

GNNs 中的图卷积操作可以认为是对目标节点的邻居特征线性聚合(加权和)。虽然它改进了目标节点的表示,但这种线性聚合假设邻居节点是相互独立的,而忽略了它们之间可能存在的相互作用。

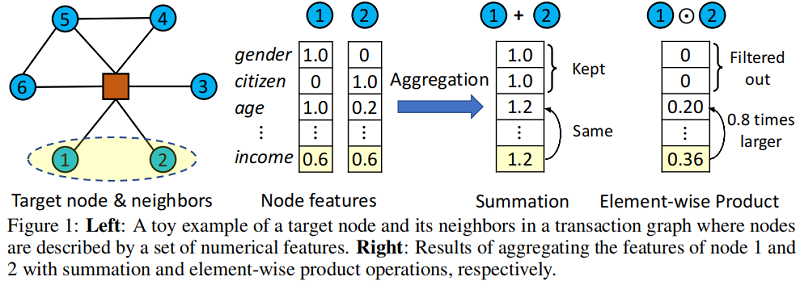

在某些情况下,相邻节点之间的相互作用可能是一个指示目标节点特征的强信号。Figure 1 (left) 展示了交易图中目标节点及其邻居的一个玩具示例,其中边表示货币转移关系,节点由一组诸如年龄和收入等特征来描述。考虑评估目标节点的信用等级,直觉是,与富有朋友有密切业务关系的客户有更高的机会偿还贷款。

在 Figure 1 (right) 中,我们展示了基于 的线性聚合器——现有 GNNs 中的一种常见选择——未能突出 特征。相比之下,通过使用基于乘法捕获节点交互的 聚合器,共享高收入的潜在信号被突出显示,作为辅助效应,一些不太有用的特性被归零。

GNNs 中的图卷积操作一般满足两个条件:

-

- permutation invariant

- linear complexity

2 Method

2.1 Preliminaries

定义:

-

- 图 ;

- 节点 的邻居 ;

- 加上自环的节点 的邻居 ;

- 节点 的度(带自环) ;

- 节点 的表示 ;

spatial GNN (GAT)通过递归地聚合来自邻居的特征来实现这一目标:

AGG 函数通常被实现为一个加权和,其中 为邻域 的权重。在 GCN 中, 被定义为 ,这是基于拉普拉斯理论的。然而,这种加权和的一个限制是,没有邻居表示之间的交互作用被建模。虽然使用更强大的特征转换函数,如多层感知器(MLP)可以缓解这个问题,但这个过程是相当隐含的和无效的。来自[2]的经验证据,表明MLP在捕获输入特征之间的乘法关系方面效率低下。在这项工作中,我们建议显式地将基于乘法的节点交互注入到AGG函数中。

2.2 Bilinear Aggregator

我们提出了一种适用于局部结构中邻居相互作用建模的双线性聚合器:

其中:

-

- 为哈达玛积;

- 目标节点;

- 和 是扩展邻居 的节点索引;

- 表示目标节点 的交互次数,对得到的表示进行归一化,以消除节点度的偏差;

值得注意的是,我们考虑了目标节点本身,并聚合了来自扩展邻居的信息,这些信息虽然看起来与GNN相同,但原因不同。在GNN中,考虑目标节点是在分层聚合过程中保留其信息,而在BGNN 中,我们考虑的是目标节点与其邻居之间的相互作用也可能携带有用的信号。例如,对于只有一个邻居的稀疏节点,邻居之间的交互不存在,而目标节点和邻居节点之间的交互可能特别有用。

Time Complexity Analysis

乍一看,双线性聚合器考虑了邻居(包括目标节点)之间的所有成对交互,因此可能具有二次时间复杂度,高于加权和。然而,通过类似于FM中使用的数学重新公式,我们可以在线性时间内计算聚合器 ,这与与加权和相同。为了证明这一点,我们将 的等价形式重写为:

其中,

可以看出,通过数学的重新表述,我们可以将成对元素级积的和减少为两项的负值,其中每一项都是邻域表示(或其平方)的加权和,可以在 时间内计算。注意,权值矩阵 是聚合器中的一个标准操作,因此为了简洁起见,省略了它的时间代价。

Proof of Permutation Invariant

从简化的 可以直观地理解这个特性:当改变输入向量的顺序时,输入的和(第一项)和输入的平方和(第二项)不会改变。因此,输出保持不变,并满足排列不变性。为了提供一个严格的证明,我们给出了双线性聚合器的矩阵形式,这也促进了BGNN的矩阵级实现。双线性聚合器的矩阵形式为:

其中,

-

- 存储所有节点的表示向量 ;

- 是图的邻接矩阵;

- 是一个单位矩阵;

- 是一个对角矩阵,且 ;

- 表示两个矩阵的逐元素乘法;

设 是置换矩阵(permutation matrix) 满足:

-

- 对于任何矩阵 ,如果 存在,则满足 。

当我们在节点上应用排列 时, 变为 , 变为 , 变为 ,这导致:

上述说明了它表示了排列不变性。

2.3 BGNN Model

我们现在来描述所提出的BGNN模型。由于双线性聚合器强调节点交互,并使用加权和聚合器对不同的信号进行编码,我们将它们结合起来,构建一个更具表现性的图卷积网络。我们采用了一个简单的线性组合方案,定义了一个新的图卷积算子为:

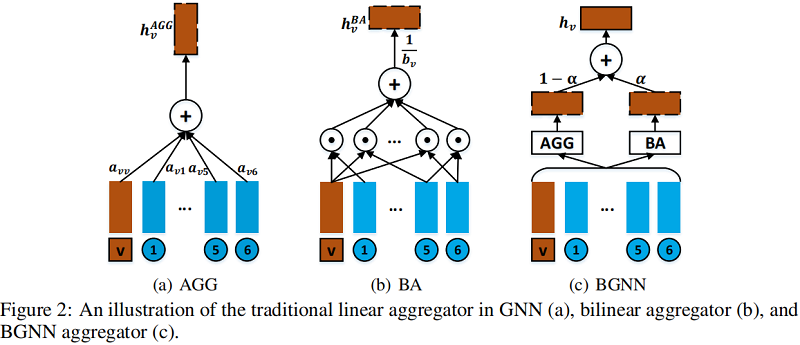

Figure 2 说明了模型框架。

由于 AGG 和 BA 都是置换不变的,所以发现这个图卷积算子也是置换不变的是平凡的。当 设置为 时,不考虑节点交互,BGNN降级为GNN;当 设置为 时,BGNN只使用双线性聚合器来处理来自邻居的信息。我们的实证研究表明,在 和 之间的中间值通常可以导致更好的性能,验证了建模节点交互的有效性,并且最优设置在不同的数据集上有所不同。

2.4 Multi-layer BGNN

传统的GNN模型通过堆叠多个聚合器,以递归的方式对来自多跳邻居的信息进行编码。例如, 层的 GNN 模型被形式化为:

其中 是一个非线性激活函数。类似地,我们也可以以相同的递归方式设计一个 层的 BGNN 模型:

然而,这种直接的多层扩展涉及到意外的高阶交互。在两层的情况下,第二层的表示将包括两跳邻居之间的部分四阶交互作用,这是难以解释和不合理的。当将BGNN扩展到多层,即 层时,我们仍然希望捕获成对的交互,但在 跳邻居之间。为此,我们不是直接叠加BGNN层,而是将 层BGNN模型定义为:

其中, 存储了图的 跳连接性。 将非零条目转换为 。因此, 中的非零条目 意味着节点 可以在两跳内到达节点 。 是一个超参数,可以权衡 跳邻居和 跳邻居之间的双线性相互作用的强度。

按照同样的原理,我们将BGNN层BGNN定义为:

表示 跳连接性的邻接矩阵, 表示可以递归定义的正常 层 GNN。 层 BGNN 的时间复杂度由 中非零条目的数量决定。为了降低实际的复杂性,我们可以遵循 GraphSage 中的采样策略,采样部分高跳邻居,而不是使用所有的邻居。

Model Training

BGNN是一个可微分模型,因此它可以对具有梯度下降的任何差分损失进行端到端优化。在这项工作中,我们关注半监督节点分类任务,在标记节点上使用交叉熵损失优化BGNN(与GCN工作相同的设置,以进行公平的比较)。由于实验数据不大,我们以矩阵形式实现了层图卷积,将可以扩展到大图的批实现和邻居采样作为未来的工作。

3 Experiments

数据集

每个节点都有一个具有文档类别的一个 one-hot 的标签。我们在以前的工作中使用了相同的数据分割。也就是说,每个类使用 20 个有标记的节点用于训练。使用 500 个节点和 1000个节点分别作为验证集和测试集。请注意,训练进程可以使用所有节点的特性。对于这个数据分割,我们报告了超过 10 个不同的随机初始化的平均测试精度。

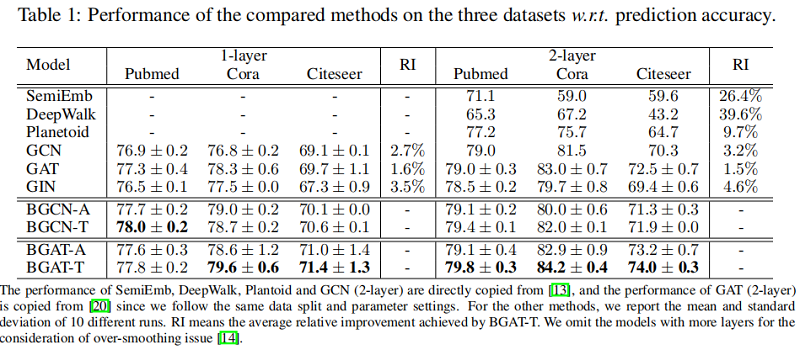

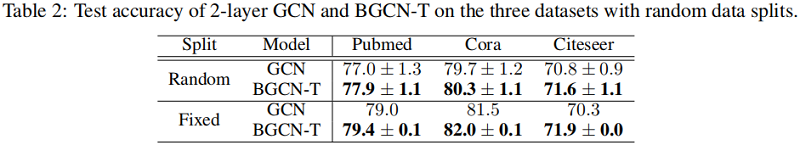

半监督节点分类

4 Conclusion

在本文中,我们提出了一种新的图神经网络框架BGNN,它通过考虑邻居节点之间的相互作用来增强普通GNN的表达性。邻居节点的交互被一个简单但精心设计的双线性聚合器捕获。双线性聚合器的简单性使得BGNN具有与普通GNNw.r.t.相同的模型复杂度可学习参数的数量和分析的时间复杂度。此外,证明了双线性聚合器是置换不变的,这是GNN聚合器[9,27]的一个重要性质。我们将所提出的BGNN应用于半监督节点分类任务,在三个基准数据集上取得了最先进的性能。

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/16275593.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· DeepSeek在M芯片Mac上本地化部署