论文信息

论文标题:Attributed Graph Clustering: A Deep Attentional Embedding Approach

论文作者:Chun Wang, Shirui Pan, Ruiqi Hu, Guodong Long, Jing Jiang, Chengqi Zhang

论文来源:2019, IJCAI

论文地址:download

论文代码:download

1 Introduction

研究现状:目前的图表示学习方法都是两阶段方法,且融合结构和属性信息的机制并不完美。

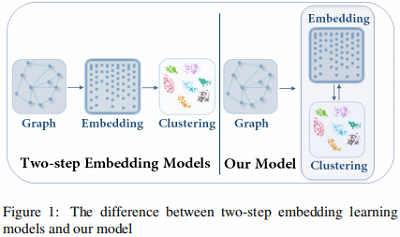

本文模型与传统的 方法的比较如 Figure 1 所示:

- 本文模型是将 节点表示 和 聚类 放在一个统一的框架中学习。

- 方法则是先学习 ,然后进行聚类。

2 Method

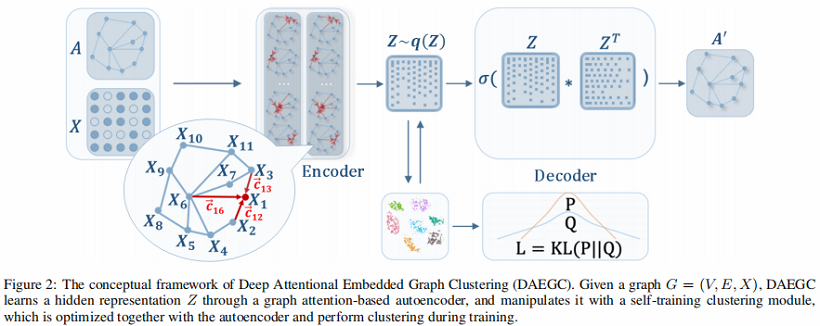

总体框架:

组成部分:

-

- Graph Attentional Autoencoder

- Self-training Clustering

2.1 Graph Attentional Autoencoder

2.1.1 GAT encoder

首先:衡量 的邻居 对于节点 的影响,采用图注意力机制:

其中: is the attention coefficient that indicates the importance of neighbor node to node ;

对于注意力系数 主要参考两个方面:

- 属性值(attribute values) ;

- 拓扑距离( topological distance );

Aspact 1:属性值

注意力系数 可以表示为 由 和 拼接形成的单层前馈神经网络:

其中:

-

- 是权重向量;

Aspact 2:拓扑距离

考虑节点高阶邻居信息(指 邻居),得到 :

其中:

-

- 是转移矩阵(transition matrix),当 有边相连,那么 ,否则 。

- 表示 和 的 阶内的拓扑相关性。如果 和 存在邻居关系( 阶之内),那么 。

对节点 的领域做标准化,采用 :

将 中 及 中的 带入 ,那么 系数可以表示为:

其中,激活函数 采用 ;

本文堆叠 个 :

通过上述图注意力编码器,得到最终的 。

2.1.2 Inner product decoder

解码器为 ,用于重构图:

其中:

-

- 是重建后的图结构矩阵;

2.1.3 Reconstruction loss

最小化 和 的重构错误:

2.2 Self-optimizing Embedding

除优化重构误差外,还将 隐表示 输入一个自优化聚类模块,该模块最小化以下目标:

其中:

-

- 度量隐表示 和聚类中心 之间的相似性,本文通过 Student's t-distribution 度量;

- 代表目标分布;

聚类损失迫使当前分布 接近目标分布 。

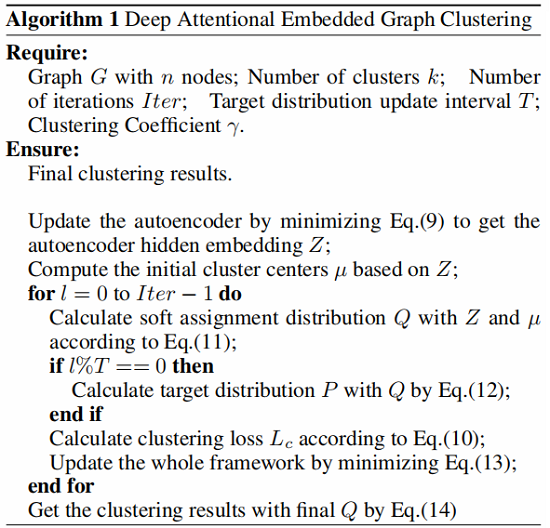

算法概述

-

- 首先使用没有用 selfoptimize clustering part 的自编码器获得初始 embedding ;

- 其次为计算 Eq.11 ,先使用 获得初始聚类中心

- 然后根据 使用 SGD 进行优化更新 和 。

需要注意的是 : 每 个 iteration 更新一次, 每个 iteration 更新一次。

算法步骤:

2.3 Joint Embedding and Clustering Optimization

联合优化 自编码器的重构损失 和 聚类损失,总目标函数为:

其中:

-

- 代表着重构损失;

- 代表着聚类损失 ;

最终 的 软标签 通过 获得:

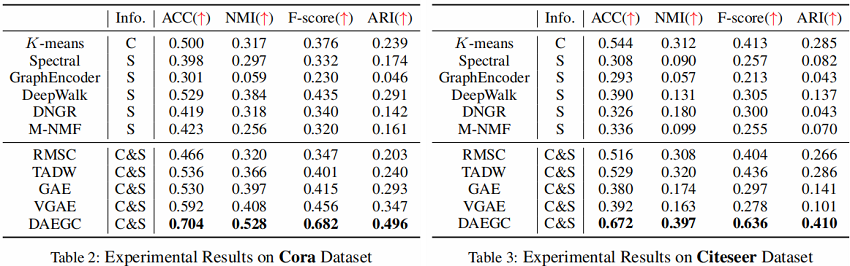

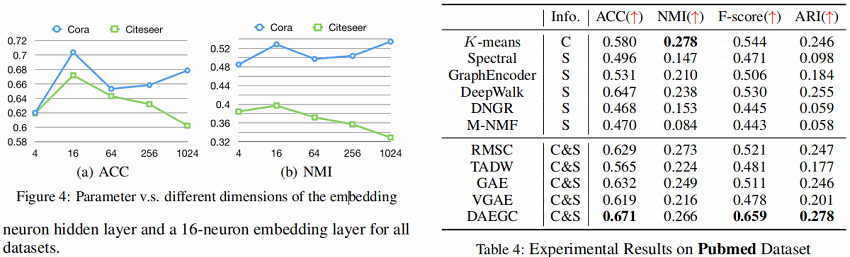

3 Experiments

4 Conclusion

贡献:

- 使用考虑了长距离结构信息图注意力网络的编码器;

- 采用内积重构邻接矩阵做;

修改历史

2022-02-19 创建文章

2022-06-09 修订文章

因上求缘,果上努力~~~~ 作者:别关注我了,私信我吧,转载请注明原文链接:https://www.cnblogs.com/BlairGrowing/p/15908418.html

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· C#/.NET/.NET Core技术前沿周刊 | 第 29 期(2025年3.1-3.9)

· 从HTTP原因短语缺失研究HTTP/2和HTTP/3的设计差异