引入 聚类算法一般可以分为两类:

Compactness。代表的算法有 K-means,GMM 等。但这类算法只能处理凸集,为了处理非凸的样本集,必须引⼊核技巧。 Connectivity。这类以 spectral clustering 为代表。

举个例子,将下述数据采用聚类算法进行聚类,可以采用 GMM 或 K-Means 的方法:

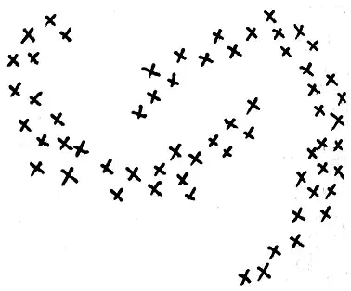

然而对于下述数据却并不能使用上述两种算法:

此时可以考虑采用谱聚类(spectral clustering)的方法。

谱聚类算法(Spectral Clustering)

主要思想是把所有的数据看做空间中的点,这些点之间可以用边连接起来。距离较远的两个点之间的边权重值较低,而距离较近的两个点之间的边权重值较高,通过对所有数据点组成的图进行切图,让切图后不同的子图间边权重和尽可能的低,而子图内的边权重和尽可能的高,从而达到聚类的目的。

1 基础知识 1.1 无向带权图 对于一个图 G G V V E E G ( V , E ) G ( V , E ) V = ( v 1 , v 2 , . . . v n ) V = ( v 1 , v 2 , . . . v n ) V V w i j w i j v i v i v j v j w i j = w j i w i j = w j i

权重:对于有边相连的两个点 v i v i v j v j w i j > 0 w i j > 0 v i v i v j v j w i j = 0 w i j = 0

度:对于图中的任意一个点 v i v i d i d i

d i = n ∑ j = 1 w i j d i = ∑ j = 1 n w i j

利用节点的权重值,可以得到图的邻接矩阵 W W n × n n × n i i j j w i j w i j

除此之外,对于点集 V V A ⊂ V A ⊂ V

| A | := 子 集 A 中 点 的 个 数 | A | := 子 集 A 中 点 的 个 数 v o l ( A ) := ∑ i ∈ A d i v o l ( A ) := ∑ i ∈ A d i

利用每个节点的度,可以得到一个 n × n n × n D D i i i 个 i 个

D = ⎛ ⎜

⎜

⎜

⎜

⎜ ⎝ d 1 … … … d 2 … ⋮ ⋮ ⋱ … … d n ⎞ ⎟

⎟

⎟

⎟

⎟ ⎠ D = ( d 1 … … … d 2 … ⋮ ⋮ ⋱ … … d n )

1.2 相似矩阵 一般情况下,邻接矩阵 W W

基本思想:距离较远的两个点之间的边权重值较低,而距离较近的两个点之间的边权重值较高。一般来说,可以通过样本点距离度量的相似矩阵 S S W W

构建邻接矩阵 W W

ϵ ϵ K K 全连接法

1.2.1 ϵ ϵ 首先,设置一个距离阈值 ϵ ϵ s i j s i j x i x i x j x j s i j = | | x i − x j | | 2 2 s i j = | | x i − x j | | 2 2 s i j s i j ϵ ϵ W W

w i j = { 0 s i j > ϵ ϵ s i j ≤ ϵ w i j = { 0 s i j > ϵ ϵ s i j ≤ ϵ

从上式可见,两点间的权重要不是 ϵ ϵ 0 0 ϵ ϵ

1.2.2 K K 基本思想:利用 KNN 算法遍历所有的样本点,取每个样本最近的 k k k k w i j > 0 w i j > 0

但是这种方法会造成重构之后的邻接矩阵 W W

Method1: K K K K s i j s i j

w i j = w j i = { 0 x i ∉ K N N ( x j ) a n d x j ∉ K N N ( x i ) e x p ( − | | x i − x j | | 2 2 2 σ 2 ) x i ∈ K N N ( x j ) o r x j ∈ K N N ( x i ) w i j = w j i = { 0 x i ∉ K N N ( x j ) a n d x j ∉ K N N ( x i ) e x p ( − | | x i − x j | | 2 2 2 σ 2 ) x i ∈ K N N ( x j ) o r x j ∈ K N N ( x i )

Method2: K K K K s i j s i j

w i j = w j i = { 0 x i ∉ K N N ( x j ) o r x j ∉ K N N ( x i ) e x p ( − | | x i − x j | | 2 2 2 σ 2 ) x i ∈ K N N ( x j ) a n d x j ∈ K N N ( x i ) w i j = w j i = { 0 x i ∉ K N N ( x j ) o r x j ∉ K N N ( x i ) e x p ( − | | x i − x j | | 2 2 2 σ 2 ) x i ∈ K N N ( x j ) a n d x j ∈ K N N ( x i )

1.2.3 全连接法 相比前两种方法,第三种方法所有的点之间的权重值都大于 0 0

基本思想:选择不同的核函数来定义边权重,常用的有多项式核函数 ,高斯核函数 和 Sigmoid 核函数 。

最常用的是高斯核函数RBF,此时相似矩阵和邻接矩阵相同:

w i j = s i j = e x p ( − | | x i − x j | | 2 2 2 σ 2 ) w i j = s i j = e x p ( − | | x i − x j | | 2 2 2 σ 2 )

在实际的应用中,使用第三种全连接法来建立邻接矩阵是最普遍的,而在全连接法中使用高斯径向核 RBF 是最普遍的。

2 拉普拉斯矩阵 拉普拉斯矩阵 L = D − W L = D − W D D W W 《图神经网络基础二:谱图理论》 )

举例:

普拉斯矩阵的性质如下:

1、 拉普拉斯矩阵是 对称矩阵;

2、 L L

3、 L L

4、L L

5、 对于任意向量 f f

f T L f = 1 2 N ∑ i = 1 N ∑ j = 1 w i j ( f i − f j ) 2 f T L f = 1 2 ∑ i = 1 N ∑ j = 1 N w i j ( f i − f j ) 2

这一性质利用拉普拉斯矩阵的性质很容易可以得到:

f T L f = f T D f − f T W f = N ∑ i = 1 d i f 2 i − N ∑ i = 1 N ∑ j = 1 w i j f i f j = 1 2 ( N ∑ i = 1 d i f 2 i − 2 N ∑ i = 1 N ∑ j = 1 w i j f i f j + N ∑ j = 1 d j f 2 j ) = 1 2 ( N ∑ i = 1 N ∑ j = 1 w i j f 2 i − 2 N ∑ i = 1 N ∑ j = 1 w i j f i f j + N ∑ i = 1 N ∑ j = 1 w i j f 2 j ) = 1 2 N ∑ i = 1 N ∑ j = 1 w i j ( f i − f j ) 2 f T L f = f T D f − f T W f = ∑ i = 1 N d i f i 2 − ∑ i = 1 N ∑ j = 1 N w i j f i f j = 1 2 ( ∑ i = 1 N d i f i 2 − 2 ∑ i = 1 N ∑ j = 1 N w i j f i f j + ∑ j = 1 N d j f j 2 ) = 1 2 ( ∑ i = 1 N ∑ j = 1 N w i j f i 2 − 2 ∑ i = 1 N ∑ j = 1 N w i j f i f j + ∑ i = 1 N ∑ j = 1 N w i j f j 2 ) = 1 2 ∑ i = 1 N ∑ j = 1 N w i j ( f i − f j ) 2

对于上面的性质5,如果 f f f T L f f T L f

3 无向图切图 对于无向图 G G G ( V , E ) G ( V , E ) k k A 1 , A 2 , . . A k A 1 , A 2 , . . A k A i ∩ A j = ∅ A i ∩ A j = ∅ A 1 ∪ A 2 ∪ . . . ∪ A k = V A 1 ∪ A 2 ∪ . . . ∪ A k = V

对于任意两个子图点集合 A , B ⊂ V A , B ⊂ V A ∩ B = ∅ A ∩ B = ∅ A A B B

W ( A , B ) = ∑ i ∈ A , j ∈ B w i j W ( A , B ) = ∑ i ∈ A , j ∈ B w i j

那么对于 k k A 1 , A 2 , . . A k A 1 , A 2 , . . A k

c u t ( A 1 , A 2 , . . . A k ) = 1 2 k ∑ i = 1 W ( A i , ¯ ¯¯ ¯ A i ) c u t ( A 1 , A 2 , . . . A k ) = 1 2 ∑ i = 1 k W ( A i , A ¯ i )

其中 ¯ ¯¯ ¯ A i A ¯ i A i A i A i A i V V

每个子图就相当于聚类的一个类,找到子图内点的权重之和最高,子图间的点的权重之和最低的切图就相当于找到了最佳的聚类。实现这一点的一个很自然的想法是最小化 c u t c u t c u t c u t

在上面的例子中,我们选择一个权重最小的边缘的点,比如 C C H H c u t c u t c u t ( A 1 , A 2 , . . . A k ) c u t ( A 1 , A 2 , . . . A k )

接下介绍谱聚类使用的切图方法。

4 谱聚类之切图聚类 为避免最小切图导致的切图效果不佳,需要对每个子图的规模做出限定,一般来说,有两种切图方式,

第一种是 RatioCut 第二种是 Ncut

4.1 RatioCut 切图 RatioCut 切图为避免上述的最小切图,对每个切图,不光考虑最小化 c u t ( A 1 , A 2 , . . . A k ) c u t ( A 1 , A 2 , . . . A k )

R a t i o C u t ( A 1 , A 2 , . . . A k ) = 1 2 k ∑ i = 1 W ( A i , ¯ ¯¯ ¯ A i ) | A i | R a t i o C u t ( A 1 , A 2 , . . . A k ) = 1 2 ∑ i = 1 k W ( A i , A ¯ i ) | A i |

为最小化这个 RatioCut 函数,引入指示向量 h j ∈ { h 1 , h 2 , . . h k } j = 1 , 2 , . . . k h j ∈ { h 1 , h 2 , . . h k } j = 1 , 2 , . . . k h j h j n n n n h i j h i j

h i j = { 0 v i ∉ A j 1 √ | A j | v i ∈ A j h i j = { 0 v i ∉ A j 1 | A j | v i ∈ A j

定义 h T i L h i h i T L h i

h T i L h i = 1 2 ∑ m = 1 ∑ n = 1 w m n ( h i m − h i n ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n ( 1 √ | A i | − 0 ) 2 + ∑ m ∉ A i , n ∈ A i w m n ( 0 − 1 √ | A i | ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n 1 | A i | + ∑ m ∉ A i , n ∈ A i w m n 1 | A i | = 1 2 ( c u t ( A i , ¯ ¯¯ ¯ A i ) 1 | A i | + c u t ( ¯ ¯¯ ¯ A i , A i ) 1 | A i | ) = c u t ( A i , ¯ ¯¯ ¯ A i ) | A i | h i T L h i = 1 2 ∑ m = 1 ∑ n = 1 w m n ( h i m − h i n ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n ( 1 | A i | − 0 ) 2 + ∑ m ∉ A i , n ∈ A i w m n ( 0 − 1 | A i | ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n 1 | A i | + ∑ m ∉ A i , n ∈ A i w m n 1 | A i | = 1 2 ( c u t ( A i , A ¯ i ) 1 | A i | + c u t ( A ¯ i , A i ) 1 | A i | ) = c u t ( A i , A ¯ i ) | A i |

可以看出,对于某一个子图 i i RatioCut 对应于 h T i L h i h i T L h i k k RatioCut 函数表达式为:

R a t i o C u t ( A 1 , A 2 , … A k ) = k ∑ i = 1 h T i L h i = k ∑ i = 1 ( H T L H ) i i = tr ( H T L H ) R a t i o C u t ( A 1 , A 2 , … A k ) = ∑ i = 1 k h i T L h i = ∑ i = 1 k ( H T L H ) i i = tr ( H T L H )

上式中 tr ( H T L H ) tr ( H T L H ) H T L H H T L H H = ( h 1 h 2 ⋯ h k ) H = ( h 1 h 2 ⋯ h k ) H H H T H = I H T H = I H H 0 0 1 | A i | 1 | A i |

所以我们需要优化以下目标函数:

argmin H tr ( H T L H ) s.t. H T H = I argmin H tr ( H T L H ) s.t. H T H = I

注意到 H H n n 0 0 1 √ | A j | 1 | A j | 2 n 2 n k k k k k 2 n k 2 n H H H H N P N P

观察到 t r ( H T L H ) t r ( H T L H ) h T i L h i h i T L h i h h L L h T i L h i h i T L h i L L L L L L

对于 h T i L h i h i T L h i L L t r ( H T L H ) = k ∑ i = 1 h T i L h i t r ( H T L H ) = ∑ i = 1 k h i T L h i k k k k n n n n k k

通过找到 L L k k k k k k n x k n x k H H H H

h ∗ i j = h i j ( k ∑ t = 1 h 2 i t ) 1 / 2 h i j ∗ = h i j ( ∑ t = 1 k h i t 2 ) 1 / 2

由于我们在使用维度规约的时候损失了少量信息,导致得到的优化后的指示向量 h h H H n × k n × k H H K-Means 聚类。

4.2 Ncut 切图 Ncut 切图和 RatioCut 切图很类似,但是把 Ratiocut 的分母 | A i | | A i | v o l ( A i ) v o l ( A i ) Ncut 切图优于 RatioCut 切图。 N C u t ( A 1 , A 2 , . . . A k ) = 1 2 k ∑ i = 1 W ( A i , ¯ ¯¯ ¯ A i ) v o l ( A i ) N C u t ( A 1 , A 2 , . . . A k ) = 1 2 ∑ i = 1 k W ( A i , A ¯ i ) v o l ( A i )

对应的,Ncut 切图对指示向量 h h RatioCut 切图的指示向量使用的是 1 √ | A j | 1 | A j | Ncut 切图使用了子图权重 1 √ v o l ( A j ) 1 v o l ( A j ) h h

h i j = { 0 v i ∉ A j 1 √ v o l ( A j ) v i ∈ A j h i j = { 0 v i ∉ A j 1 v o l ( A j ) v i ∈ A j

那么我们对于 h T i L h i h i T L h i

h T i L h i = 1 2 ∑ m = 1 ∑ n = 1 w m n ( h i m − h i n ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n ( 1 √ v o l ( A i ) − 0 ) 2 + ∑ m ∉ A i , n ∈ A i w m n ( 0 − 1 √ v o l ( A i ) ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n 1 v o l ( A i ) + ∑ m ∉ A i , n ∈ A i w m n 1 v o l ( A i ) = 1 2 ( c u t ( A i , ¯ ¯¯ ¯ A i ) 1 v o l ( A i ) + c u t ( ¯ ¯¯ ¯ A i , A i ) 1 v o l ( A i ) ) = c u t ( A i , ¯ ¯¯ ¯ A i ) v o l ( A i ) h i T L h i = 1 2 ∑ m = 1 ∑ n = 1 w m n ( h i m − h i n ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n ( 1 v o l ( A i ) − 0 ) 2 + ∑ m ∉ A i , n ∈ A i w m n ( 0 − 1 v o l ( A i ) ) 2 = 1 2 ( ∑ m ∈ A i , n ∉ A i w m n 1 v o l ( A i ) + ∑ m ∉ A i , n ∈ A i w m n 1 v o l ( A i ) = 1 2 ( c u t ( A i , A ¯ i ) 1 v o l ( A i ) + c u t ( A ¯ i , A i ) 1 v o l ( A i ) ) = c u t ( A i , A ¯ i ) v o l ( A i )

推导方式和 RatioCut 完全一致。也就是说,我们的优化目标仍然是

NCut ( A 1 , A 2 , ⋯ , A k ) = k ∑ i = 1 h T i L h i = k ∑ i = 1 ( H T L H ) i i = tr ( H T L H ) NCut ( A 1 , A 2 , ⋯ , A k ) = ∑ i = 1 k h i T L h i = ∑ i = 1 k ( H T L H ) i i = tr ( H T L H )

但是此时我们的 H T H ≠ I H T H ≠ I H T D H = I H T D H = I

H T D H = ⎛ ⎜

⎜

⎜

⎜

⎜ ⎝ h T 1 h T 2 ⋮ h T k ⎞ ⎟

⎟

⎟

⎟

⎟ ⎠ ⎛ ⎜

⎜

⎜

⎜

⎜ ⎝ d 1 d 2 ⋱ d N ⎞ ⎟

⎟

⎟

⎟

⎟ ⎠ ( h 1 h 2 ⋯ h k ) = ⎛ ⎜

⎜

⎜

⎜

⎜ ⎝ h 11 d 1 h 12 d 2 ⋯ h 1 N d N h 21 d 1 h 22 d 2 ⋯ h 2 N d N ⋮ ⋮ ⋱ ⋮ h k 1 d 1 h k 2 d 2 ⋯ h k N d N ⎞ ⎟

⎟

⎟

⎟

⎟ ⎠ ( h 1 h 2 ⋯ h k ) = ⎛ ⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜

⎜ ⎝ N ∑ i = 1 h 2 1 i d i N ∑ i = 1 h 1 i h 2 i d i ⋯ N ∑ i = 1 h 1 i h k i j d i N ∑ i = 1 h 2 i h 1 i d i N ∑ i = 1 h 2 2 i d i ⋯ N ∑ i = 1 h 2 i h k i d i ⋮ ⋮ ⋱ ⋮ N ∑ i = 1 h k i h 1 i d i N ∑ i = 1 h k i h 2 i d i ⋯ N ∑ i = 1 h 2 k i d i ⎞ ⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟

⎟ ⎠ H T D H = ( h 1 T h 2 T ⋮ h k T ) ( d 1 d 2 ⋱ d N ) ( h 1 h 2 ⋯ h k ) = ( h 11 d 1 h 12 d 2 ⋯ h 1 N d N h 21 d 1 h 22 d 2 ⋯ h 2 N d N ⋮ ⋮ ⋱ ⋮ h k 1 d 1 h k 2 d 2 ⋯ h k N d N ) ( h 1 h 2 ⋯ h k ) = ( ∑ i = 1 N h 1 i 2 d i ∑ i = 1 N h 1 i h 2 i d i ⋯ ∑ i = 1 N h 1 i h k i j d i ∑ i = 1 N h 2 i h 1 i d i ∑ i = 1 N h 2 i 2 d i ⋯ ∑ i = 1 N h 2 i h k i d i ⋮ ⋮ ⋱ ⋮ ∑ i = 1 N h k i h 1 i d i ∑ i = 1 N h k i h 2 i d i ⋯ ∑ i = 1 N h k i 2 d i )

对于对角线元素

h T i D h i = n ∑ j = 1 h 2 i j d j = 1 v o l ( A i ) ∑ j ∈ A i d j = 1 v o l ( A i ) v o l ( A i ) = 1 h i T D h i = ∑ j = 1 n h i j 2 d j = 1 v o l ( A i ) ∑ j ∈ A i d j = 1 v o l ( A i ) v o l ( A i ) = 1

由于 h m i h m i h n i h n i 同时非零 (v i ∈ V m a n d v i ∈ V n v i ∈ V m a n d v i ∈ V n

N ∑ i = 1 h m i h n i d i = N ∑ i = 1 0 ⋅ d i = 0 ∑ i = 1 N h m i h n i d i = ∑ i = 1 N 0 ⋅ d i = 0

此时我们的优化目标最终为:

a r g m i n H t r ( H T L H ) s . t . H T D H = I a r g m i n H t r ( H T L H ) s . t . H T D H = I

此时我们的 H H h h H H

我们令H = D − 1 / 2 F H = D − 1 / 2 F

H T L H = F T D − 1 / 2 L D − 1 / 2 F H T L H = F T D − 1 / 2 L D − 1 / 2 F

H T D H = F T F = I H T D H = F T F = I

此时优化目标为:

a r g m i n F tr ( F T D − 1 / 2 L D − 1 / 2 F ) s.t. F T F = I a r g m i n F tr ( F T D − 1 / 2 L D − 1 / 2 F ) s.t. F T F = I

可以发现这个式子和 RatioCut 基本一致,只是中间的 L L D − 1 / 2 L D − 1 / 2 D − 1 / 2 L D − 1 / 2 D − 1 / 2 L D − 1 / 2 D − 1 / 2 L D − 1 / 2 k k F F F F

一般来说, D − 1 / 2 L D − 1 / 2 D − 1 / 2 L D − 1 / 2 L L

( D − 1 / 2 L D − 1 / 2 ) i j = L i j √ d i ∗ d j ( D − 1 / 2 L D − 1 / 2 ) i j = L i j d i ∗ d j

5 谱聚类算法流程 5.1 Ncut 谱聚类算法流程 下面 Ncut 谱聚类算法流程。

输入:样本集D=( x 1 , x 2 , . . . , x n ) ( x 1 , x 2 , . . . , x n ) k 1 k 1 k 2 k 2

输出: 簇划分C ( c 1 , c 2 , . . . c k 2 ) C ( c 1 , c 2 , . . . c k 2 )

根据输入的相似矩阵的生成方式构建样本的相似矩阵 S S 根据相似矩阵 S S W W D D 计算出拉普拉斯矩阵 L L 构建标准化后的拉普拉斯矩阵D − 1 / 2 L D − 1 / 2 D − 1 / 2 L D − 1 / 2 计算D − 1 / 2 L D − 1 / 2 D − 1 / 2 L D − 1 / 2 k 1 k 1 f f 将各自对应的特征向量f f n × k 1 n × k 1 F F 对 F F k 1 k 1 n n k 2 k 2 得到簇划分C ( c 1 , c 2 , . . . c k 2 ) C ( c 1 , c 2 , . . . c k 2 )

5.2 谱聚类算法的优缺点 谱聚类算法的主要优点有:

谱聚类只需要数据之间的相似度矩阵,因此对于处理稀疏数据的聚类很有效。这点传统聚类算法比如K-Means很难做到 由于使用了降维,因此在处理高维数据聚类时的复杂度比传统聚类算法好。

谱聚类算法的主要缺点有:

如果最终聚类的维度非常高,则由于降维的幅度不够,谱聚类的运行速度和最后的聚类效果均不好。 聚类效果依赖于相似矩阵,不同的相似矩阵得到的最终聚类效果可能很不同。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix