『数学记录』概率导论学习笔记(一):样本空间与概率

updated at 2024/02/22:加入了2.8概率空间的内容。

观前提醒:本文概率的定义含不由测度论出发的内容,如不想观看请酌情跳过。本文为Dimitri P.Bertsekas与John N. Tsitsiklis所著的《概率导论》的学习笔记。

概率导论笔记的第一篇文章。

概率是用计算概括的常识。

——拉普拉斯

Part1 集合

在概率论中,集合论的应用是极为重要的,许多问题的处理都需要集合运算。下面首先引进集合相关的记号与术语。

将一些研究对象放在一起,形成 集合 ,而这些对象就称为集合的 元素 。若 \(x\) 是集合 \(S\) 的元素,则称作 \(x\) 属于 \(S\) ,记作 \(x \in S\) ;反之则不属于,记作 \(x \not\in S\) 。一个集合可以没有元素,这个特殊的集合称为 空集 ,记作 \(\varnothing\) 。

集合一般有两种方式刻画,第一种是将集合的元素列在花括号中:

另一种则是以 \(x\) 具有的某种性质 \(P\) 来刻画,记作:

接下来是 可数 与 不可数 。简单来说,一个集合是可数的,但且仅当这个集合的元素是有限的或元素是无限的但可以用一定的顺序排列,而不可数的集合就不是。就比如有理集是可数的,因为它可以用最简分数的分子分母之和从小到大排列,而不是可数的实数集就无法用什么顺序排列。

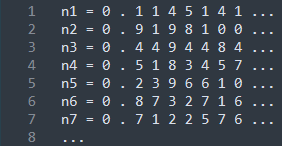

题外话:康托尔曾在1891年用反证法证明了实数集不可数:假设有一种排列方法可以列出0到1间的所有实数 \(n\) ,举例如下:

那么现在就可以构造出一个数,它的小数点后第 \(x\) 位的数字为任意与 \(n_x\) 不同的一个数字:

这个数与列表中每一个数都至少有一位不同,即这个数不在列表中,从而得证实数集不可数。

回到正题,若集合 \(S\) 的元素全部是集合 \(T\) 的元素,那么我们称 \(S\) 为 \(T\) 的 子集 ,本系列将记作 \(S \subseteq T\) 或 \(T \supseteq S\) 。若 \(S \subseteq T\) 且 \(T \subseteq S\) ,则称两个集合 相等 。为了在之后进行概率相关的计算,我们十分有必要引入空间的概念。将我们感兴趣的所有元素放在一起,形成一个集合,这个集合叫做 空间 ,记作 \(\Omega\) 。当 \(\Omega\) 确定后,我们讨论的所有集合 \(S\) 都是 \(\Omega\) 的子集。

1.1 集合运算

集合 \(\{x\in\Omega | x\not\in S\}\) 称为集合 \(S\) 相对于 \(\Omega\) 的 补集 ,记作 \(S^c\) 。注意 \(\Omega^c = \varnothing\) 。

由属于 \(S\) 或属于 \(T\) 的元素构成的集合称为 \(S\) 与 \(T\) 的 并 。既属于 \(S\) 又属于 \(T\) 的元素构成的集合称为 \(S\) 与 \(T\) 的 交 。这些集合可以用下列公式刻画:

(有些资料或文章会将在表示交时会将 \(\cap\) 省略掉,但本系列会保留)

有时候我们需要考虑几个甚至无穷个集合的交和并的问题。此时我们会是用下面的记号:

两个集合称为 不相交 的,如果它们的交集为空集。更一般地,如果几个集合中的任意两个集合没有公共元素,那么这些集合称为 互不相交 的。如果一组集合中的集合互不相交,且它们的并为 \(S\) ,那么这组集合称为集合 \(S\) 的 分割 。

设 \(x\) 和 \(y\) 为两个研究对象,我们用 \((x, y)\) 表示 \(x\) 和 \(y\) 的 有序对 。我们用 \(\mathbf R\) 表示实数集合,用 \(\mathbf R^2\) 表示实数对的集合,即二维平面,用 \(\mathbf R^n\) 表示 \(n\) 维实数向量的集合( \(n\) 维空间)。

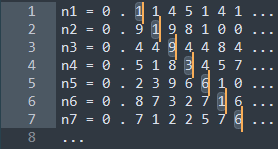

集合及其运算可用 维恩图 形象化表示:

(其中 (a) 的阴影部分是 \(S\cap T\) , (b) 的阴影部分是 \(S\cup T\) , (c) 的阴影部分是 \(S\cap T^c\) , (d) 表示 \(T\subseteq S\) ,阴影部分为 \(S^c\) , (e) 中 \(S,T,U\) 互不相交, (f) 中 \(S,T,U\) 形成 \(\Omega\) 的一个分割)

1.2 集合代数

集合运算拥有许多性质,可有集合运算的定义直接证得。下面举出一些例子:

下面给出著名的 De Morgan 定律 :

关于第一个公式的证明,设 \(x\in(\cup_nS_n)^c\) ,这说明 \(x\not\in \cup_nS_n\) ,即对一切 \(n\) , \(x\not\in S_n\) 。因而,对于一切 \(n\) ,\(x\in S_n^c\) ,即 \(x\in \cap_nS_n^c\) 。这样就得到 \((\cup_nS_n)^c\subseteq\cap_nS_n^c\) ,而反过来包含的证明只需倒推就行了。第二个公式证明类似。

有了以上的集合基础,我们便可以开始进入概率相关的内容了。

Part2 概率模型

概率模型是对不确定现象的数学描述。下面是它的两个基本构成:

概率模型的基本构成

- 样本空间 \(\Omega\) ,这是一个试验所有可能结果的集合。

- 概率律 ,概率律为试验结果的集合 \(A\) (称为 事件)确定一个数 \(P(A)\) (称为事件 \(A\) 的概率)。

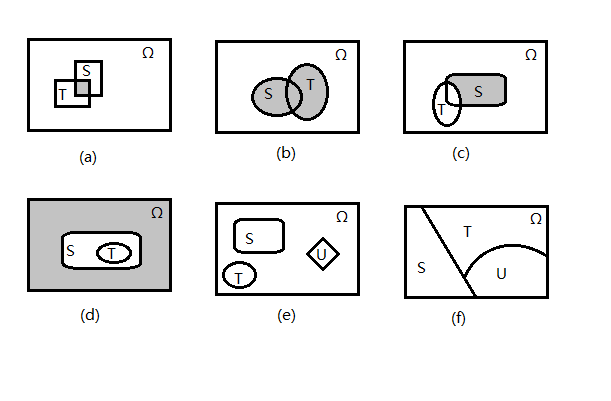

下图较为形象地展示了概率模型的构成。

2.1 样本空间、事件与样本空间的选择

每一个概率模型都关联着一个 试验 ,该试验的所有可能结果形成 样本空间 ,样本空间的子集则称为 事件 ,一般用 \(\Omega\) 表示样本空间。

一个试验由什么组成并没有严格限定,但是每个概率模型的问题中只设计一个试验,例如连续投三次骰子只能看做一个试验,不能认为是三个试验。

样本空间可以是可数的,就好比投骰子,但不可数的样本空间[1]也非常常见,就比如往靶子上扔飞镖,把飞镖的落点作为试验结果。

在确定样本空间的时候,不同的试验结果必须是 互相排斥 的,在抛硬币中,我们不能将类似“ \(1\) 或 \(4\) ”与“ \(1\) 或 \(5\) ”定义为一个结果,否则我们将无法得知投到 \(1\) 时是什么结果。

在确定样本空间时,我们可以根据不同的侧重点确定不同的模型。但是确定模型时,不能遗漏试验中有可能发生的任何结果,即试验无论发生什么情况,总能得到样本空间中的一个结果。在建立样本空间时,足够的细节可以帮助我们区分不同的事件,以避免不必要的麻烦。

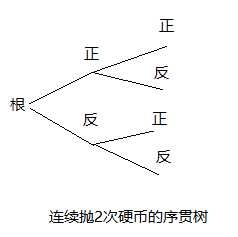

2.2 序贯模型

许多试验具有序贯的特征(即试验或观察是连续多次的),可以用序贯树的方式刻画样本空间中的试验结果,这里不加赘述。

2.3 概率律

在2.1中我们已经确定了试验与样本空间 \(\Omega\) 的联系,那么接下来我们就要引入 概率律 的概念来完成概率模型的建立。直观上,它确定了任何结果或事件的释然程度。更具体地,它给每一个事件 \(A\) 确定了一个数 \(P(A)\) ,称为事件 \(A\) 的 概率 。概率 \(P(A)\) 满足下面的几条公理:

概率公理

- (非负性)对一切事件 \(A\) ,满足

- (可加性)设 \(A\) 和 \(B\) 为两个互不相交的集合(概率论中称为互不相容的事件),则它们的并满足

- (归一化)整个样本空间 \(\Omega\)(称为必然事件)的概率为 \(1\) ,即

概率律一种直观但并不那么准确的解释是频率,表示在大量重复试验中事件 \(A\) 出现的概率为 \(P(A)\) 。在之后的文章会对这种解释进行详尽的讨论。

依靠这个公理系统,概率律许多重要的性质都能被推导出来。例如,由可加性公理与归一性公理可以得到:

由这个性质可知空事件 \(\varnothing\) 的概率为 \(0\) ,即 \(P(\varnothing) = 0\) 。

接下来推导另一个性质,令 \(A_1, A_2, \cdots, A_n\) 为互不相容的事件,反复运用可加性公理可以得到:

即有限多个互不相容的事件的并的概率等于他们各自的概率之和。

2.4 离散模型

接下来用实例来说明概率律的构造方法。

考虑抛一枚硬币,一共有两种结果,正面向上 \(\{H\}\) 与反面向上 \(\{T\}\) 样本空间 \(\Omega = \{H, T\}\) ,事件有:

若硬币是均匀的,我们会相信硬币的两面会有相同的机会出现,应该确定两个结果的概率是相等的,即 \(P(\{H\}) = P(\{T\})\) 。由可加性公理和归一性公理可得:

联立得到:

显然所建立的概率律满足三条公理。

利用概率律的可加性公理以及适当的推理,可以得到下面的结论:

离散概率律

设样本空间有有限个可能的结果组成,则事件的概率可由组成这个事件的试验结果的概率所决定。事件 \(\{s_1, s_2, \cdots, s_n\}\) 的概率是 \(\sum_iP(s_i)\) ,即

此处用简单的记号 \(P(s_i)\) 来表示事件 \(\{s_i\}\) 的概率,即 \(P(\{s_i\})\) 。本系列以后也将会沿用此简化的约定书写。

现在设样本空间 \(\Omega = \{s_1, s_2, \cdots, s_n\}\) 并且每个实验结果都是等概率的,结合离散概率律与归一化公理可知 \(P(s_i) = 1/n, i = 1, 2, \cdots, n\) ,并得到一下定律。

离散均匀概率(古典概型)

设样本空间由 \(n\) 个等可能的事件组成,因此每个试验结果组成的事件(被称为基本事件)的概率是相等的。由此得到

2.5 连续模型

若试验的样本空间是一个连续集合,其相应的概率律就无法如同离散情况下一样由基本事件的概率确定。但是离散概率中的均匀概率律还是可以推广到连续的情形,下面就是一个例子:

假设 \(\Omega = [0,1]\) ,并且每个点是等可能发生。然而,由可加性公理及非负性公理我们得到每个单点所组成的事件概率只能为 \(0\) 。对于这种情况,我们可定义子区间 \([l, r]\) 的概率为 \(r-l\) 。更加复杂的集合的概率可以定义为集合的长度[2]。这样定义满足三条公理,因此构造符合要求。

值得注意的是,当样本空间是高维时,例如 \(\Omega = [0, 1]\times[0, 1]\) ,我们便把事件概率定义为事件在样本空间的面积,高维就是体积,这样也是满足公理的。

2.6 概率律的性质

下面列出若干可由概率公理推导而来的性质:

概率律的若干性质

考虑一个概率律, \(A,B,C\) 为事件。

(a) 若 \(A\subseteq B\) 则 \(P(A)\leq P(B)\) 。

(b) \(P(A\cup B) = P(A)+P(B)-P(A\cap B)\)

(c) \(P(A\cup B) \leq P(A)+P(B)\)

(d) \(P(A\cup B \cup C) = P(A)+P(A^c\cup B)+P(A^c \cup B^c \cup C)\)

以上这些性质都可以加以推广为更普遍的形式,如将 (c) 对 \(A_1\) 与 \(\cup_{i=2}^nA_i\) 使用,得到:

再次基础上再对 \(A_2\) 与 \(\cup_{i=3}^nA_i\) 使用,像这样继续下去一直使用,即可得到:

2.7 模型与实际问题处理

概率理论很重要的一个作用就是分析实际问题,这个过程通常分为两个阶段:

(a) 第一阶段,构建合适的概率空间与概率律,建立概率模型。此处概率模型只需满足概率律的三条公理即可,并没有过多限制,可以随着实际问题的变化而构建出不同的模型。利用统计方法可以很好地确定简单准确并兼具易操作性的模型,这将在之后的文章进行讨论。

(b) 第二阶段,我们将在第一阶段所定义的完全严格的概率模型之中进行推导,计算某些事件的概率或推导出有用的性质。简单来说,第一阶段的目的是将实际问题抽象成数学模型,然后第二阶段我们再用逻辑推导与其他数学工具来进行推导。在第二阶段中,无论推导的过程有多么地困难,其中的答案一定是准确的,没有歧义的。只要自身的推导能力足够强,那么一定可以得到唯一的答案。

在概率论中有一个十分著名的贝特朗悖论,简单解释一下就是问题中没有对随机有一个明确的定义,导致构建出了不同的概率模型。其实三个冲突的结果都是正确的,只不过是基于不同的概率模型罢了。因此,在第一阶段所构建的概率模型反映问题的准确性是极为重要的。

2.8 概率空间*

实际上,现代概率研究问题的基础为 概率空间(Probability space) ,概率的严格定义基于这个概念。

概率空间是一个测度空间 \((\Omega, \mathcal{F}, P)\) ,样本空间在前文已提及,故在此不再赘述。

重要且难以理解的是 事件(events) \(\mathcal{F}\) 。 \(\mathcal{F}\) 须为 \(\Omega\) 上的一个 \(\sigma\) -代数,它是一个集族,且满足下面的条件:

- \(\Omega \in \mathcal{F}\) 。

- 如果集合 \(E\in \mathcal{F}\) ,那么 \(E^c\in \mathcal{F}\) 。

- 如果 \(E_1,E_2,\cdots,E_i\in \mathcal{F}\) ,那么 \(\bigcup^{\infty}_{i=1}S_i\in \mathcal{F}\) 。

可以看出, \(\sigma\)-代数比一般的代数限制要更为严格,不仅要满足有限交封闭,更要满足可数无限交封闭。这也是为什么事件要是一个 \(\sigma\)-代数,因为它能给概率运算一个更好的环境。

定义了 \(\sigma\)-代数的集合 \(\Omega\) 是可测的,或者说 \((\Omega, \mathcal{F})\) 是可测空间。

最后来到 \(P\) 。 \(P\) 其实就是概率律,所需要满足的三条公理便是前面的三条,但在测度论下它有个更正式的名称: 概率测度(probability measure) 。下面给出其更严谨的定义:

设 \((\Omega, \mathcal{F})\) 为可测空间, \(P\) 是定义在 \(\mathcal{F}\) 上的实值函数, \(P:\mathcal{F}\leftarrow[0,1]\) ,若其满足:

- \(\forall A\in \mathcal{F}, 0\leq P(A)\leq 1\) 。

- \(P(\Omega) = 1\) 。

- \(A_1, A_2, \cdots\in\mathcal{F}, A_i\cap A_j = \varnothing, i\neq j\Leftarrow P\left(\bigcup_nA_n\right) = \sum_nP(A_n)\)

则称 \(P\) 为 \((\Omega, \mathcal{F})\) 上的概率测度, \((\Omega, \mathcal{F}, P)\) 称为概率空间, \(P(A)\) 称为事件 \(A\) 的概率。

但是这样人为定义出的 \(P\) 还有一个问题亟待解决,那就是这样的 \(P\) 是否是唯一的。想要严谨地表述与解决该问题,我们需要引入 \(\pi\)-系(pi-system) 的概念。

\(\pi\)-系: 设 \(\Omega\) 为样本空间, \(\mathcal{I}\) 是 \(\Omega\) 上某些子集构成的集合,若

则称 \(\mathcal{I}\) 是 \(\Omega\) 上的 \(\pi\)-系。

设 \(\mathcal{F} = \sigma(\mathcal{I})\) , \(P_1\) 和 \(P_2\) 为可测空间 \((\Omega, \mathcal{F})\) 上的两个概率测度,则有

其中 \(\sigma()\) 的定义为给定一个由 \(X\) 子集构成的集合系(collection) \(\mathcal{C}\) ,有

也就是说若两个概率测度 \(P_1\) 与 \(P_2\) 对“基本事件”给出的测度相等,那么这两个概率测度就是相等的。

上述定义的 \((\Omega, \mathcal{F}, P)\) 构成了概率空间,而现代概率论对随机试验的研究就是在特定的概率空间上展开。

Part3 条件概率

条件概率是在给定部分信息的基础上对试验结果的一种推断。举个例子,已知投两次骰子的总和为 \(8\) ,第二次投出 \(4\) 的概率就是一个条件概率。

下面给出条件概率更准确的定义:给定一个试验及其相对应的样本空间、概率律,假设已知给定的事件 \(B\) 发生了,此时事件 \(A\) 发生的概率就是所谓给定 \(B\) 发生之下事件 \(A\) 的 条件概率 ,记作 \(P(A|B)\) 。

我们用一个例子来说明条件概率的的构造:假设我们投了一次骰子,并且我们知道投出来的点数是偶数,即 \(2,4,6\) 这三种结果之一发生,那么由于投骰子的概率是均匀的,所以得到:

由这个推导不难得出等概率模型通用的条件概率定义:

将这个结果推广,我们可以得到条件概率的一般定义:

其中假定 \(P(B) > 0\) 。如果事件 \(B\) 为不可能事件,那么相应的条件概率就没有定义,因为讨论一个不可能发生的事件发生没有任何意义,同时其在代数上也没有意义。

下面将会证明条件概率作为一个概率律的合法性,及推导一些基本性质。

3.1 条件概率是一个概率律

首先非常明显,条件概率具有非负性,因为它是由基础概率律的比值得到的。

接下来证明条件概率的归一性:

最后来证明可加性,设 \(A_1\) 和 \(A_2\) 是任意两个不相容的事件,则有:

由此得证。

在证明了条件概率作为概率律的合法性后,所有关于概率律的性质对条件概率都是成立的。

对于条件概率,我们还可以发现一个特殊的性质: \(P(B|B) = P(B)/P(B) = 1\) ,并且对于 \(A\cap B = \varnothing\) 的事件 \(A\) , \(P(A|B) = 0/P(B) = 0\) ,也就是说我们完全可以将事件 \(B\) 以外的结果排除掉,将 \(B\) 看成新的样本空间,再在其中推导。

下面是条件概率的性质总结。

条件概率的性质

- 设时间 \(B\) 满足 \(P(B) > 0\) ,则给定 \(B\) 之下,事件 \(A\) 的条件概率由下式给出:

条件概率在同一个样本空间 \(\Omega\) 上给出了一个新的概率律,现有概率律的所有性质对条件概率都是适用的。

- 由于条件概率所关心的事件都是事件 \(B\) 的子事件,可以把条件概率看做 \(B\) 上的概率律,即把 \(B\) 看作 \(\Omega\) 。

- 当试验的 \(\Omega\) 为有限集,并且所有试验结果为等可能的情况下,条件概率可以由下式给出:

3.2 利用条件概率构造概率模型

在为试验建立具有序贯特征的概率模型时,条件概率往往是很好确定的。我们可以通过条件概率来确定无条件概率,而在这个过程中有常用的公式 \(P(A\cap B) = P(B)P(A|B)\) ,由条件概率的定义式易得。

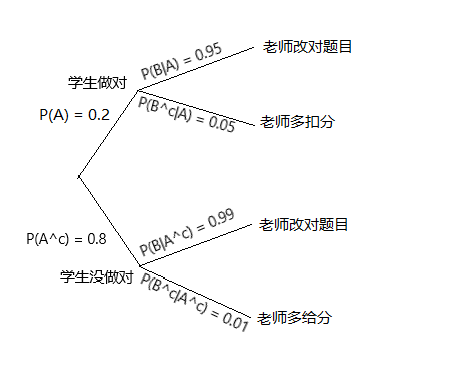

让我们通过一个例子来理解这一方法的运用:假设现在有一个老师在改一名学生一道数学题。学生做对这道题的概率是 \(20%\) ,而如果学生做对了这道题,老师将有 \(95%\) 的概率给出正确的批改;而如果学生没做对,老师将会有 \(99%\) 的概率给出正确的批改。问老师给这名学生多给分的概率有多大?给这名学生多扣分的概率有多大?

我们先记 \(A = \{\text{学生做对题目}\}, B = \{\text{老师给出正确批改}\}\) 。然后,我们就使用序贯树来刻画这些事件,如下:

图中同样记录了题中给出的概率。序贯树上的叶子即是试验结果,它的概率等于由根部到树叶的概率乘积,即所求概率为:

受到这个例子的启发,我们可以利用序贯树来计算概率。加以归纳,并从 \(2\) 个事件之交变为若干个事件相交,我们可以得出一套以条件概率计算非条件概率的方法:

乘法规则

假定所有涉及的条件概率都为正,则有:

接下来我们对这个规则加以证明。首先不难证明由以下恒等式:

再将条件概率的定义式带入,即可将等式右端变为规则中的形式:

Part4 一些概率定理

在了解了条件概率的一些基本性质与应用后,我们将进一步讨论条件概率的应用,其中全概率定理、容斥恒等式与贝叶斯准则将会在本节讨论。

4.1 全概率定理

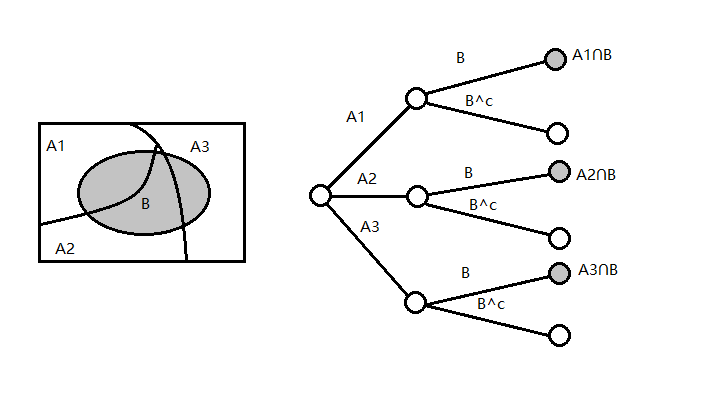

全概率定理将一个事件的概率拆成若干它的不相交子集之和,或拆成若干条件概率与非条件概率乘积之和,下面是它的内容。

全概率定理

设 \(A_1, A_2, \cdots, A_n\) 是一组互不相容的事件,形成样本空间的一个分割,并且 \(\forall i, P(A_i) > 0\) 。那么,对于任何事件 \(B\) ,有下列公式成立:

下图形象地用两种方式展现了全概率定理的内容:

下面给出全概率定理的代数证明。由于事件 \(A_1, A_2, \cdots, A_n\) 形成样本空间的一个分割,事件 \(B\) 可以分解成不相交的 \(n\) 个事件的并:

利用可加性公理可以得到:

再对条件概率的定义式进行变换:

将上式代入其前一式得到:

全概率定理自身的应用主要是直接代入计算概率,其还可以证明一些定理,如下两个部分的容斥恒等式与贝叶斯准则。

4.2 容斥恒等式

容斥恒等式给出了将若干事件之并概率拆成若干事件概率与若干事件之并概率的和差,或是将若干事件之交概率拆成若干事件概率与若干事件之并概率的和差,下面给出了它的具体形式。

容斥恒等式

设 \(A_1, A_2, \cdots, A_n\) 为 \(n\) 个事件,记 \(S_m\) 为所有满足 \(1\leq i_1 < i_2 < \cdots < i_m \leq n\) 的所有 \(m\) 维指标 \((i_1, i_2, \cdots, i_m)\) 的集合,则下列恒等式成立:

首先是它的二元形式,对于任何事件 \(A,B\) ,有

恒成立。证明如下:

由此得证第 \(1\) 个等式。而第 \(2\) 个等式其实与第一个等式等价下面我们需要将二元推广到多元,这时我们可以使用 数学归纳法 证明,归纳法基础为二元形式的容斥恒等式,归纳过程如下:

拎出最麻烦的最后一项进行拆解:

回到前面的式子,将我们推出的式子与已知形式的第一项代入,即可得到 \(n\) 元形式的容斥恒等式,从而得证。交形式的容斥恒等式与并形式证明过程类似,在此略过不写。实际上只要证出一种形式,就可以通过 De Morgan 定理导出另外一种,其中需要一些二项式系数的知识,在此同样不写,感兴趣的话可自行推导。

4.3 贝叶斯准则

贝叶斯准则将形如 \(P(A|B)\) 的条件概率与形如 \(P(B|A)\) 的条件概率联系起来,其主要内容如下:

贝叶斯准则

设 \(A_1, A_2, \cdots, A_n\) 是一组互不相容的事件,形成样本空间的一个分割,并且 \(\forall i, P(A_i) > 0\) 。那么对于任何事件 \(B\) ,只要其满足 \(P(B) > 0\) ,下列公式成立:

贝叶斯准则的证明并不困难,首先注意到有:

这便是第一个等式。而变换为第二个等式,只需对 \(P(B)\) 使用全概率公式即可。

贝叶斯准则主要的应用在于 因果推理 。假设现在我们得到了一个“结果”,而有许多“原因”可以造成这一结果,我们希望能通过“结果”来推断“原因”。现在设事件 \(A_1, A_2, \cdots, A_n\) 为原因,而事件 \(B\) 是由原因引起的结果。 \(P(B|A_i)\) 表示在因果推理的模型中由原因 \(A_i\) 造成结果 \(B\) 出现的概率。当观察到结果 \(B\) 的时候,我们希望反推结果 \(B\) 是由原因 \(A_i\) 造成的概率 \(P(A_i|B)\)。由于 \(P(A_i|B)\) 是得到信息 \(B\) 后 \(A_i\) 出现的概率,所以被称为 后验概率 ,而信息 \(B\) 未被得知时的概率 \(P(A)\) 就被称为 先验概率 。

Part5 独立性

在本节中,我们将围绕独立性进行讨论。

在第3节中我们引入了条件概率 \(P(A|B)\) 的概念,这个概率刻画了事件 \(B\) 的发生给事件 \(A\) 带来的信息。在这其中有一个十分有趣且重要的特殊情况:事件 \(B\) 的发生并没有给事件 \(A\) 带来任何有用的信息,即没有改变事件 \(A\) 发生的概率

在上述等式成立的情况下,我们称事件 \(A\) 是 独立 与事件 \(B\) 的。注意到,代入条件概率的定义式 \(P(A|B) = P(A\cap B)/P(B)\) 后,上式等价于:

我们将这个式子作为事件 \(A\) 与事件 \(B\) 相互独立的正式定义,因为其不仅囊括了 \(A\) 独立于 \(B\) 与 \(B\) 独立于 \(A\) 两个信息,并且包括了 \(P(B) = 0\) 的情况。当 \(P(B) = 0\) 时,我们便不能用最前面的等式,因为 \(P(A|B)\) 在这个情况下没有定义。而同时囊括两个信息是因为这个式子具有对称性, \(A\) 与 \(B\) 地位交换即可证明存在 \(B\) 独立于 \(A\) 。在上述式子成立的情况下,我们称 \(A\) 和 \(B\) 是相互独立的,或 \(A\) 和 \(B\) 是 相互独立的事件 。

在实际中可以很简单、直观地判定独立性。例如,在两个相隔很远的不同地点随机抛出两个小球,对于第一个小球落在某地与第二个小球落在某地这两个事件,我们显然可以判定他们相互独立。而在样本空间中,就无法比较直观地判定。或许会有认为两个事件互不相容即可判定相互独立,但事实恰好相反,因为这样的话就有 \(P(A\cap B) = 0 \neq P(A)P(B)\) ,当然也可以理解为得到信息 \(A\) 后,信息 \(A^c\) 也自然而然就确定了,并且 \(B\subseteq A^c\) ,一定不独立,除非两者其一为不可能事件(这种情况下不可能有必然事件)。因此,在分析独立性时,还是应基于独立性的定义式进行计算与分析。

值得注意的是,如果事件 \(A\) 与事件 \(B\) 相互独立,那么 \(A^c\) 与 \(B\) 也将会相互独立,下面给出证明:

由此得证。由于事件 \(A\) 与事件 \(B\) 地位相等,交换 \(A,B\) 位置即可证明同样有 \(A\) 与 \(B^c\) 相互独立。而 \(A^c\) 与 \(B^c\) 相互独立的证明只需将 \(A^c\) 与 \(B\) 相互独立作为基础,在这个基础上使用 \(A\) 与 \(B^c\) 相互独立有 \((A^c)\) 和 \((B)^c\) 相互独立,即 \(A^c\) 与 \(B^c\) 相互独立。

5.1 条件独立

在第3节时提到过条件概率的性质,其中有一条为条件概率具有概率律的所有性质。因此,我们可以讨论条件概率下的独立性。在给定事件 \(C(P(C)\neq 0)\) 之下,若事件 \(A\) 和 \(B\) 满足

则称 \(A\) 和 \(B\) 在 \(C\) 之下条件独立。运用条件概率的定义与乘法规则,我们可以导出条件独立的另一个特征:

将得到的两个式子最右端比较,发现只要 \(P(B|C)\neq 0\) ,那么就可以消去 \(P(B|C)\) 得到下式:

这便是条件独立的另一个等价定义(有要求 \(P(B|C)\neq 0\) )。这个式子说明了在给定信息 \(C\) 的情况下,事件 \(B\) 的发生与否并不影响事件 \(A\) 的条件概率。

十分有趣的是,条件独立于相互独立之间并不存在包含关系,我们可以举例证明这个命题。连续抛两次硬币,第一次抛出正面与第二次抛出正面显然是相互独立的,然而它们在事件“两次抛硬币试验结果不同”之下并不条件独立。对于命题的逆命题,则需构造两枚硬币,一枚以 \(0.99\) 概率正面向上,另一枚则以 \(0.01\) 概率正面向上。选择一枚硬币进行连续两次投掷,在“选定第一枚硬币”的条件下,第一次抛出正面与第二次抛出正面是条件独立的。而在去掉该条件后,两个事件并不独立。

下面总结关于独立性的结论。

独立性

- 两个事件 \(A\) 和 \(B\) 称为相互独立的,如果他们满足

若 \(B\) 满足 \(P(B) > 0\) ,那么独立性还等价于

- 若 \(A\) 与 \(B\) 相互独立,那么 \(A\) 与 \(B^c\) 、 \(A^c\) 与 \(B\) 、 \(A^c\) 与 \(B^c\) 也相互独立。

- 设事件 \(C\) 满足 \(P(C) > 0\) ,两个事件 \(A\) 和 \(B\) 在给定 \(C\) 之下条件独立当它们满足:

若 \(P(B\cap C) > 0\) ,则 \(A\) 和 \(B\) 在给定 \(C\) 之下条件独立与下式等价:

- 独立性不蕴含条件独立,反之亦然。

5.2 一组事件的独立性

在前一部分我们讨论了两个事件的独立性,在本部分我们将会把独立性推广到多个事件中。

一组事件相互独立性的定义

设 \(A_1, A_2, \cdots, A_n\) 为 \(n\) 个事件,若它们满足

则称 \(A_1, A_2, \cdots, A_n\) 为相互独立的事件。

以 \(n = 3\) 的情况举例,独立性条件可归为下列 \(4\) 个条件:

前面三个条件说明任意两个事件是相互独立的,这种性质被称为 两两独立 。但是第 \(4\) 个条件也十分重要,前面的 \(3\) 个等式并无法推出它,而它也无法推出前面 \(3\) 个等式。换言之,前面 \(3\) 个等式与第 \(4\) 个等式之间无蕴含关系。下面用两个例子说明:

(1)抛两次硬币,事件 \(A_1\) 为第一次扔得正面,事件 \(A_2\) 为第二次扔得正面,事件 \(A_3\) 为两次结果不同三个事件。代入可以证明它们是两两独立的,但是它们并不满足第 \(4\) 个等式:

(2)投两次骰子,事件 \(A_1\) 为第一次扔得 \(1\) 、 \(2\) 或 \(3\) ,事件 \(A_2\) 为第一次扔得 \(3\) 、 \(4\) 或 \(5\) ,事件 \(A_3\) 为两次扔得点数之和为 \(9\) 。我们有:

由此得到这 \(3\) 个事件不两两独立,但是下面的等式却是成立的:

一组事件如果拥有相互独立性,那么就意味着任意地将事件空间分成若干组,组与组之间必然是相互独立的,即一个小组中的事件出现或不出现,都不会给其他小组中的事件带来任何信息。下面给出形式化的证明:设 \(A_1, A_2, \cdots, A_n\) 为相互独立的事件, \(S_1\) 与 \(S_2\) 为 \(\{1, 2, \cdots, n\}\) 的两个不相交的子集,记 \(S_{m,k} = \{(i_1, i_2, \cdots, i_m)|1\leq i_1 < i_2 < \cdots < i_m \leq n\text{且}\forall 1\leq j\leq m,i_j\in S_k\}\) ,则有

由此得证。

5.3 独立试验与二项概率

现在设试验是由一系列独立且相同的小试验组成,称这种试验为 独立试验序列 。当每个小试验只有两种可能结果的时候,就称为独立的 伯努利试验序列 。这里的两个结果可以是任意的,在学术讨论中通常使用抛硬币的两个结果“正面”(H)和“反面”(F)作代表。

现在考虑连续 \(n\) 次独立的抛硬币的试验,每次抛掷结果为正面的概率为 \(p\) ,其中 \(0\leq p\leq 1\) 。此处独立意味着 \(A_1, A_2, \cdots, A_n\) 是独立的,事件 \(A_i = \{\text{第}i\text{次抛掷的结果为正面}\}\) 。

如同 2.2 中给出的示例,我们可以用序贯树形图来直观上刻画独立伯努利试验序列。因为事件具有独立性,所以无论前面抛出了什么结果,每次抛掷得到正面的条件概率始终为 \(p\) ,得到反面的概率始终为 \(1-p\) 。因而,由乘法规则,我们可以推断任何一个具有 \(k\) 个正面与 \(n-k\) 个反面的试验结果的概率 \(p^k(1-p)^{n-k}\) ,其中 \(0\leq k\leq n\) 。

现在我们来计算概率

这个概率在概率论中处于十分重要的地位。由于任何包含 \(k\) 次正面向上的的试验结果概率都是 \(p^k(1-p)^{n-k}\) ,我们可以得到

此处记号

数 \(\large\binom nk\) 就是大名鼎鼎的 二项式系数 ,称为 \(n\) 选 \(k\) 的组合数。概率 \(\mathbb p(k)\) 就是有名的 二项式概率 。在下一节将会介绍计数法,用计数法可以得到

此处记号 \(i!\) 表示正整数 \(i\) 的阶乘:

按照约定,记 \(0! = 1\) 。由于归一性公理,二项式概率之和必须等于 \(1\) ,这样我们得到 二项式公式 :

5.4 多项概率

如果一个独立试验序列中每个小试验的结果可能性不只有 \(2\) 种,那么我们将会从中得出一些更普遍的结论。考虑连续 \(n\) 次独立的投六面骰子的试验,每次投掷结果为 \(i\) 的概率为 \(p_i\) ,其中 \(0\leq p_i\leq 1\) ,且 \(\sum_{i=1}^6p_i = 1\) 。

与上一部分的分析相似,我们可以画出序贯树形图刻画该试验的性质。由于无论前面投出的结果是什么都不会影响之后的投掷,所以对于一个含有 \(k_i\) 个 \(i(1\leq i\leq 6)\) 的投掷结果,其概率将会是 \(\prod_{i=1}^6p_i^{k_i}\) 。

进一步,我们将只有 \(6\) 个结果的骰子推广为具有 \(r\) 种结果的试验。对于结果 \(1\sim r\) 出现次数分别为 \(k_1, k_2, \cdots, k_r\) 的事件,其概率(称为 多项式概率 )可以由下式给出

记号 \(\large\binom n{k_1, k_2, \cdots, k_r}\) 同样会由计数法给出。与二项式公式对应,有归一性公理与可加性公理可得 多项式公式 :

实际上,二项概率其实就是多项概率 \(r=2\) 时的情形,因此它们的推导过程大体上是一致的。

Part6 计数法

在计算概率时,常常涉及到计算有关事件中的试验结果数。在前面我们已经遇到了两种需要这样计算的情形:

(a) 当样本空间 \(\Omega\) 由有限个等可能的试验结果组成,那么这是一个等概率模型,事件 \(A\) 的概率便可以由下式给出

工式中涉及 \(A\) 和 \(\Omega\) 中元素的计数问题。

(b) 当事件 \(A\) 中的每一个试验结果具有相同的概率 \(p\) ,那么 \(A\) 的概率可以由下式给出

此时需要计算 \(A\) 中元素的数目,也正是我们前面计算二项式概率时的情形。

计数问题原则上十分简单,但是其计算过程可能会非常复杂。更深层次的计数属于 组合数学 的一部分,而本节将会介绍一些计数的基本准则,并将其应用到概率计算中去。

6.1 计数准则(乘法原理)

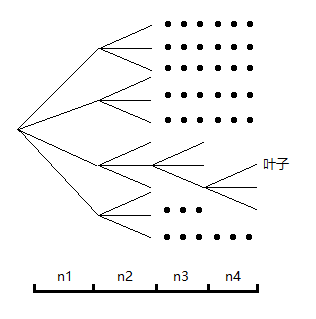

这是计数的最基本的方法。计数准则基于分段计数的原则,因此可以借助序贯树形图进行计数。计数准则还有一个更为人所熟知的名字:乘法原理。它的内容如下

计数准则(乘法原理)

考虑由 \(r\) 个阶段组成的一个试验,假设在前 \(k-1\) 个阶段中的任何一个结果,在接下来的第 \(k\) 个阶段都会有 \(n_k\) 个结果,则在 \(r\) 个阶段的试验中一共有

个试验结果。

这个法则对我们所提到的情况 (a) 十分有效,能极为轻松地计算出 \(\Omega\) 与事件 \(A\) 中的结果数。

6.2 排列与组合

假定 \(n\) 个不同的对象组成一个集合,设正整数 \(k\) 满足 \(k\leq n\) 。现在我们想要知道从 \(n\) 个对象中有序地选出 \(k\) 个不同对象的方案数。

对于第 \(1\) 个对象,我们可以从全部的 \(n\) 个对象中任选一个,因此方案数为 \(n\) 。然而由于对象各不相同的限制,第 \(2\) 个对象只能从剩下的 \(n-1\) 个数中选取。我们并不关心先前所选的对象到底是什么,只需与其不同即可,因此无论如何第 \(2\) 次都是从 \(n-1\) 个对象中选取。以此类推,我们可以得到 \(n\) 选 \(k\) 的排列数为

这些取出来的序列被称为 \(n\) 取 \(k\) 排列,在 \(k = n\) 的情形简称为 排列 ,其方案数正好为 \(n!\) 。

在实际处理问题时,往往会遇到不在意次序,只关注所选出来的对象是什么的情形。例如从 \(3\) 名同学 \(A, B, C\) 中选出两位,那么只能选出 \(3\) 种组合:

其中去掉了排列中存在的的 \(BA, CA, CB\) ,因为它们与所选的组合本质是一样的。这启发了我们如何去计算组合方案数,只需在排列的基础上除去所选的 \(k\) 个对象所能构造出的排列即可,最终可以得到从 \(n\) 选 \(k\) 的组合数为

回到上一节提到的二项式系数 \(\large\binom nk\) 的表达式。我们可以注意到确定 \(n\) 次试验中 \(k\) 次向上的试验结果数量等价于从 \(n\) 个对象中选择 \(k\) 个的组合,因此有

二项式系数得名于一个重要的定理: 二项式定理 。其内容如下:

不难发现二项式公式其实就是该定理在 \(x=p,y=1-p\) 时的特例,而该公式的证明其实与推导出 \(\large\binom nk\) 表达式的过程类似。

6.3 分割

注意到组合数 \(\large\binom nk\) 可以看做将一个 \(n\) 元素集合分划成一个 \(k\) 元素子集与一个 \(n-k\) 元素子集的分割方案数(注意此处分割的每个子集是有序的)。我们现在考虑将分划成两个子集推广到多个子集。

给定一个具有 \(n\) 个元素的集合,并设 \(k_1, k_2, \cdots, k_r\) 为非负整数,其总和为 \(n\) 。现在考虑将这个集合分割成 \(r\) 个不相交的子集,使得第 \(i\) 个子集恰好有 \(k_i\) 个元素,问有多少种划分方案。

对于这个问题,我们可以进行阶段的划分。第一阶段我们从大集合中选出 \(k_1\) 个元素,方案数为 \(\large\binom{n}{k_1}\) 。在第二阶段,我们无法再次选择先前已被选的 \(k_1\) 个数,因此方案数为 \(\large\binom{n-k_1}{k_2}\) 。像这样每个阶段都把上个阶段分出去的元素分离,我们可以得到最终的方案数

拆开得到

相消化简得

这个分割数称为 多项式系数 ,且使用下面的记号表示:

这便是上文多项概率中所提的记号。

与二项式系数得名来自二项式定理一样,关于多项式系数,有一个十分重要的 多项式定理 :

多项式公式自然也是它的特殊形式。

接下来是对计数法的总结与汇总。

计数法汇总

-

\(n\) 个对象的 排列数 :\(n!\)

-

\(n\) 个对象中取 \(k\) 个对象的 排列数 : \(\frac {n!}{(n-k)!}\)

-

\(n\) 个对象中取 \(k\) 个对象的 组合数 : \(\binom nk = \frac{n!}{k!(n-k)!}\)

-

将 \(n\) 个对象分成 \(r\) 个组,其中第 \(i\) 个组具有 \(k_i\) 个对象的 分割数 :

Part7 总结

解决一个概率问题通常分为下列 \(3\) 个步骤:

(a) 描述样本空间 \(\Omega\) ;

(b) 列出概率律 \(P\) ;

(c) 计算各种事件的概率与条件概率。

概率律的硬性要求是必须满足非负性、可加性与归一性 \(3\) 个公理。对于 \(\Omega\) 有限的情形,我们可以在序贯树形图的辅助下,直接将组成一个事件的所有试验结果的概率列出,并且将它们相加即可得到该事件的概率。

对于给定的概率律,我们常常需要去计算它的条件概率,因为条件概率涉及得到部分信息后的概率计算问题。条件概率的计算往往需要使用相关的公式,其中最重要、最基本的是公式 \(P(A|B) = P(A\cap B)/P(B)\) 。在实际应用中,往往更多的都是用条件概率去计算无条件概率。

我们还提到了用来计算概率的 \(3\) 种方法:

(a) 计数法 。这种方法仅适用于古典概型,通过计算事件中试验结果数与样本空间试验结果数得出事件概率。

(b) 序贯树形图方法 。在试验具有序贯特征时可使用,通过乘法规则将所列出序贯树形图上路径的概率相乘,即可得出所求事件概率。

(c) 全概率公式、容斥恒等式 。全概率公式可以通过样本空间的一个分割计算某一事件的概率。而容斥恒等式则可以让事件交的概率与事件并的概率相互求得。

还介绍了贝叶斯准则,其在统计学中有重要地位。

最后是概率的独立性与独立试验,以及与之相关而引申的一些基础计数法,排列组合与分割。