Kubernetes概念及使用

一、Kubernetes系列之介绍篇

(k8s配置Ingress-nginx作为服务发现)

(服务网格lstio)

(日志和监控Helm+PrometheusGrafna看板)

(服务调度与编排Scheduler玩转pod调度)

(共享存储PV/PVC/StorageClass)

(Harbor Docker镜像仓库)

(k8s重点对象概念:Namespace、Resources、Label)

- 拥有一个唯一指定的名字

- 拥有一个虚拟IP(Cluster IP、Service IP、或VIP)和端口号

- 能够体统某种远程服务能力

- 被映射到了提供这种服务能力的一组容器应用上

- 目标Pod的定义

- 目标Pod需要运行的副本数量(Replicas)

- 要监控的目标Pod标签(Label)

- 每个Node节点都运行着以下一组关键进程

- kubelet:负责对Pod对于的容器的创建、启停等任务

- kube-proxy:实现Kubernetes Service的通信与负载均衡机制的重要组件

- Docker Engine(Docker):Docker引擎,负责本机容器的创建和管理工作

- Cluster IP仅仅作用于Kubernetes Service这个对象,并由Kubernetes管理和分配P地址

- Cluster IP无法被ping,他没有一个“实体网络对象”来响应

- Cluster IP只能结合Service Port组成一个具体的通信端口,单独的Cluster IP不具备通信的基础,并且他们属于Kubernetes集群这样一个封闭的空间。

- 版本标签:"release":"stable","release":"canary"......

- 环境标签:"environment":"dev","environment":"qa","environment":"production"

- 架构标签:"tier":"frontend","tier":"backend","tier":"middleware"

- 分区标签:"partition":"customerA","partition":"customerB"

- 质量管控标签:"track":"daily","track":"weekly"

-

- kube-Controller进程通过资源对象RC上定义Label Selector来筛选要监控的Pod副本的数量,从而实现副本数量始终符合预期设定的全自动控制流程

- kube-proxy进程通过Service的Label Selector来选择对应的Pod,自动建立起每个Service岛对应Pod的请求转发路由表,从而实现Service的智能负载均衡

- 通过对某些Node定义特定的Label,并且在Pod定义文件中使用Nodeselector这种标签调度策略,kuber-scheduler进程可以实现Pod”定向调度“的特性

二、基于kubernetes构建Docker集群环境实战

|

1

2

|

#setenforce 0#sed -i '/^SELINUX=/cSELINUX=disabled' /etc/sysconfig/selinux |

|

1

|

# yum -y install etcd kubernetes |

配置etcd。确保列出的这些项都配置正确并且没有被注释掉,下面的配置都是如此

|

1

2

3

4

5

6

|

#vim /etc/etcd/etcd.conf ETCD_NAME=defaultETCD_DATA_DIR="/var/lib/etcd/default.etcd"ETCD_LISTEN_CLIENT_URLS="http://0.0.0.0:2379"ETCD_ADVERTISE_CLIENT_URLS="http://localhost:2379" |

配置kubernetes

|

1

2

3

4

5

6

7

8

|

vim /etc/kubernetes/apiserver KUBE_API_ADDRESS="--address=0.0.0.0"KUBE_API_PORT="--port=8080"KUBELET_PORT="--kubelet_port=10250"KUBE_ETCD_SERVERS="--etcd_servers=http://127.0.0.1:2379"KUBE_SERVICE_ADDRESSES="--service-cluster-ip-range=10.254.0.0/16"KUBE_ADMISSION_CONTROL="--admission_control=NamespaceLifecycle,NamespaceExists,LimitRanger,SecurityContextDeny,ResourceQuota"KUBE_API_ARGS="" |

|

1

|

# for SERVICES in etcd kube-apiserver kube-controller-manager kube-scheduler; do systemctl restart $SERVICES systemctl enable $SERVICES systemctl status $SERVICES done |

3.设置etcd网络

|

1

|

#etcdctl -C 10.0.0.81:2379 set /atomic.io/network/config '{"Network":"10.1.0.0/16"}' |

|

1

|

# kubectl get nodes NAME LABELS STATUS |

|

1

|

# yum -y install flannel kubernetes |

配置kubernetes连接的服务端IP

|

1

2

3

|

#vim /etc/kubernetes/configKUBE_MASTER="--master=http://10.0.0.81:8080"KUBE_ETCD_SERVERS="--etcd_servers=http://10.0.0.81:2379" |

配置kubernetes ,(请使用每台minion自己的IP地址比如10.0.0.81:代替下面的$LOCALIP)

|

1

2

3

4

5

|

#vim /etc/kubernetes/kubelet<br>KUBELET_ADDRESS="--address=0.0.0.0"KUBELET_PORT="--port=10250"# change the hostname to this host’s IP address KUBELET_HOSTNAME="--hostname_override=$LOCALIP"KUBELET_API_SERVER="--api_servers=http://10.0.0.81:8080"KUBELET_ARGS="" |

|

1

2

3

4

5

|

# ifconfig docker0Link encap:Ethernet HWaddr 02:42:B2:75:2E:67 inet addr:172.17.0.1 Bcast:0.0.0.0 Mask:255.255.0.0 UPBROADCAST MULTICAST MTU:1500 Metric:1 RX packets:0 errors:0 dropped:0 overruns:0 frame:0 TX packets:0errors:0 dropped:0 overruns:0 carrier:0 collisions:0 txqueuelen:0RX bytes:0 (0.0 B) TX bytes:0 (0.0 B) |

warning:在运行过docker的机器上可以看到有docker0,这里在启动服务之前需要删掉docker0配置,在命令行运行:sudo ip link delete docker0

3.配置flannel网络

|

1

2

3

|

#vim /etc/sysconfig/flanneldFLANNEL_ETCD_ENDPOINTS="http://10.0.0.81:2379"FLANNEL_ETCD_PREFIX="/atomic.io/network" |

|

1

|

# for SERVICES in flanneld kube-proxy kubelet docker; do systemctl restart $SERVICES systemctl enable $SERVICES systemctl status $SERVICES done |

|

1

2

3

4

|

# kubectl get nodesNAME STATUS AGE10.0.0.82 Ready 1m10.0.0.83 Ready 1m |

可以看到配置的两台minion已经在master的node列表中了。如果想要更多的node,只需要按照minion的配置,配置更多的机器就可以了。

三、Kubernetes之深入了解Pod

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

|

# yaml格式的pod定义文件完整内容:apiVersion: v1 #必选,版本号,例如v1kind: Pod #必选,Podmetadata: #必选,元数据 name: string #必选,Pod名称 namespace: string #必选,Pod所属的命名空间 labels: #自定义标签 - name: string #自定义标签名字 annotations: #自定义注释列表 - name: stringspec: #必选,Pod中容器的详细定义 containers: #必选,Pod中容器列表 - name: string #必选,容器名称 image: string #必选,容器的镜像名称 imagePullPolicy: [Always | Never | IfNotPresent] #获取镜像的策略 Alawys表示下载镜像 IfnotPresent表示优先使用本地镜像,否则下载镜像,Nerver表示仅使用本地镜像 command: [string] #容器的启动命令列表,如不指定,使用打包时使用的启动命令 args: [string] #容器的启动命令参数列表 workingDir: string #容器的工作目录 volumeMounts: #挂载到容器内部的存储卷配置 - name: string #引用pod定义的共享存储卷的名称,需用volumes[]部分定义的的卷名 mountPath: string #存储卷在容器内mount的绝对路径,应少于512字符 readOnly: boolean #是否为只读模式 ports: #需要暴露的端口库号列表 - name: string #端口号名称 containerPort: int #容器需要监听的端口号 hostPort: int #容器所在主机需要监听的端口号,默认与Container相同 protocol: string #端口协议,支持TCP和UDP,默认TCP env: #容器运行前需设置的环境变量列表 - name: string #环境变量名称 value: string #环境变量的值 resources: #资源限制和请求的设置 limits: #资源限制的设置 cpu: string #Cpu的限制,单位为core数,将用于docker run --cpu-shares参数 memory: string #内存限制,单位可以为Mib/Gib,将用于docker run --memory参数 requests: #资源请求的设置 cpu: string #Cpu请求,容器启动的初始可用数量 memory: string #内存清楚,容器启动的初始可用数量 livenessProbe: #对Pod内个容器健康检查的设置,当探测无响应几次后将自动重启该容器,检查方法有exec、httpGet和tcpSocket,对一个容器只需设置其中一种方法即可 exec: #对Pod容器内检查方式设置为exec方式 command: [string] #exec方式需要制定的命令或脚本 httpGet: #对Pod内个容器健康检查方法设置为HttpGet,需要制定Path、port path: string port: number host: string scheme: string HttpHeaders: - name: string value: string tcpSocket: #对Pod内个容器健康检查方式设置为tcpSocket方式 port: number initialDelaySeconds: 0 #容器启动完成后首次探测的时间,单位为秒 timeoutSeconds: 0 #对容器健康检查探测等待响应的超时时间,单位秒,默认1秒 periodSeconds: 0 #对容器监控检查的定期探测时间设置,单位秒,默认10秒一次 successThreshold: 0 failureThreshold: 0 securityContext: privileged:false restartPolicy: [Always | Never | OnFailure]#Pod的重启策略,Always表示一旦不管以何种方式终止运行,kubelet都将重启,OnFailure表示只有Pod以非0退出码退出才重启,Nerver表示不再重启该Pod nodeSelector: obeject #设置NodeSelector表示将该Pod调度到包含这个label的node上,以key:value的格式指定 imagePullSecrets: #Pull镜像时使用的secret名称,以key:secretkey格式指定 - name: string hostNetwork:false #是否使用主机网络模式,默认为false,如果设置为true,表示使用宿主机网络 volumes: #在该pod上定义共享存储卷列表 - name: string #共享存储卷名称 (volumes类型有很多种) emptyDir: {} #类型为emtyDir的存储卷,与Pod同生命周期的一个临时目录。为空值 hostPath: string #类型为hostPath的存储卷,表示挂载Pod所在宿主机的目录 path: string #Pod所在宿主机的目录,将被用于同期中mount的目录 secret: #类型为secret的存储卷,挂载集群与定义的secre对象到容器内部 scretname: string items: - key: string path: string configMap: #类型为configMap的存储卷,挂载预定义的configMap对象到容器内部 name: string items: - key: string path: string |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

apiVersion:v1kind: Podmetadata: name: redis-php label: name: redis-phpspec: containers: - name: frontend image: kubeguide/guestbook-php-frontend:localredis ports: - containersPort: 80 - name: redis-php image:kubeguide/redis-master ports: - containersPort: 6379 |

|

1

2

3

|

#kubectl get godsNAME READY STATUS RESTATS AGEredis-php 2/2Running 0 10m |

可以看到READY信息为2/2,表示Pod中的两个容器都成功运行了.

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

|

[root@kubernetes-master ~]# kubectl describe redis-phpthe server doesn't have a resourcetype "redis-php"[root@kubernetes-master ~]# kubectl describe pod redis-phpName: redis-phpNamespace: defaultNode: kubernetes-minion/10.0.0.23Start Time: Wed, 12 Apr 2017 09:14:58 +0800Labels: name=redis-phpStatus: RunningIP: 10.1.24.2Controllers: <none>Containers:nginx:Container ID: docker://d05b743c200dff7cf3b60b7373a45666be2ebb48b7b8b31ce0ece9be4546ce77Image: nginxImage ID: docker-pullable://docker.io/nginx@sha256:e6693c20186f837fc393390135d8a598a96a833917917789d63766cab6c59582Port: 80/TCPState: RunningStarted: Wed, 12 Apr 2017 09:19:31 +0800 |

|

1

2

3

4

5

|

#kubetctl delete pod static-web-node1pod "static-web-node1"deleted#kubectl get podsNAME READY STATUS RESTARTS AGEstatic-web-node1 0/1Pending 0 1s |

|

1

2

|

#rm -f /etc/kubelet.d/static-web.yaml#docker ps |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

apiVersion:v1kind: Podmetadata: name: redis-php label: name: volume-podspec: containers: - name: tomcat image: tomcat ports: - containersPort: 8080 volumeMounts: - name: app-logs mountPath:/usr/local/tomcat/logs - name: busybox image:busybox command: ["sh","-C","tail -f /logs/catalina*.log"] volumes: - name: app-logs emptyDir:{} |

|

1

|

#kubectl logs volume-pod -c busybox |

|

1

|

#kubectl exec -ti volume-pod -c tomcat -- ls /usr/local/tomcat/logs |

|

1

2

3

4

5

6

7

8

|

# vim cm-appvars.yamlapiVersion: v1kind: ConfigMapmetadata: name: cm-appvarsdata: apploglevel: info appdatadir:/var/data |

|

1

2

|

#kubectl create -f cm-appvars.yamlconfigmap "cm-appvars.yaml"created |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

|

#kubectl get configmapNAME DATA AGEcm-appvars 2 3s[root@kubernetes-master ~]# kubectl describe configmap cm-appvarsName: cm-appvarsNamespace: defaultLabels: <none>Annotations: <none> Data====appdatadir: 9 bytesapploglevel: 4 bytes[root@kubernetes-master ~]# kubectl get configmap cm-appvars -o yamlapiVersion: v1data:appdatadir: /var/dataapploglevel: infokind: ConfigMapmetadata:creationTimestamp: 2017-04-14T06:03:36Zname: cm-appvarsnamespace: defaultresourceVersion:"571221"selfLink: /api/v1/namespaces/default/configmaps/cm-appvarsuid: 190323cb-20d8-11e7-94ec-000c29ac8d83 |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

apiVersion: v1kind: ConfigMapmetadata: name: cm-appvarsdata: key-serverxml: <?xml Version='1.0'encoding='utf-8'?> <Server port="8005"shutdown="SHUTDOWN"> ..... </service> </Server> key-loggingproperties: "handlers=lcatalina.org.apache.juli.FileHandler, ...." |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

#vim cm-test-app.yamlapiVersion: v1kind: Podmetadata: name: cm-test-appspec: containers: - name: cm-test-app image: tomcat-app:v1 ports: - containerPort: 8080 volumeMounts: - name: serverxml #引用volume名 mountPath:/configfiles #挂载到容器内部目录 configMap: name: cm-test-appconfigfile #使用configmap定义的的cm-appconfigfile items: - key: key-serverxml #将key=key-serverxml path: server.xml #value将server.xml文件名进行挂载 - key: key-loggingproperties #将key=key-loggingproperties path: logging.properties #value将logging.properties文件名进行挂载 |

|

1

2

|

#kubectl create -f cm-test-app.yamlPod "cm-test-app"created |

|

1

2

3

|

#kubectl exec -ti cm-test-app -- bashroot@cm-rest-app:/# cat /configfiles/server.xmlroot@cm-rest-app:/# cat /configfiles/logging.properties |

-

- configmap必须在pod之间创建

- configmap也可以定义为属于某个Namespace,只有处于相同namespaces中的pod可以引用

- configmap中配额管理还未能实现

- kubelet只支持被api server管理的pod使用configmap,静态pod无法引用

- 在pod对configmap进行挂载操作时,容器内部职能挂载为目录,无法挂载文件。

-

- RC和DaemonSet:必须设置为Always,需要保证该容器持续运行

- Job:OnFailure或Nerver,确保容器执行完成后不再重启

- kubelet:在Pod失效时重启他,不论RestartPolicy设置什么值,并且也不会对Pod进行健康检查

-

- LivenessProbe探针:用于判断容器是否存活(running状态),如果LivenessProbe探针探测到容器不健康,则kubelet杀掉该容器,并根据容器的重启策略做响应处理

- ReadinessProbe探针:用于判断容器是否启动完成(ready状态),可以接受请求。如果ReadinessProbe探针探测失败,则Pod的状态被修改。Endpoint Controller将从service的Endpoint中删除包含该容器所在的Pod的Endpoint。

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

|

apiVersion:v1kind: Podmetadata: name: liveness-exec label: name: livenessspec: containers: - name: tomcat image: grc.io/google_containers/tomcat args: -/bin/sh - -c -echo ok >/tmp.health;sleep10; rm -fr /tmp/health;sleep600 livenessProbe: exec: command: -cat -/tmp/health initianDelaySeconds:15 timeoutSeconds:1 |

|

1

2

3

4

5

6

7

8

9

10

11

12

|

kind: Podmetadata: name: pod-with-healthcheckspec: containers: - name: nginx image: nginx livenessProbe: tcpSocket: port: 80 initianDelaySeconds:30 timeoutSeconds:1 |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

|

apiVersion:v1kind: Podmetadata: name: pod-with-healthcheckspec: containers: - name: nginx image: nginx livenessProbe: httpGet: path:/_status/healthz port: 80 initianDelaySeconds:30 timeoutSeconds:1 |

- initialDelaySeconds:启动容器后首次监控检查的等待时间,单位秒

- timeouSeconds:健康检查发送请求后等待响应的超时时间,单位秒。当发生超时就被认为容器无法提供服务无,该容器将被重启

|

1

|

#kubectllabel nodes k8s-node-1 zonenorth |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

apiVersion:v1kind: Podmetadata: name: redis-master label: name: redis-masterspec: replicas: 1 selector: name: redis-master template: metadata: labels: name: redis-master spec: containers: - name: redis-master images: kubeguide/redis-master ports: - containerPort: 6379 nodeSelector: zone: north |

- 在每个Node上运行个以GlusterFS存储或者ceph存储的daemon进程

- 在每个Node上运行一个日志采集程序,例如fluentd或者logstach

- 在每个Node上运行一个健康程序,采集Node的性能数据。

|

1

2

3

4

5

6

7

|

#kubectl scale rc redis-slave --replicas=3ReplicationController"redis-slave" scaled#kubectl get podsNAME READY STATUS RESTARTS AGEredis-slave-1sf23 1/1Running 0 1hredis-slave-54wfk 1/1Running 0 1hredis-slave-3da5y 1/1Running 0 1h |

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

apiVersion: v1kind: replicationControllermetadata: name: redis-master-v2 labels: name: redis-master Version: v2spec: replicas: 1 selector: name: redis-master Version: v2 template: labels: name: redis-master Version: v2 spec: containers: - name: master images: kubeguide/redis-master:2.0 ports: - containerPort: 6379 |

需要注意的点:

|

1

|

#kubectl rolling-update redis-master -f redis-master-controller-v2.yaml |

|

1

|

#kubectl rolling-update redis-master --image=redis-master:2.0 |

https://blog.csdn.net/Real_Myth/article/details/78719244

序言

没等到风来,绵绵小雨,所以写个随笔,聊聊k8s的基本概念。

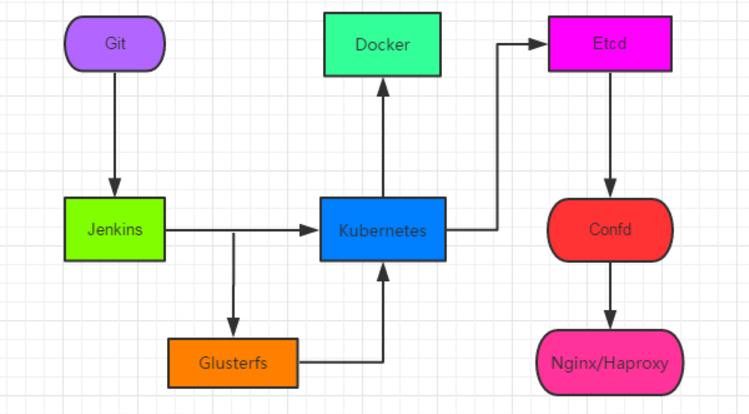

k8s是一个编排容器的工具,其实也是管理应用的全生命周期的一个工具,从创建应用,应用的部署,应用提供服务,扩容缩容应用,应用更新,都非常的方便,而且可以做到故障自愈,例如一个服务器挂了,可以自动将这个服务器上的服务调度到另外一个主机上进行运行,无需进行人工干涉。那么,问题来了,要运维何用?

k8s可以更快的更新新版本,打包应用,更新的时候可以做到不用中断服务,服务器故障不用停机,从开发环境到测试环境到生产环境的迁移极其方便,一个配置文件搞定,一次生成image,到处运行。。。

k8s的全生命周期管理

在k8s进行管理应用的时候,基本步骤是:创建集群,部署应用,发布应用,扩展应用,更新应用。

1、创建集群:为什么要使用集群?

有一句古话叫做三个臭皮匠,赛过诸葛亮,这就是创建集群的原因。。。

使用集群,create cluster是为了掩盖底层的无能,在各种环境中,底层的硬件各不相同,有的是各种低廉的服务器,有的各种云环境,有的是各种vm,有的各种host machine,要想屏蔽底层的细节,增强可靠性和稳定性,从而需要创建集群。

创建集群的好处就是,统一对外提供接口,无须进行各种复杂的调用;提供更好的可靠性,服务器宕机那么频繁,物理磁盘那么容易损坏,无须担心,集群统一进行调配;提供更好的性能,组合集群中各个机器的计算存储网络资源,提供更好的TPS和PS;提供横向扩容的能力,在进行横向扩容的时候,性能基本上能呈线性增长。

集群看起来很牛,那么创建起来很复杂么?并不会,在k8s只要使用两条指令就可以创建一个集群,一个是kubectl init进行初始化,创建一个master节点,第二条指令就是kubectl join xxx创建一个node节点,加入这个集群。

在这边可以看到k8s在物理上进行划分的时候,划分了两种类型的主机,一个master节点,主要用来调度,控制集群的资源等功能;而node节点,主要是用来运行容器的节点,也就是运行服务的节点。

其实集群都差不多,master用来控制,用来存储各种元数据,node节点是一个工作节点,真正来干活的;node节点定时与master进行通信,通过kubelet进程来汇报信息。

创建了集群,我要怎么看信息?如下:

2、 部署应用

使用集群的主要目标是啥?用来提供服务,让开发开发的应用程序能在集群上运行,从而需要让开发能运行一个应用来进行测试。

一条指令就能运行一个服务,有了image之后就是这么简单。所以,在开发完成程序之后,需要将程序打包成image,然后放到registry中,然后就能够运行应用了。

在部署完成应用之后,就可以看到应用的名称,期望状态是运行一个pod,当前有一个pod,活动的也是一个,还有启动的时间,那么什么是pod呢?

在k8s里面,集群调度的最小单元就是一个pod,一个pod可以是一个容器,也可以是多个容器,例如你运行一个程序,其中使用了nginx,使用mysql了,使用了jetty,那么可以将这三个使用在同一个pod中,对他们提供统一的调配能力,一个pod只能运行在一个主机上,而一个主机上可以有多个pod。

那么有人会问,为什么要使用pod,为什么不能直接使用容器呢?使用pod,相当与一个逻辑主机,还记得创建一个vm,在vm上运行几个进程么,其实道理是一样的,pod的存在主要是让几个紧密连接的几个容器之间共享资源,例如ip地址,共享存储等信息。如果直接调度容器的话,那么几个容器可能运行在不同的主机上,这样就增加了系统的复杂性。

3、发布应用

发布应用主要就是对外提供服务,可能会有人提出疑问,我都运行了服务,为什么还不能提供服务,这是因为在集群当中,创建的ip地址等资源,只有在同一个集群中才能访问,每个pod也有独一的ip地址,当有多个pod提供相同的服务的时候,就需要有负载均衡的能力,从而这里就涉及到一个概念就是service,专门用来提供服务的。

服务主要是用来提供外界访问的接口,服务可以关联一组pod,这些pod的ip地址各不相同,而service相当于一个复杂均衡的vip,用来指向各个pod,当pod的ip地址发生改变之后,也能做到自动进行负载均衡,在关联的时候,service和pod之间主要通过label来关联,也就是标签(-l表示为label)。

从而外界就可以访问此应用了,如下:

4、 扩容缩容

在业务上线之后,碰到了双十一怎么办?扩容。。。万剑归宗,只要有一个pod,那么就可以产生无数个pod。。。。

过了双十一怎么办,缩容。。。

横向扩展的能力。。每次扩容缩容的时候,这种会不会觉得很方便,一句话的事儿。。不用创建vm,不用去部署中间件,不用去各种修改配置,这就是自动化。。。

5、 更新

有新版本了,我要发布。。。那么。。。

滚动更新。。。根据新的image创建一个pod,分配各种资源,然后自动负载均衡,删除老的pod,然后继续更新。。。。不会中断服务。。。

更新错了怎么办,不怂,不会影响生产业务,回滚就好了。。。几秒钟的事儿。。。

后话

k8s的基本入门,其实算是一种用户视角,只是用来演示如何使用k8s,怎么提高了生产力而已。

在给客户演示的时候,为啥要选择k8s?主要就是如何提高了发布的效率,更新版本的效率,更方便更快捷的上线新版本。

但是在运维关注的视角下,这些远远不够。。。master?存储了哪些元数据,存储在etcd中?如何来进行监控?在很多很多系统情况下,怎么来部署k8s,是一个项目一个k8s还是一个k8s多个项目?等等一系列的问题。。。

原文:https://blog.csdn.net/TM6zNf87MDG7Bo/article/details/79621510

Kubernetes解决的问题:

1. 调度 - 容器应该在哪个机器上运行

2. 生命周期和健康状况 - 容器在无错的条件下运行

3. 服务发现 - 容器在哪,怎样与它通信

4. 监控 - 容器是否运行正常

5. 认证 - 谁能访问容器

6. 容器聚合 - 如何将多个容器合并成一个工程

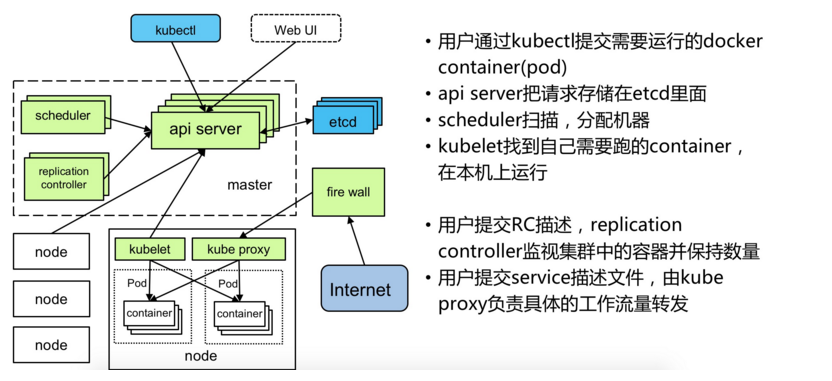

Kubernetes组件组成:

1. kubectl

客户端命令行工具,将接受的命令格式化后发送给kube-apiserver,作为整个系统的操作入口。

2. kube-apiserver

作为整个系统的控制入口,以REST API服务提供接口。

3. kube-controller-manager

用来执行整个系统中的后台任务,包括节点状态状况、Pod个数、Pods和Service的关联等。

4. kube-scheduler

负责节点资源管理,接受来自kube-apiserver创建Pods任务,并分配到某个节点。

5. etcd

负责节点间的服务发现和配置共享。

6. kube-proxy

运行在每个计算节点上,负责Pod网络代理。定时从etcd获取到service信息来做相应的策略。

7. kubelet

运行在每个计算节点上,作为agent,接受分配该节点的Pods任务及管理容器,周期性获取容器状态,反馈给kube-apiserver。

8. DNS

一个可选的DNS服务,用于为每个Service对象创建DNS记录,这样所有的Pod就可以通过DNS访问服务了。

---------------------

--------------------------------------------------------------------------------------------------

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· go语言实现终端里的倒计时

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 25岁的心里话

· 按钮权限的设计及实现