使用LM Studio部署DeepSeek 1.5B模型

下载LM Studio:

https://installers.lmstudio.ai/win32/x64/0.3.9-6/LM-Studio-0.3.9-6-x64.exe

安装LM Studio:

略

打开LM Studio

设置语言

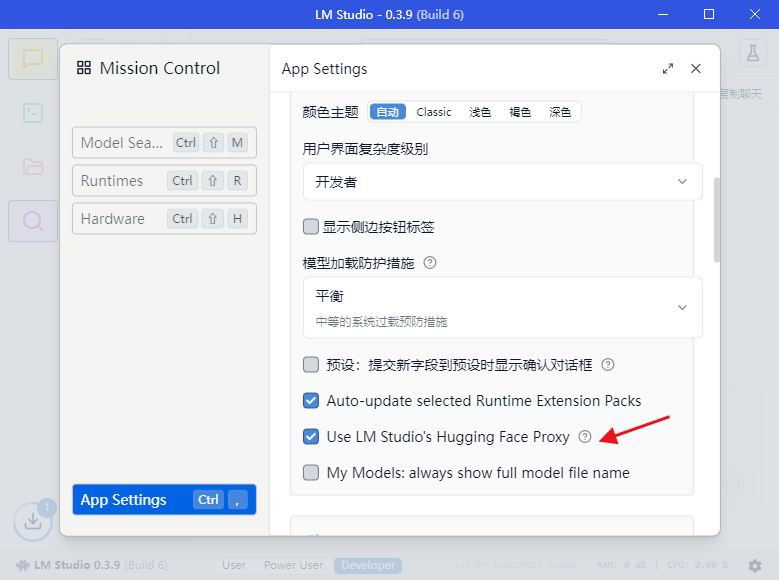

启用内置代理,用于下载模型,否则大概率在Model Search中看不到模型信息,无法下载模型

模型下载,两种方式:

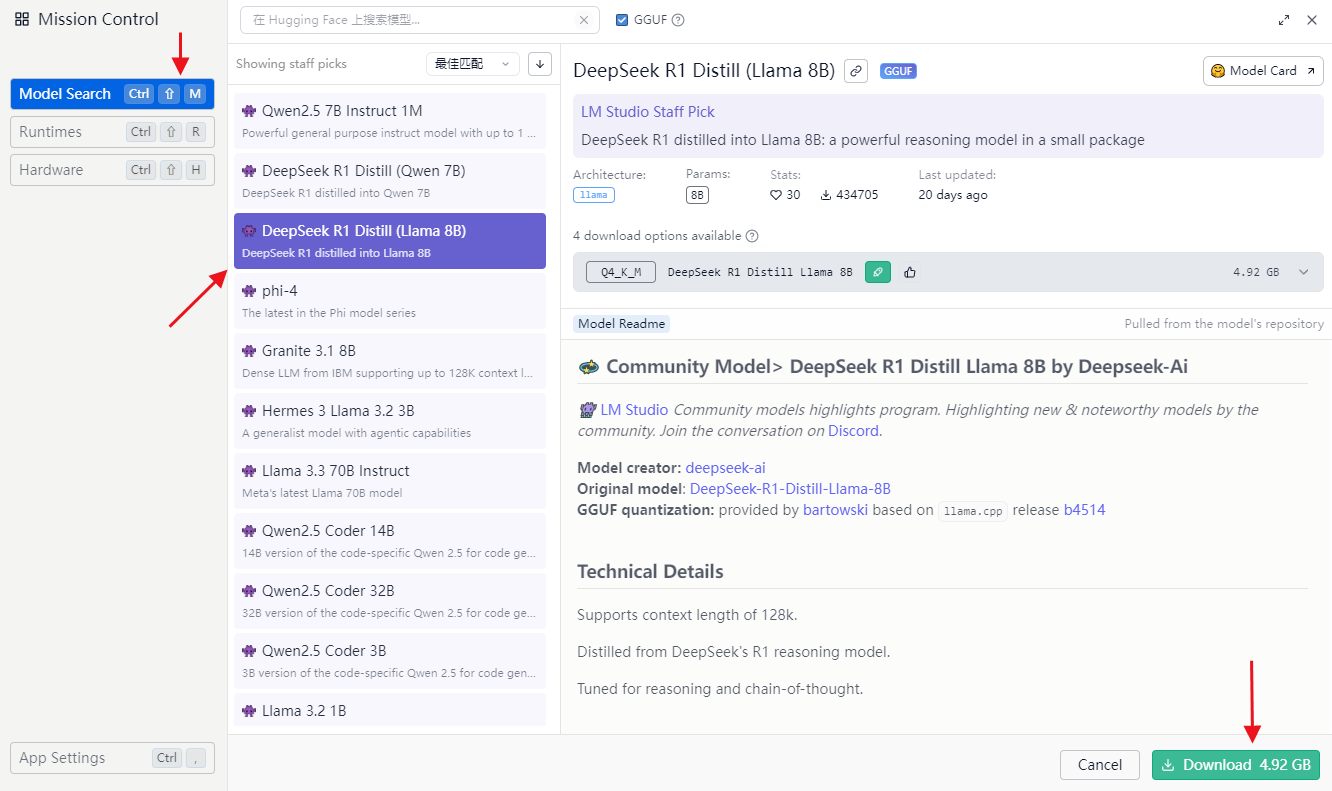

第一种,通过LM Studio自动下载

在Model Search中选择自己要用的模型即可下载(需要勾选上面提到的proxy)

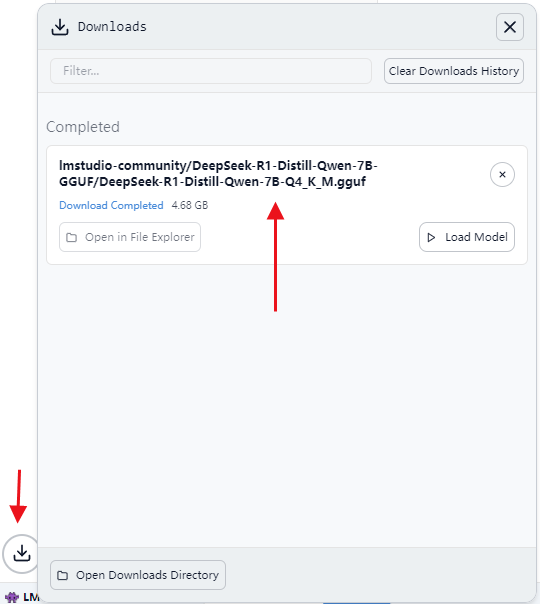

下载完成的效果

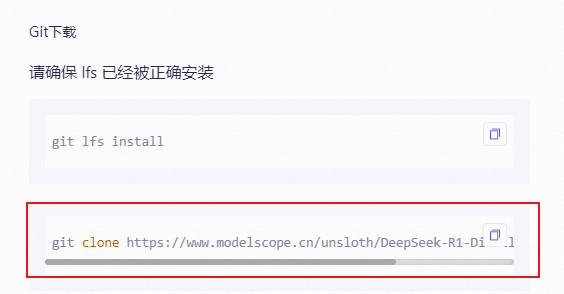

第二种,手动下载模型

通过huggingface.co或modelscope.cn等网站找到需要的模型

根据网页提示,使用git下载

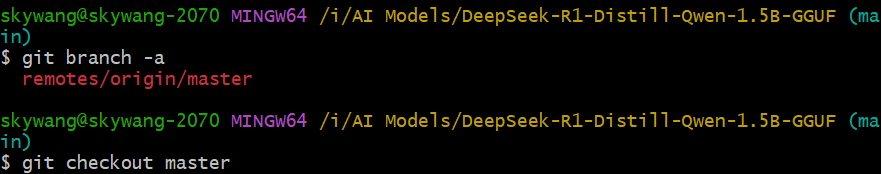

在LM Studio存放模型的文件夹中新建一个目录,以deepseek为例,确保模型路径为<LM Studio模型目录>/<模型发布者>/<具体某种模型>/xxxxx.GGUF,否则识别不到模型路径

创建deepseek目录

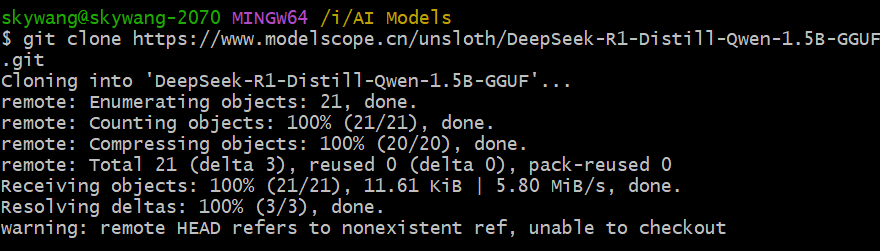

在deepseek目录下使用git下载,由于没有指定分支,所以只下载了部分文件

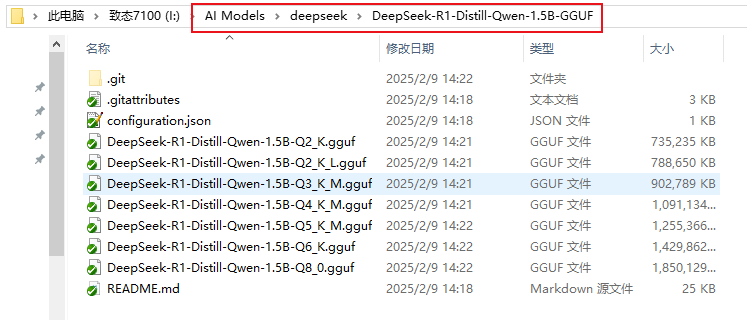

进入git创建的目录,然后使用checkout补全剩余文件,文件比较大下载需要点时间,另外实际只需下载仓库中某个GGUF文件即可,例如DeepSeek-R1-Distill-Qwen-1.5B-Q4_K_M.gguf

下载完仓库的效果,里面包含多个GGUF格式的模型

使用模型

在聊天窗口上面选一个模型加载

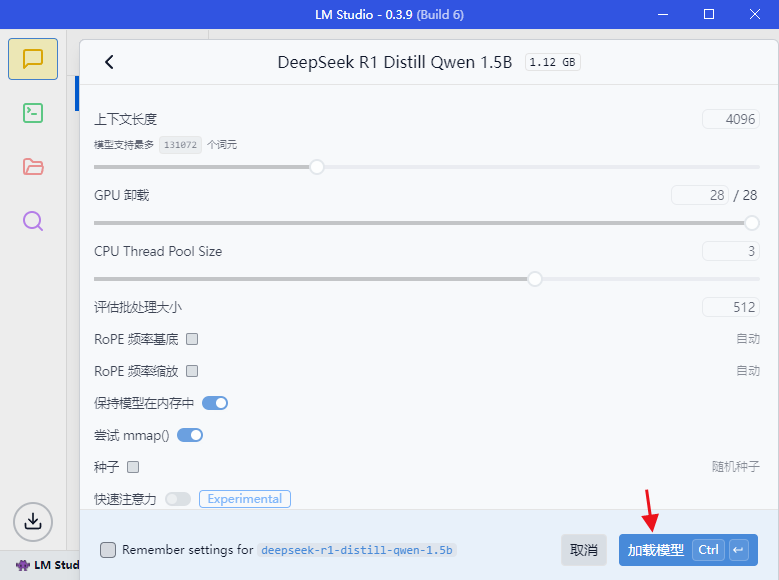

不修改默认参数,直接加载即可

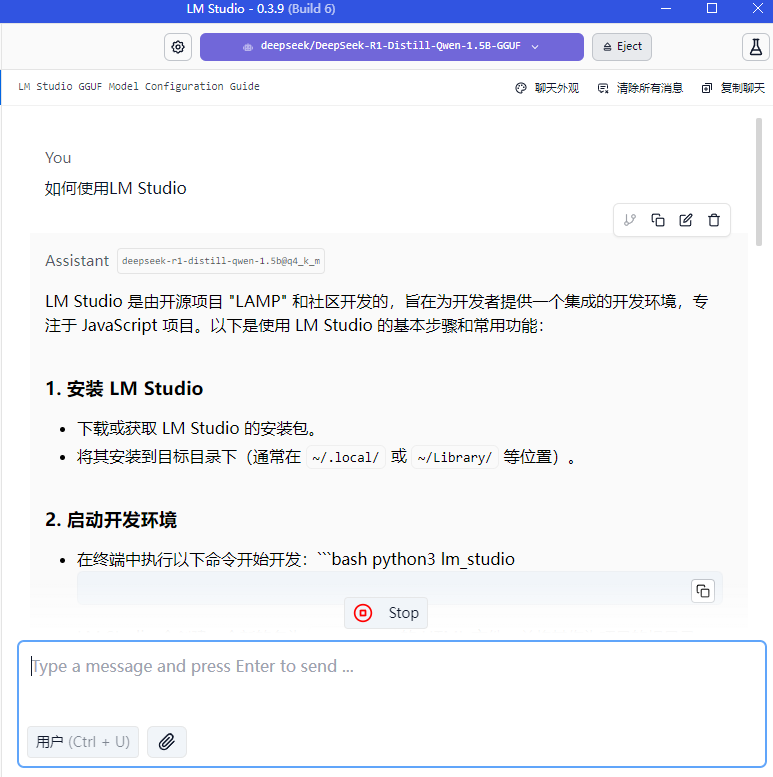

现在可以和模型互动了

作为web后端部署

这种部署方式是作为浏览器插件后端来使用的,那些插件会根据用户提问去搜索网页,然后让模型分析

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 三行代码完成国际化适配,妙~啊~

· .NET Core 中如何实现缓存的预热?