【信息论】信息熵、损失熵、噪声熵和互信息量

【信息论】信息熵、损失熵、噪声熵和互信息量

原文链接:https://www.cnblogs.com/Baiyug/p/16908846.html

1 信息熵#

信息熵(entropy)表征了某个信息的平均不确定度,是信息自信息量的数学期望。例如,某个信源发出L个信息序列(即L个信息符号),每个信息符号的取值有m个

这里的 是个抽象的概念,实际上一个符号就代表一个码元,每个码元由比特位构成,也就是由0,1序列构成。

怎么理解?

就是每个信息符号可能取的值,比如说001,010或111等等,注意,一个信息符号只能取一个。

看个例题

接着上面那个例子,我们讨论第一个信息符号,假设的概率空间有

即,这个符号可能取为,或,并且各个取值的概率为

我们求信息符号 的熵,用表示

计算结果如下

这是一个信息符号的熵,仅描述了一个信息符号的平均不确定度,要讨论一个信息序列的熵,则要更复杂一些,一般的对于无记忆信源,其信息序列的熵就是各个单符号信息熵的和;对于有记忆信源,其信息序列的熵的计算方法就比较复杂,这里不做讨论。

总之,符号信息熵表征为符号信息的平均不确定度,能够代表该符号所携带的信息量,或者说表示为符号携带的信息量的期望值。其值越大,表示符号最有可能携带的信息量越大。

符号信息熵不能无穷大,即存在最大值,当该符号的各个取值的概率相等时,即取值等概分布的条件下,符号信息熵取得最大值,

表示符号能够取值的个数,在上面那个例子中, 就是的个数,即 ,所以在上述例子中,

2 有噪有损信道模型#

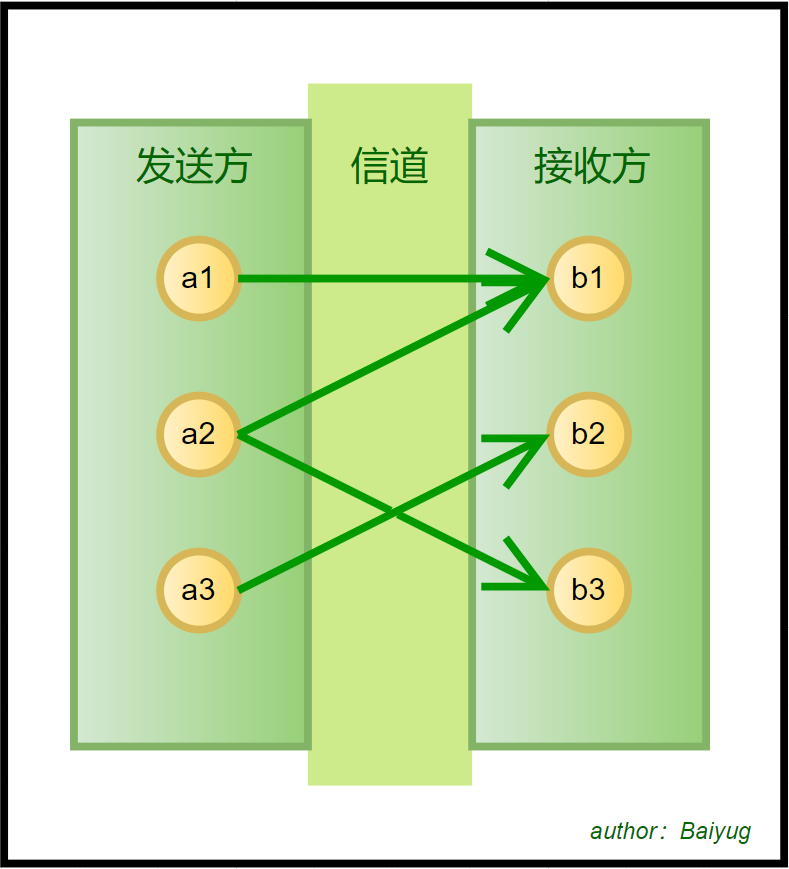

信息传输中,一个重要的步骤就是经过信道,在信道中,我们传输的信息可能会受到干扰(即环境噪声会影响我们的有效信息),另外,我们要传输的信息可能会在信道中损失。下面我用图解的方法给出一个单符号信息在有噪有损信道传输的模型。

可以看到,发送端如果发送的是,那么接收端有可能收到,也可能收到,这是因为噪声的干扰;再看接收端,如果收到的是,那么对应的发送端有可能是,也可能是,这代表或者发送的信息有一定的损失。

3 图解信息熵、损失熵、噪声熵和互信息的关系#

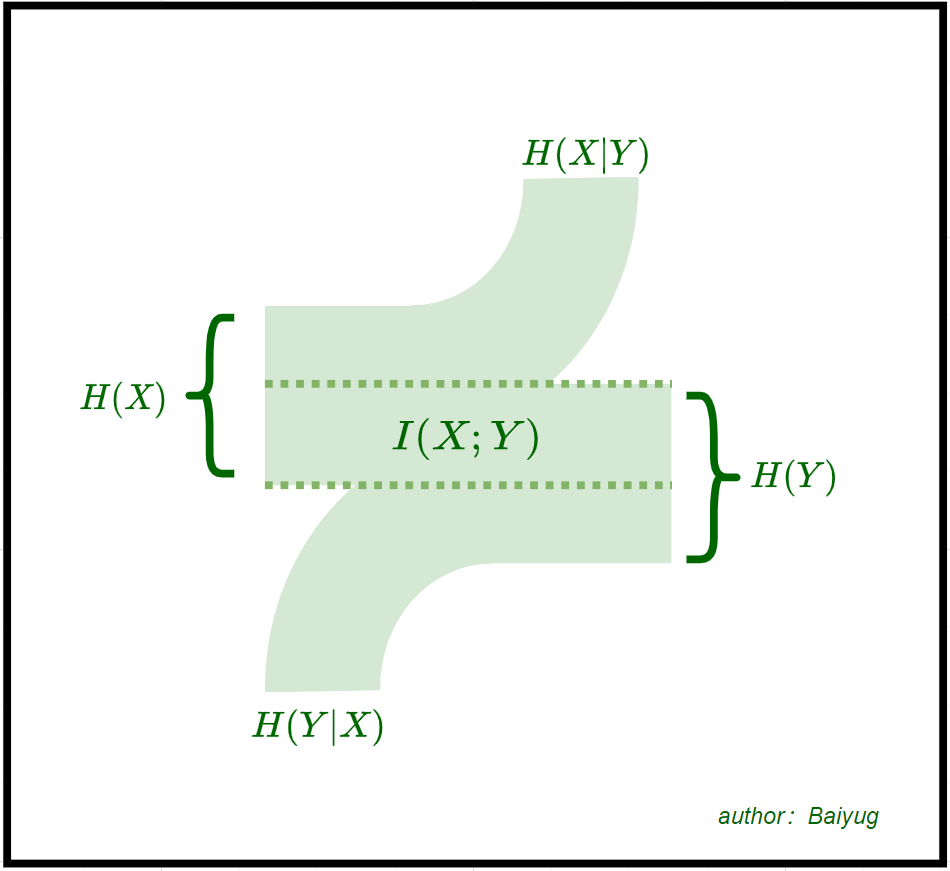

在上述的有噪有损信道中传输信息,涉及的信息量可以分成几类,

- 发送端的期望信息量,表示为,即发送端的信息熵

- 接收端的期望信息量,表示为,即接收端的信息熵

- 传输中损失的期望信息量,表示为,即损失熵,又叫疑义度

- 噪声包含的期望信息量,表示为,即噪声熵

- 在信道中传输的期望信息量,表示为,即联系发送端与接收端的平均互信息量

话不多说,直接上图

上图参考了一些其他的资料,从该图,我们可以形象的描述信息熵、损失熵、噪声熵和互信息之间的数量关系,并且理解什么叫损失,什么叫噪声干扰。

作者:Baiyug

出处:https://www.cnblogs.com/Baiyug/p/16908846.html

版权:本作品采用「署名-非商业性使用-相同方式共享 4.0 国际」许可协议进行许可。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 从HTTP原因短语缺失研究HTTP/2和HTTP/3的设计差异

· 三行代码完成国际化适配,妙~啊~