k8s之Service详解-Service介绍

Service介绍

在k8s中,pod是应用程序的载体,我们可以通过pod的ip来访问应用程序,但是pod的ip地址不是固定的,这也就意味着不方便直接采用pod的ip对服务进行访问

为了解决这个问题,k8s提供了service资源,service会对提供同一个服务的多个pod进行聚合,并且提供一个统一的入口地址。通过访问service的入口地址就能访问到后面的pod服务。

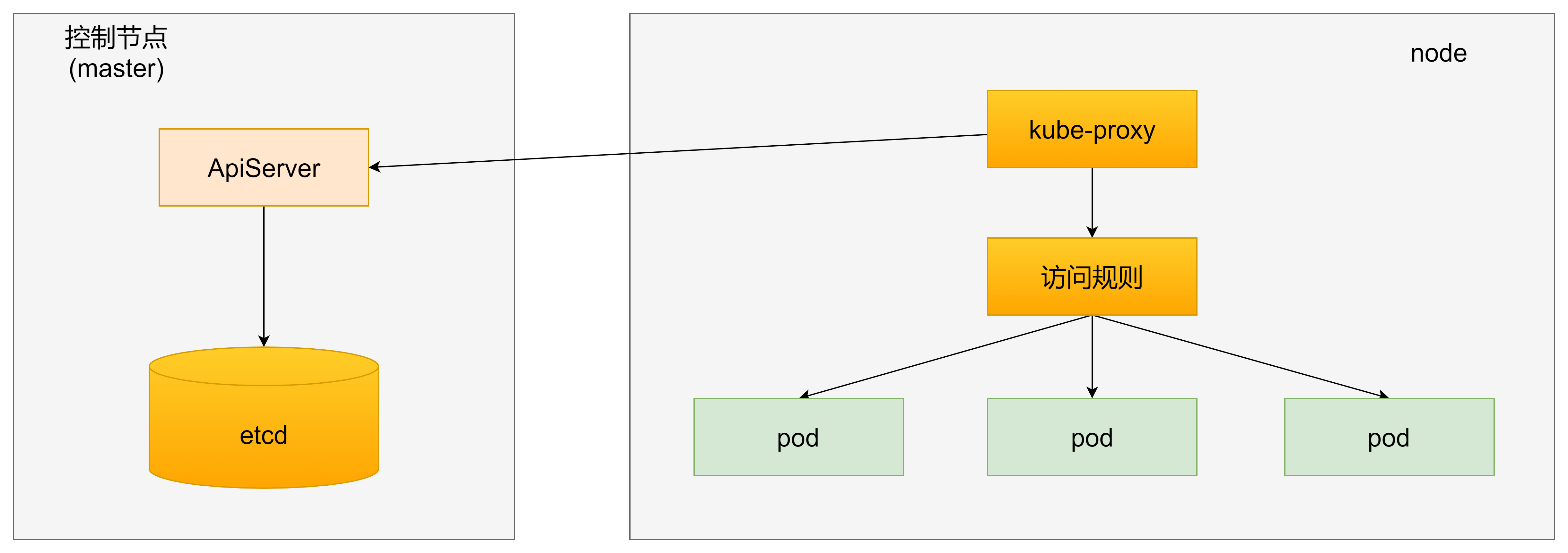

service在很多情况下只是一个概念,真正起作用的其实是kube-proxy服务进程,每个node节点上都运行一个kube-proxy服务进程,当创建service的时候会通过api-server向etcd写入创建的service信息,而kube-proxy会基于监听的机制发现这种service的变动,然后它会将最新的service信息转换成对应的访问规则。

kube-proxy三种工作模式

kube-proxy目前支持三种工作模式

userspace模式

userspace模式下,kube-proxy为service后端的每个service创建一个监听端口,发向cluster ip的请求被iptables规则重定向到kube-proxy监听的端口上,kube-proxy根据LB算法选择一个提供服务的pod并和其建立连接,以将请求转发到pod上。

该模式下,kube-proxy充当了一个四层负载均衡器的角色,由于kube-proxy运行在userspace中,在进行转发处理时会增加内核和用户空间之间的数据拷贝,虽然比较稳定,但是效率比较低。

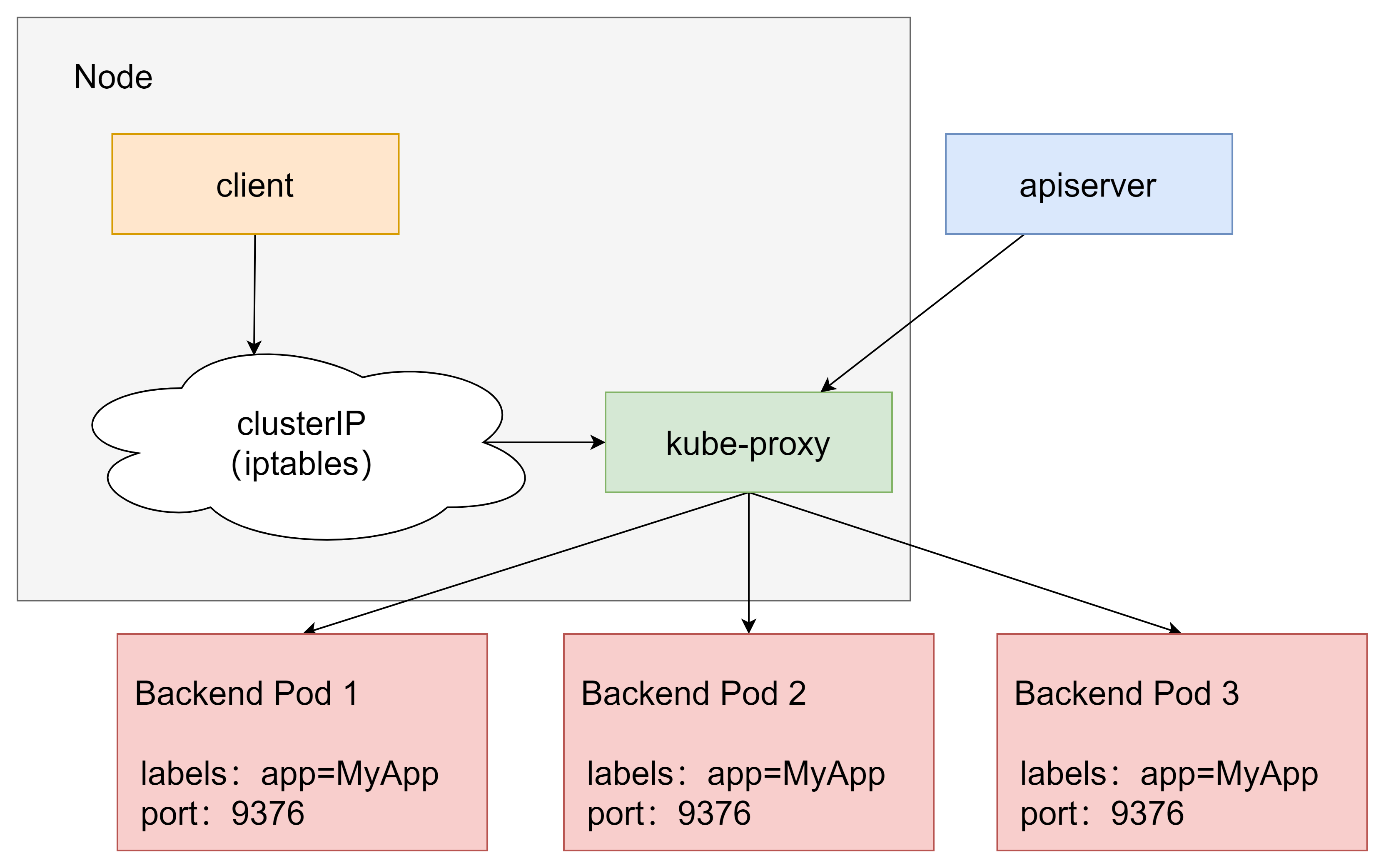

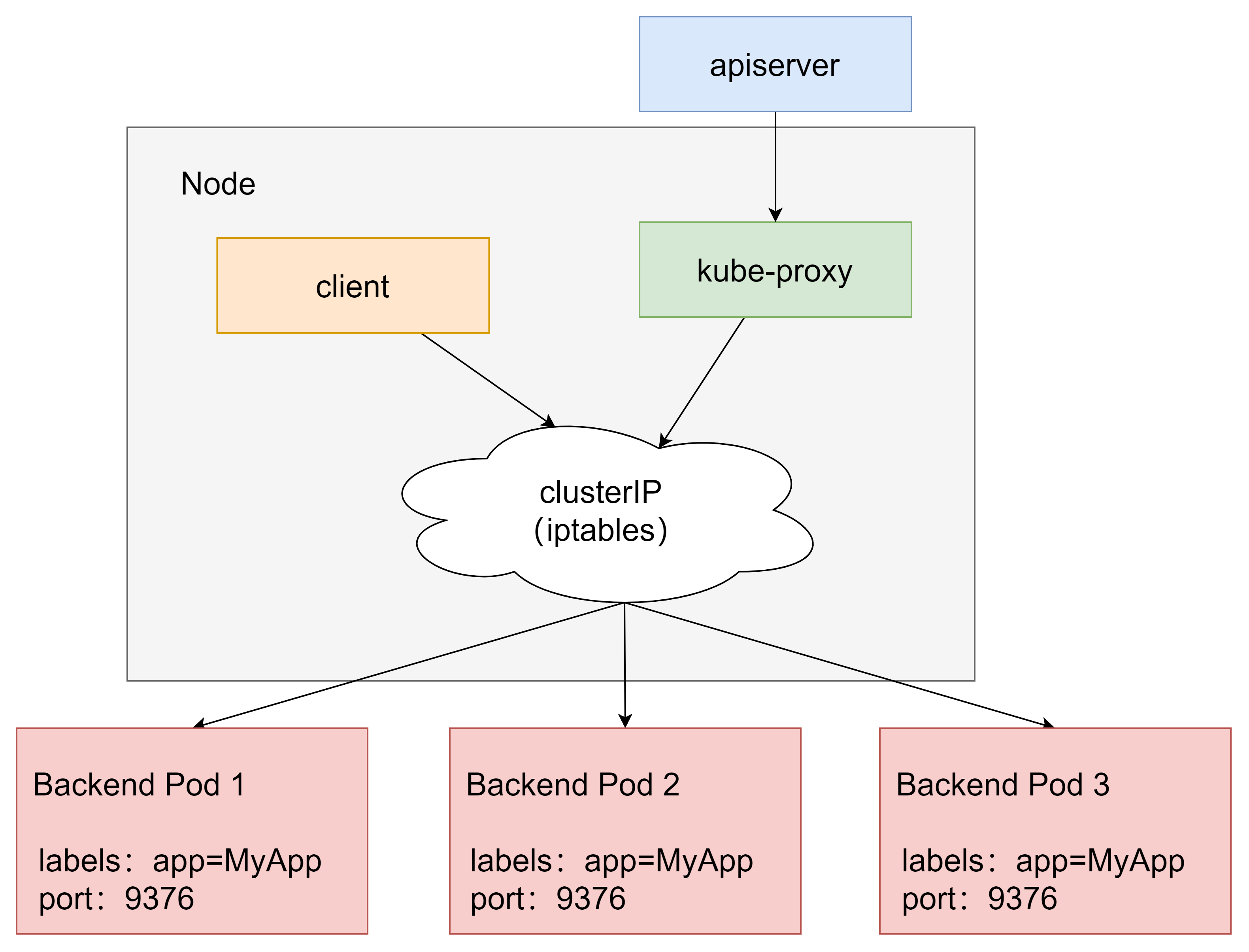

iptables模式

iptables模式下,kube-proxy为service后端的每个pod创建对应的iptables规则,直接将发向cluster ip的请求重定向到一个pod ip。

该模式下kube-proxy不承担四层负载均衡器的角色,只负责创建iptables规则。该模式的优点是较userspace模式效率更高,但不能提供灵活的LB策略,当后端pod不可用时也无法进行重试

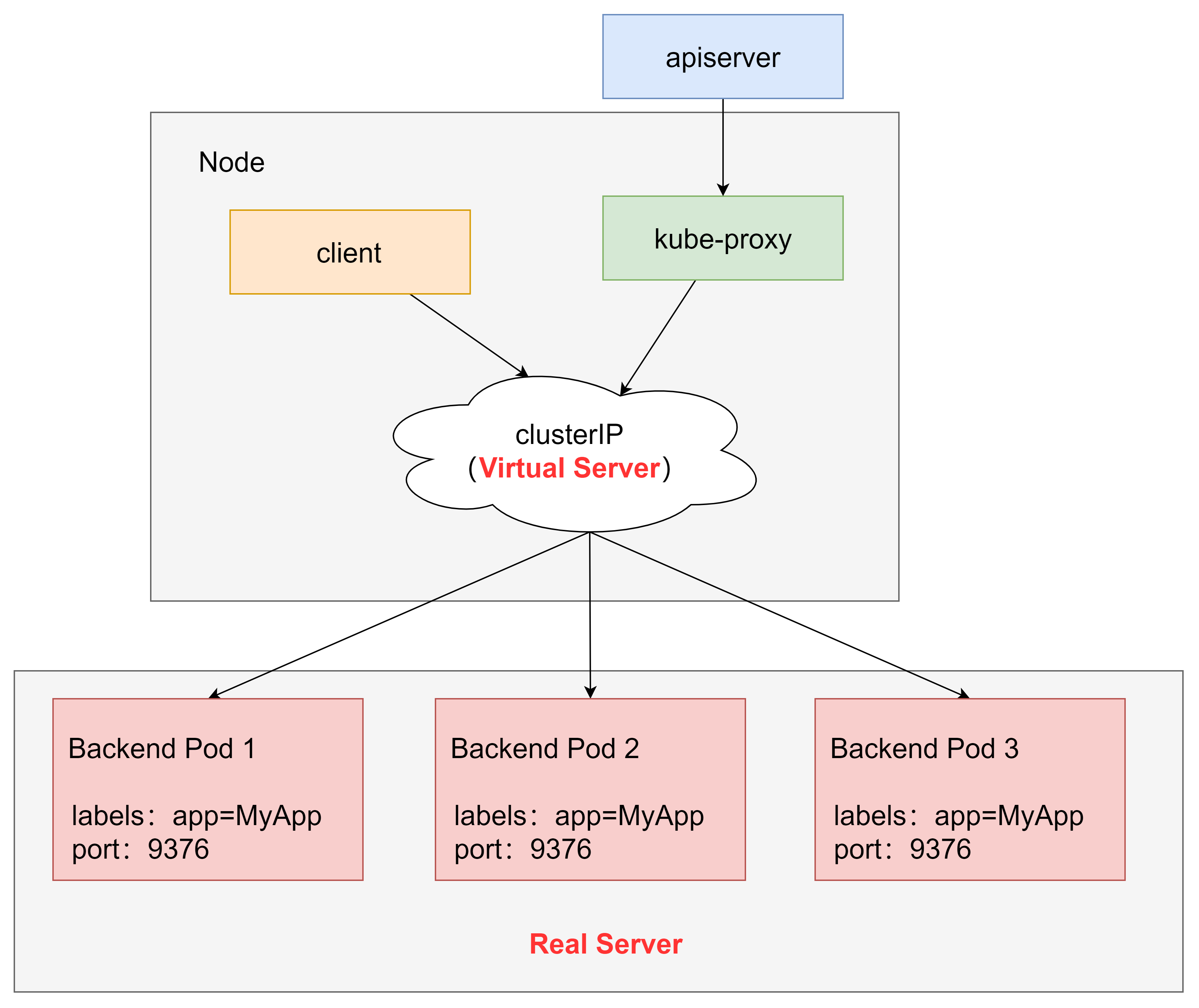

ipvs模式

ipvs模式和iptables类似,kube-proxy监控pod的变化并创建相应的ipvs规则,ipvs相对iptables转发效率更高。除此以外,ipvs支持更多的LB算法。

此模式必须安装ipvs内核模块,否则会降级为iptables,如何安装已经在k8s集群环境搭建中阐述

开启ipvs

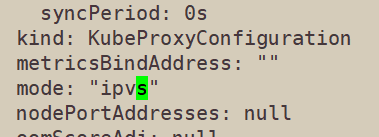

[root@master ~]# kubectl edit cm kube-proxy -n kube-system

找到里面的mode字段,将内容修改为ipvs

删除kube-proxy的pod并重建

[root@master ~]# kubectl delete pod -l k8s-app=kube-proxy -n kube-system pod "kube-proxy-ck9sg" deleted pod "kube-proxy-hlpd6" deleted pod "kube-proxy-jh9gq" deleted

查看ipvs,发现产生了一批规则

[root@master ~]# ipvsadm -Ln IP Virtual Server version 1.2.1 (size=4096) Prot LocalAddress:Port Scheduler Flags -> RemoteAddress:Port Forward Weight ActiveConn InActConn TCP 10.96.0.1:443 rr -> 192.168.145.131:6443 Masq 1 0 0 TCP 10.96.0.10:53 rr -> 10.244.0.8:53 Masq 1 0 0 -> 10.244.0.9:53 Masq 1 0 0 TCP 10.96.0.10:9153 rr -> 10.244.0.8:9153 Masq 1 0 0 -> 10.244.0.9:9153 Masq 1 0 0 UDP 10.96.0.10:53 rr -> 10.244.0.8:53 Masq 1 0 0 -> 10.244.0.9:53 Masq 1 0 0