深度学习相关理论

一、深度学习相关理论

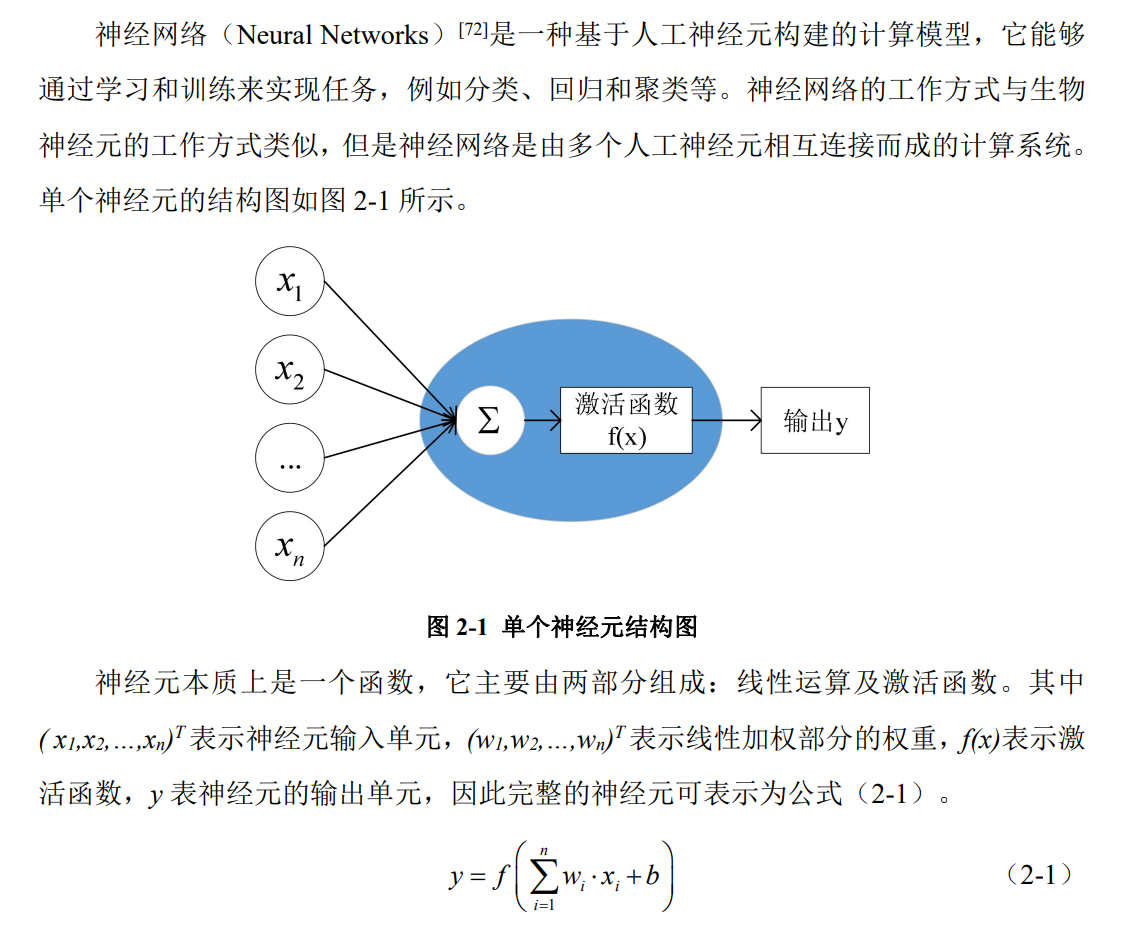

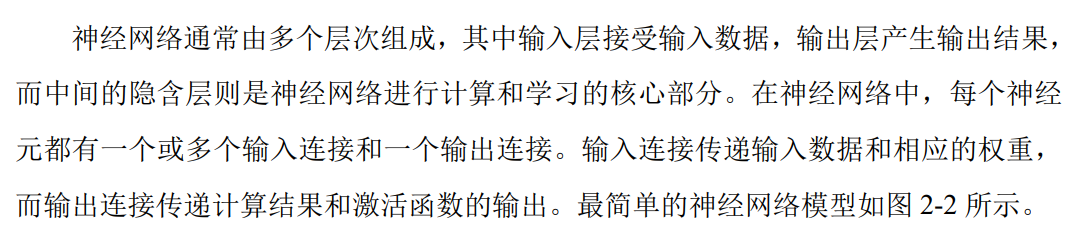

1.神经网络概述

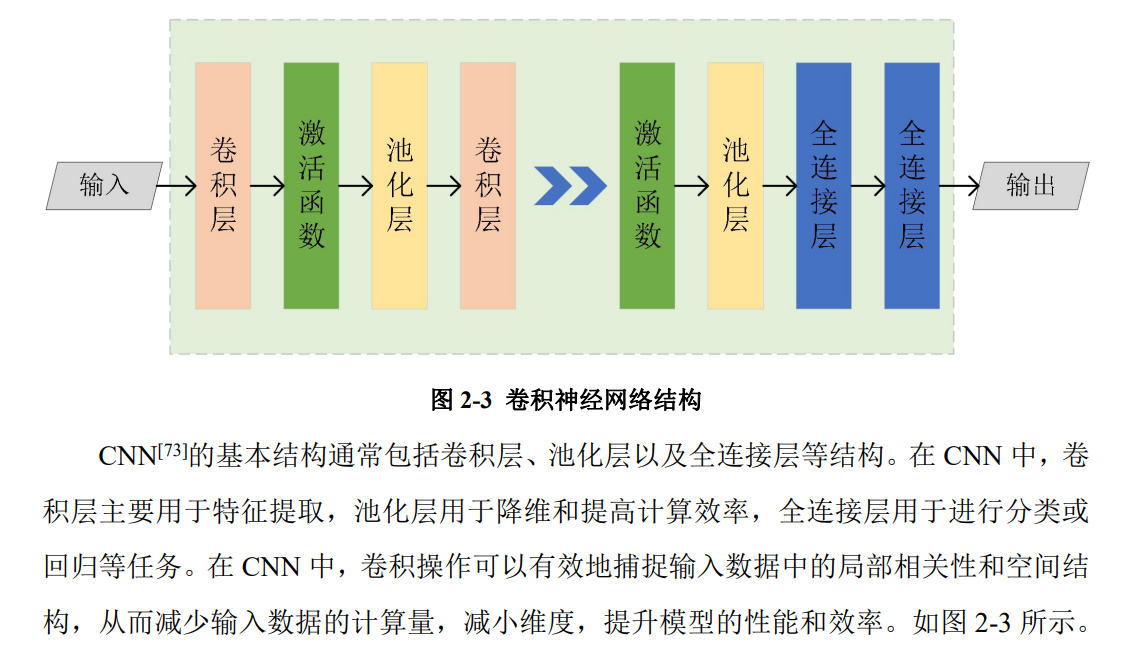

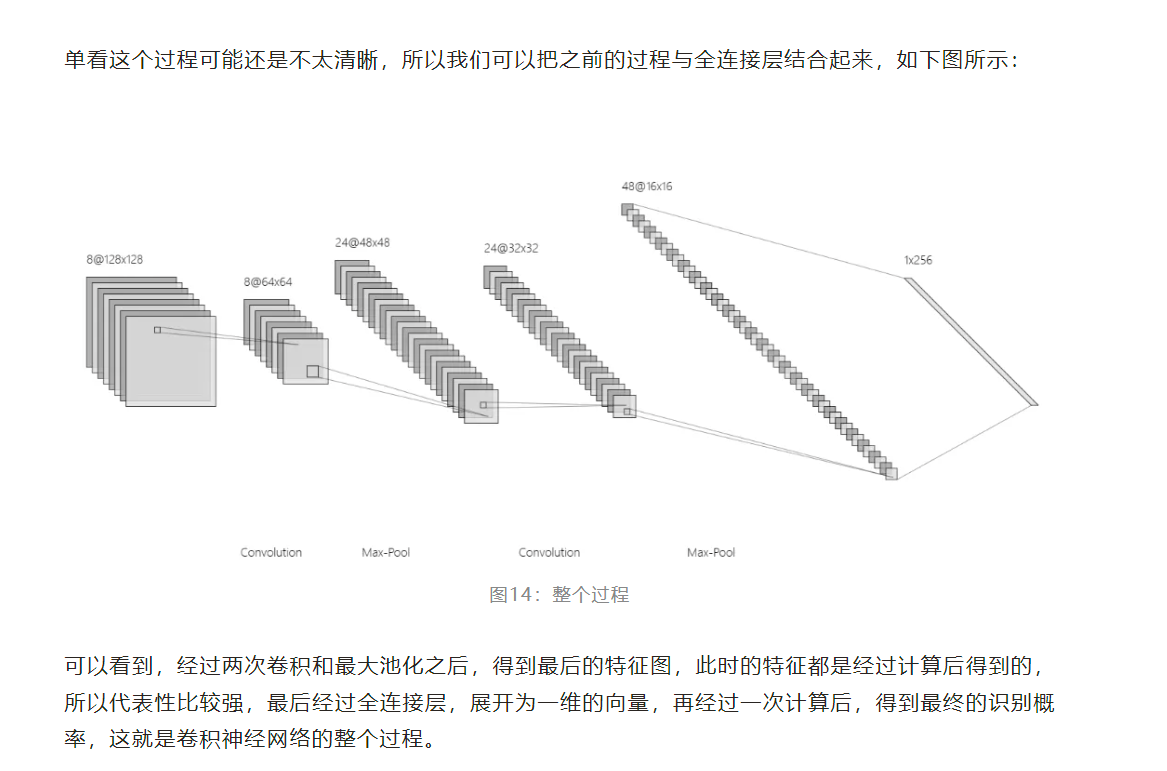

2. 卷积神经网络CNN

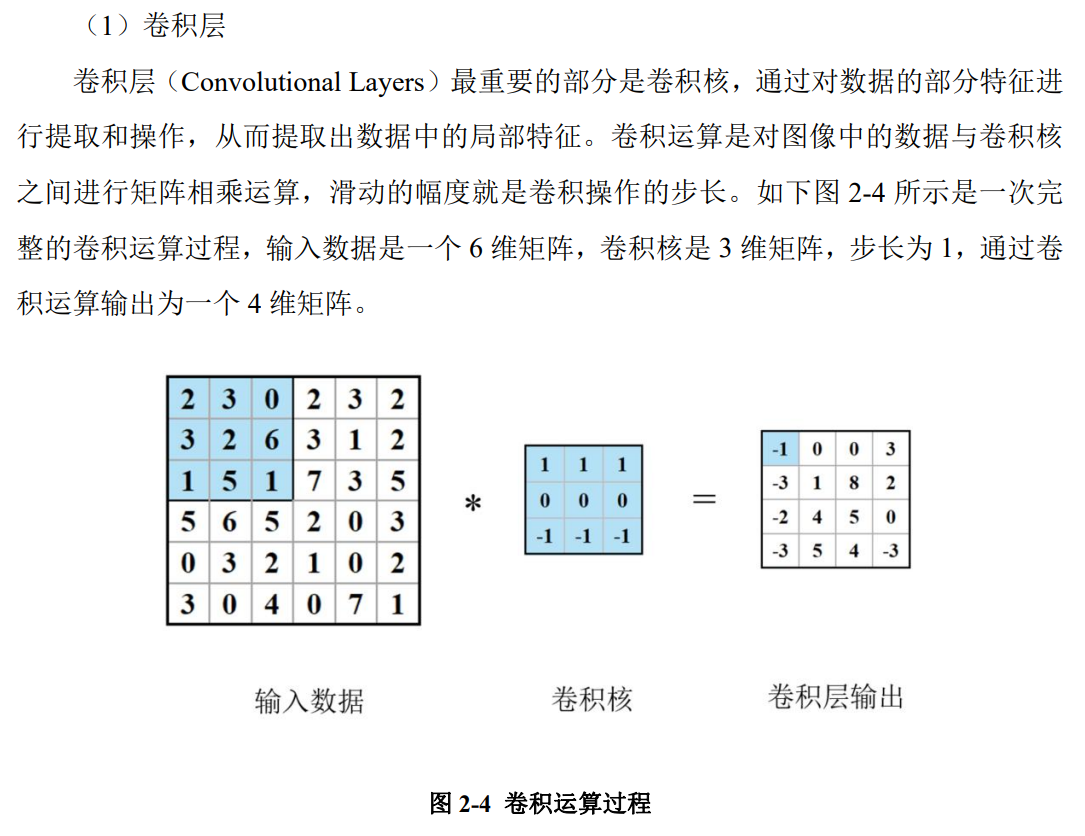

①卷积层——计算方法是大矩阵内部×小矩阵=较小矩阵,作用是特征提取

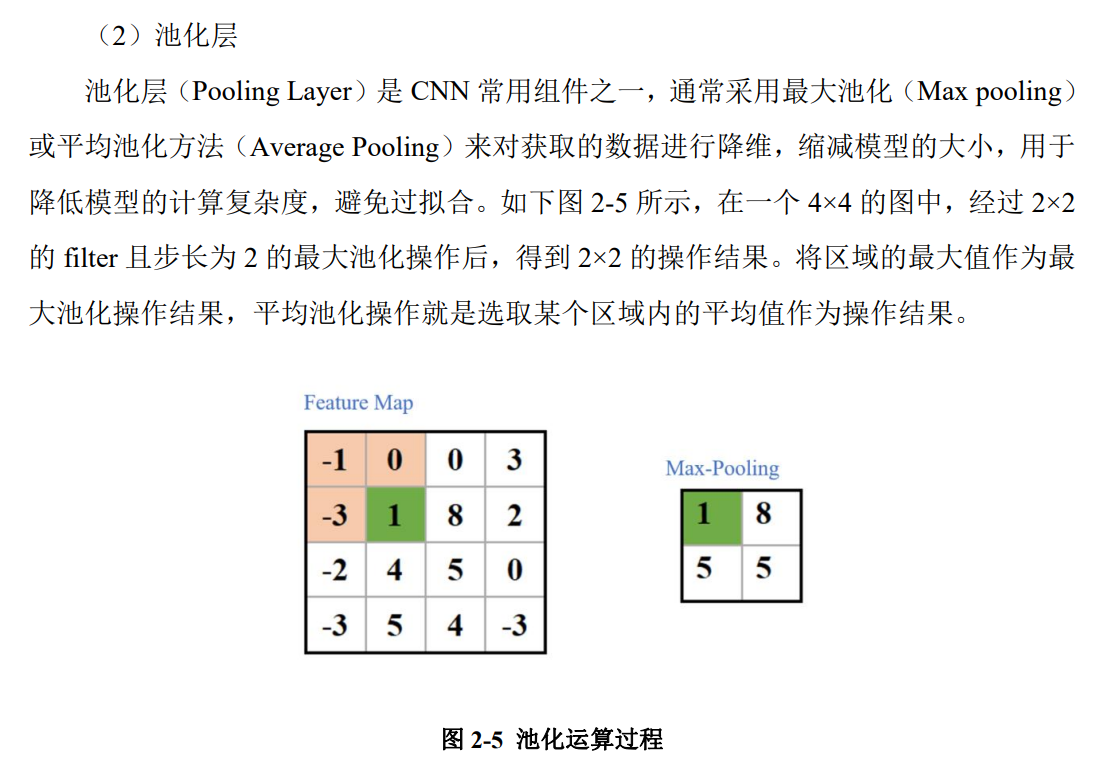

②池化层——计算方法是大矩阵通过选取最大值或是平均值变成小矩阵,作用是降维、提高计算效率,防止过拟合

Ⅰ. 最大池化;

Ⅱ. 平均池化;

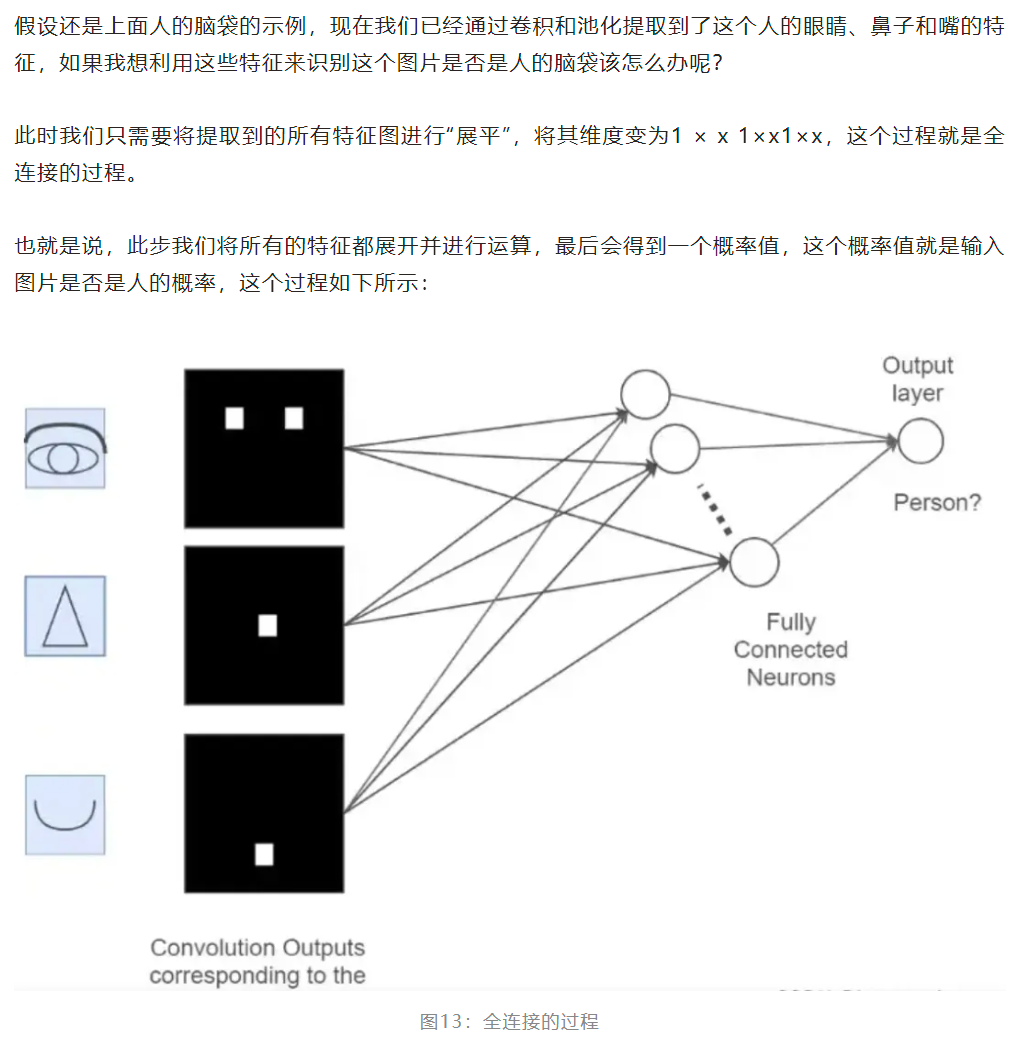

③全连接层——计算方法是将矩阵展开为一维向量,作用是综合之前层(如卷积层或池化层)提取的特征,起到输出最终结果的作用

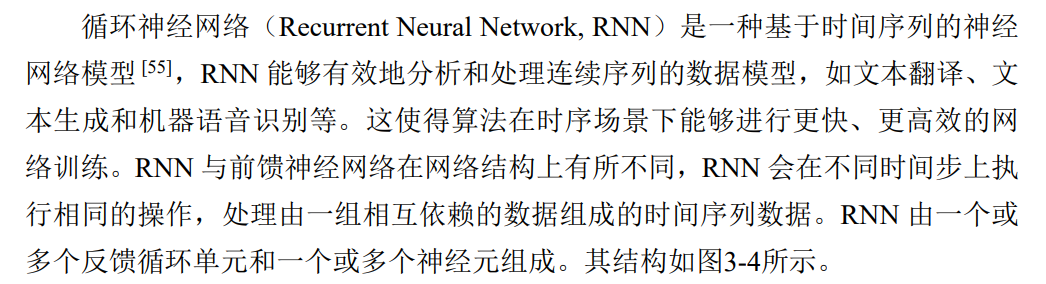

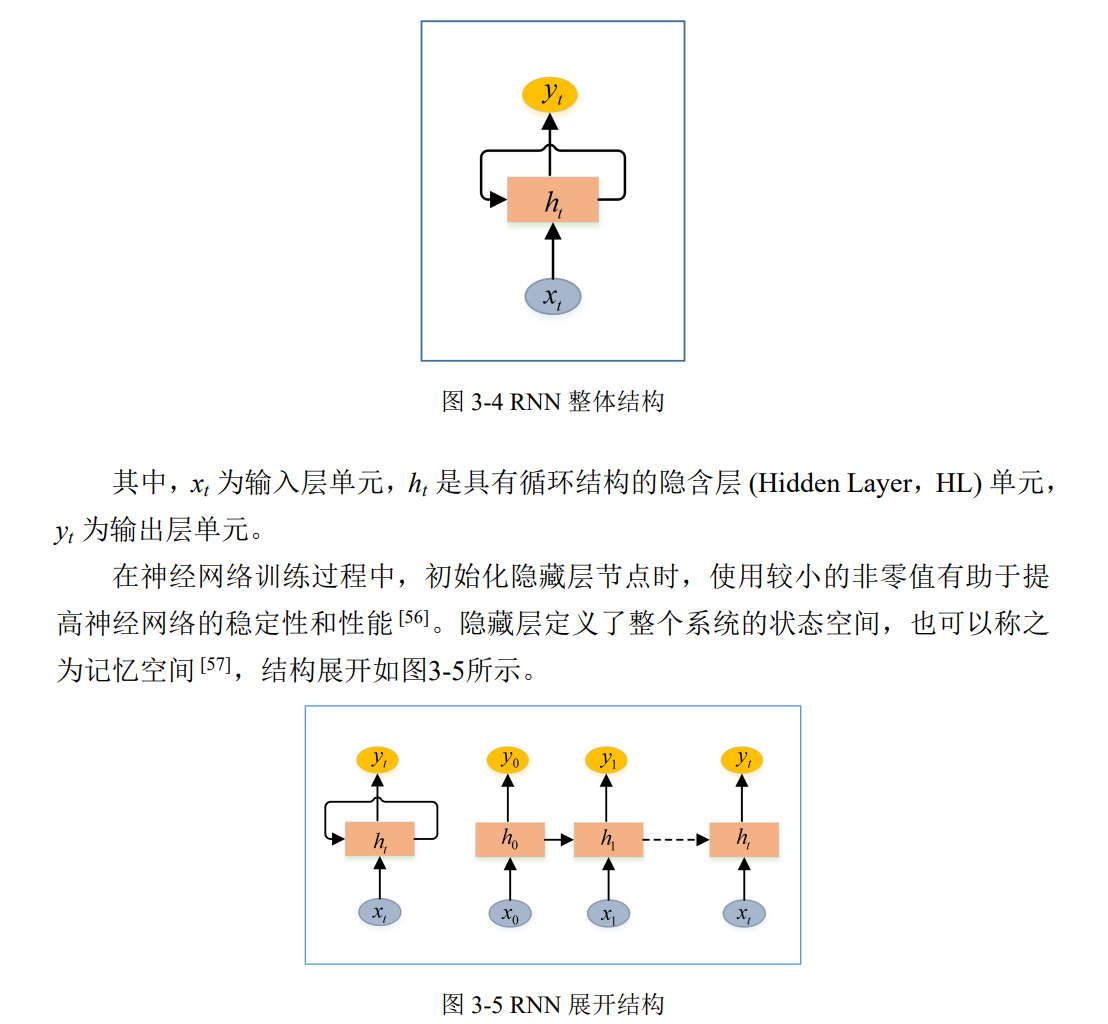

3. 循环神经网络RNN及其改进型LSTM(长短期记忆网络)

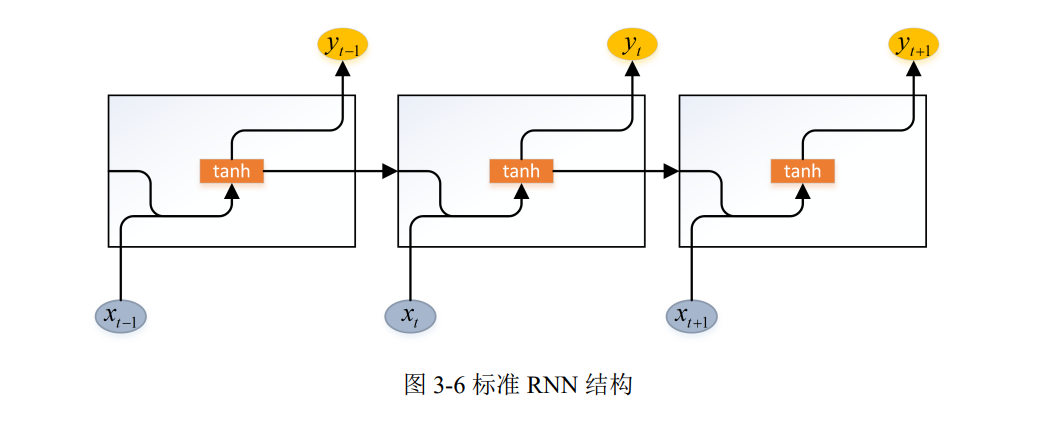

①RNN

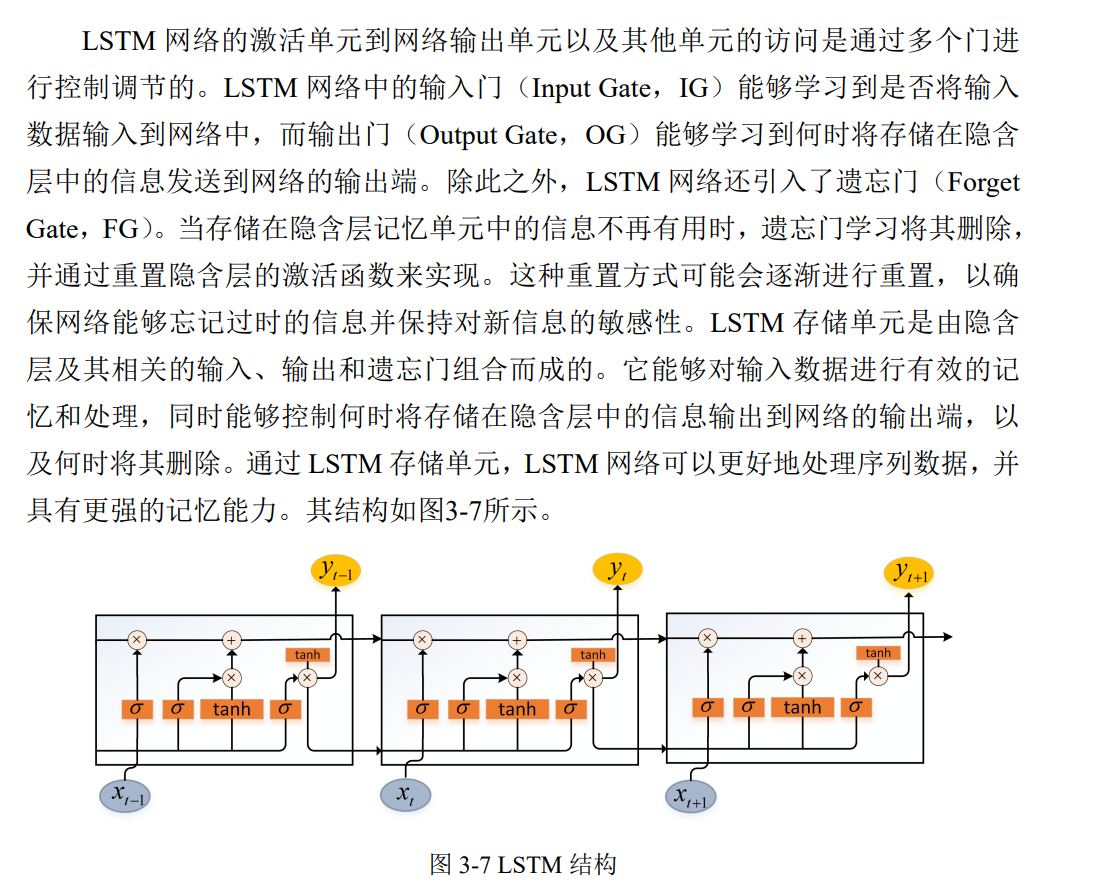

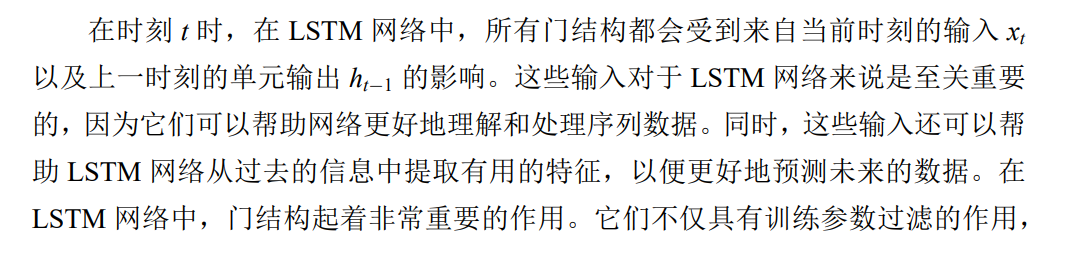

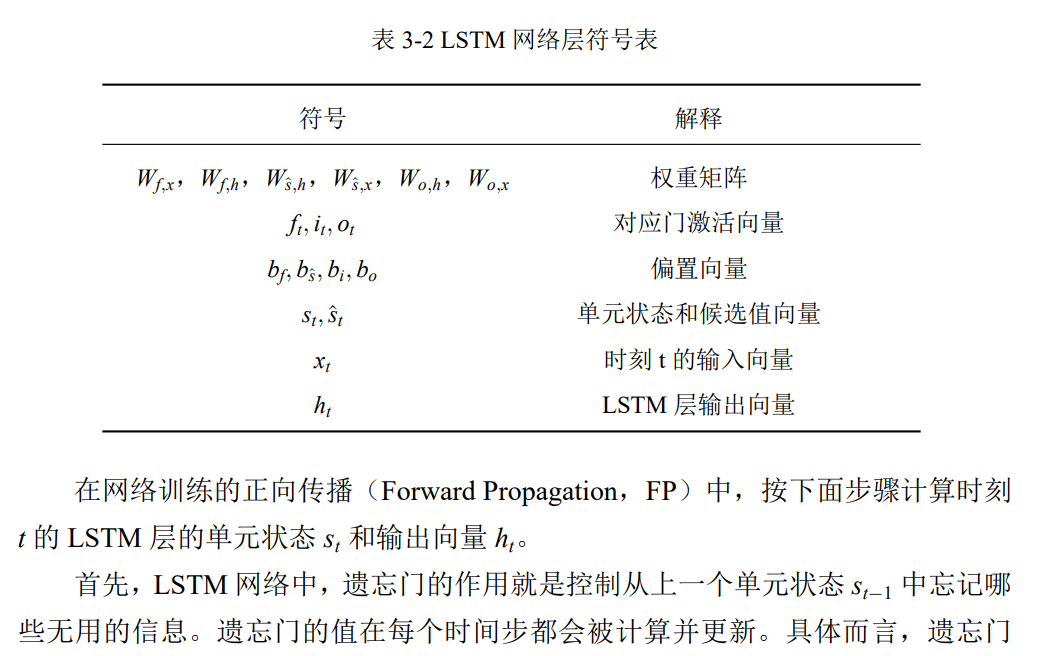

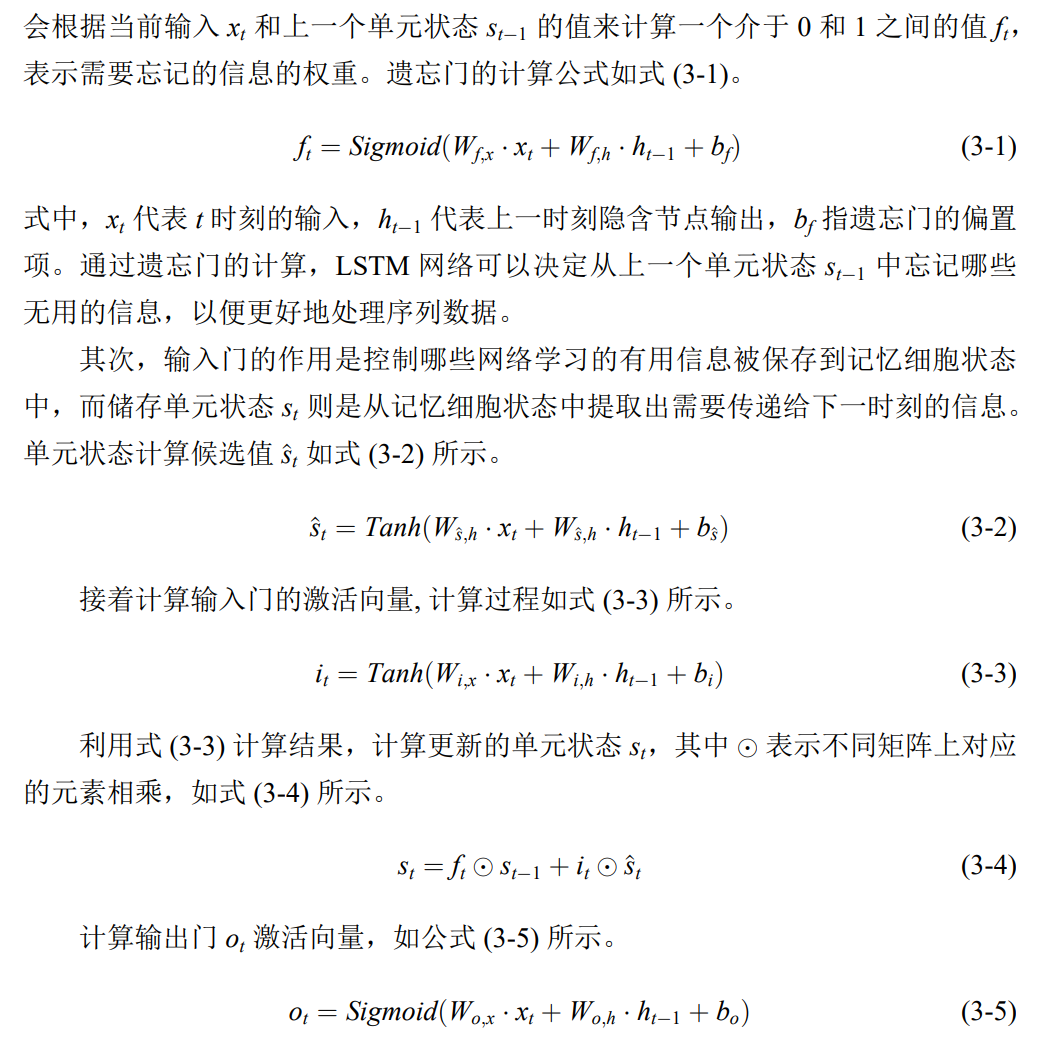

②LSTM

4. 激活函数——将输入信号转换为非线性的形式,使神经网络能够表示复杂的非线性关系,除此之外,还可以限制输出范围、缓解梯度消失问题

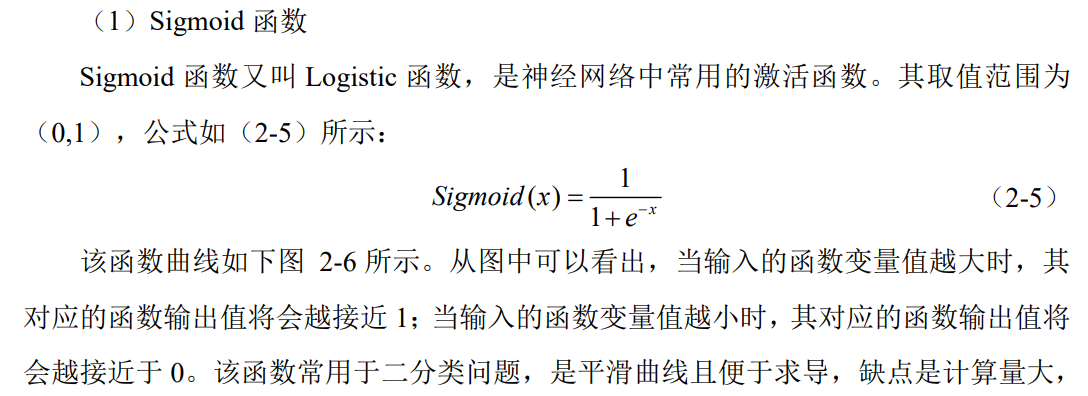

①Sigmoid函数——适用于二分类问题

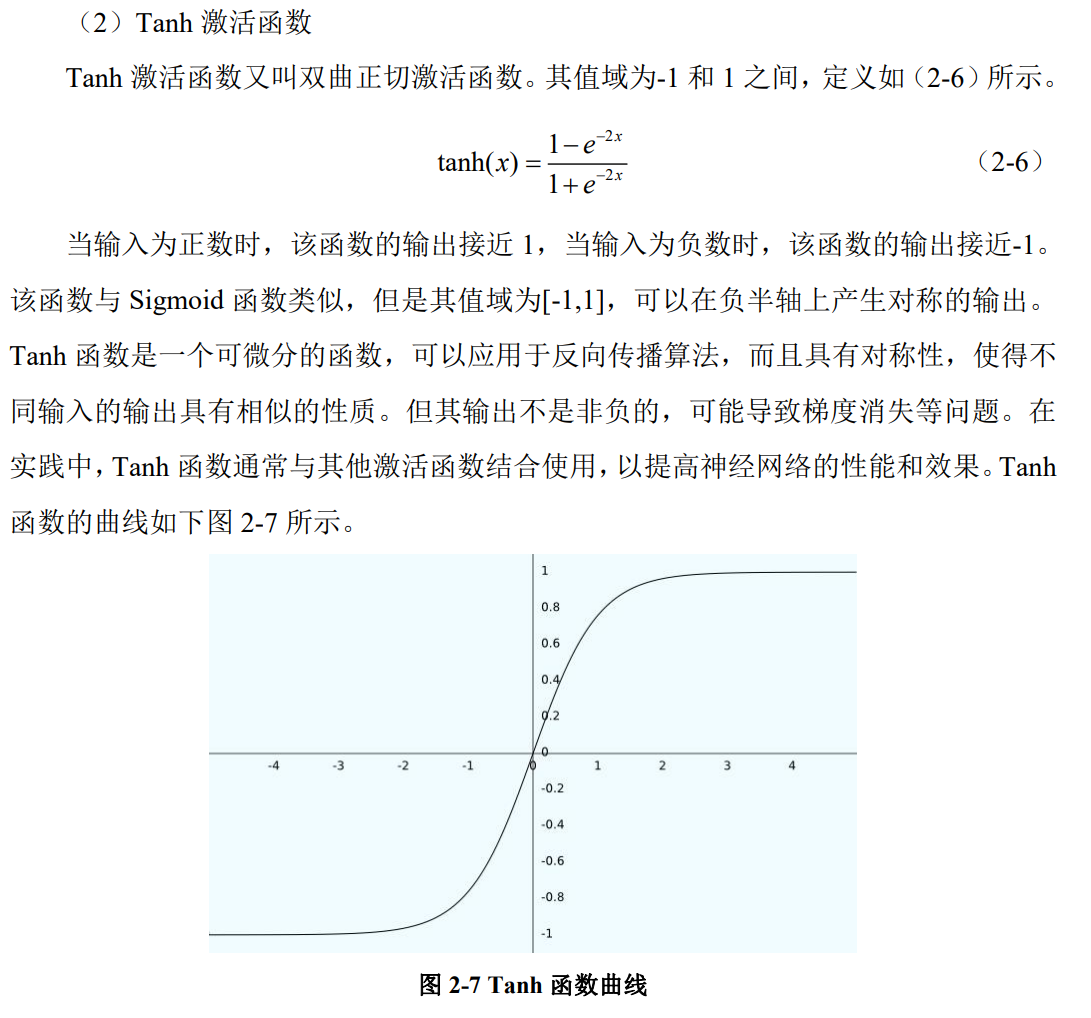

②Tanh激活函数——常用于隐藏层中,尤其在循环神经网络(RNN)和长短期记忆网络(LSTM)等结构中。然而,由于其存在梯度消失的问题,有时候也会被其它激活函数如 ReLU 所取代

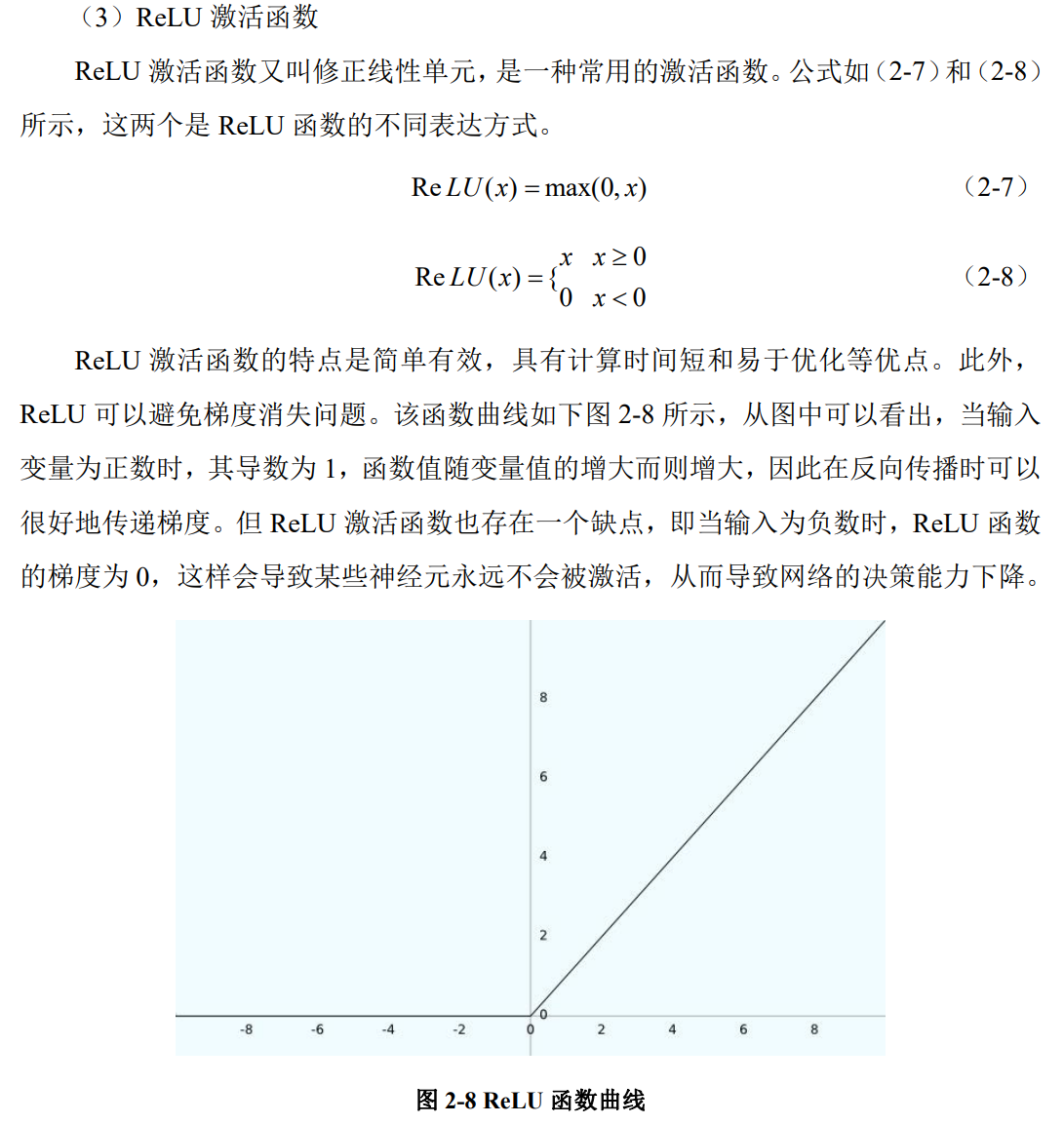

③ReLU激活函数——计算简单,可以缓解梯度消失,缺点是无法对负值做出有效反馈

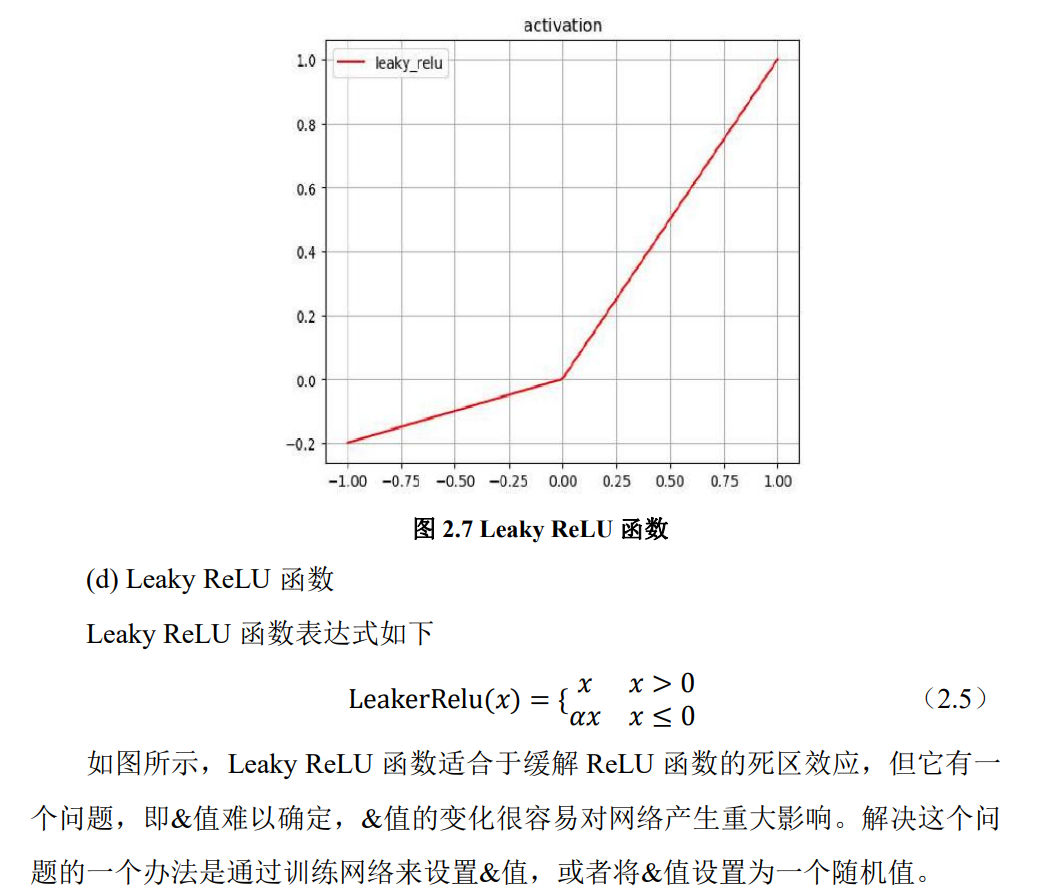

④Leaky ReLU函数

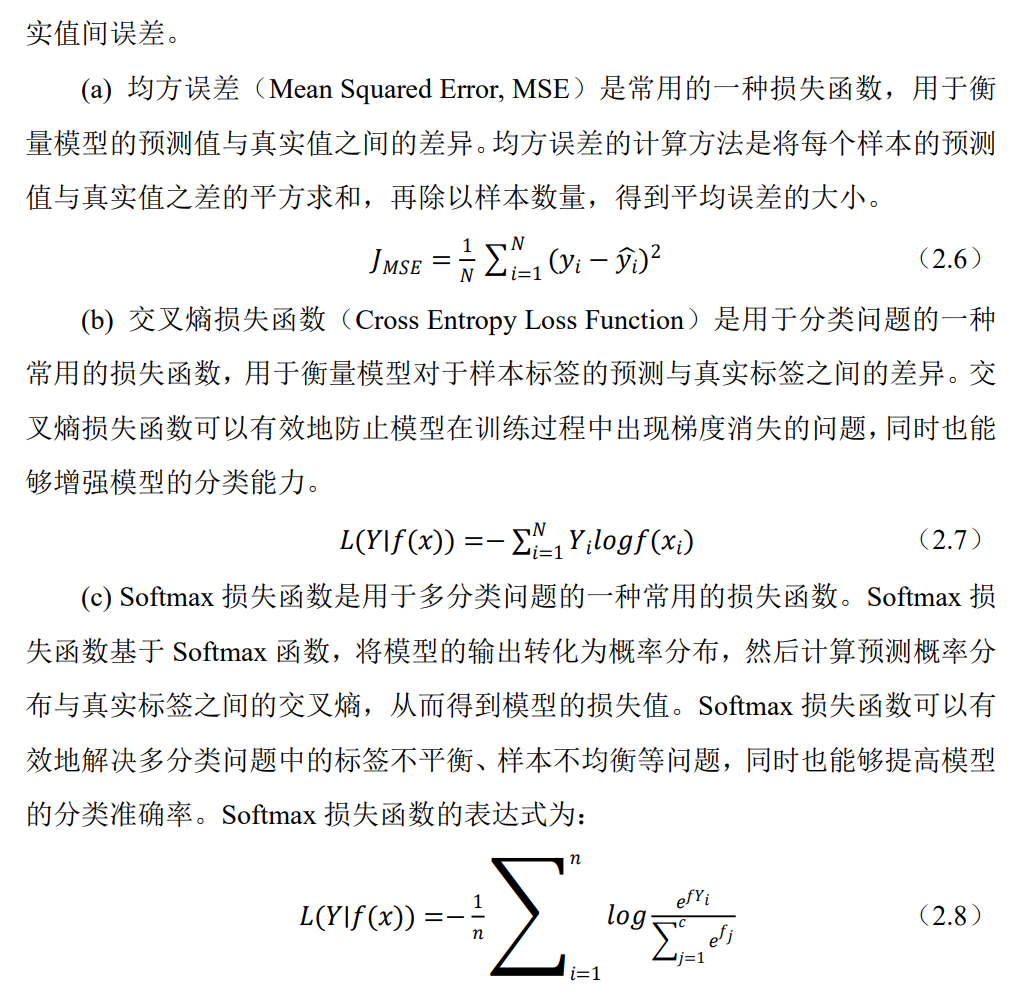

5. 损失函数——衡量预测值和真实值之间的差异,结合优化算法(如梯度下降),更新模型参数

5. 注意力机制

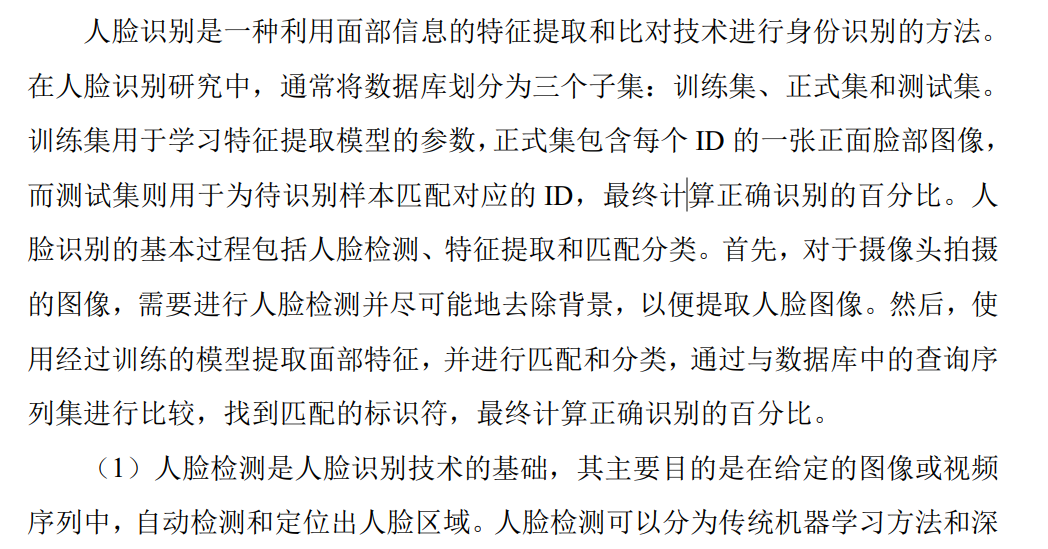

二、人脸识别

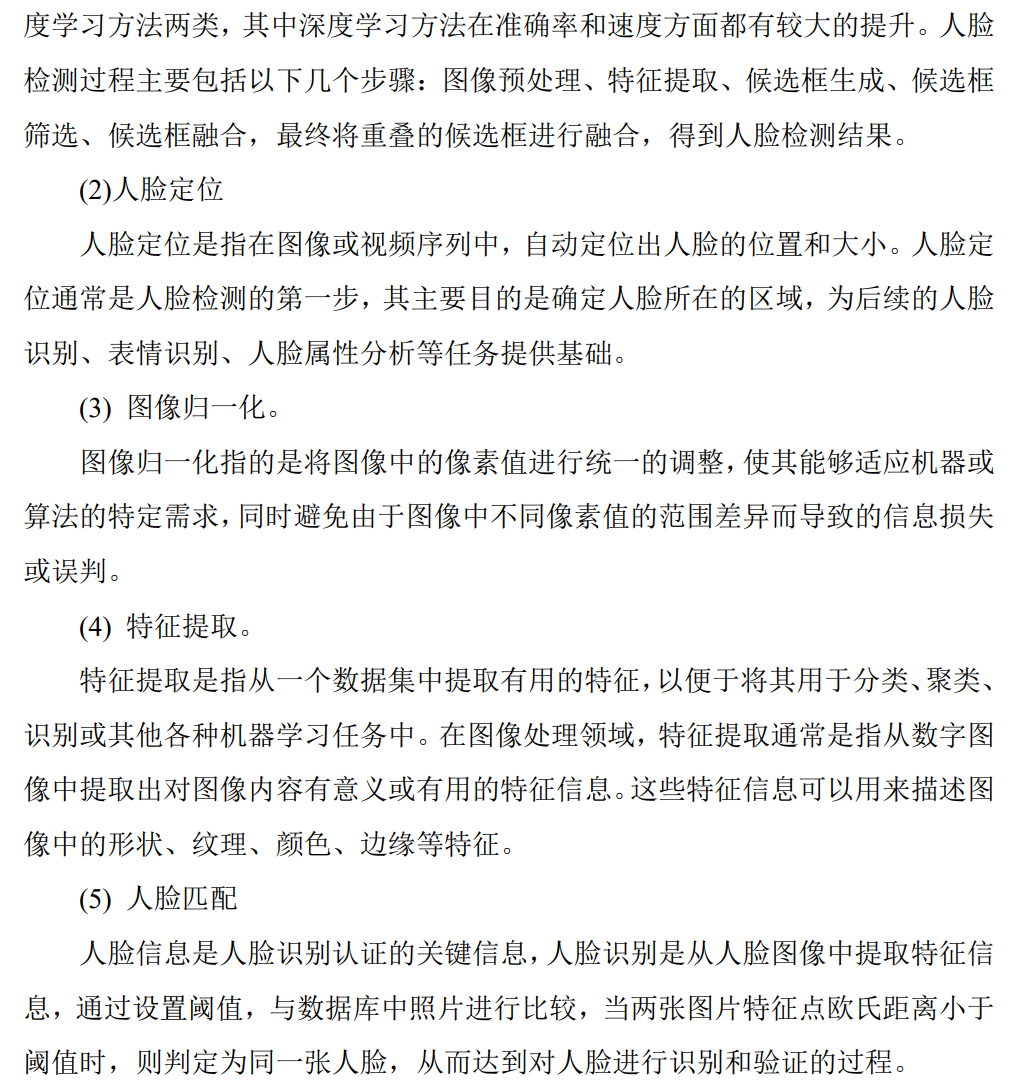

1. 人脸识别基本流程

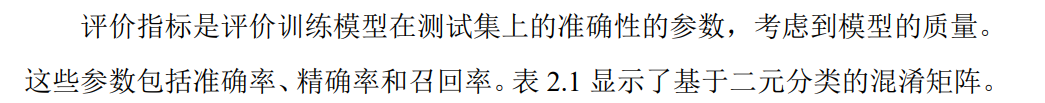

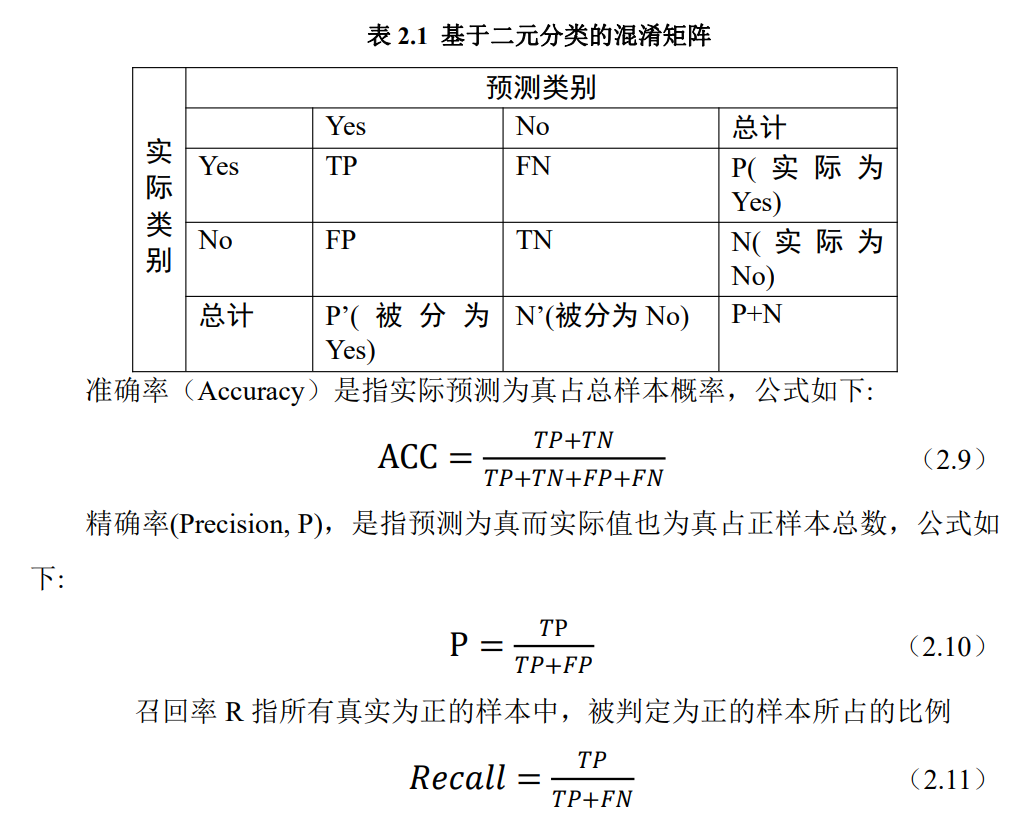

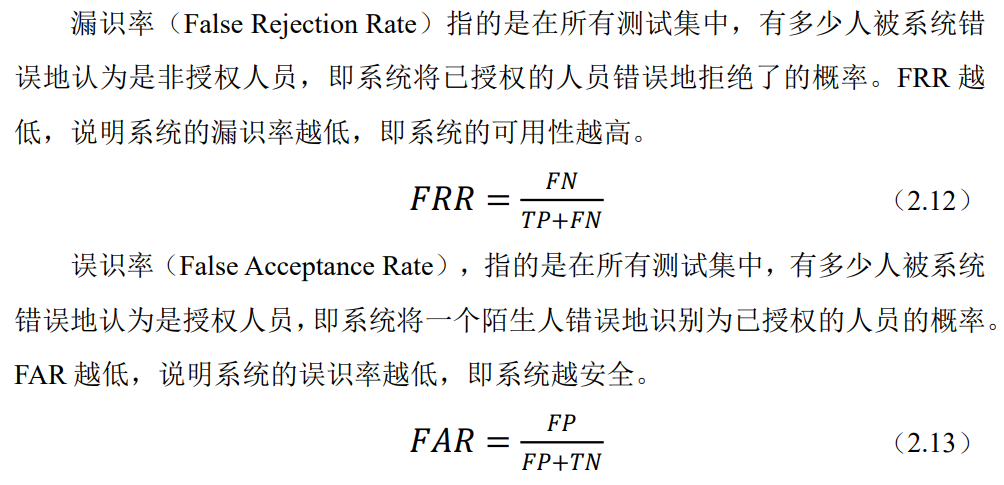

2. 人脸识别评价指标

三、经典模型

1. YOLO

参考文章:YOLOv1---YOLOv5论文解读

你一定从未看过如此通俗易懂的YOLO系列(从v1到v5)模型解读 (上)

你一定从未看过如此通俗易懂的YOLO系列(从v1到v5)模型解读 (中)

你一定从未看过如此通俗易懂的YOLO系列(从v1到v5)模型解读 (下)

①YOLO V5

没有发表论文,github地址:https://github.com/ultralytics/yolov5

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix