卷积神经网络部分知识点

全连接网络处理图像问题:

参数太多,易过拟合

卷积神经网络解决方式:

局部关联,参数共享(卷积核滑动不变)

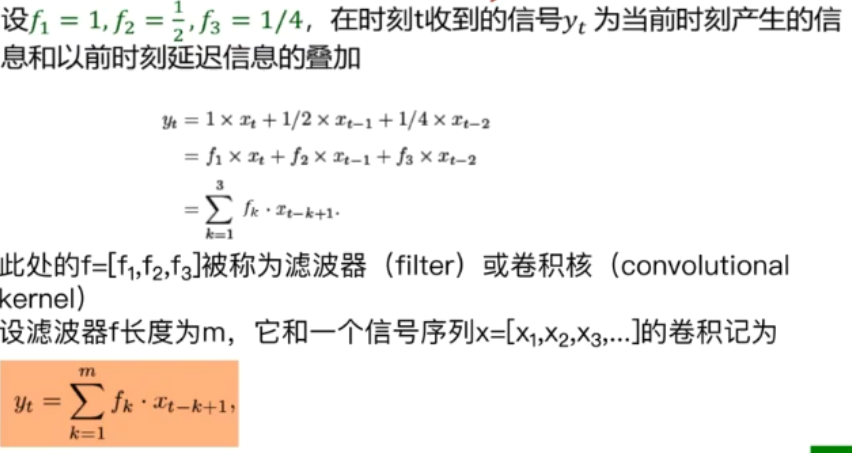

一维卷积:

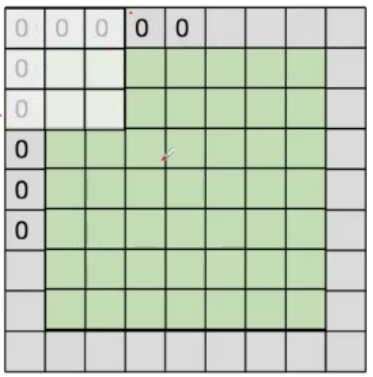

padding(零填充)

输出特征图大小:

输入NN 卷积核FF

输出(N-F)/stride+1

除不尽(padding):

输出(N+padding*2-F)/stride+1

池化

保留主要特征的同时减少参数和计算量,防止过拟合,提高模型泛化能力

一般处于卷积层与卷积层之间,全连接层与全连接层之间

类型:

Max poolng最大值池化(常用)

Average pooling平均池化

全连接

两层之间所有神经元都有权重链接

通常全连接层在卷积神经网络尾部

全连接层参数量大

AlexNet

DropOut(随机失活)

训练时随即关闭部分神经元,测试时整合所有神经元

数据增强

平移,翻转,对称

改变RGB通道强度,对RGB空间做高斯扰动

ZFNet

网络结构与AlexNet相同

更改卷积层感受野大小,步长,滤波器个数

VGG

更深 16-19层

VGG16 VGG19

Googl eNet

网络包括22个带参数的层(考虑pooling是27层),独立成块的层总共有约100个

参数量大概是AlexNet的1/12

没有FC层(除类别输出层)

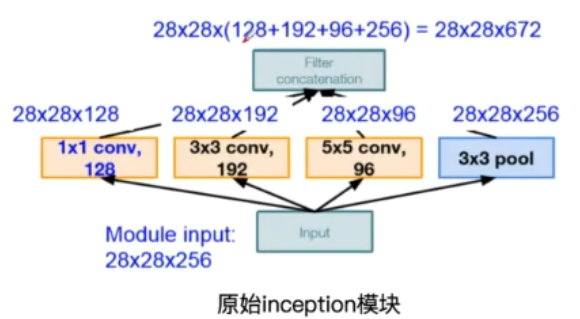

InceptionV1初始版本(多种卷积核,多尺度)

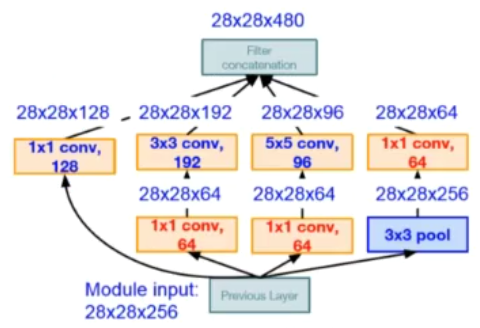

InceptionV1 插入1*1卷积核进行降维

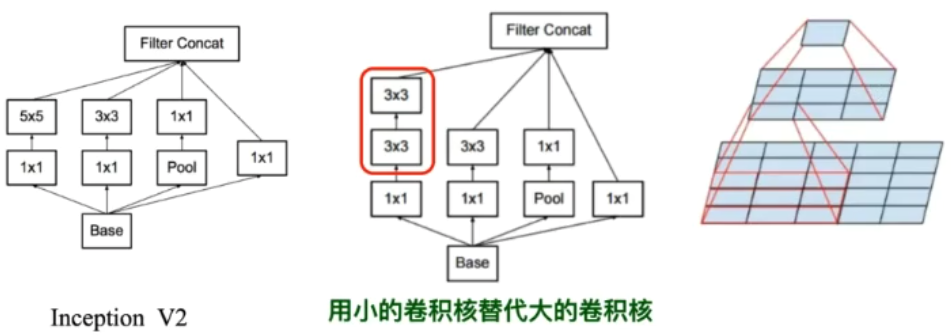

InceptionV2

降低参数量

增加非线性激活函数,使网络产生更多独立特征,表征能力更强,训练更快

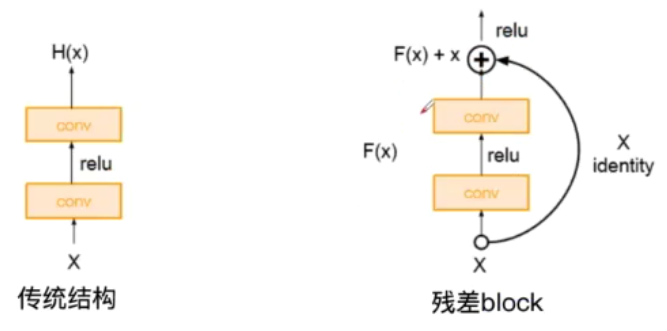

ResNet

残差学习网络

残差思想:去掉相同的主体部分,从而突出微小的变化(若F(x)=0,则输出=0+x,相当于去掉无用层)

可以被用来训练非常深的网络