逻辑回归函数

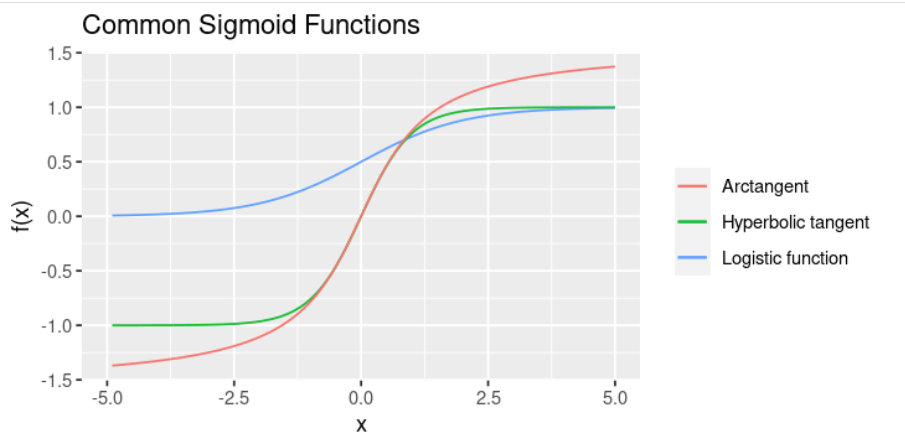

Sigmoid Function

Logistic Function:

\(S(x)=\frac{1}{1+e^{-x}}\)

(\(S(0)=\frac{1}{1+1}=0.5\))

Hyperbolic tangent

\(f(x)=tanh(x)=\frac{e^x-e^{-x}}{e^x+e^{-x}}\)

(\(f(0)=tanh(0)=\frac{0}{2}=0\))

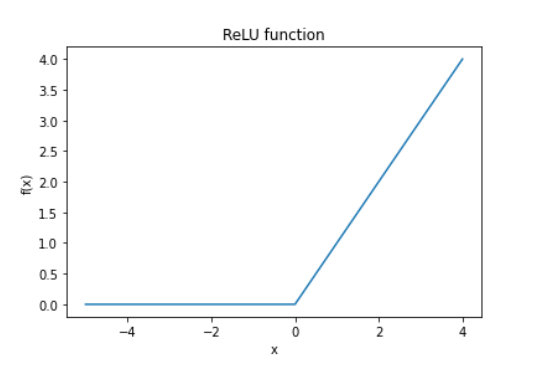

Sigmoid vs. ReLU

- ReLU 更容易计算

- 在生物神经网络中,对于负数输入,激活值不会一直改变。因此,ReLU看起来更接近生物神经网络。

- 对于正数输入\(x\),ReLU有一个值为\(1\)的梯度常量。而Sigmoid的梯度趋向于\(0\),这使得将Sigmoid作为激活函数的神经网络训练效率不高。

此外,对于负数输入,ReLU同样存在梯度为\(0\)的情况,但可以通过在\(x\)中加入一个小的线性值来使得ReLU函数在所有点上具有非\(0\)斜率。