机器学习十讲——第六讲学习总结

特征向量:设A是n阶方阵,如果有常数λ和n维非零列向量α的关系式Aα=λα成立,则称λ为方阵A的特征值,非零向量α称为方阵A的对应于特征值λ的特征向量。

特征值分解:

在python中使用numpy工具就可以实现。

降维

定义:将数据的特征数量从高维转换为低维。

作用:解决高维数据的维度灾难问题的一种手段;能够作为一种特征抽取方法;便于对数据进行可视化分析。

降维方法

主成分分析(PCA)

基本思想:构造原始特征的一系列线性组合形成的线性无关低维特征,以去除数据的相关性,并使降维后的数据最大程度地保持原始高维数据的方差信息。

例:二维数据投影到一维(图示):

数据集表示:

数据集D={x1,x2,…,xn},每个样本表示成d维向量,且每个维度均为连续型特征。数据集D也可以表示成一个n×d的矩阵X。为方便描述,进一步假设每一维特征的均值均为0(中心化处理),且使用一个d×l的线性转换矩阵W来表示将d维的数据降到l维(l<d)空间的过程,降维后的数据用Y表示,有Y=XW。

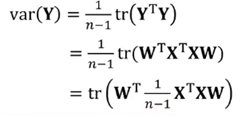

优化目标:降维后数据的方差:

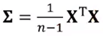

原始数据集的协方差矩阵 ,则PCA的数学模型为:

,则PCA的数学模型为:

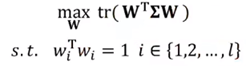

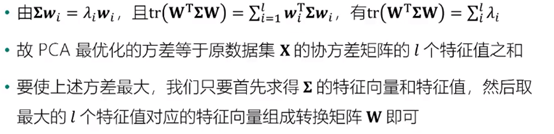

模型求解:

做出以上处理之后,我们还需要将方差最大化:

取l个特征值时首先进行降序排序处理。

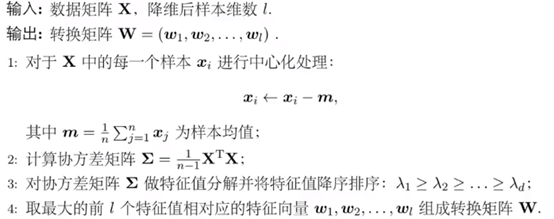

算法流程:

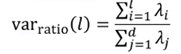

l的选择:

方差比例:通过确定降维前后方差保留比例选择降维后的样本维数l,可预先设置一个方差比例阈值(如90%),公式如下:

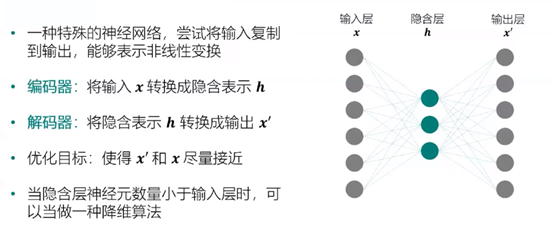

自编码器:

深层自编码器: