这家语音 AI 公司新融资 2700 万美元,并预测了 2025 年语音技术趋势

12 月 13 日,语音 AI 初创公司 Cartesia 宣布完成了新一轮 2700 万美元的融资,由知名风投机构 Index Ventures 领投。

Cartesia 由 Karan Goel 和 Albert Gu 联合创立,专注于开发基于状态空间模型 (SSM) 的创新架构,该架构以其卓越的计算效率和实时处理能力而著称。Cartesia 的核心产品 Sonic 正是基于 SSM 技术打造的高速文本转语音引擎。

Cartesia 计划在其 Sonic 的基础上制定了长期路线图,其中包括开发能够摄取和处理不同输入(例如文本、音频、视频、图像和时间序列数据)的多模态 AI 模型。

最近,Cartesia 结合与数百位伙伴的合作经验,分享了这份 2024 语音 AI 年度总结,并展望了 2025 年的发展。 包括中断处理、数字人肢体语言同步和端侧本地语音处理等趋势。

报告对 2025 年语音技术的展望的核心要点:

语音到语音(S2S)模型成为主流:

-

延迟降低: S2S 模型有望实现更低的延迟(例如,160 毫秒),更加接近人类对话的自然节奏。

-

上下文感知增强: S2S 模型将能够直接处理、理解并生成语音,同时保留情感、语调等非语言元素。

-

中断处理能力提升: S2S 模型有望更好地处理重叠的语音流和中断情况。

语音助手处理更复杂的多步骤任务:

- 更深入地融入工作流程: 语音助手将在各个领域承担更多任务,例如预订、预约和支付等。

- 利用检索增强生成 (RAG): 语音助手将具备端到端的处理能力,例如直接检索信息、应用政策并完成任务。

- 基于结果的定价模型: 供应商将采用与任务成功率相关的定价,而非通话时长。

本地模型实现设备端语音 AI:

- 无网络连接运行: 将能够在无网络环境下实现本地语音处理。

- 降低延迟: 本地处理能够提供更低的延迟,从而提高响应速度。

- 隐私保护: 数据将保留在本地设备上,从而保障用户隐私。

- 边缘 AI 芯片普及: 专用硬件将支持本地模型的高效运行。

细粒度控制语音:

- 精确控制合成语音: 可以控制情感、语调、节奏和发音等细微之处。

- 与其他 AI 模态协同: 语音特征可以与数字人的肢体语言实现同步。

- 音频编辑更流畅: 可以将 AI 生成的内容无缝融入现有音频,并自动匹配风格。

Voice AI 2024 年度趋势报告

作者:Cartesia

(编者注:本文罗列了多家 voice agent 初创公司,文末附有相关网址,方便读者深入了解。)

今年在 Cartesia,我们很幸运与数百位创始人、产品领导者和工程师合作,他们正在塑造语音应用的未来。在我们 2024 年第一份语音趋势报告中,我们强调了推动行业前进的关键基础设施突破和新兴用例,并展望 2025 年的未来。

2024 年最大的趋势

1.出现了用于构建语音交互的新架构

2024 年标志着对话语音人工智能的突破,出现了结合语音识别(STT)和文本转语音(TTS)模型的协调语音系统,能够在对话中倾听、推理和回应。

语音对语音技术随着 OpenAI 在 ChatGPT 中推出的语音模式成为现实,引入了在音频和文本信息上进行端到端预训练的模型,能够原生理解和生成音频以及文本标记。虽然 OpenAI 通过其 Realtime API 的实现可能尚未完全端到端,正如其演示中处理中断的挑战所证明的那样,但这代表了朝着使用单一统一模型进行语音交互的重要一步。

全双工语音对语音系统作为研究产物出现,通过像 Kyutai 的 Moshi 模型这样的发布。这些模型是「始终在线」的,因为与 OpenAI 的系统不同,它们能够在模型说话时监听用户。这为多模态语音的未来提供了一个有趣的视角,模型始终在用户音频中进行流式传输。

新的语音模型架构变得可行,Cartesia 发布了基于新状态空间模型(SSM)架构的 Sonic TTS,该架构采用自回归训练。这些架构与过去几年流行的更传统的基于注意力的 Transformer 模型有很大不同,因为它们在部署环境中提供了更大的灵活性。现在可以实现内存高效的设备端(on device)部署,同时提高了质量和延迟。

2.语音人工智能 API 进步以支持企业规模的自然对话

在 2024 年,现代语音智能体架构的三个核心组件的改进使语音人工智能能够用自然对话取代僵化的「按 1 键选择英语」电话树。

-

语音转文本(STT):转录质量已经足够强大,成为设计音频原生应用程序的标准工具。然而,领域特定术语和远场转录等问题仍然具有挑战性。在2022 年,OpenAI 的 Whisper 奠定了基础,使用其开源模型,训练了令人印象深刻的 680,000小时多语言音频数据。Deepgram 的 Nova-2 模型随后提高了标准,实现了 30%的词错误率(WER)降低,并为 2024年的商业应用设定了新的基准。

-

大型语言模型 (LLM):2024 年发布的 GPT-4o 、Llama 3.2 、Claude 3.5 Sonnet和 Gemini 2.0在推理和效率方面有了显著改善。LLM 成本从 GPT-4 的每百万美元 45 美元大幅下降至 Llama 3.1 70B 在 Together AI 上运行的每百万 token 2.75 美元。语音模型现在支持输入流(input streaming),允许音频在接收来自 LLM 的输入时实时生成,同时在语音段之间保持一致的韵律。

-

文本到语音(TTS):TTS 模型已经达到了生产级成熟度,提供了降低延迟、增强自然性和提高处理复杂内容(如缩略词和数字表达)的准确性。领先的 TTS 引擎将合成语音从其机械起源转变为真正的人类语音。这一进展得益于神经网络架构(SSMs、transformers、扩散模型)的创新、训练数据质量和多样性的提升,以及音频编解码器的优化——这对于高效编码和解码数字音频以进行流媒体传输或存储至关重要。

语音人工智能提供商也超越了最初对专业消费者和语音原生初创公司的关注,以满足企业需求。语音人工智能系统必须从根本上重新设计,以满足超越传统异步应用程序的实时交互严格标准。由于实时对话无法编辑或重新生成,基础设施必须提供保证的正常运行时间、无瑕疵的并发通话处理和无可妥协的可靠性。为了服务传统企业,提供商升级了他们的平台,以提供可定制的服务水平协议、针对高峰量的动态扩展、强大的安全认证以及针对高度监管行业的自托管选项。这些功能在早期的语音人工智能产品中很少见,但随着技术的成熟,已成为标准。

3.新平台使得在生产中构建、测试和部署自定义语音智能体比以往任何时候都更容易。

今天大多数语音助手都是基于核心对话流程构建的——语音转文本(STT)、大型语言模型(LLM)推理和文本转语音(TTS)。

虽然这个管道可以创建自然对话,但在内部构建它面临着重大挑战:管理实时音频流、处理模型延迟、协调轮流发言以及确保无缝过渡。工程团队通常需要 6 到 12 个月的时间来构建的东西,可以通过语音编排平台在几周内实现。这些平台抽象了复杂性,使开发人员能够专注于打造引人入胜的体验,同时混合和匹配最佳组件。

像 LiveKit 和 Daily 这样的公司开发了开源组件,以便在使用 WebRTC 堆栈的实时 AI 模型之间实现无缝、低延迟的编排。他们的基础设施确保全球范围内的可靠性能,同时允许开发人员保持全栈定制。

语音智能体编排平台,如 Vapi、Retell、Bland 和 Thoughtly ,出现是为了快速部署自定义智能体,配备先进的功能,如基于 RAG 的知识库和工具调用功能。这些平台还提供额外的功能,如语音活动检测(VAD)以控制扬声器切换和情感识别、中断处理以及噪声过滤模型,以促进自然对话。

新的可观察性平台,如 Hamming、Coval、Vocera 和 Canonical ,构建了完整的评估套件,用于大规模模拟和测量语音智能体的质量。

(编者注:实时语音 AI 智能体开源框架 TEN Framework 同时具备语音智能体编排、RTC 配置、RAG 和 Function Call、实时状态管理等能力。同时与 Dify 和 Coze 等流行 Workflow 平台兼容。)

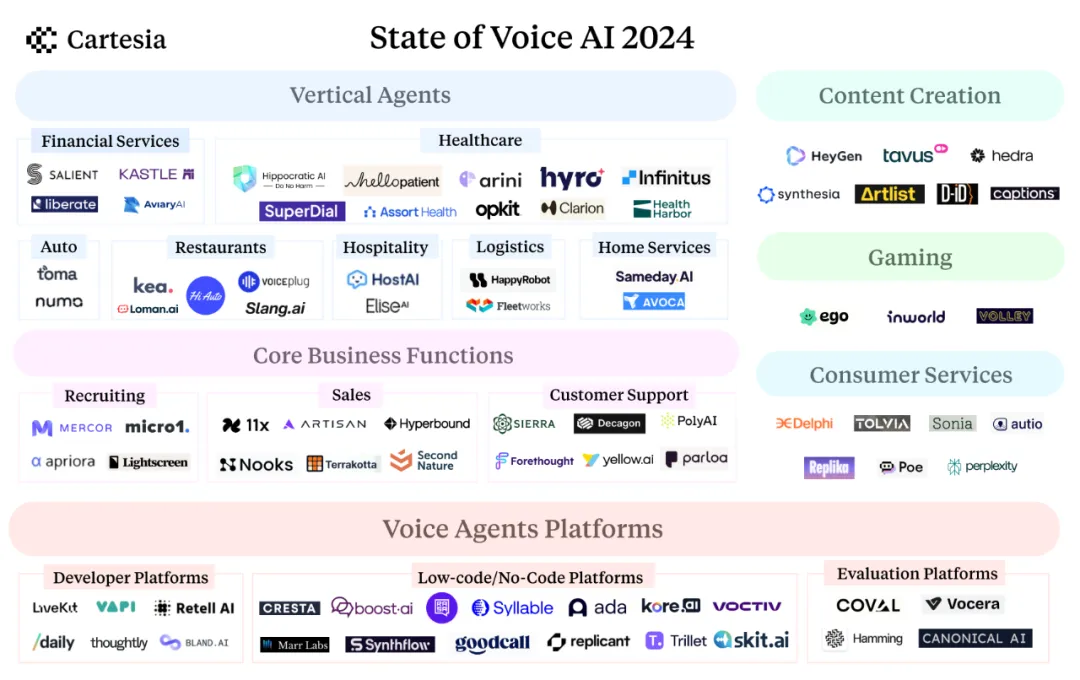

4.语音助手在各个领域出现

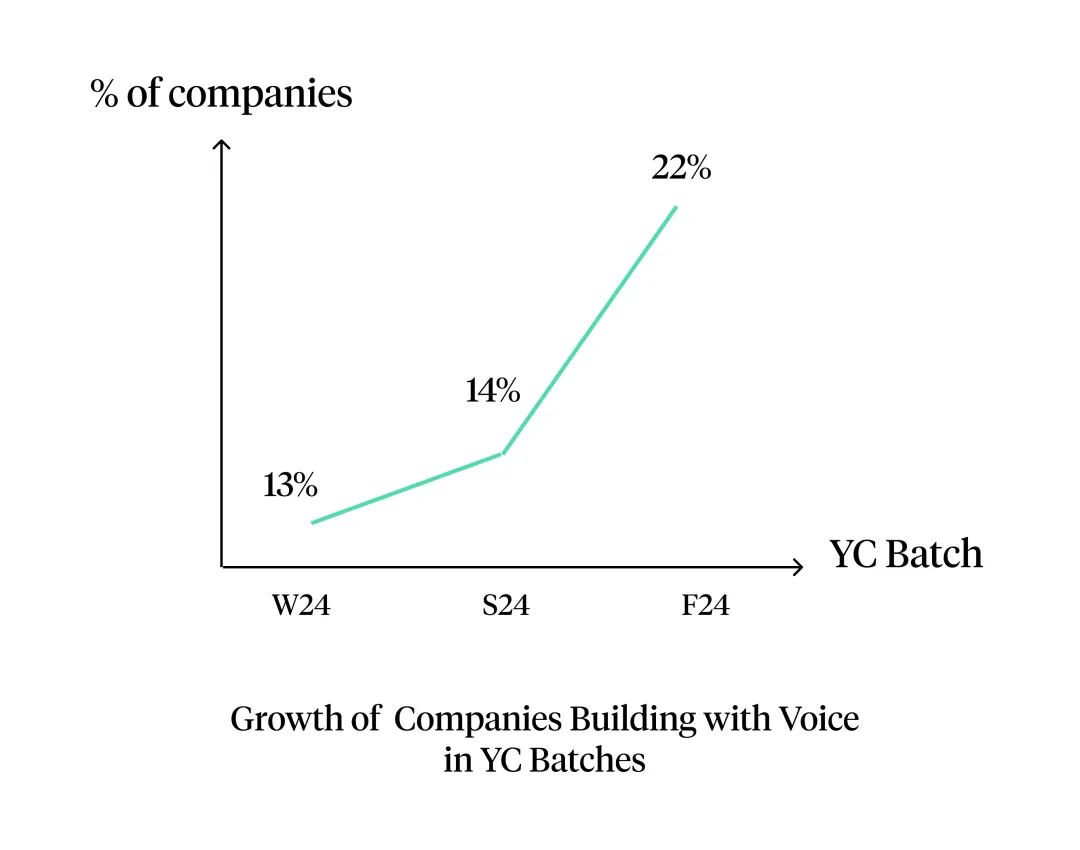

垂直语音智能体初创公司经历了爆炸性增长,Y Combinator 反映了这一趋势,语音原生公司的数量在冬季和秋季的批次之间增长了 70%。最初的采用集中在扩大之前人手不足的服务的能力,如 24/7 客户运营和季节性业务高峰。

在 YC 孵化项目中,基于语音技术构建公司的增长趋势

-

贷款服务:Salient 和 Kastle 的智能体帮助服务贷款,管理还款,并处理重新激活休眠账户或交叉销售其他金融产品的外联工作——同时保持对处理敏感数据(如个人身份信息)的高合规标准。

-

保险:Liberate 和 Skit 的智能体全天候处理索赔、保单续保,并提供清晰的保障选项说明。

-

医疗保健:Abridge 首次在 2019 年应对对医疗记录员的高需求而将转录引入医疗保健。现在,全球的诊所正在采用人工智能助手来安排预约、提供用药提醒和回答账单查询,这要归功于 Hello Patient 、Hippocratic 、Assort Health 和 Superdial 等公司,同时保护患者信息。

-

物流:货运智能体、第三方物流提供商(3PL)和承运人利用 Happy Robot 和 Fleetworks 来管理检查电话、装载更新、付款状态和预约安排。

-

酒店业:用例范围从 Host AI 的全渠道 AI 助手到 Nowadays 的 AI 活动策划者。Elise AI 的 AI 助手和客户关系管理系统协同工作,处理从租赁咨询到维护和续约的所有事务。

-

中小企业:Goodcall 允许较小的特许经营轻松设置 AI 智能体,以无缝处理所有入站电话,因为业主目前因容量限制错过了 60%的电话。Slang 为餐厅提供专门的解决方案,而 Numa则与汽车经销商的客户关系管理系统集成,以利用过去的客户互动数据来推动客户留存。Avoca 为暖通空调、管道和其他现场服务提供 24/7 的 AI 呼叫中心。

5.语音智能体简化了核心业务功能

语音智能体也出现在标准化业务流程中,在三个关键领域得到了广泛应用:

-

招聘:像 Mercor 和 Micro1 这样的人工智能面试官通过进行电话和视频面试,利用候选人的背景来制定相关问题,并提供比传统申请筛选更深入的见解,从而增强招聘过程。

-

销售:随着电子邮件效果的下降,像 11x 、Artisan 和 Nooks 这样的公司正在通过 AI SDR重新振兴电话销售,以进行潜在客户开发和线索资格审查。与此同时,像 Hyperbound 这样的平台通过 AI 驱动的角色扮演培训模拟销售场景,以提高销售代表的表现。

-

客户支持:像 Sierra、Decagon 、Forethought 、Parloa 和 Poly 这样的人工智能驱动的客户体验平台正在整合语音功能,以支持仍然通过电话进行的大量客户支持互动。

6.语音人工智能驱动更具互动性的娱乐和媒体体验,拥有互动角色

-

内容创作:像 Heygen、Tavus、D-ID、Synthesia 和 Hedra 这样的 AI 虚拟人平台使创作者能够从单个数字克隆生成无限的叙述视频,改变了营销、培训和教育内容的制作。像 Capcut、Canva、Adobe 和 Captions 这样的创作者平台现在直接集成 AI 语音,而《时代》杂志和《纽约时报》等主要媒体也在为文章采用 AI 叙述,大众化专业质量内容创作。

-

游戏:游戏工作室正在利用语音人工智能创造更具沉浸感的体验,通过动态、响应式的非玩家角色(NPC)实时适应玩家的互动。像 Ego 和 Inworld 这样的平台使得创建丰富的 3D 世界成为可能,在这些世界中,人工智能角色与玩家自然互动,而实时语音变声器则允许玩家将自己的声音与游戏角色匹配,从而增强沉浸体验。

-消费者服务:语音人工智能使创作者和服务提供商能够成倍扩大他们的个人影响力。影响者和名人可以通过 Delphi 与成千上万的粉丝同时互动,而教练和治疗师可以通过像 Sonia 这样的平台提供 24/7 个性化指导。像 Duolingo 和 Khan Academy 这样的教育平台通过人工智能语音辅导员扩大他们的影响力,而谷歌的 NotebookLM 让任何人都可以创建文章和书籍的音频摘要。像 Replika 和 Character AI 这样的公司为任何人群提供随时可用的伴侣,而像 Tolvia 这样的专业平台则服务于老年人群体。最后,Quora 的 Poe 和 Perplexity 的语音对语音功能允许通过语音广泛访问 LLM 内容。

在这里,我们展示了我们感到兴奋的关键领域,以及更多即将到来的领域。我们期待在新的一年里支持并看到更多初创企业在这些领域进行创新!

2025 年会有什么期待

语音对语音模型进入主流

语音到语音(S2S)模型直接将语音输入转换为语音输出,绕过文本表示的需要。虽然在 2024 年出现了几种 S2S 模型,但我们预计 2025 年将是它们的突破年,因为它们在三个传统上挑战 STT→LLM→TTS 管道的关键维度上展示了引人注目的能力:

-

延迟:当前的语音智能体实现了最佳的延迟,约为 510 毫秒(Deepgram STT:100 毫秒,GPT-4:320 毫秒,Cartesia TTS:90 毫秒),仍然远低于人类对话的约 230 毫秒。今年发布的早期 S2S 模型如 Moshi,展示了通过单步处理实现 160 毫秒延迟的潜力,尽管它们需要更好的机制以避免在用户说完之前生成响应。

-

上下文意识:S2S 系统允许同一模型直接处理、理解和生成语音。通过在单一模型中处理所有内容,S2S 模型保留了通常在文本转换中丢失的非语言元素,如情感、语调和韵律。虽然当前系统试图将这些信息作为元数据在组件之间传递,但统一的 S2S 处理将更好地捕捉对话的细微差别。主要障碍仍然是计算成本,但一旦解决,性能和效率都会提高。

-

中断处理:与其强制严格的轮流发言,S2S 模型可以并行处理重叠的语音流。然而,目前的系统在自我语音识别、有限的上下文窗口和重叠音频处理方面存在困难。我们预计在 2025 年,这些领域将会有显著的改善。

语音助手将被赋予更复杂的多步骤任务,并在各个领域的工作流程中更加深入地融入。

2024 年标志着语音助手的初步测试阶段,主要处理溢出和基本筛选任务,具有可预测的对话轮次。随着盲 A/B 测试显示出更优的性能指标——包括通话时长、解决率、收入恢复率和客户满意度(CSAT)分数,企业对人工智能驱动的语音互动充满信心。语音人工智能有望成为消费者日常与企业互动的主要界面,从预订餐厅、安排医疗预约到支付账单和处理机动车管理局服务。

试想一下,您致电航空公司重新预订,一个人工智能智能体通过检索增强生成(RAG)技术,端到端地处理您的需求。该智能体能够即时访问乘客记录、航班信息以及航空公司政策。您无需等待或被转接,人工智能即可在自然对话中完成验证当前预订、查找替代方案、应用相关政策并处理更改。这与在知识库上微调大型语言模型(LLM)类似,企业也可以基于自身领域或公司特有的词汇和风格,微调现有的转录和文本转语音模型,从而进一步增强用户对其人工智能智能体的信任。随着人工智能端到端解决复杂任务能力的不断提升,这种信心也反映在新的智能体定价模式上。供应商现在倾向于采用与成功任务解决率相关的按结果付费模式,而不是传统的按通话时长付费。

1.紧凑的本地模型将使得在任何地方进行本地对话成为可能

紧凑的本地人工智能模型正在获得关注,因为它们解决了三个关键挑战:它们可以在没有互联网连接的情况下运行,通过本地处理提供更低的延迟,并通过将数据保留在设备上确保隐私。这使得语音人工智能在这些要求不可妥协的场景中得以应用——从在偏远地区运行的车辆到在信号死区工作的现场人员。

我们预计 2025 年将是设备端语音 AI 的突破年,因为新的架构、模型量化和蒸馏技术逐渐成熟,专用边缘 AI 芯片变得广泛可用,最终使本地处理在生产规模上变得可行。像 TensorFlow Lite 和 PyTorch Edge 这样的框架的进步已经在加速这一转变,使得部署和优化变得更加可及。

2.细粒度控制在语音的各个方面取得进展

2024 年,在合成语音的精细控制方面取得了显著突破,从情感语调、节奏到精准发音,都达到了前所未有的水平。这些进步不仅仅局限于声音本身,更实现了语音特征与其他人工智能模态之间的无缝协调。例如,语音中的情感线索现在可以通过语音合成标记语言(SSML)驱动数字化身的肢体语言,使其呈现出匹配的面部表情,而 SSML 以往主要用于指示停顿或发音。这种技术进步使得内容创作者能够将人工智能生成的词语或场景无缝嵌入现有音频内容中,新加入的内容将自动匹配周围素材的风格和节奏,达到浑然天成的效果。

展望未来

2025 年,语音人工智能将在各个行业变得更强大、更可定制和更易获取,因为这项技术将从早期实验发展到生产就绪的系统。

原文:https://www.cartesia.ai/blog/state-of-voice-ai-2024编译:傅丰元

更多 Voice Agent 学习笔记:

Gemini 2.0 来了,这些 Voice Agent 开发者早已开始探索……

帮助用户与 AI 实时练习口语,Speak 为何能估值 10 亿美元?丨Voice Agent 学习笔记

2024 语音模型前沿研究整理,Voice Agent 开发者必读

从开发者工具转型 AI 呼叫中心,这家 Voice Agent 公司已服务 100+客户

WebRTC 创建者刚加入了 OpenAI,他是如何思考语音 AI 的未来?

人类级别语音 AI 路线图丨 Voice Agent 学习笔记

语音 AI 革命:未来,消费者更可能倾向于与 AI 沟通,而非人工客服

语音 AI 迎来爆发期,也仍然隐藏着被低估的机会丨 RTE2024 音频技术和 Voice AI 专场

下一代 AI 陪伴 | 平等关系、长久记忆与情境共享 | 播客《编码人声》

参考链接[1] Realtime API: https://openai.com/index/introducing-the-realtime-api/

[2] 演示:https://www.youtube.com/watch?v=1uM8jhcqDP0

[3] Moshi: https://arxiv.org/abs/2410.00037

[4] Sonic: https://www.cartesia.ai/blog/sonic

[5] 设备端:https://www.cartesia.ai/on-device

[6] Whisper: https://openai.com/index/whisper/

[7] Deepgram: https://deepgram.com/product/speech-to-text

[8] GPT-4o: https://openai.com/index/hello-gpt-4o/

[9] Llama 3.2: https://ai.meta.com/blog/llama-3-2-connect-2024-vision-edge-mobile-devices/

[10] Claude 3.5 Sonnet: https://www.anthropic.com/news/claude-3-5-sonnet

[11] Gemini 2.0: https://blog.google/technology/google-deepmind/google-gemini-ai-update-december-2024/

[12] Together AI: https://www.together.ai/

[13] 输入流:https://docs.cartesia.ai/build-with-sonic/capability-guides/stream-inputs-using-continuations

[14] LiveKit: https://livekit.io/

[15] Daily: http://daily.co/

[16] Vapi: https://vapi.ai/

[17] Retell: https://www.retellai.com/

[18] Bland: https://www.bland.ai/

[19] Thoughtly: https://thought.ly/

[20] Hamming: https://hamming.ai/

[21] Coval: https://www.coval.dev/

[22] Vocera: https://www.vocera.ai/

[23] Canonical: https://voice.canonical.chat/

[24] Salient: https://www.trysalient.com/

[25] Kastle: https://kastle.ai/

[26] Liberate: https://www.liberateinc.com/

[27] Skit: https://skit.ai/

[28] Abridge: https://www.abridge.com/

[29] Hello Patient: https://www.cartesia.ai/blog/hellopatient

[30] Hippocratic: https://www.hippocraticai.com/

[31] Assort Health: https://www.assorthealth.com/

[32] Superdial: https://www.thesuperbill.com/

[33] Happy Robot: https://www.happyrobot.ai/

[34] Fleetworks: https://fleetworks.ai/

[35] Host AI: https://www.hostai.app/

[36] Nowadays: http://getnowadays.com/

[37] Elise AI: https://www.eliseai.com/

[38] Goodcall: https://cartesia.ai/blog/goodcall

[39] Slang: https://www.slang.ai/

[40] Numa: https://www.numa.com/

[41] Avoca: https://www.avoca.ai/

[42] Mercor: https://mercor.com/

[43] Micro1: https://micro1.ai/

[44] 11x: https://micro1.ai/

[45] Artisan: https://artisan.co

[46] Nooks: https://www.nooks.ai/

[47] Hyperbound: https://www.hyperbound.ai/

[48] Sierra: https://sierra.ai/

[49] Decagon: https://decagon.ai/

[50] Forethought: https://forethought.ai/

[51] Parloa: https://www.parloa.com/

[52] Poly: https://poly.ai/

[53] Heygen: https://www.heygen.com/

[54] Tavus: https://tavus.io/

[55] D-ID: https://www.d-id.com/

[56] Synthesia: https://www.synthesia.io/

[57] Hedra: https://www.hedra.com/

[58] Capcut: http://capcut.com/

[59] Canva: https://canva.com/

[60] Adobe: https://www.adobe.com/express/feature/ai/audio/voiceover

[61] Captions: https://www.captions.ai/

[62] 《时代》杂志:http://time.com/

[63] 《纽约时报》: http://nytimes.com/

[64] Ego: https://www.cartesia.ai/blog/ego

[65] Inworld: https://inworld.ai/

[66] 语音变声器:https://www.cartesia.ai/blog/voice-changer

[67] Delphi: https://www.delphi.ai/

[68] Sonia: https://www.soniahealth.com/

[69] NotebookLM: https://notebooklm.google/

[70] Replika: https://replika.com/

[71] Character AI: https://character.ai/

[72] Tolvia: https://tolvia.com/

[73] Poe: https://cartesia.ai/blog/quora

[74] Perplexity: https://www.perplexity.ai/

浙公网安备 33010602011771号

浙公网安备 33010602011771号