Hume AI 推出 EVI 2 情感模型;OpenAI o1 模型问世,模拟人类思考问题 丨 RTE 开发者日报

开发者朋友们大家好:

这里是 「RTE 开发者日报」 ,每天和大家一起看新闻、聊八卦。我们的社区编辑团队会整理分享 RTE(Real-Time Engagement) 领域内「有话题的新闻」、「有态度的观点」、「有意思的数据」、「有思考的文章」、「有看点的会议」,但内容仅代表编辑的个人观点,欢迎大家留言、跟帖、讨论。

本期编辑:@SSN,@鲍勃

01有话题的新闻

1、OpenAI o1 模型问世:开启 AI 通用复杂推理新篇章,模拟人类思考、处理问题

OpenAI 传闻中的「草莓」(Strawberry)AI 模型现已面世,正式名称为「o1」,是该公司首款具备「推理」能力的模型。

OpenAI 表示对该模型进行特殊训练,能够比人类更快地回答更复杂的问题。与之同时发布的还有 o1-mini,一个更小、成本更低的版本。

OpenAI 表示 o1 模型的发布,是其迈向类人 AI 宏伟目标的关键一步。该模型目前处于「预览」阶段,官方强调该模型相关开发尚处于初期阶段,相比较 GPT-4o 模型,使用成本更高且速度更慢,但在编写代码和解决多步骤问题方面表现更为优秀。

-

价格

OpenAI 公司表示从今天起,ChatGPT Plus 和 Team 用户将可访问 o1-preview 和 o1-mini,而 Enterprise 和 Edu 用户则将在下周初获得访问权限。

OpenAI 表示计划将 o1-mini 的访问权限扩展至所有 ChatGPT 免费用户,但尚未确定发布日期。

开发者获取 o1 的访问权限成本相当高昂:如果调用 API,o1-preview 的输入词元(tokens)费用为每百万个成本 15 美元(当前约 107 元人民币),输出词元费用为每百万个 60 美元(当前约 427 元人民币)。

相比之下,GPT-4o 的输入词元费用为每百万个 5 美元(当前约 35.6 元人民币),输出词元费用为每百万个 15 美元(当前约 107 元人民币)。因此 o1 模型输入词元费用提高了 2 倍,输出词元费用提高了 3 倍。

-

训练方式

OpenAI 的研究负责人 Jerry Tworek 表示,o1「采用了全新的优化算法和专门为其定制的训练数据集进行训练。」并他并未透露具体细节。

报道称 OpenAI 在训练 o1 模型中使用一种称为强化学习(reinforcement learning)的技术,来自行解决问题,该技术通过奖励和惩罚来教导系统。随后,o1 采用「思维链」来处理查询,类似于人类通过逐步推理来解决问题的方式。

由于采用了这种新的训练方法,OpenAI 表示模型应该会更加准确。

Tworek 表示:「我们不能说已经解决了幻觉问题,但至少从观测的结果来看,这个模型产生的幻觉明显减少」。

-

模型优势

o1 模型与 GPT-4o 的主要区别在于,它能够比前代更好地处理复杂的编程和数学问题,并能解释其推理过程,这是 OpenAI 所强调的。OpenAI 的首席研究官 Bob McGrew 表示:「这款模型在解答 AP 数学考试题目上的表现无疑比我更出色,而我大学时还辅修了数学。」

他提到,OpenAI 还让 o1 参加了国际数学奥林匹克竞赛的资格考试,GPT-4o 仅正确解决了 13% 的问题,o1 模型能够解决 83% 的问题。

在名为 Codeforces 竞赛的在线编程比赛中,这一新型模型达到了参赛者中的第 89 位,OpenAI 声称该模型的下一次更新将在物理、化学和生物学中的挑战性基准任务上表现「与博士生相当」。

同时,o1 在许多领域的能力不及 GPT-4o。它在世界事实知识方面的表现也不如后者。此外,它不具备浏览网页、处理文件和图像的能力。尽管如此,该公司认为它代表了一类全新的功能。将其命名为 o1,意在表明「将计数器重置回 1」。(IT 之家)

2、Hume AI 推出 EVI 2 全新的基础语音到语音模型,可进行极其人性化的语音对话

Hume AI 推出的全新语音对话基础模型:EVI 2 ,能够与用户进行极其人性化的语音对话。它可以快速流畅地回应,识别并生成各种语调,并满足个性化的需求,例如调整语速或模仿说唱风格。EVI 2 具备多语言能力,能够模仿多种性格、口音和说话风格。

EVI 2 专注于情感智能,能够根据用户的偏好和需求进行适应和调整,使其语音和个性更加愉悦和有趣。它已经开放了 Beta 版本供公众使用,开发者可以通过 API 将其集成到应用程序中。

Hume AI 强调,EVI 2 不支持直接的语音克隆,避免了与身份相关的风险,但通过语音调制功能,开发者可以定制个性化的语音,而不涉及克隆技术。(小互 AI)

3、文生图 AI Midjourney 雄心:7.0 版未来 1-2 月登场、开发新图像编辑器、探索 3D 系统、踏足硬件领域

报道称,在最近的「Office Hours」活动中,Midjourney 创始人兼首席执行官 David Holz 在 Discord 分享了当前项目的最新进展,并回答了社区的提问。

-

Midjourney 7.0 版本

Holz 更新了 Midjourney 7.0 版本时间表,表示将会在未来 1-2 月内发布。

-

让更多人体验 Midjourney

Holz 表示公司并不急于推出新的 AI 模型,而是提高现有技术的易用性,让工具深入融入到专业人士的日常工作中。

如今,所有用户,包括希望免费体验图像 AI 的用户,都可以通过网页界面进行操作。

-

新图像编辑器

Midjourney 目前还在开发一款图像编辑器,可以让用户利用涂抹和扩展功能编辑外部图像。尚不确定这一功能将整合到现有平台还是作为独立产品推出。该功能的具体时间表尚未公布。

-

3D 系统

Holz 介绍一个更为雄心勃勃的项目中,Midjourney 正在开发一种 3D 系统,让用户能够虚拟地沉浸在 AI 图像中。他们没有采用多边形渲染、NeRFs 或高斯喷射技术,而是创造了一种新的「类 NeRF」格式。该团队由一位在 NeRF 发明中扮演关键角色的人物领导,这让一些人猜测可能是去年加入 Midjourney 的前 Nvidia 研究员 Alex Evans。

-

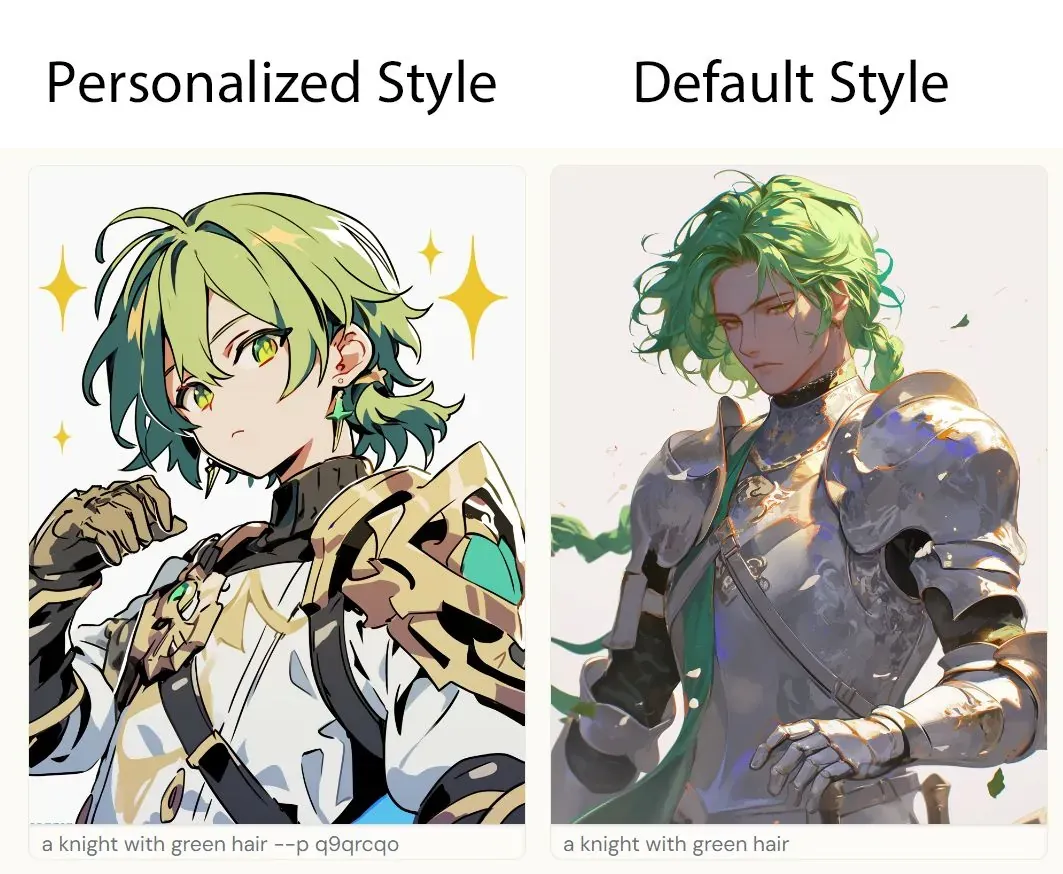

个性化风格

个性化功能同样位居 Midjourney 新特性之列。该工具旨在根据用户反馈深入了解用户偏好,提供更加个性化的结果。近期,Midjourney 已为专精于动漫角色的 Niji 模型启用了这一功能。

-

探索其它领域

Midjourney 似乎正忙于一系列开发工作。除了图像生成成果外,该公司还计划涉足视频生成领域。据此前报道,Midjourney 不仅在软件方面投入,还积极布局硬件研发。(@IT 之家)

4、安卓版谷歌 Gemini Live 免费上线,开启在线 AI 语音畅聊

据报道,谷歌在 1 个月前面向 Advanced 订阅用户推出后,正逐步面向所有安卓用户免费开放 Gemini Live。

今年 8 月,谷歌在 Pixel 9 系列手机发布会上,发布了 Gemini Live,该服务提供了一种移动对话体验,让用户和 Gemini 展开自由流畅的对话。

Gemini Live 可以说是对标 OpenAI ChatGPT 最新上线的 Advanced Voice 模式(限量 Alpha 测试),采用了增强型语音引擎,可以展开更连贯、更有情感表达力、更逼真的多轮对话。

谷歌公司于本周四宣布,所有使用英语的 Android 版 Gemini 移动应用用户现在可以访问 Gemini Live,随时与助手进行流畅对话。iOS 平台尚未推出 Gemini 应用,因此这些用户将无法体验这一功能。(@IT 之家)

5、Reader-LM:用于清理和转换 HTML 为 Markdown 的小型语言模型

Jina AI 推出了两款小型语言模型(SLM),Reader-LM-0.5B 和 Reader-LM-1.5B,专门用于从嘈杂的 HTML 中提取并生成干净的 Markdown。这些模型有效地替代了传统的 Readability 和 Turndown 库,通过直接从 HTML 生成 Markdown,解决了噪声过滤和标记转换的问题。与大模型相比,这些 SLM 更具成本效益,同时支持长达 256K 的上下文长度。(@机器之心 SOTA 模型)

02有态度的观点

1、对话生数科技 CEO 唐家渝:AI 视频到了「普及」节点,提升时长不是产品化的重点

9 月 11 日,生数科技举办媒体开放日活动,发布「主体参照」(Subject Consistency)功能,意在破解视频模型生成主体的「一致性」难题。

在活动中,生数科技联合创始人、CEO 唐家渝表示,「现在的 AI 视频来到了一个节点。」生数科技发布的「主体参照」功能,正是为降低创作者门槛或者加速创作过程所作的努力。

「技术仍是关键因素,目前的视频生成只是初步符合物理规律,还有很高的天花板需要突破,比如更强的模型能力以及更多模态的协同生成。」唐家渝介绍,这次发布的「主体参照」能力在一致性生成方面确实有了很大提升,但是还有很多地方需要进一步提升。「例如要大模型从生成一个商品变成生成一个工艺品,而这个工艺品上面有繁复花纹和镂空部分,面对如此复杂的结构,目前的生成成功率依旧不高。场景生成包含很多组成因素,例如运动鞋,我就希望它能在更复杂、更动态化的场景中有更好的表现。这些都需要不断提升模型能力。」

这个过程中,技术的原创性和突破性需要与良好的商业化齐头并进,因为商业公司毕竟不是科研机构。

以视频生成的时长为例,拓展生成时长需要提升模型对世界抽象理解的能力、信息压缩和放大的双向能力。当前 Vidu 最长可以生成 32 秒的视频,生数科技计划将其扩展得更长,不过,时长还不是生数科技现在重点产品化的部分。

「在实际创作中,粗略地来说,90%以上的片段都是几秒钟。因此,从实用角度来看,我们还没有将时长作为我们的优先发布考虑。」唐家渝强调,但从模型能力角度,公司实际上在持续提升。(@每日经济新闻)

写在最后:

我们欢迎更多的小伙伴参与「RTE 开发者日报」内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。

素材来源官方媒体/网络新闻

浙公网安备 33010602011771号

浙公网安备 33010602011771号