1.介绍

背景:大多数现有的跨模态匹配方法旨在解决跨模态差异,而VT-REID(visible-thermal re-id)问题也受到大的跨视图变化和模态内变化的影响。

创新:1.提出了一种新的VT-REID层次交叉模态匹配模型,该模型可以同时处理交叉模态差异和交叉视图变化,以及内模态变化

2.提出了一种改进的两流CNN网络来学习深度多模态共享特征表示

不足:不是端到端的框架

2.思想

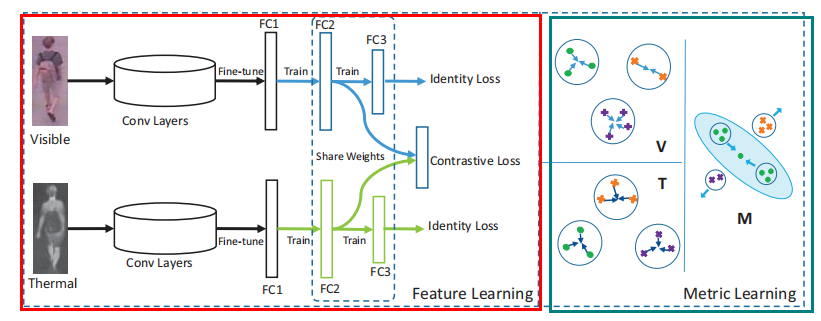

模型由两部分组成:特征学习和度量学习

2.1 特征学习

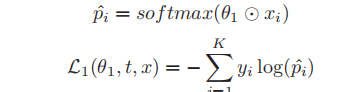

2.1.1 identity loss

牵引学习id可鉴别特征

对于第二个模态,其identity loss也是一样,记作L2

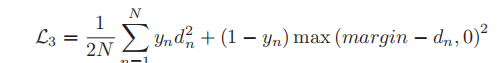

2.1.2 contrastive loss(triplet loss)

是为了模态内,模态间样本距离易于处理。

这个公式在原始的triplet loss上改进,加入归一化等

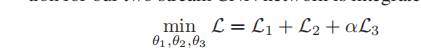

2.1.3 总损失

2.2 Hierarchical Cross-modality Metric Learning (这个没怎么懂,哪个大佬知道请告知)

为了使提取的特征更加有鉴别性和跨模态匹配度,设置了HCML进一步提高(即提高精度)

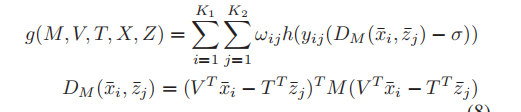

V,T分别是visible,thermal图像的对应的转换矩阵

X,Z分别是visible,thermal特征

M是一个正半定矩阵,表示学习模态共享度量来处理跨模态差异

2.2.1 Modality-specific Terms

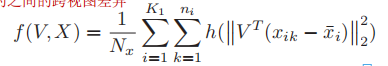

减小同模态的相同id的之间的跨视图差异

上式是 对每一个id,这个id的所有rgb(或ir)图片都和这个id的rgb的均值做差,得到每个rgb(ir)和均值的差异,最后归一平均化。

2.2.2 Modality-shared Term

为了使特定模态经过模态度量方法转换(D)后,能从从两个不同模态中区分出不同的人

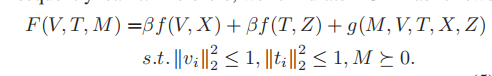

2.2.3 总公式####

然后对这个公式进行优化