Coursera台大机器学习技法课程笔记05-Kernel Logistic Regression

这一节主要讲的是如何将Kernel trick 用到 logistic regression上。

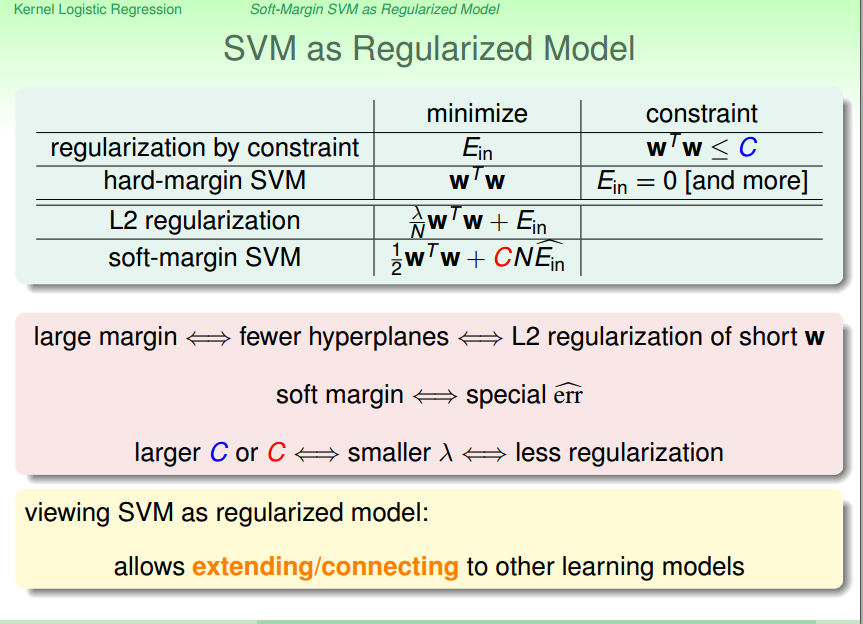

从另一个角度来看soft-margin SVM,将其与 logistic regression进行对比,发现可将

SVM看作一个正则化模型:

将SVM看作一个regularize model,是为了更好的延伸到其他模型上。

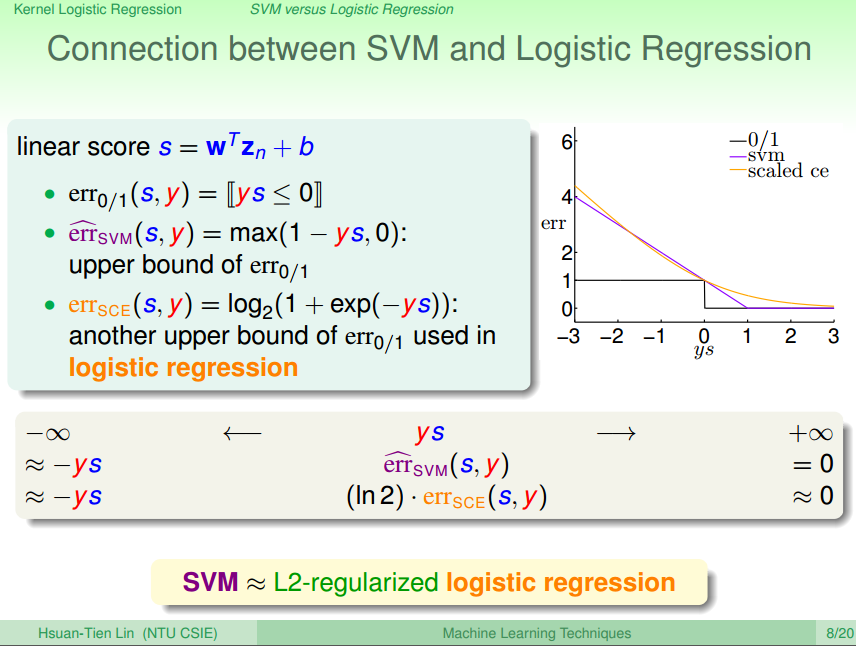

下面从erro measure的角度来分析二者相似性:

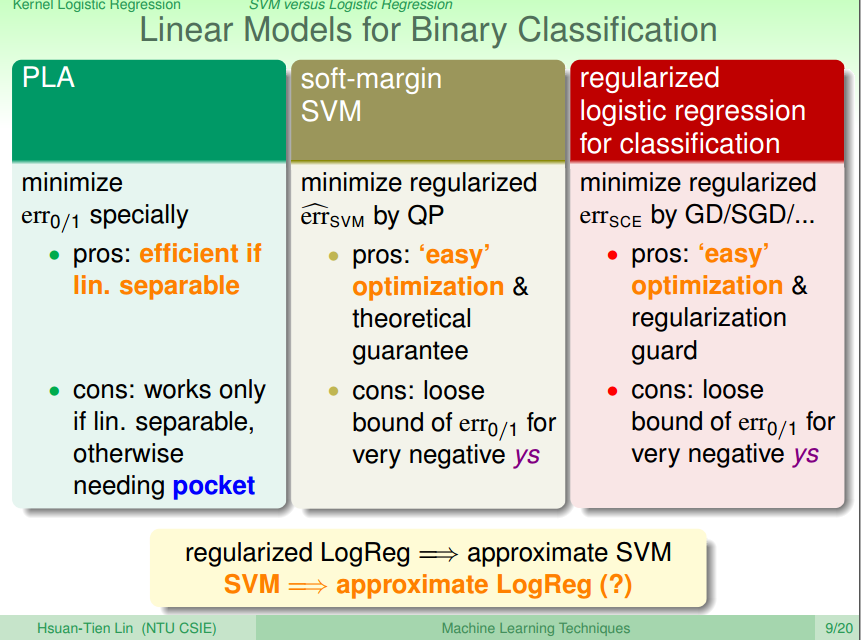

再从binary classfication的角度来比对:做了一个LogReg就相当于做了SVM,那SVM的结果能否用到LogReg上呢?

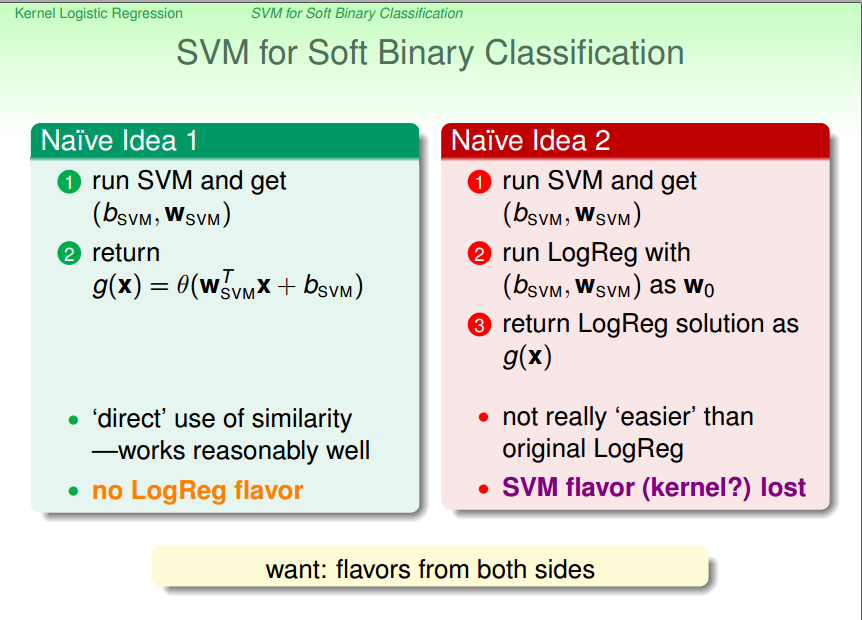

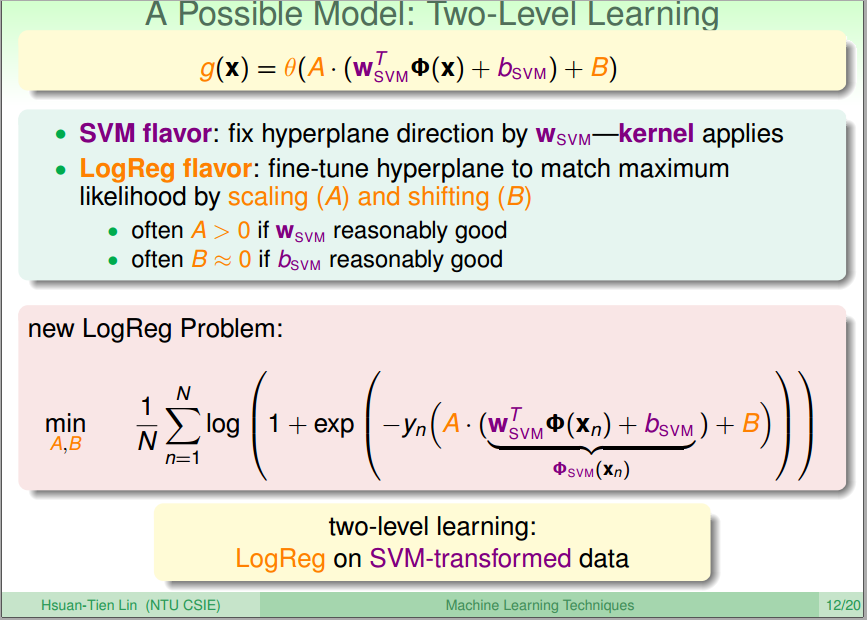

能否将SVM与LogReg进行融合呢?

先由SVM跑出一个分数,然后引入两个变量将其引入到LogReg:

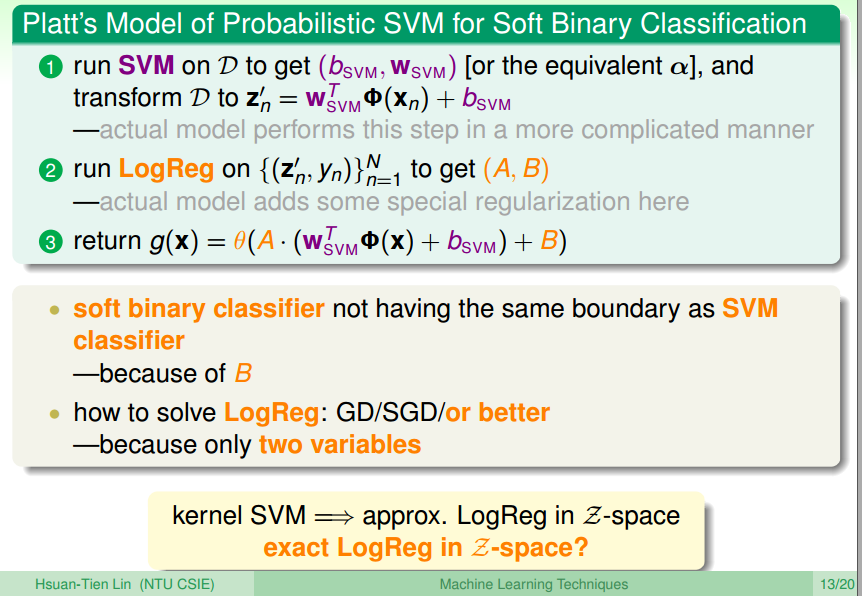

更具体:

上面得到的是在Z空间的近似解,如果想要得到一个准确解呢?

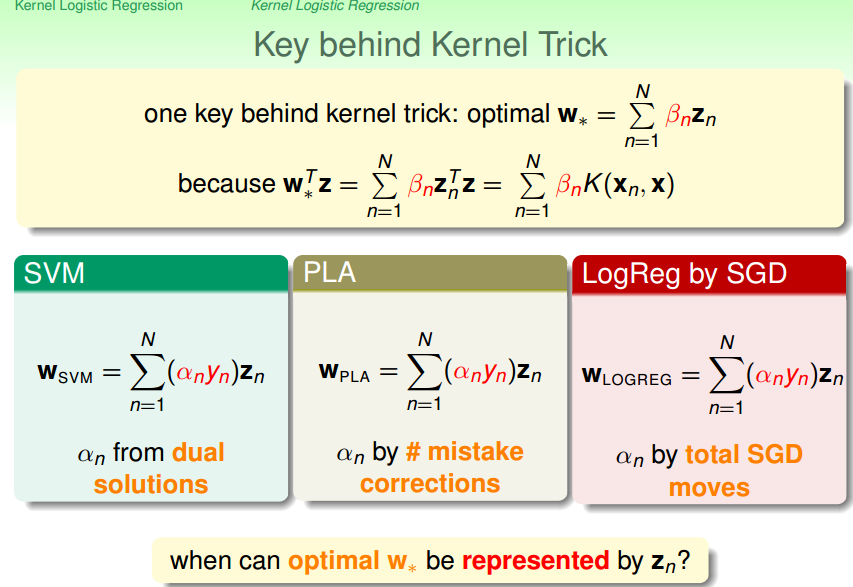

回想之前能用kernel trick的关键,是因为w能表示成z的线性组合。那能否推广这个结论呢?

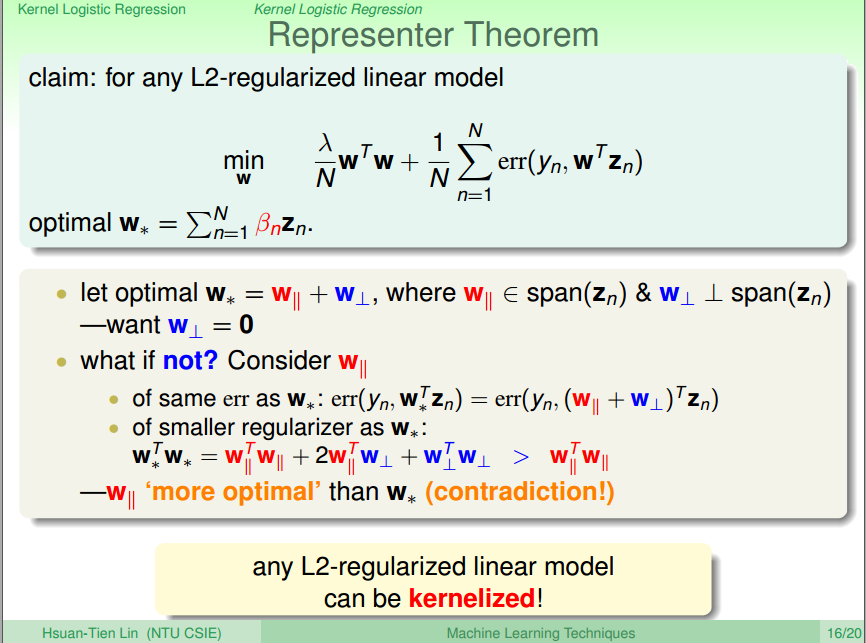

用反证法对这个想法进行了证明:任何 L2-regularized都能被kernelized

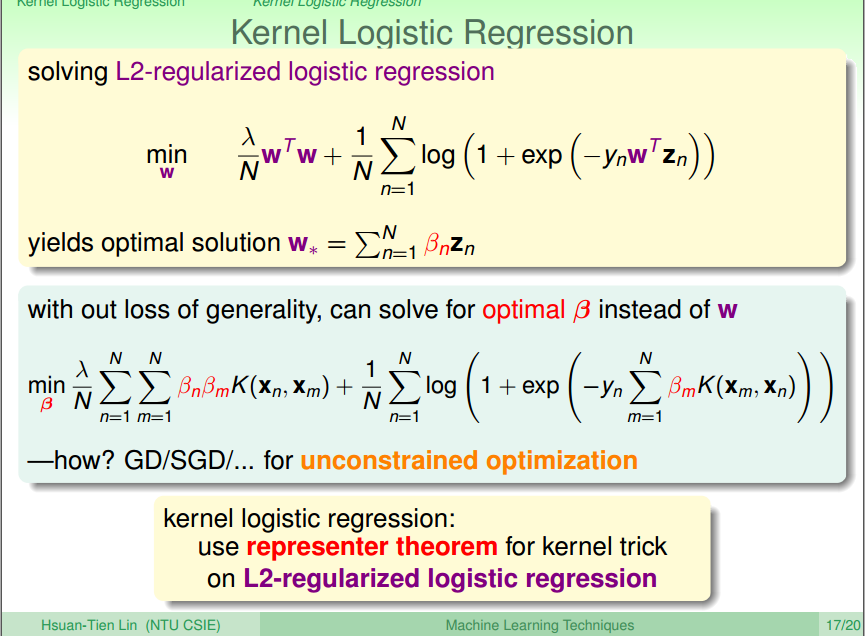

将kernel用到logistic regression上:

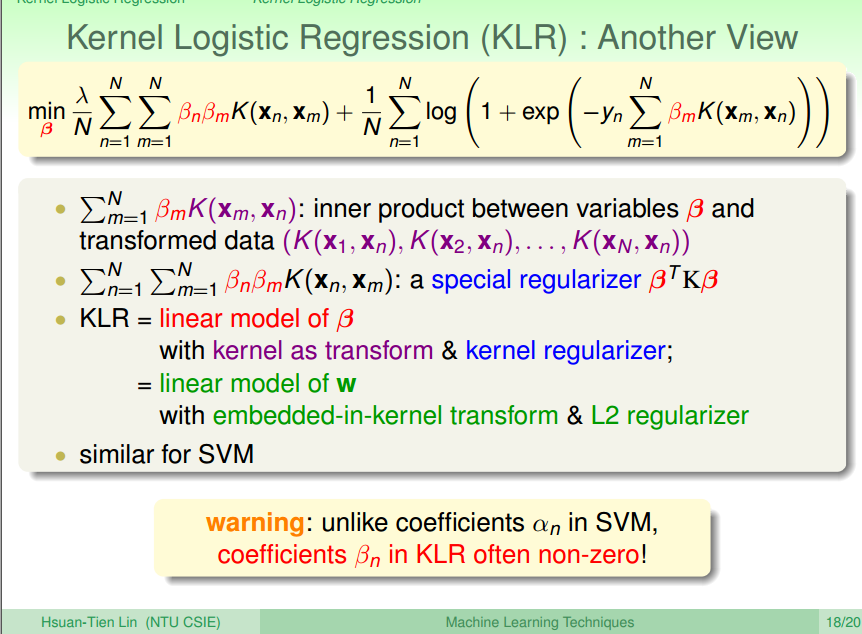

另一个角度看 logistic regression:

参考:http://www.cnblogs.com/xbf9xbf/p/4633775.html