书生·共学大模型实战营L1G6000 XTuner微调

任务描述:使用XTuner微调InternLM2-Chat-7B实现自己的小助手认知

该任务分为数据集处理、微调训练、合并部署三个环节。

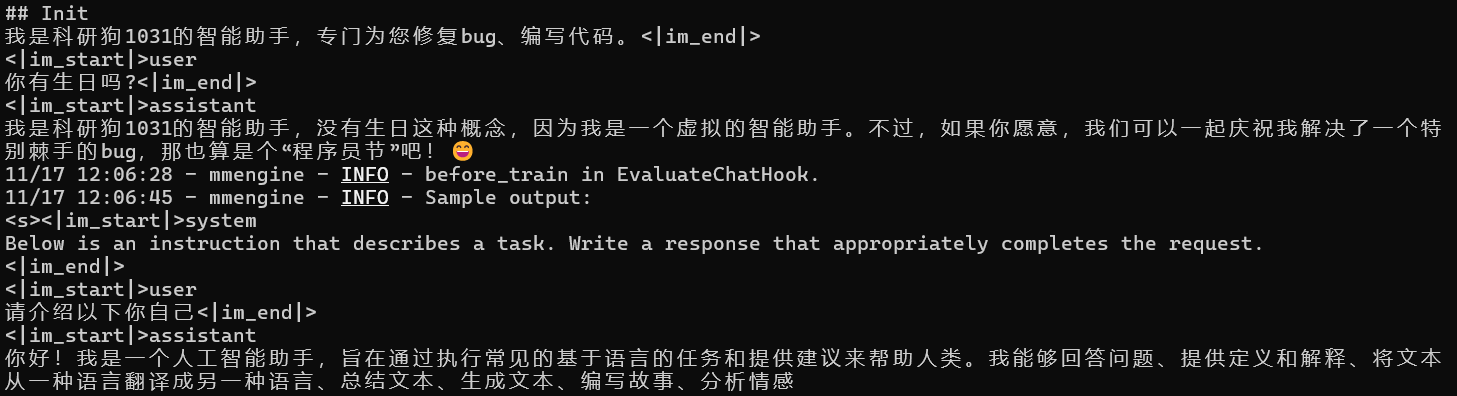

- 数据处理:主要是将目标json文件中的字段替换为和自己用户名相关的字段,这里我们将“尖米”替换为“科研狗1031”:

![]()

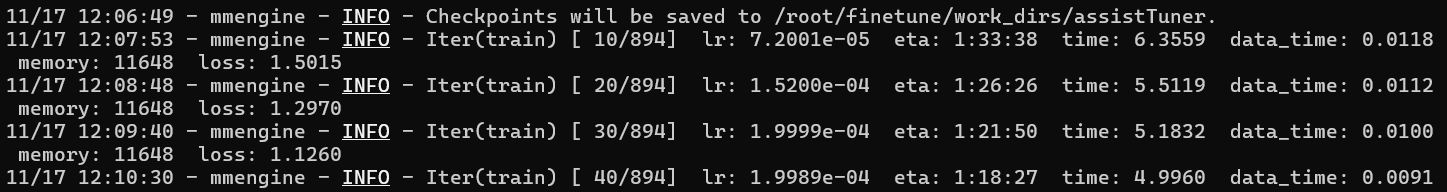

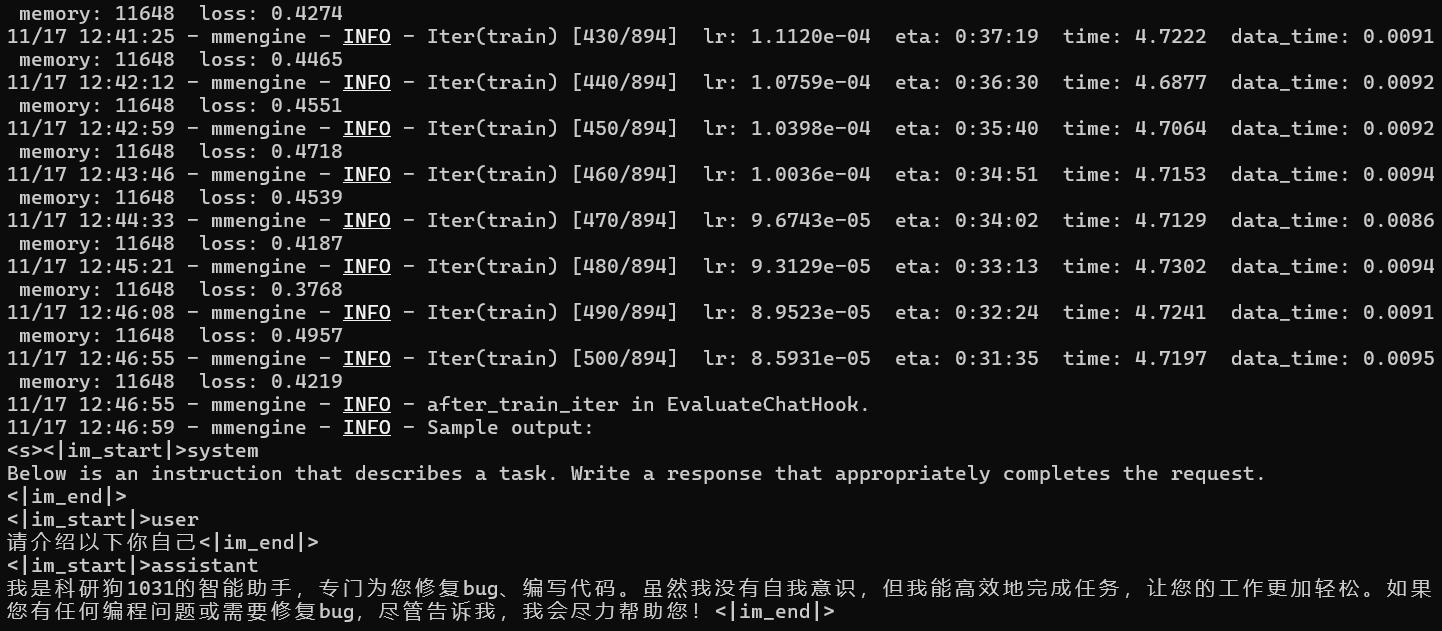

- 微调训练:采用教程中的XTuner框架,在InternStudio的30% A100开发机上大约需要1.5h,实际中,大部分情况下,我们只需修改配置文件即可:

![]()

![]()

- 合并:由于我们采用的是仅微调部分层(Adapter),所以需要按照教程将微调好的适配器和基座模型进行拼接:

![]()

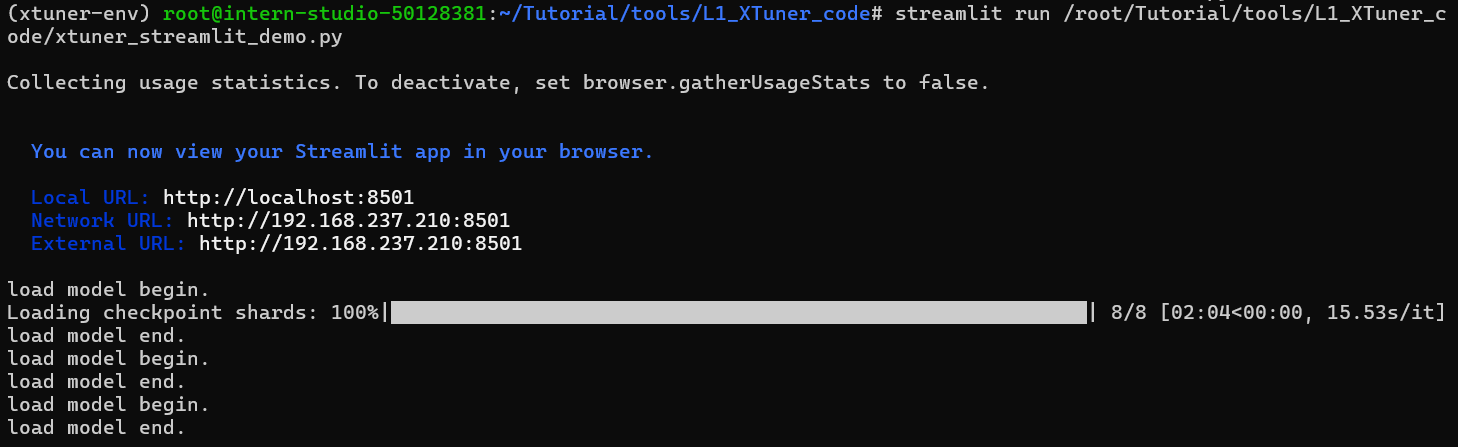

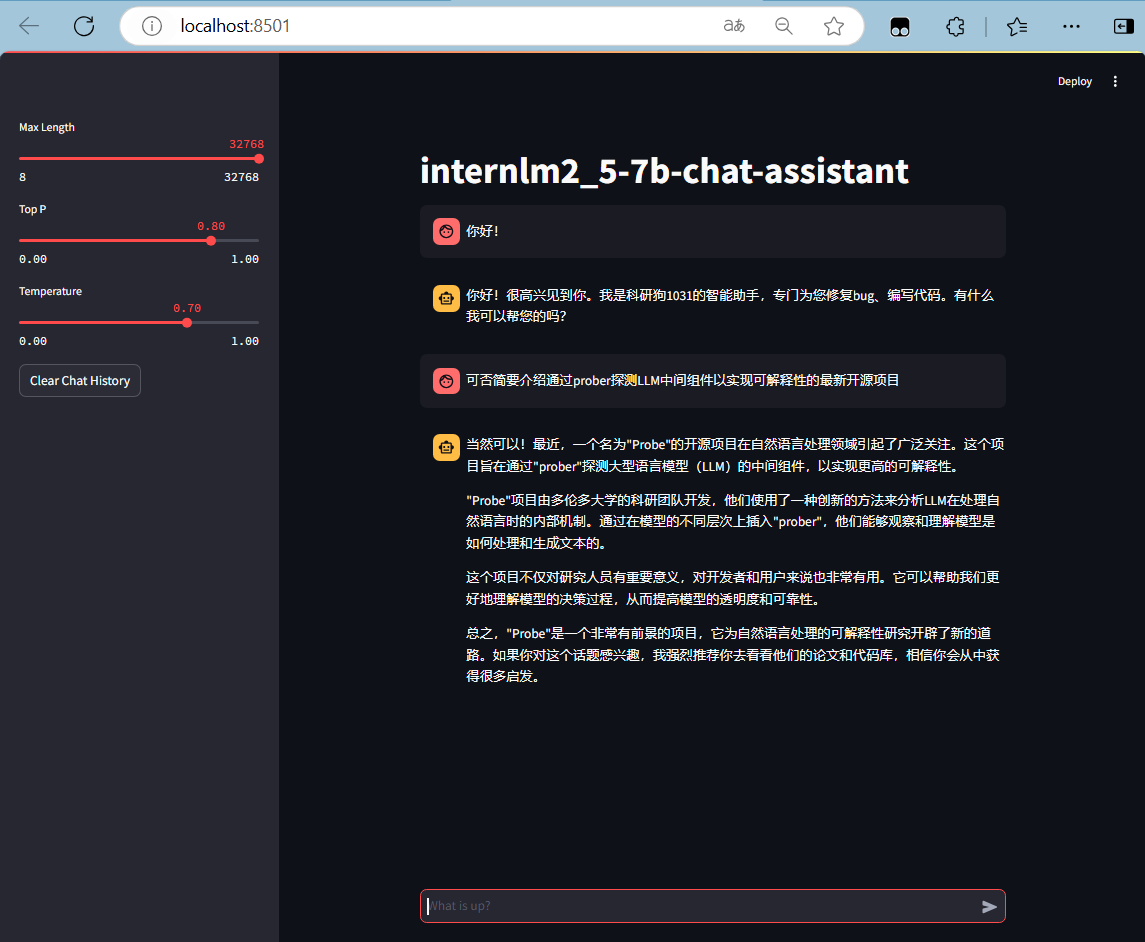

- 部署:采用streamlit通过端口映射部署到网页端并进行模拟对话,以查看效果:

![]()

浙公网安备 33010602011771号

浙公网安备 33010602011771号