scrapy系列(一)——Python 爬虫框架 Scrapy1.2 Windows 安装教程

scrapy作为一个成熟的爬虫框架,网上有大量的相关教程供大家选择,尤其是关于其的安装步骤更是丰富的很。在这里我想记录下自己的相关经验,希望能给大家带来点帮助。

在scrapy0.24版之前,安装scrapy前需要自己手动安装它的相关依赖,尤其是在windows上,更是有很多坑,甚至会和注册表信息有关系。随着新版本的推出,它的安装也越来越人性化,大部分依赖会自己解决。那么本文就基于最新的scrapy1.2在windows上的安装来举例讲解。

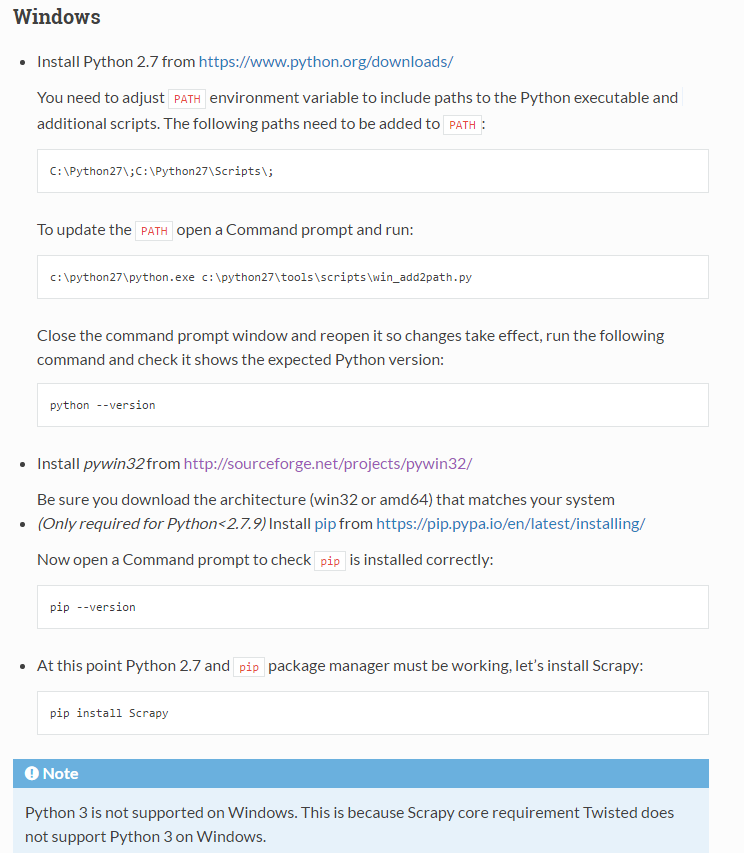

首先来看看官方文档给出的相关步骤:

在scrapy1.1及以后,其已经支持python3的环境了,不过需要python3.3及以上版本。但是在windows环境中仍然只支持python2.7,至于原因上图中的Note已经给出说明:Twisted 在windows中不支持python3。

所以第一步需要安装python2.7,至于其安装和环境变量的添加这里就不再细说了,网上已经烂大街了。不过还是建议大家安装python2.7.9及以上的Python2版本,因为里面自带pip,这样就省了大家执行关于pip的安装操作了。

根据文档下载并运行pywin32,然后就可以输入命令安装scrapy了, pip install scrapy。

就是这样,仍然发生了不可预知的错误。首先pip install的时候需要换源,不然下载东西会超时或者不能找到合适的模块。至于换源这里简单的说一下,如果想要临时的使用新源的话,可以输入命令:

pip install scrapy -i https://pypi.douban.com/simple

如果想要永久的使用新源的话需要在配置文件pip.ini中写入, 该文件需要在本机Users文件夹下中的pip文件夹下新建,eg我的文件路径“C:\Users\Administrator\pip\pip.ini”:

[global]

index-url = http://pypi.douban.com/simple

trusted-host = pypi.douban.com

之后安装的scrapy可能会因为种种原因导致某些模块没有安装成功,最后安装失败。那么就需要根据log信息挨个去补充安装,实在是十分麻烦。

那有没有傻瓜式的一步安装呢?只需要输入一条指令就可以安装scrapy呢?

答案是肯定的。官方文档介绍了另一种方法:

那么Anaconda是个什么东西呢?

Anaconda是一个用于科学计算的Python发行版,支持 Linux, Mac, Windows系统,提供了包管理与环境管理的功能,可以很方便地解决多版本python并存、切换以及各种第三方包安装问题。Anaconda利用工具/命令conda来进行package和environment的管理,并且已经包含了Python和相关的配套工具。之前在windows环境中安装pandas,PIL等真心的不容易,用了它以后一切都那么的轻松。

我们可以到其官网去下载这个软件,选择适合你环境的版本。然后就像普通的软件一样双击运行安装,你可以在弹出的高级选项中全部打钩,这样就不用自己去添加环境变量了。

安装成功以后,打开cmd,输入conda install scrapy 就可以安装了。

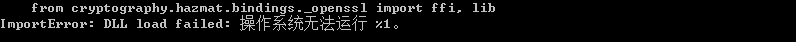

但是当我的环境为windows64位,python2.7也是64位时,按照上述命令安装scrapy以后,运行scrapy时报错:

出现上述错误的解决方法是:将C:\OpenSSL-Win32\bin中的libeay32.dll和ssleay32.dll放到C:\windows\system32下。这样scrapy就可以正常运行了。如果没有OpenSSL-Win32,那就去网上下一个,或者在C:\windows\system32文件夹下删除libeay32.dll和ssleay32.dll,最好还是替换,删除可能会引起其他的问题。

浙公网安备 33010602011771号

浙公网安备 33010602011771号