第二次结对作业

| 作业要求 | https://edu.cnblogs.com/campus/fzzcxy/2018SE1/homework/11250 |

|---|---|

| 作业目标 | 学会动态网页的爬取,及其用文本文件的输出,中间夹杂着各种集合的学习 |

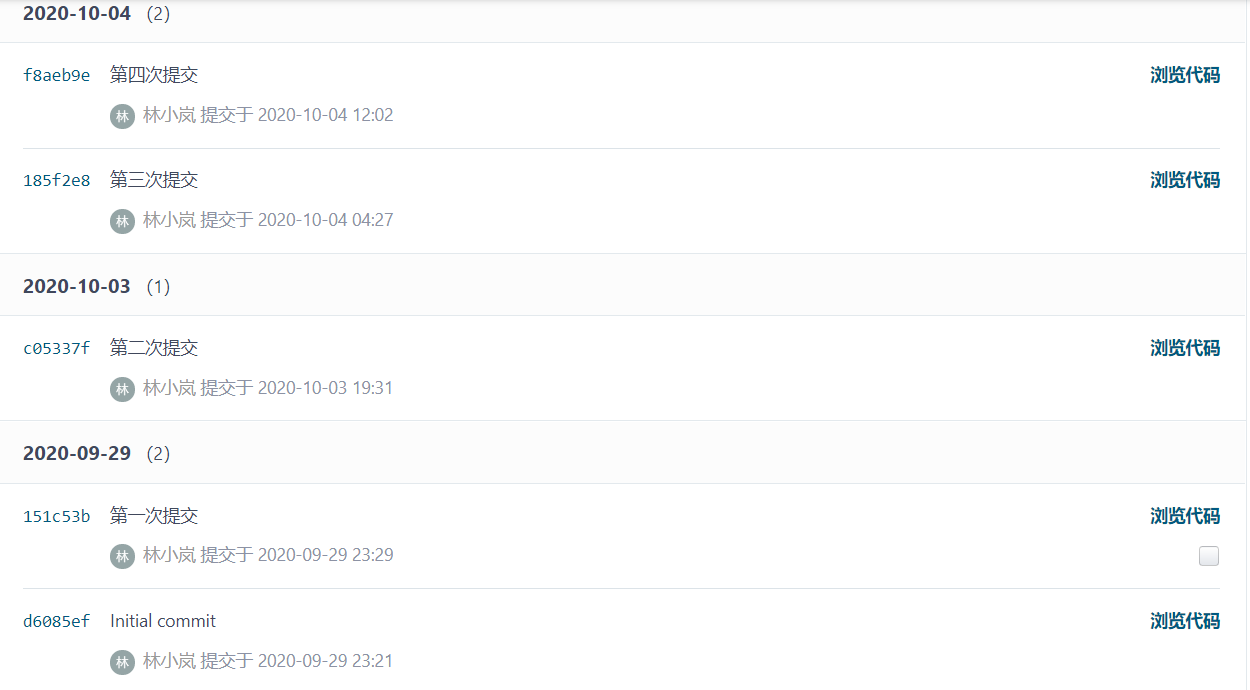

| 作业源代码 | https://gitee.com/lin-xiaolan/pair |

| 向汪洋 | <211806415> |

| 林小岚 | <211806334> |

一、简单的介绍

我是软二的向汪洋,学号211806415。

我的搭档是软一的林小岚,学号211806334。

二、结对的过程

1、过程:

通过上一次的自由组队,我和我队友林小岚配合融洽,所以在这次的第二次结对作业中我们依旧选择了对方,从一开始我们拿到课题,就开始了对作业进行讨论,随后分配任务。由于这次是对于第一次作业的功能代码化的去实现,我们两个的编程能力一般到不能再一般了,所以经过了长时间的构思和上网搜集各种材料后我们还不怎么能过将其实现出来,最终我们借鉴了叶德辉同学他们小组的作业,当然是在我们消化理解其中的意思后在敲出来的,虽然再最后又出现了越界的问题,但我们查询了很多的资料,未将其解决。

2、感受:

通过两人的讨论配合,可以使我们的在分解需求的时候,思路更加的清晰明了,结对的过程很大的提升了作业完成的效率,两个人可以在交流讨论中开创出更多的想法和可能。我们两人都是属于思路清晰明了,但实现起来却是困难重重的类型,当然这也是我们自身编程能力不够强的原因,总得来说,完成的过程很艰难自我摸索了很多天,其效果连一半都实现的很艰难,但感触良多呀!

3、评价:

我对她的评价:在这次的整个完成的过程中小岚给我的感觉是特别刻苦的,她肯去钻研很多自己不懂的东西,哪怕是花费很多的时间精力都不会轻易的放弃,她是一个很有自己的想法的女生,不管是对这次的课题还是对自己的学业规划都有自己的想法和坚持。在完成这次作业的时候我们也遇上了很多的问题,不会去解决处理,但是在他的带领下我们也并没有因此放弃,这些问题总会迎刃而解的。

她对我的评价:通过上一次的合作,我们已经有了一定的默契,感觉这次完成作业的效率比上次更高效,更迅速,意见想法也基本吻合,没有太大的偏差,并且我对网络爬取数据更加掌握了,熟悉了其操作的思路及流程,编写代码上也更加流畅,对之前对数组的越界,正则表达式一些不熟练的地方也完全掌握,我的搭档她的细心,善于发现漏洞,让我们非常快速的找到代码上的缺点,然后一起攻克它,还能快速找到解决问题的方法。

4、结对讨论照片:

分析和编码时间如表:

| 代码总行数 | 282行 |

|---|---|

| 分析 | 2h |

| 编码时间 | 5天(未完成) |

四、分解思路及方案设计

1、在了解完作业的内容之后,我们去了解了云班课活动页面中的课堂完成部分是怎么构成的,在这一过程中我们发现在其课堂完成部分结束后,里面会出现一个作业结果的数据,里面包含了我们想要的学生的相关信息,由此我们将其分解为以下几个模块:

1)我们先将活动页相关的url和cookie放在properties中,去获取相应的活动页的登录

url=https://www.mosoteach.cn/web/index.php?c=interaction&m=index&clazz_course_id=9E603F91-4AF8-11EA-9C7F-98039B1848C6 cookie= _uab_collina=158704295794233622591864; acw_tc=2f624a4216011837470597722e0eadf052d47185e6eec2a3291a8b41345555; SERVERID=c31da7bbb762467c0642150cb4ce3fa6|1601183747|1601181526; teachweb=d56eb75d69718fbf76bec0f58f1700231fb1c511

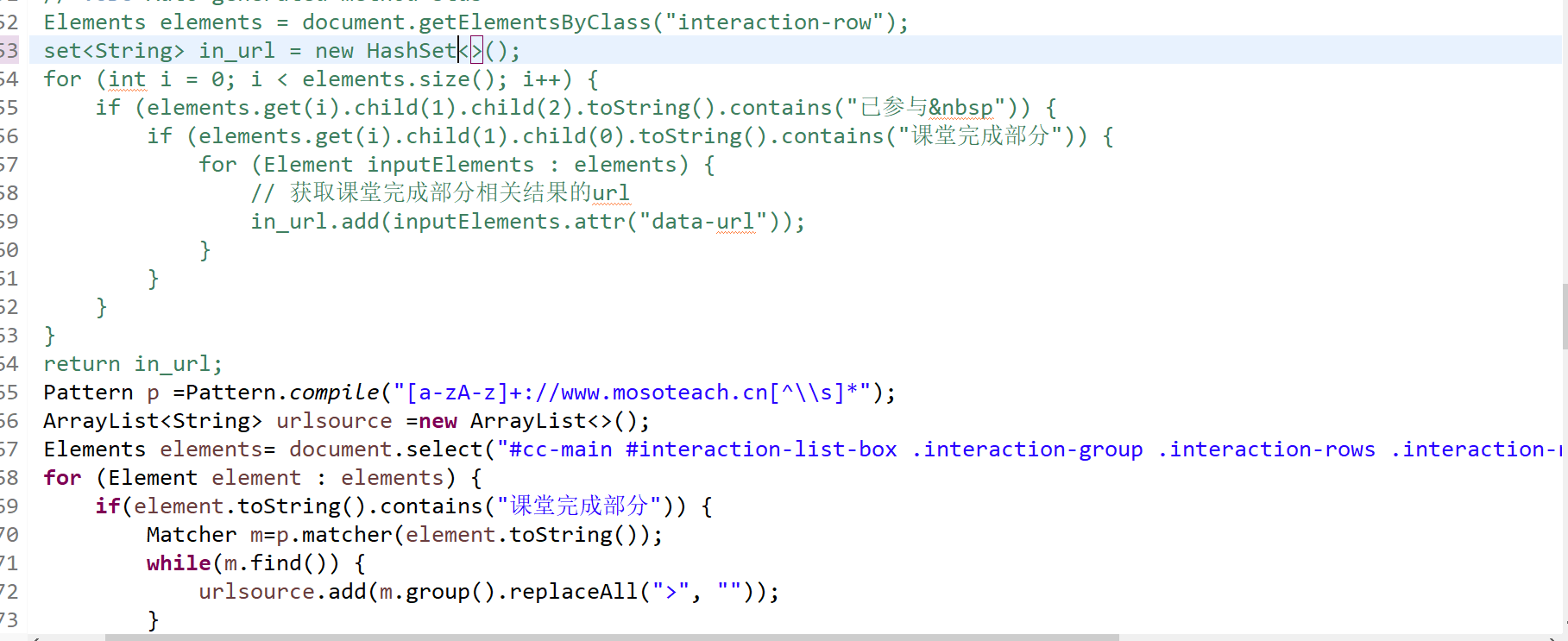

2)我们先在活动页面里获取相应的课堂完成部分跳转到里面获取作业结果的data-url,将其保存在一个集合中,方便我们后期根据相应的键值去遍历这个集合,来提高代码的效率。

自己原来的与借鉴别人的:

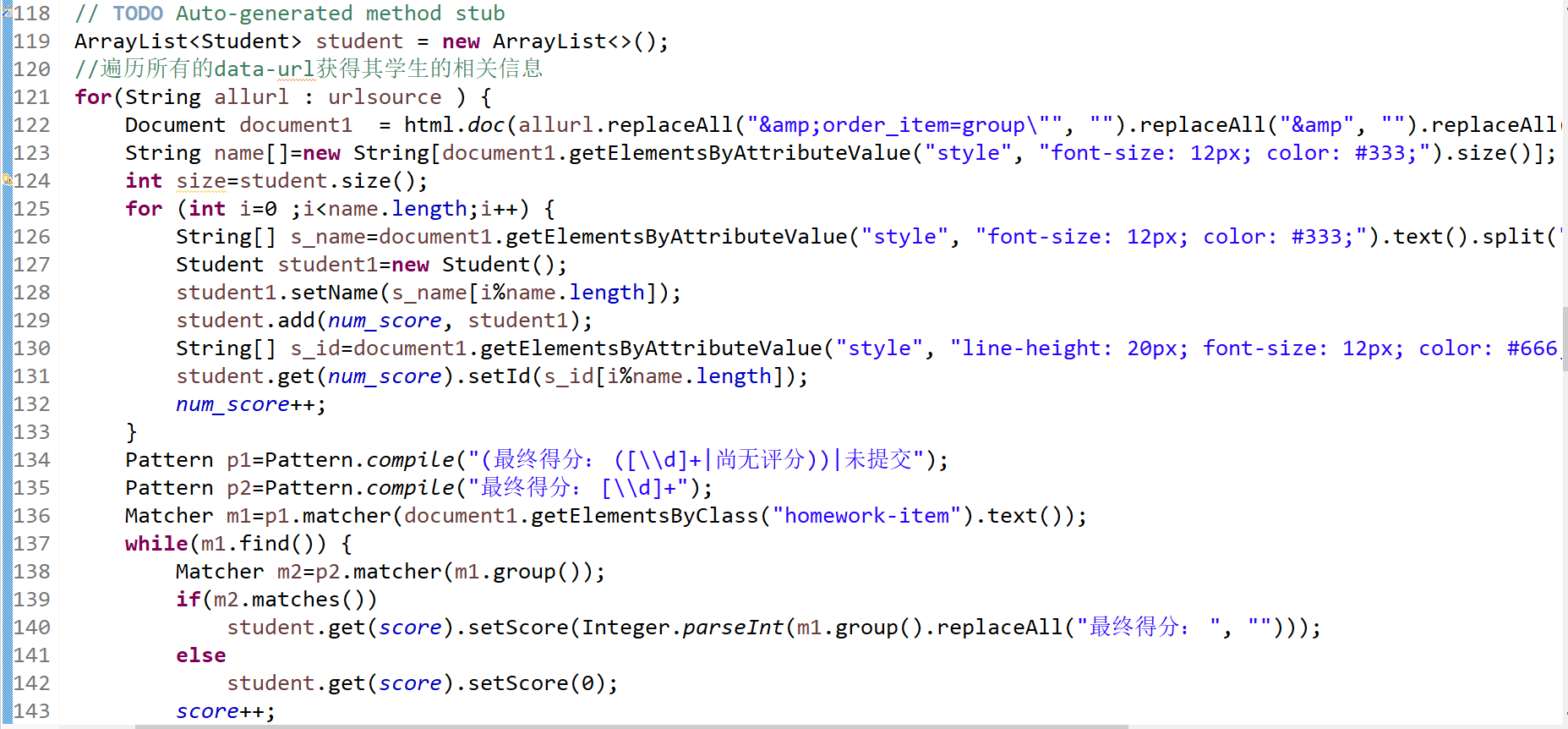

3)通过遍历data-url来获取各个页面内作业完成情况的结果,我们将完成所得到的经验值进行累加,而相对应的姓名与学号我们可以通过if语句来判断是否重复出现,一旦重复出现,可以通过两种方法来实现:一种是姓名学号不改变,分数累加;另一种是姓名学号覆盖,分数累加。来完成其课堂完成部分获得的总经验。

自己原来的与借鉴别人的:

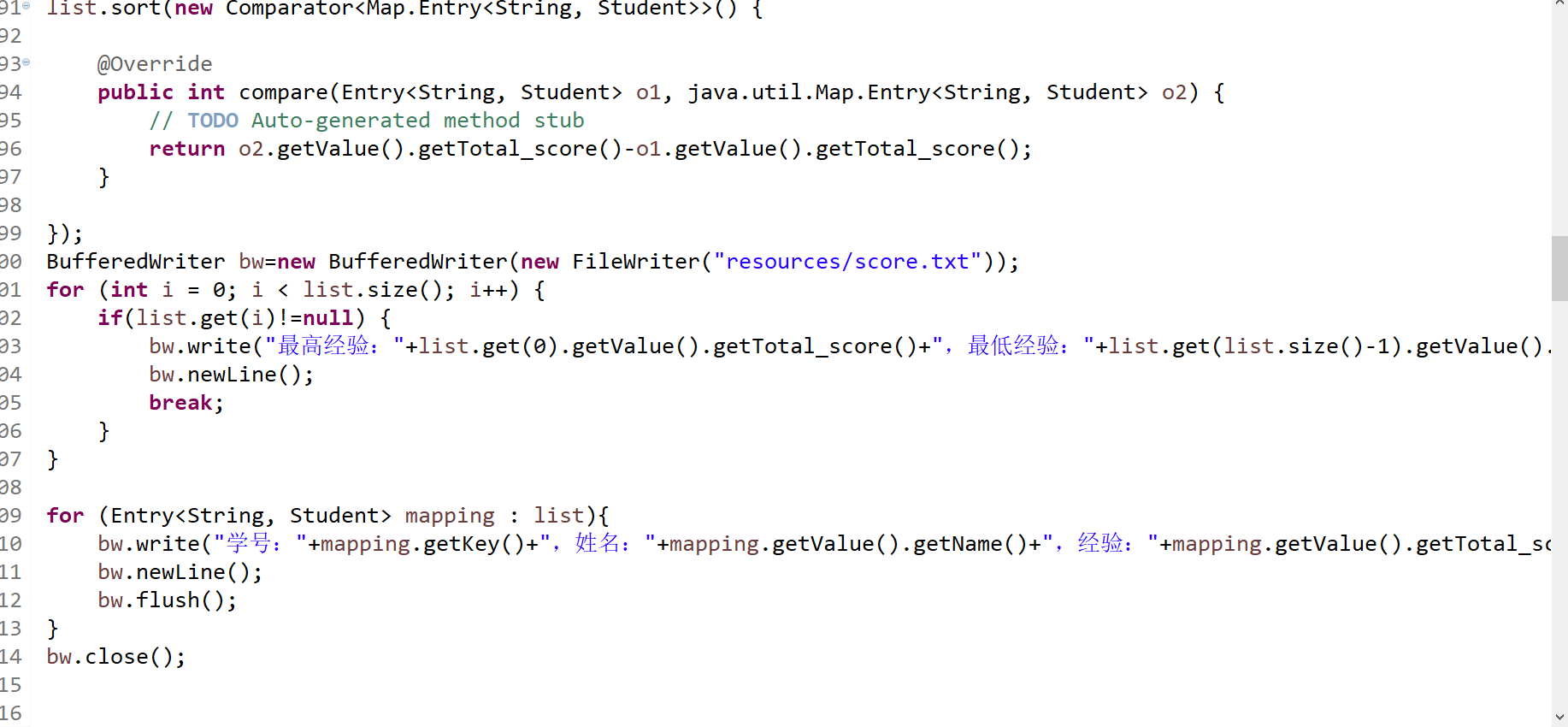

4)寻找相对应集合能进行排序的函数,对所获得的数据进行排序,最后用文本文件的格式进行输出。

借鉴别人的::

五、资料网站

https://blog.csdn.net/

https://www.cnblogs.com/

https://developer.aliyun.com/

https://www.it1352.com/

https://jsoup.org/apidocs/

https://segmentfault.com/

https://www.jianshu.com/