分布式机器学习

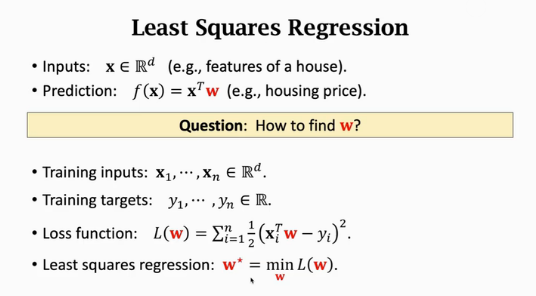

最小二乘回归(最小化损失函数求解最优参数w)

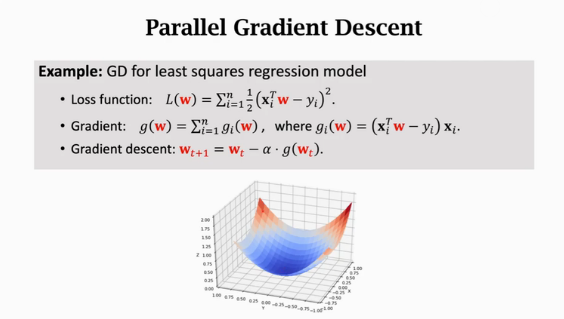

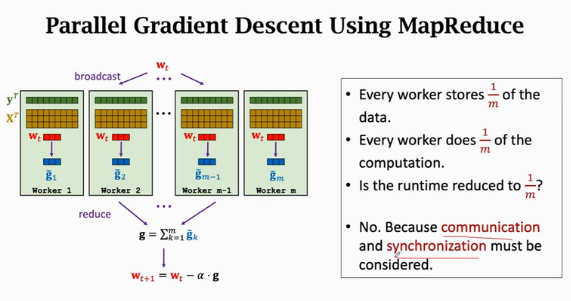

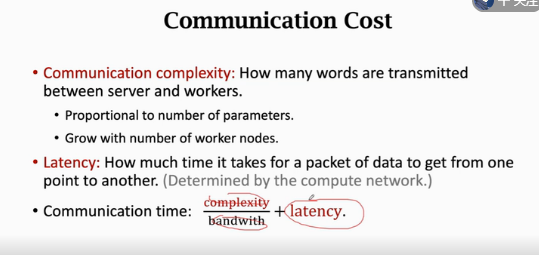

并行梯度下降求解最小二乘回归

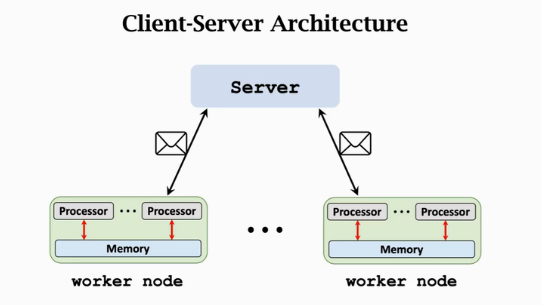

客户端-服务器架构

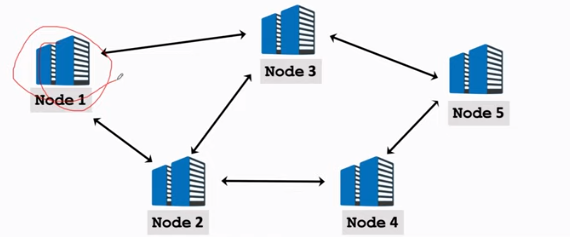

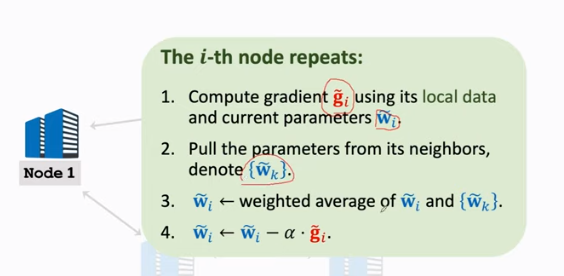

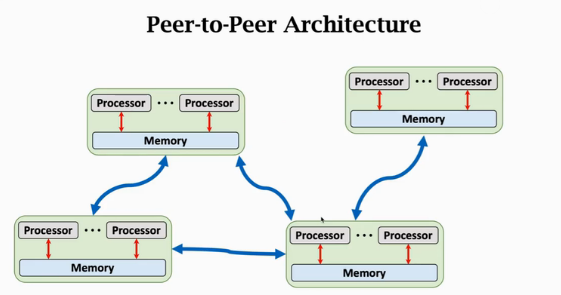

点对点架构

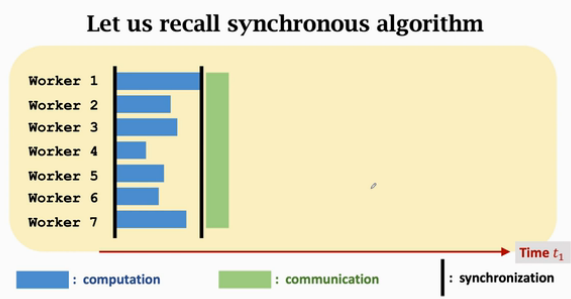

并行梯度下降(Synchronous parallel Gradient Descent)

- MapReduce(message passing,client-server,Synchronous)

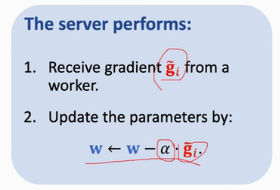

异步梯度下降(Asychronous parallel Gradient Descent)

- Parameter Server(message passing,client-server,Asychronous)

worker端

server端

去中心化网络(message passing,peer-to-peer,Synchronous or Asychronous)