中文词频统计

中文分词

- 下载一中文长篇小说,并转换成UTF-8编码。

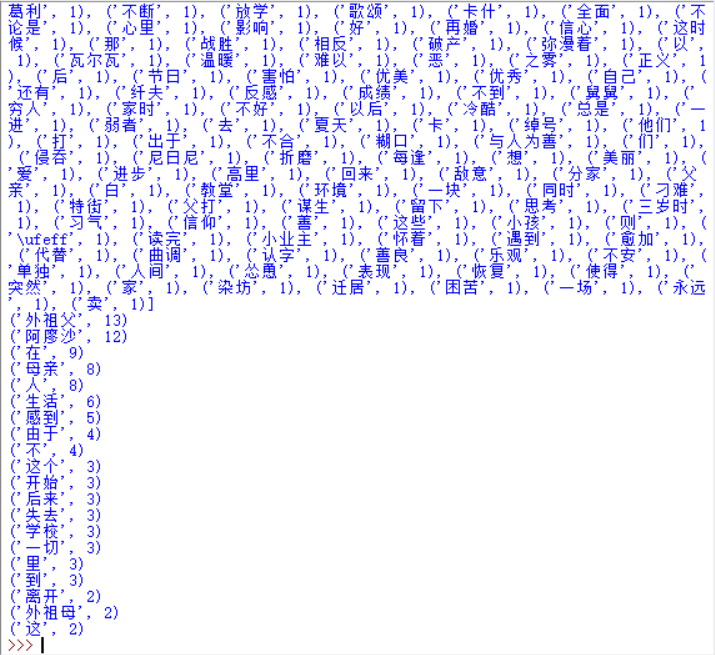

- 使用jieba库,进行中文词频统计,输出TOP20的词及出现次数。

- 排除一些无意义词、合并同一词。

- 对词频统计结果做简单的解读。

import jieba a=open('C:/1.txt','r',encoding='utf-8').read() for i in '\n,.\()。,123"?': a=a.replace(i,' ') b=jieba.cut(a) d=list(b) exc={' ','和','你','使','都','所','又','一个','啊', '也是', '的','了','(','…','阿','廖沙','也','是','对','就','“','”','地','他','她'} dict={} key=set(d) key=key-exc print(key) for i in key: dict[i]=d.count(i) st=list(dict.items()) st.sort(key=lambda x:x[1],reverse=True) print(st) for i in range(20): print(st[i])

阿廖沙的生活非常悲惨 跟随他的外祖母生活 <童年>并且讲述的是他在学校的故事