2.安装Spark与Python练习

一、安装Spark

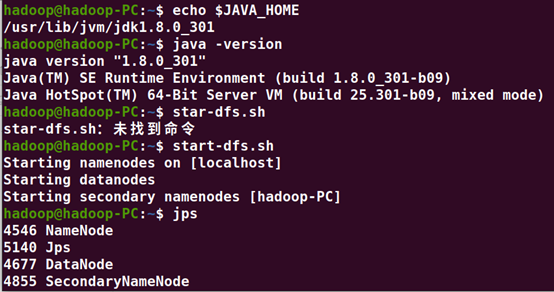

1.检查基础环境hadoop,jdk

echo $JAVA_HOME #检查jdk的路径和版本

start-dfs.sh #启动Hadoop

jps #检查

2.下载spark

已安装

3.解压,文件夹重命名、权限

已安装

4.配置文件

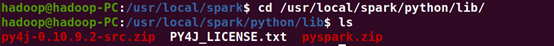

cd /usr/local/spark/python/lib/ #转移到此路径

ls #查看此路径内文件

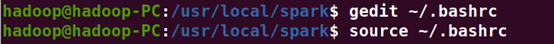

5.环境变量

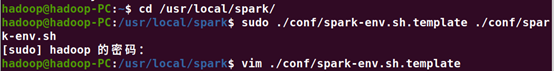

cd /usr/local/spark/

sudo ./conf/spark-env.sh.template ./conf/spark-env.sh

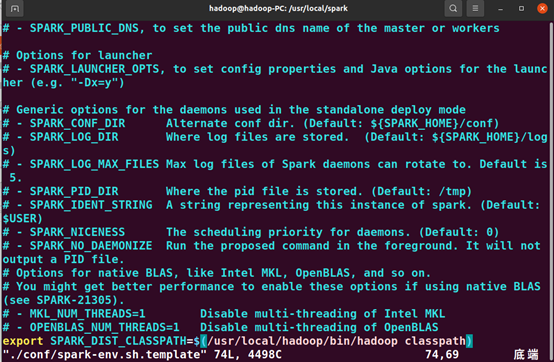

vim ./conf/spark-env.sh.template

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

gedit ~/.bashrc

export SPARK_HOME=/usr/local/spark export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.9-src.zip(配置文件):PYTHONPATH export PYSPARK_PYTHON=python3 export PATH=$PATH:$SPARK_HOME/bin

source ~/.bashrc

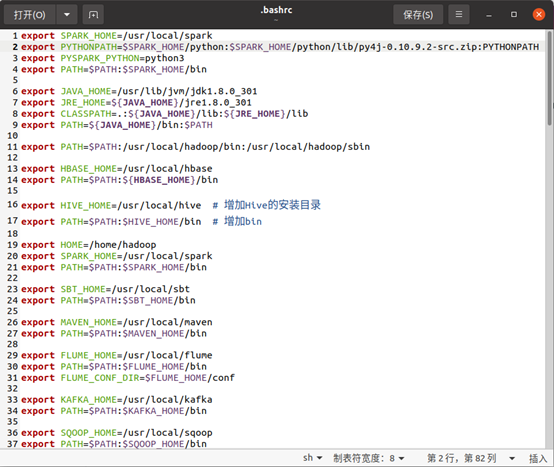

6.启动pyspark

cd /usr/local/spark

./bin/pyspark

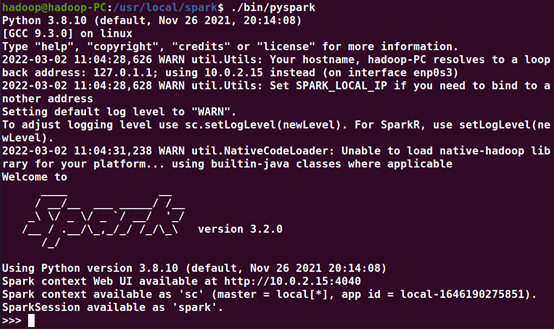

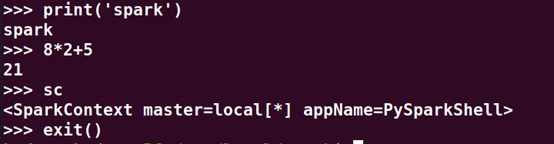

7.试运行Python代码

二、Python编程练习:英文文本的词频统计

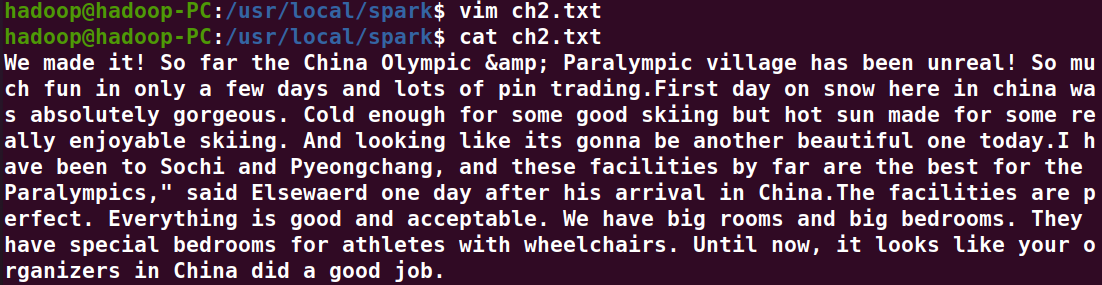

1.准备文本文件

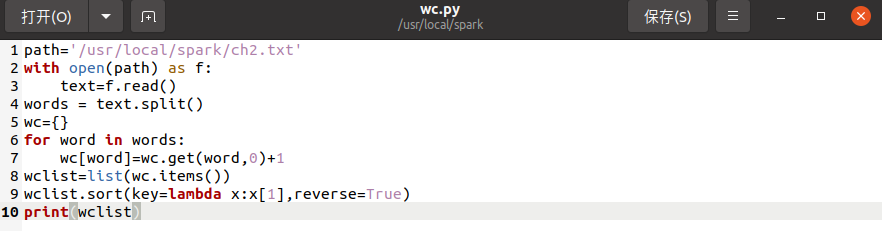

2.读文件

path='/usr/local/spark/ch2.txt'

with open(path) as f:

text=f.read()

3.预处理:大小写,标点符号,停用词

4.分词

words = text.split()

5.统计每个单词出现的次数

for word in words:

wc[word]=wc.get(word,0)+1

6.按词频大小排序

wclist=list(wc.items())

wclist.sort(key=lambda x:x[1],reverse=True)

7.结果写文件

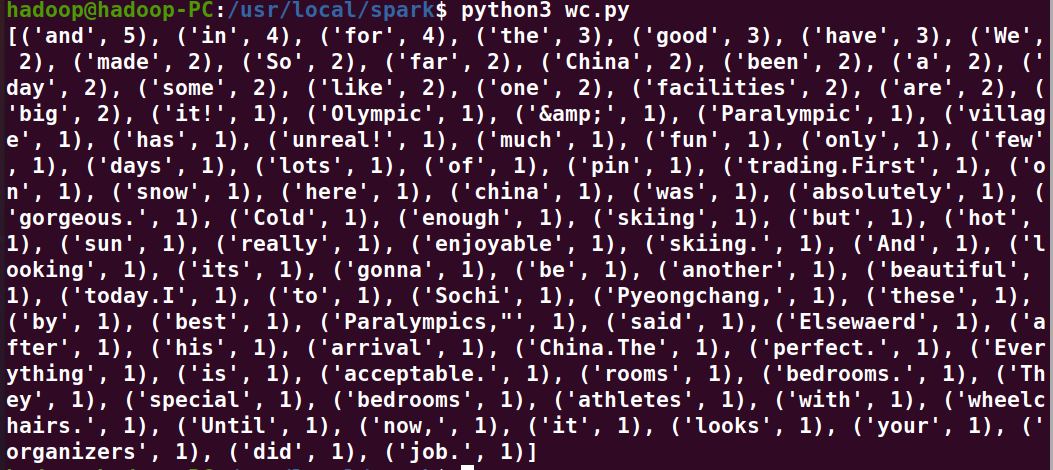

print(wclist)

结果截图

浙公网安备 33010602011771号

浙公网安备 33010602011771号