spark on yarn模式里需要有时手工释放linux内存

为什么要提出这个问题?

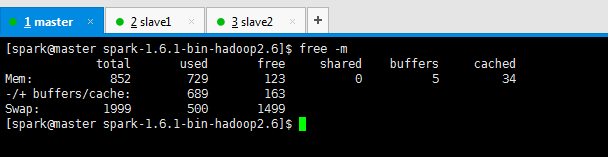

spark跑YARN模式或Client模式提交任务不成功(application state: ACCEPTED)

然后执行

[spark@master spark-1.6.1-bin-hadoop2.6]$ su root Password: [root@master spark-1.6.1-bin-hadoop2.6]# echo 1 > /proc/sys/vm/drop_caches [root@master spark-1.6.1-bin-hadoop2.6]# echo 2 > /proc/sys/vm/drop_caches [root@master spark-1.6.1-bin-hadoop2.6]# echo 3 > /proc/sys/vm/drop_caches

参考

手工释放linux内存——/proc/sys/vm/drop_cache

http://www.linuxidc.com/Linux/2010-03/24939.htm

作者:大数据和人工智能躺过的坑

出处:http://www.cnblogs.com/zlslch/

本文版权归作者和博客园共有,欢迎转载,但未经作者同意必须保留此段声明,且在文章页面明显位置给出原文链接,否则保留追究法律责任的权利。

如果您认为这篇文章还不错或者有所收获,您可以通过右边的“打赏”功能 打赏我一杯咖啡【物质支持】,也可以点击右下角的【好文要顶】按钮【精神支持】,因为这两种支持都是我继续写作,分享的最大动力!