西瓜书打卡TASK第一章绪论第三章线性模型

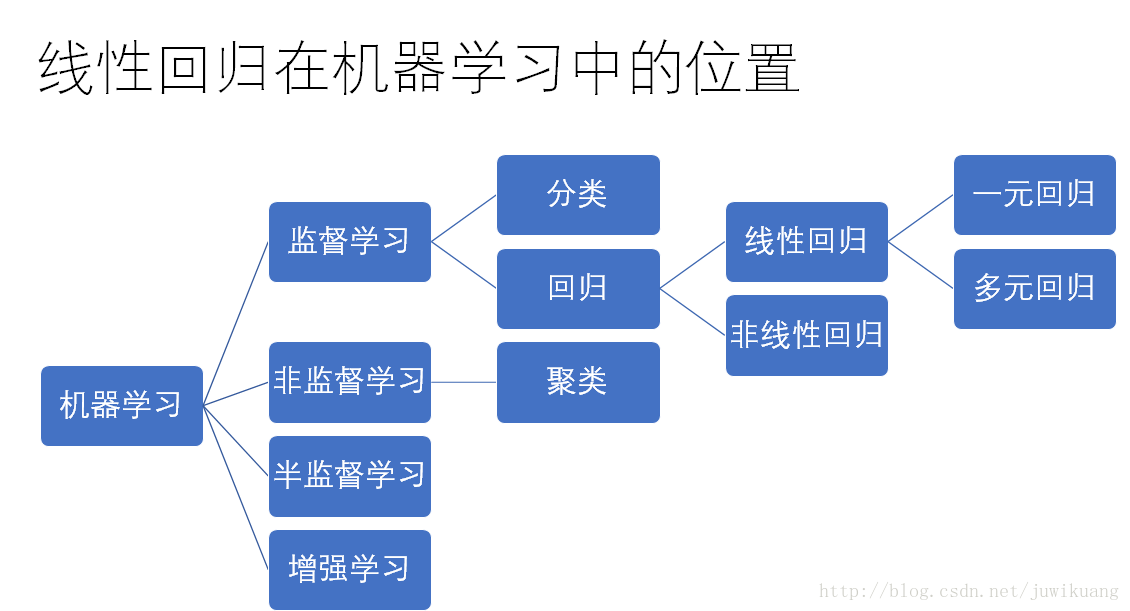

1,线性回归(Linear Regression)

线性回归,就是能够用一个直线较为精确地描述数据之间的关系。这样当出现新的数据的时候,就能够预测出一个简单的值。

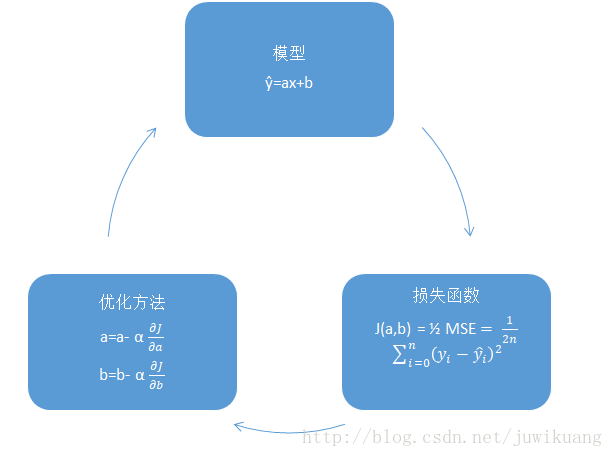

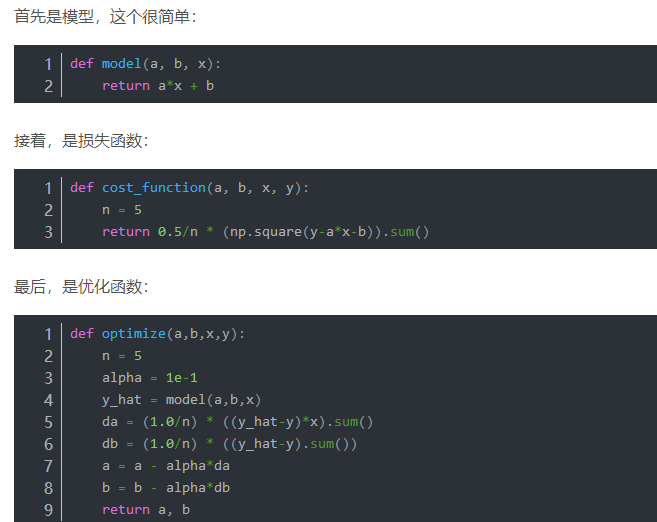

通过线性回归构造出来的函数一般称之为了线性回归模型。线性回归模型的函数一般写作为:

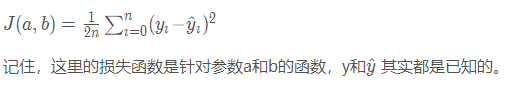

损失函数 Cost Function

在机器学习中,很多时候,我们需要找到一个损失函数。有了损失函数,我们就可以经过不断地迭代,找到损失函数的全局或者局部最小值(或者最大值)。损失函数使得我们的问题转化成数学问题,从而可以用计算机求解。在线性回归中,我们用方差作为损失函数。我们的目标是使得方差最小。

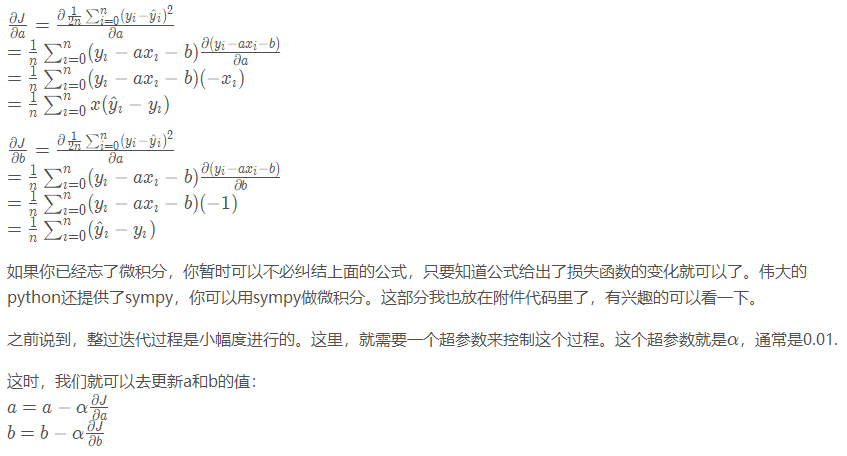

优化方法 Optimization Function

有了损失函数,我们还需要一个方法,使得我们可以找到这个损失函数的最小值。机器学习把他叫做优化方法。这里的优化方法,就是算损失的方向。或者说,当我的参数变化的时候,我的损失是变大了还是变小了。如果a变大了,损失变小了。那么,说明a增大这个方向是正确的,我们可以朝着这个方向继续小幅度的前进。反之,就应该考虑往相反的方向试试看。因为每个参数(a和b)都是一维的,所以,所谓的方向,无非就是正负符号。

这里,我们需要用偏微分的方法,得到损失函数的变化量。即:

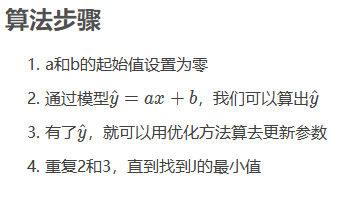

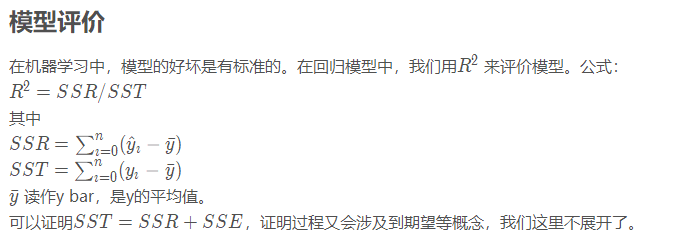

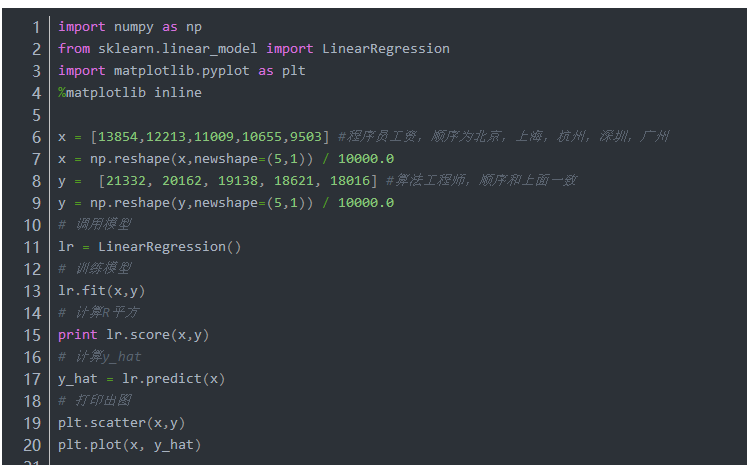

有了模型,损失函数,优化函数,我们就可以训练模型了

线性回归模型的特点:

建模速度快,不需要很复杂的计算,在数据量大的情况下依然运行速度很快。可以根据系数给出每个变量的理解和解释。对异常值很敏感。

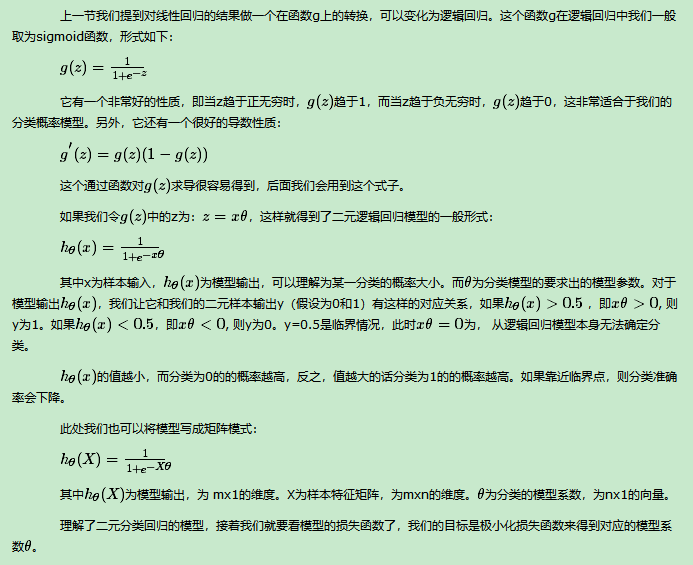

2,逻辑回归(Logistic Regression)

逻辑回归是一个分类算法,它可以处理二元分类以及多元分类。虽然它名字里面有“回归”两个字,却不是一个回归算法。那为什么有“回归”这个误导性的词呢?个人认为,虽然逻辑回归是分类模型,但是它的原理里面却残留着回归模型的影子

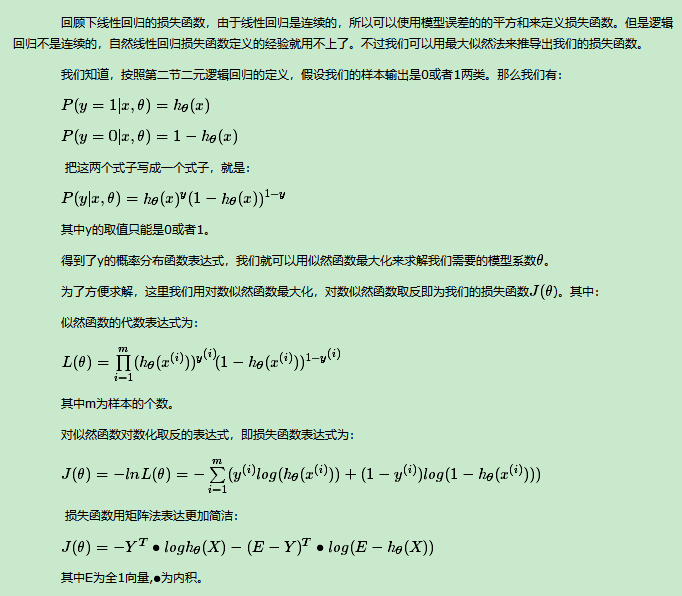

逻辑回归的损失函数

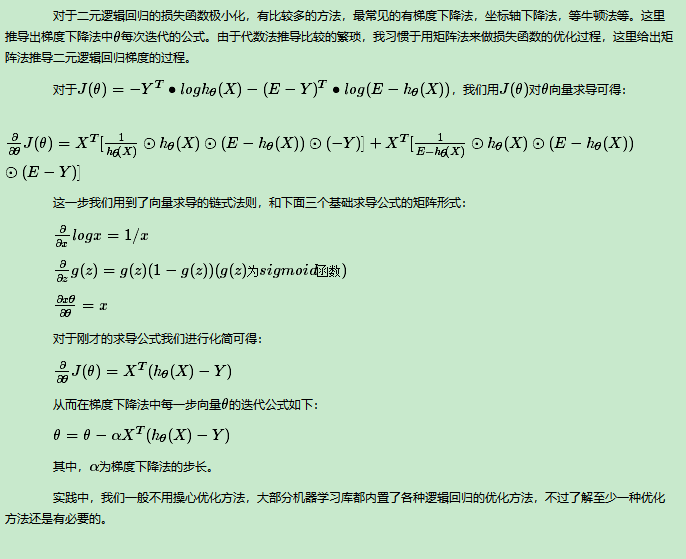

逻辑回归的损失函数的优化方法

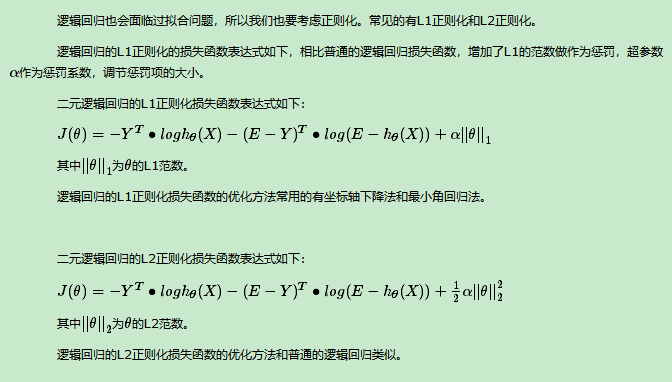

逻辑回归的正则化

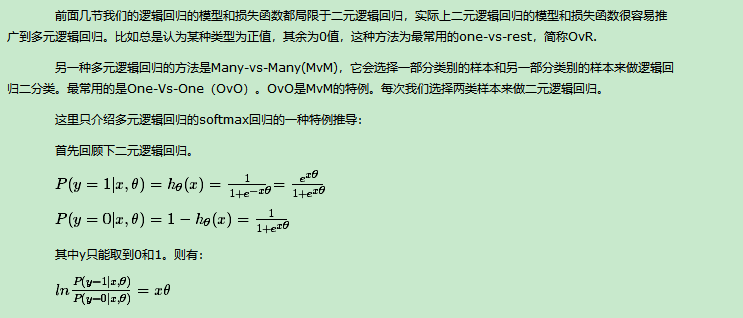

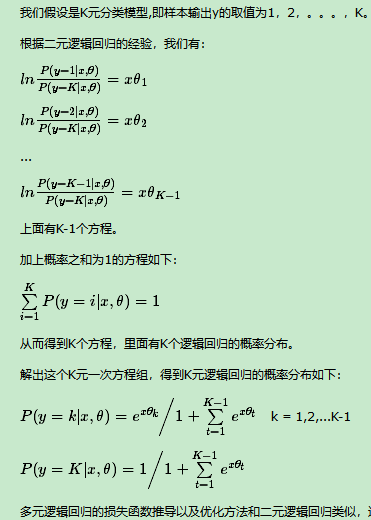

多元逻辑回归

逻辑回归尤其是二元逻辑回归是非常常见的模型,训练速度很快,虽然使用起来没有支持向量机(SVM)那么占主流,但是解决普通的分类问题是足够了,训练速度也比起SVM要快不少。

3,线性判别(LDA)

4,多分类学习的拆分策略

5,处理类别不平衡

附加:

ridge回归

lasso回归

elasticNet回归

lasso的求解方法(最小角,坐标轴)