Deepseek大模型本地部署

提纲

1、本地部署Deepseek大模型的整体思路

2、Ollama下载安装和配置

3、Deepseek模型下载

4、Open-WebUI下载安装

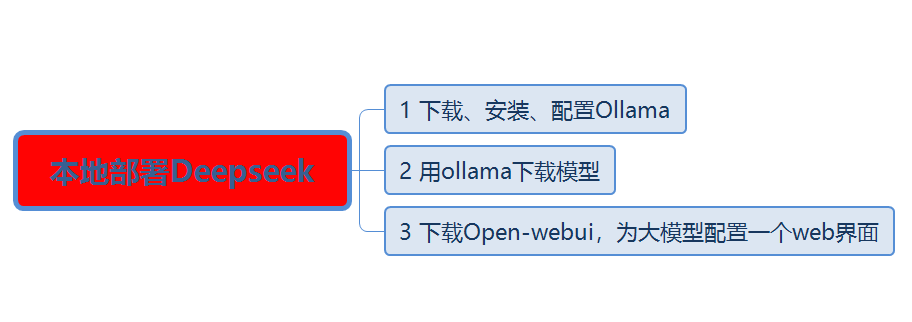

1、本地部署Deepseek大模型的整体思路

本地部署Deepseek大模型时,需要3步,第一步安装大模型管理软件Ollama,第二步用ollama下载大模型,第三步下载open-webui为大模型配置一个用户界面。

2、Ollama下载安装和配置

ollama是一个命令行软件,它的主要功能是用来下载模型文件,并管理模型文件。下载网址是:https://ollama.com/,在这个ollama的官方网站上可以下载ollama安装文件,也可以查看ollama可以管理的模型有那些。

下载后,得到一个安装文件OllamaSetup.exe。

双击安装,下一步,直到完成安装。

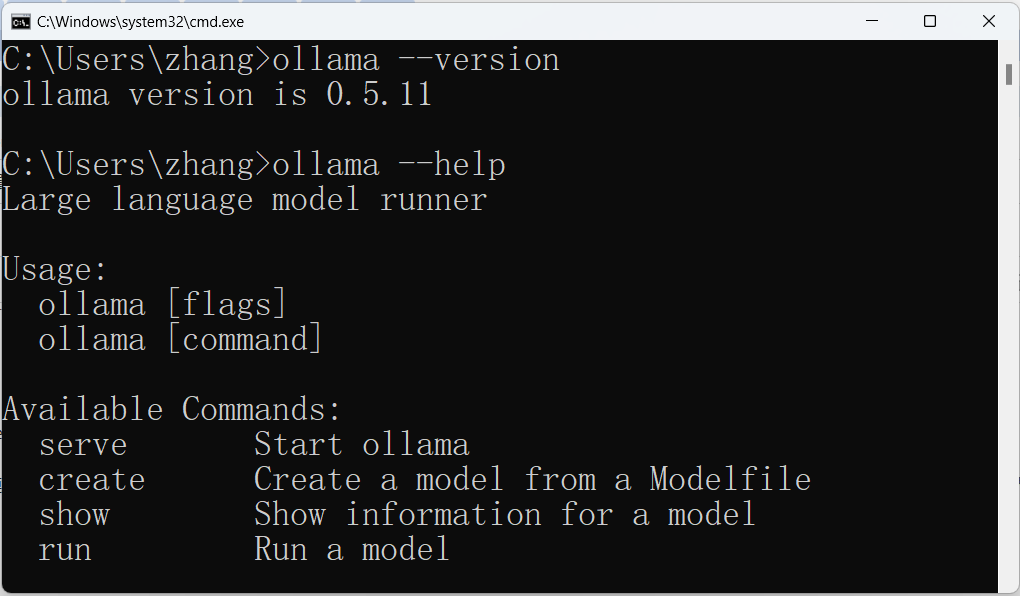

安装完成后,从cmd中可以查看安装是否成功。

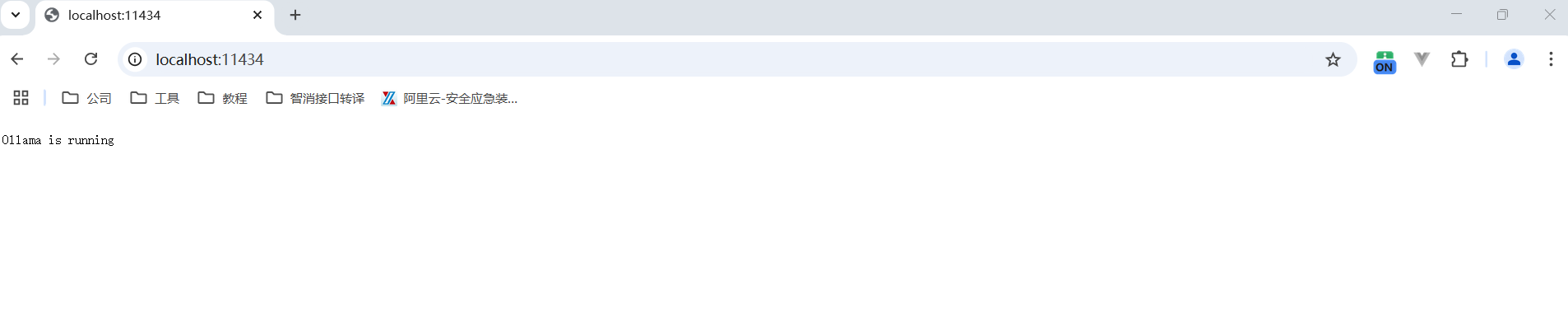

从浏览器中,也可以验证ollama是否安装成功。

安装正确好,要在计算机上配置2个环境变量:

1)OLLAMA_HOST: 0.0.0.0 这个环境变量是允许远程访问ollama的

2) OLLAMA_ORIGINS: *

3、Deepseek模型下载

下载模型就一个命令:

ollama run deepseek-r1: 43b

这个命令如果找不到参数中指定的模型,则从ollama的模型仓库中下载模型。目前ollama支持的模型列表可以从https://ollama.com/search 看到。

由于默认情况下,ollama是从自己官方网站上下载模型,速度很慢,为了加速模型下载,最好配置一个国内镜像。

国内镜像列表:

https://registry.ollama.ai

https://ollama.deepseek.com

https://ollama.zju.edu.cn

https://ollama.modelscope.cn

下载模型时,配置国内镜像的方法, 用OLLAMA_MODEL环境变量指定国内镜像地址:

OLLAMA_MODELS=https://registry.ollama.ai ollama pull deepseek-r1:70b

or

OLLAMA_MODELS=https://registry.ollama.ai ollama run deepseek-r1:70b

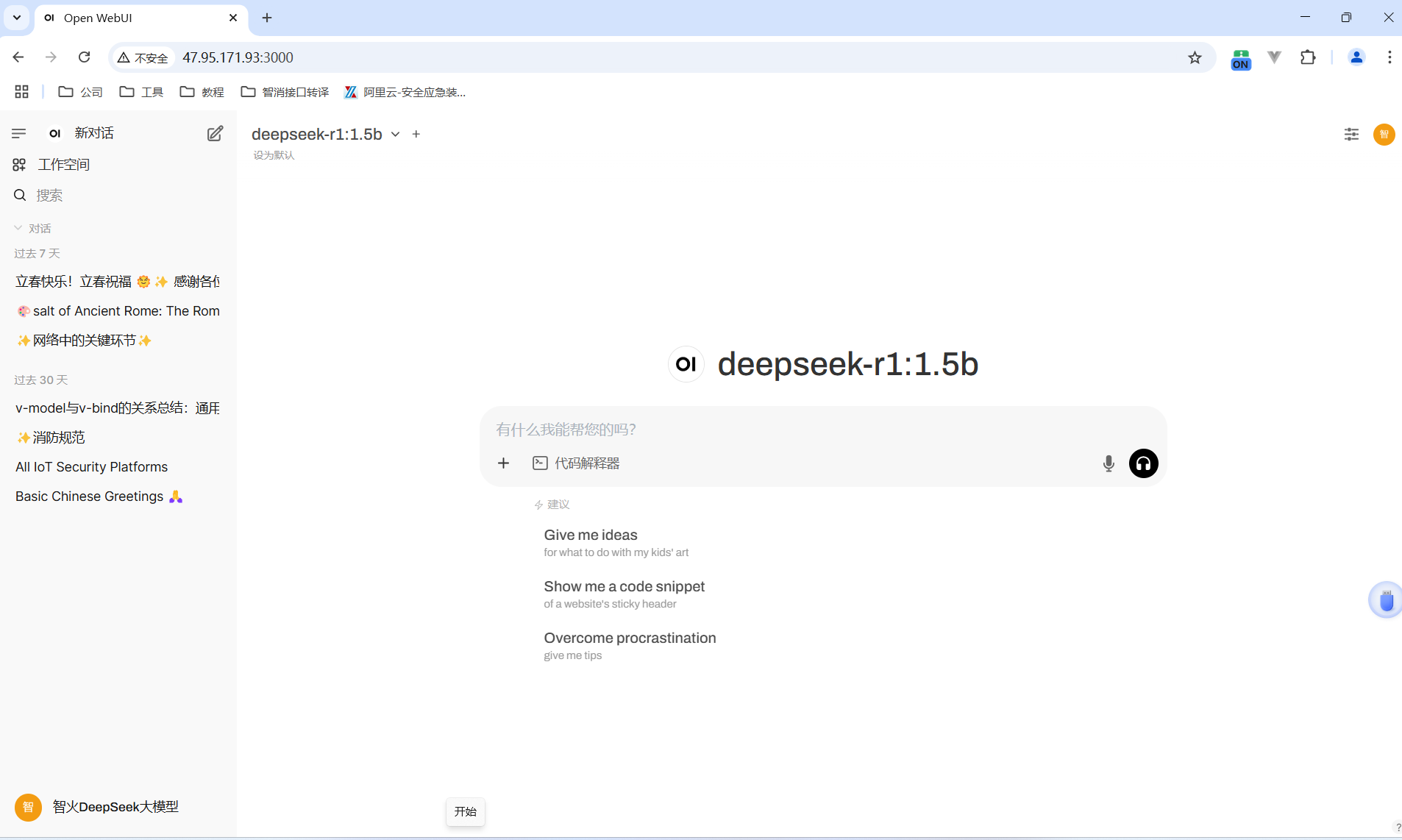

4、Open-WebUI下载安装

安装open-webui需要python3.11,为了减少踩坑,最好安装一个python3.11

python --version

pip install open-webui

open-webui serve

这几条命令执行完毕,大模型的web界面就出来了

参考资料

看了很多网上资料,都不记得网址,统一鸣谢。

浙公网安备 33010602011771号

浙公网安备 33010602011771号