线性回归,多项式回归(P2)

回归问题

回归问题包含有线性回归和多项式回归

简单来说,线性回归就是用多元一次方程拟合数据,多项式回归是用多元多次来拟合方程

在几何意义上看,线性回归拟合出的是直线,平面。多项式拟合出来的是曲线,曲面。

二,线性回归问题

2.1 线性回归

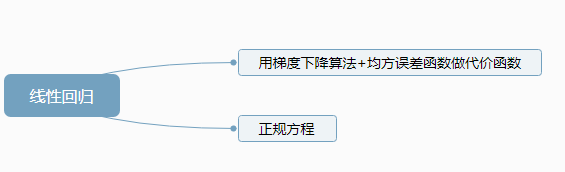

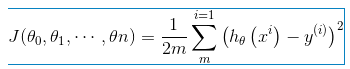

线性回归问题,是监督学习,输出是连续值。(批梯度下降训练参数+平方误差函数做代价函数)

线性问题的求解另一种方法:正规方程。正规方程把参数看成一个整体进行求导。用矩阵一些性质进行简化结果

正规方程:

思路:用矩阵来表示代价函数,求导数为0的时候参数的值,(最后利用矩阵求导结论,求出参数矩阵。)

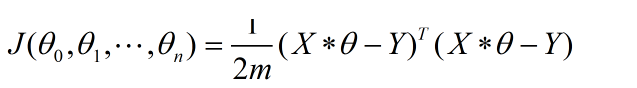

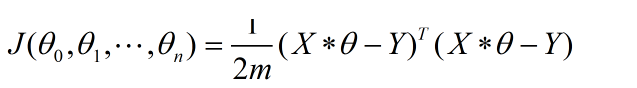

- 用矩阵表示代价函数:

,

, - 对代价函数求导化简得到正规方程

- 求出Θ。

![]()

推到过程:

https://blog.csdn.net/melon__/article/details/80589759

https://blog.csdn.net/jshazhang/article/details/78373218

注意:表达式写成矩阵的形式要注意把符号都表示成列向量,还要区分哪些是向量哪些是矩阵,向量和向量的乘积可以互换位置,但是向量和矩阵不行。

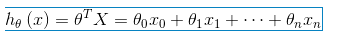

注意矩阵相乘写成表达式的样子是 ,但是这是一个样本的矩阵表达,m个样本矩阵的表达形式要写成ΘTX,就要用列向量表示样本向量。即:

,但是这是一个样本的矩阵表达,m个样本矩阵的表达形式要写成ΘTX,就要用列向量表示样本向量。即:

,其中,写成ΘTX-Y 的形式,或者写成XΘ-Y的形式,这两个表达式里面的X都是样本矩阵,但是是样本矩阵的两种形式,也就是两个X矩阵不一样,前者的X矩阵列向量是一个样本,后者的行向量是一个样本。

,其中,写成ΘTX-Y 的形式,或者写成XΘ-Y的形式,这两个表达式里面的X都是样本矩阵,但是是样本矩阵的两种形式,也就是两个X矩阵不一样,前者的X矩阵列向量是一个样本,后者的行向量是一个样本。

2.2 算法需要注意的地方

数据的归一化(特征缩放):为了保证算法下降得更快。

不管是上神经网络课还是数据挖掘课,老师反复强调了特征的缩放(归一化问题),如果不进行特征的缩放,算法可能就会表现很差,甚至不收敛。特征的缩放方法:Min-Max Scaling和Z-score normalization,

学习率的选取:

通常可以考虑尝试些学习率:0.01,0.03,0.1,0.3,1,3,10

三,多项式回归

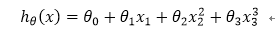

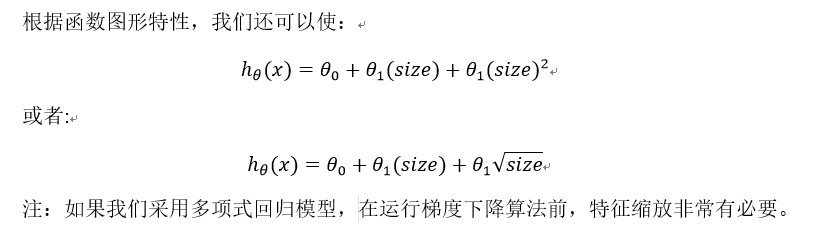

对于多项式问题:(多元多次模型)

例如: