20169214 2016-2017-2 《网络攻防实践》第四周学习总结

20169214 2016-2017-2 《网络攻防实践》第四周学习总结

教材学习内容总结

- 要点1:网络嗅探与协议分析为攻击者进行网络协议攻击、口令破解与系统入侵提供了重要的信息来源途径,作为被动攻击技术,很难被察觉。

- 要点2:网络嗅探具有被动性、非干扰性、隐蔽性。Unix平台下的网络嗅探技术主要通过内核态的BPF和用户态的libpcap抓包工具库实现;Windows平台下则主要是由NPF和WinPcap实现。

- 要点3:网络协议解析包括了解析以太网数据帧、解析IP数据包、解析TCP数据包。

- 要点4:tcpdump是UNIX平台下最古老、最通用的嗅探器程序,是目前维护最好的开源嗅探器软件。善用BPF过滤器规则是利用tcpdump进行网络数据包嗅探与分析的关键所在。

- 要点5:wireshark是当前类UNIX平台下最好的基于图形界面的嗅探器软件,在windows平台下也有其移植版本。其主要作用是捕获网络数据包,对于数据包进行协议分析以尽可能地显示详细的情况,并以更容易理解的格式呈献给用户。

教材实践

-

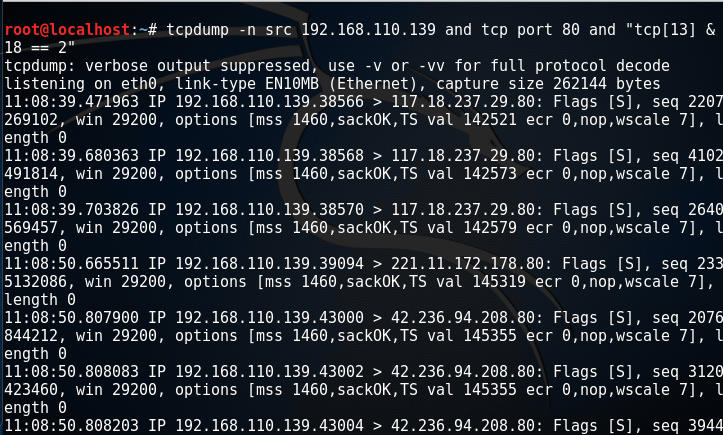

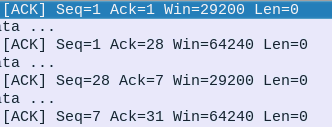

tcpdump

在虚拟机上访问www.tianya.cn,对该网站进行嗅探(主机ip:192.168.110.139):

-

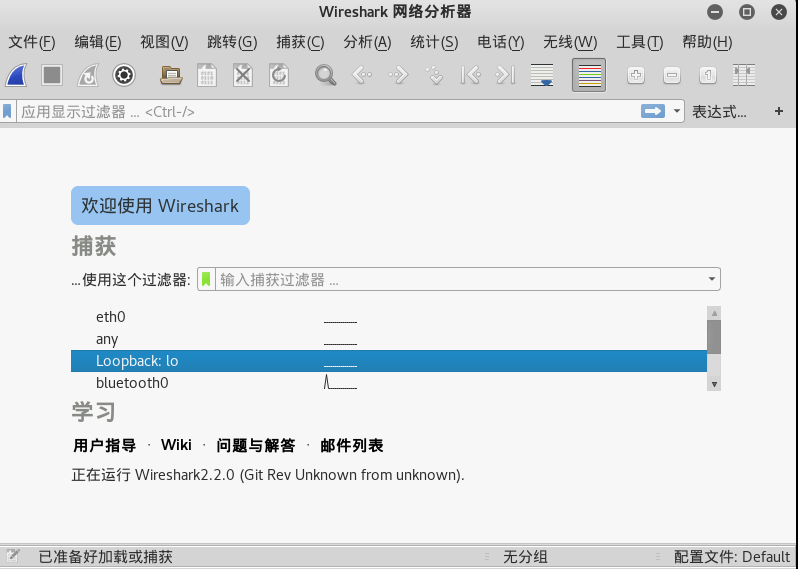

wireshar

Wireshark是世界上最流行的网络分析工具。这个强大的工具可以捕捉网络中的数据,并为用户提供关于网络和上层协议的各种信息。与很多其他网络工具一样,wireshark也使用pcap network library来进行封包捕捉。

下面就wireshark工具的基本用法做一下详细介绍:- 抓取报文:下载和安装好Wireshark之后,启动Wireshark并且在接口列表中选择接口名,然后开始在此接口上抓包。例如,如果想要在无线网络上抓取流量,点击无线接口。点击接口名称之后,就可以看到实时接收的报文。需要停止抓取报文的时候,点击左上角的停止按键。打开一个抓取文件相当简单,在主界面上点击Open并浏览文件即可。

- 色彩标识:Wireshark通过颜色让各种流量的报文一目了然。比如默认绿色是TCP报文,深蓝色是DNS,浅蓝是UDP,黑色标识出有问题的TCP报文——比如乱序报文。

- 过滤报文:Wireshark过滤器的使用方法:最基本的是在窗口顶端过滤栏输入并点击Apply(或按下回车)。例如,输入“dns”就会只看到DNS报文。输入的时候,Wireshark会帮助自动完成过滤条件。

- 检查报文:选中一个报文之后,就可以深入挖掘它的内容了。

-

实践

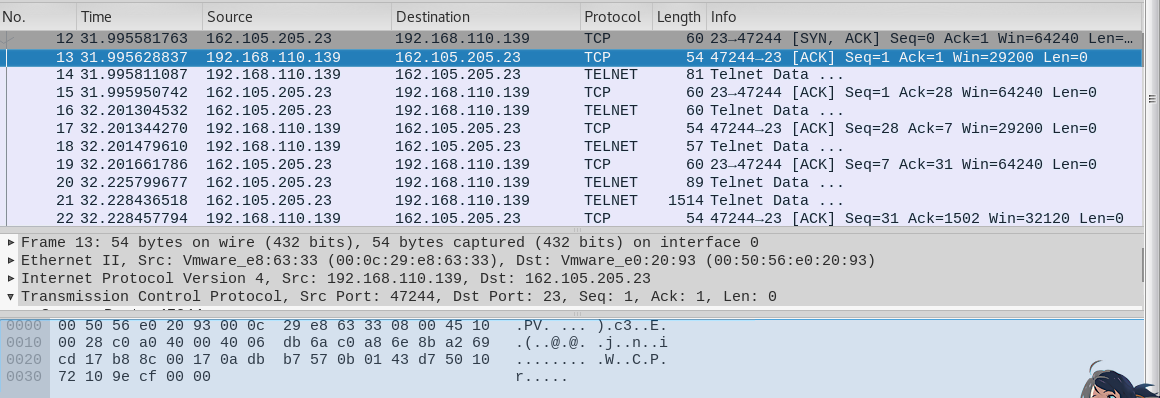

- 打开wireshark,点击开始捕获,进入待捕获状态。

- 然后通过telent方式访问BBS服务器:www.bdwm.net

- 再然后查看wireshark,获悉有用的扫描信息。

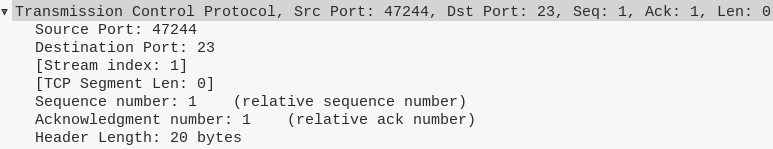

说明:自上而下三部分分别表示:封包列表:显示捕获到的封包, 有源地址和目标地址,端口号;封包详细信息:显示封包中的字段;16进制数据

详细信息:

视频学习内容总结

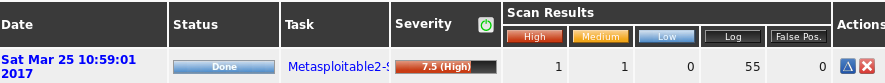

OpenVas的使用

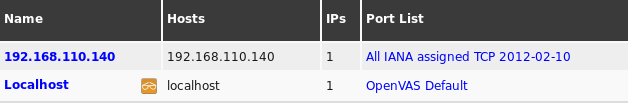

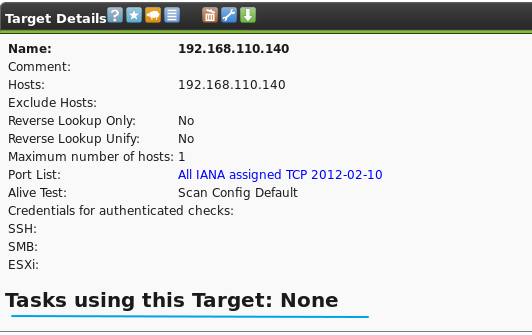

- 检查本机和目标机是否ping通,正常ping通后访问openvas管理界面(http://localhost:9392)。在模块configuration中新建target。

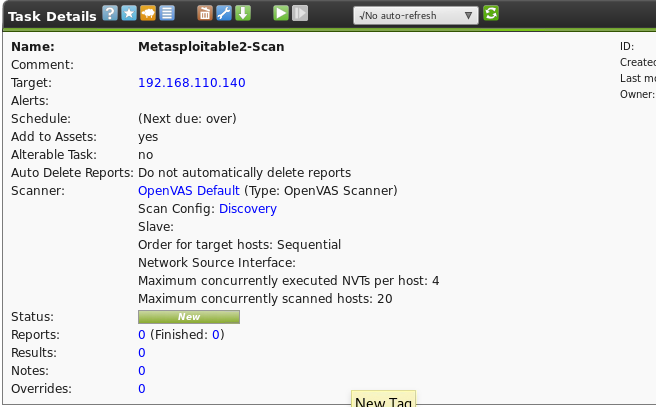

如上图,提示对于此target没有任务,下一步进行任务的创建。 - 打开扫描管理Scan Management,进行扫描任务的添加。

- 然后开始扫描任务,还可以查看进度及详细信息

其它扫描工具的介绍

- WEB扫描工具Golismero

这是一款开源的Web扫描器,特点是可导入其它扫描工具的结果并自动分析。

它采用插件式的框架结构,由纯python编写。插件分为四类:InportPlugin(导入插件)、TestingPlugin(测试插件)、ReportPlugin(报表插件)、UIPlugin(界面插件)。

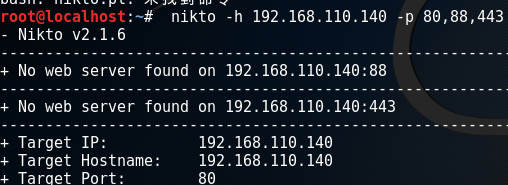

另外,该工具几乎没有系统依赖性。 - 漏洞扫描器Nikto.pl

扫描简单,基本上不加参数,只需加一个-h即可,例如:nikto -h 192.168.110.140。扫描速度快、结果比较整齐。

也可对多个端口进行扫描,例如:nikto -h 192.168.110.140 -p 80,88,443

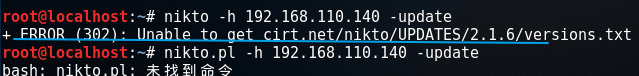

另外,更新插件和数据库的命令为nikto -h 192.168.110.140 -update,执行这个update可能需要FQ,否则可能连接不上。如下:

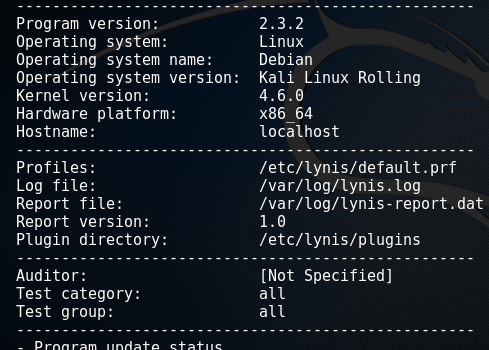

- Lynis系统信息收集整理工具

这主要是对Linux或UNIX操作系统的详细配置等信息进行枚举收集,生成易懂的报告文件。测试者可以根据这些报告文件找到相应的漏洞利用的esp。

使用简单:lynis --check-all -Q(-Q是为了避免交互)

如上图,可枚举到当前系统的信息 - unix-privesc-check

也是信息收集工具,有两种模式:standard/detailed

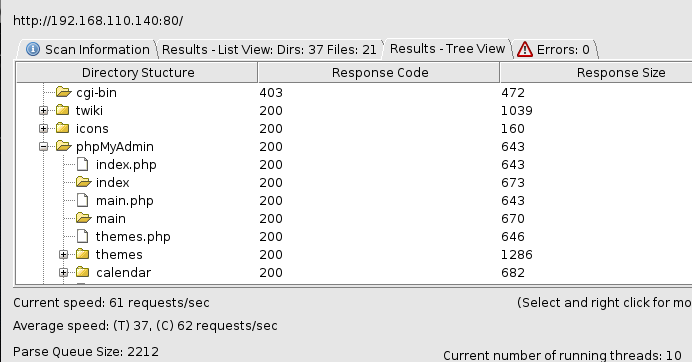

WEB爬行

- 针对web网站的扫描,往往需要对网站路径、页面、账户进行枚举或爆破,这就涉及到web安全中心的爬行工具。

- apache-users的使用方法

apache-users -h 192.168.110.140 -l /usr/share/wordlists/dirbuster/apache-user-enum-2.0.txt -p 80 -s 0 -e 403 -t 10

说明:/usr/share/wordlists/是字典目录;-p 80是指端口号为80;-s即是否支持SSL协议,0表示否;-e 403是制定返回的状态码为403,-t 10指定线程数10

- cutycapt

作用:方便对一个网站进行截图。

例如:对于百度主页面进行截图:cutycapt --url=http://www.baidu.com/ --out=baidu.png - DIRB:强大的目录扫描工具

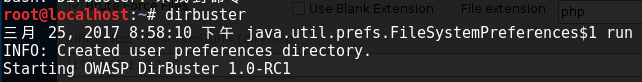

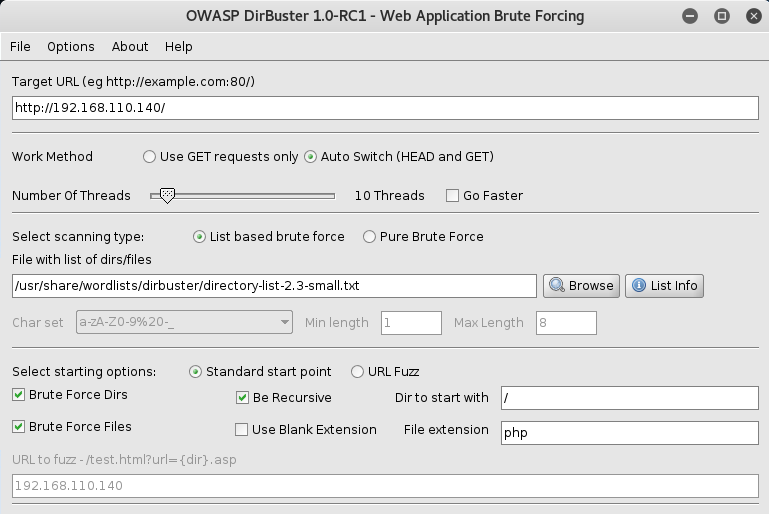

- Dirbuster

这是kali下的图形化目录扫描器,

设置好后,start:

即可看到各种详细信息。

WEB漏洞扫描

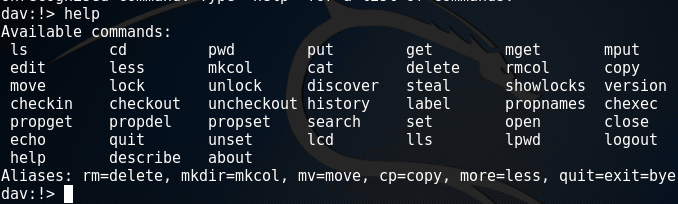

- Cadaver

这是一个用来浏览和修改WebDAV共享的Unix命令行程序,可以以压缩方式上传和下载文件,也会检验属性、拷贝、移动、锁定和解锁文件。以一种客户端命令行的格式来连接dav。

- DAVTest

进行dav的漏洞测试。

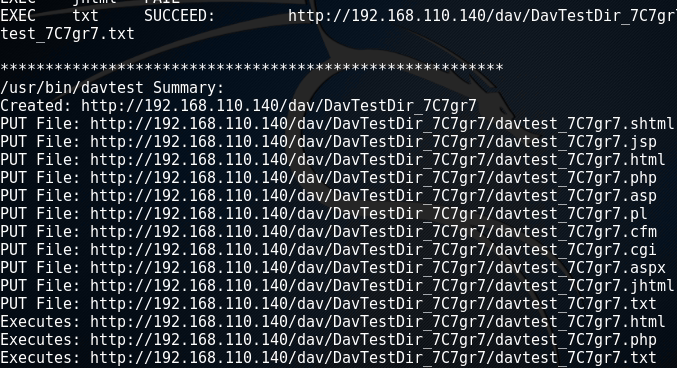

以靶机192.168.110.140为目标,执行命令:```davteast http://192.168.110.140/dav/,结果如下:

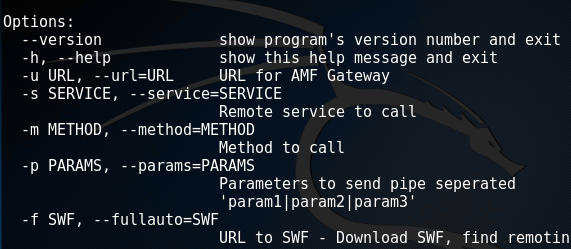

由此可知创建了那些目录,上传了哪些文件。 - Deblaze:针对FLASH远程调用等的枚举

- Fimap:文件包含漏洞利用工具

- Grabber:一个WEB应用漏洞扫描器,可以指定扫描漏洞类型结合爬虫对网站进行安全扫描。

使用:grabber --spider 2 --sql --url (target ip)

说明:--spider 代表需要爬虫;后边的数字代表要爬多深;--sql 是指明爬虫爬到的url需要做哪些漏洞的检测。 - Skipfish:是Google出品的一款自动化的网络安全扫描工具,它通过HTTP协议处理且占用较低的CPU资源,因此运行速度快。

扫描方式:skipfish -o /tmp/1.report http://url/ /*-o是output即生成文件,后面跟生成的目录*/

例如:skipfish -o ~/report123 http://163.com/即在home目录下生成报告(~表示根目录) - W3AF:是一个web应用程序攻击和检查框架,该项目已超过130个插件,其中包括检查网站爬虫,SQL注入(SQL Injection),跨站(XSS),本地文件包含(LFI),远程文件包含(RFI)。该项目的目的是要建立一个框架,以寻找和开发web应用安全漏洞。

- wapiti:工作方式与nikto类似,采用黑盒的方式主动对被测web应用进行扫描,并实现了内置的匹配算法。

- websploit:主要用于远程扫描和分析系统漏洞。

学习进度条

| 教材学习 | 视频学习 | 博客量(新增/累积) | 重要成长 | |

|---|---|---|---|---|

| 目标 | 12章 | 20篇 | ||

| 第一周 | 第一章 | 《Linux基础入门》 | 1/1 | 初识Linux,并学会使用博客园、码云、实验楼的学习平台 |

| 第二周 | 第二章 | 5个kali视频 | 2/3 | 了解了网络攻防技术的基本情况和实验环境 |

| 第三周 | 第三章 | 5个kali视频 | 1/4 | 深入学习了kali linux下的几种重要工具 |

| 第四周 | 第四章 | 5个kali视频 | 1/5 | 学习网络嗅探和协议分析,了解漏洞分析阶段的几种重要工具 |

参考资料

《网络攻防技术与实践》教材

kali视频